Show HN Today: Discover the Latest Innovative Projects from the Developer Community

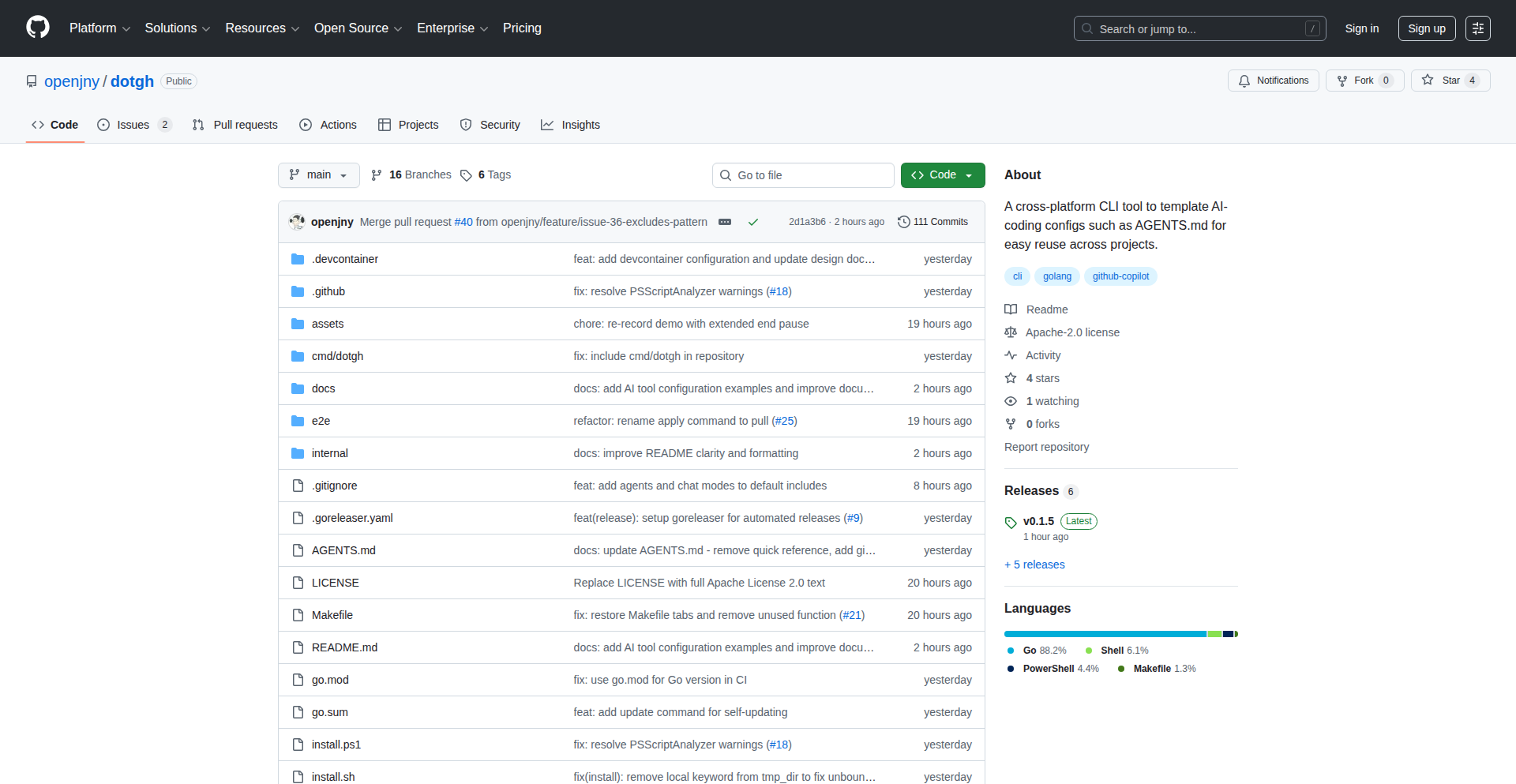

ShowHN Today

ShowHN TodayShow HN 今日精选:2025-12-01最热门的开发者项目展示

SagaSu777 2025-12-02

探索2025-12-01 Show HN上最热门的开发者项目,包括创新技术、AI应用等激动人心的新发明。深入了解这些引人注目的项目!

今日内容汇总

趋势洞察

今日的 Show HN 板块再次展现了技术创新的蓬勃活力,尤其是在人工智能与开发者工具领域。我们看到大量项目致力于让 AI 更智能、更易用,并深度集成到开发者的日常工作流中。例如,Jargon 这样的 AI Zettelkasten 工具,不仅能处理信息,还能理解并连接概念,这标志着信息管理正在从简单的存储进化到智能的理解。Superset 和 GitHits 则直接瞄准了开发者群体,通过并行化 AI 编码代理和提供代码示例引擎,极大地提升了开发效率和代码质量。Flowctl 和 RFC Hub 则体现了自动化和流程管理的趋势,通过 SRE/DevOps 工具和技术提案管理平台,让复杂系统变得更易于维护和协作。更值得注意的是,许多项目都在探索 AI 的多模态能力,如 CodeViz 将代码可视化,Paper2Song 将论文变成音乐,预示着 AI 将打破学科和感官的界限。对于开发者和创业者来说,这意味着一个前所未有的机会窗口:拥抱 AI,将其作为强大的工具,不仅能加速产品的开发,还能催生出全新的用户体验和商业模式。关注那些能真正解决痛点、提高效率、或者带来全新洞察力的项目,将是抓住技术浪潮的关键。黑客精神鼓励我们不断探索、实验,用技术解决实际问题,今天的项目正是这种精神的绝佳体现。

今日最热门产品

名称

Jargon - AI Zettelkasten

亮点

Jargon 是一款创新的 AI Zettelkasten(卡片盒笔记法)工具,它能够自动从文章、论文和 YouTube 视频中提取关键思想,并建立概念之间的关联。它通过 RAG(检索增强生成)技术,结合用户的个人知识库和最新的网络信息,提供强大的知识管理和问答能力。开发者可以从中学习到如何利用 LLM 进行信息提取、知识图谱构建以及智能搜索,为个人知识管理和信息组织带来全新的思路。

热门类别

AI/ML

Developer Tools

Productivity

Data Management

Cloud/DevOps

热门关键字

AI

LLM

Automation

Developer Tools

Data

Code

Workflow

CLI

RAG

技术趋势

AI 驱动的知识管理

低代码/无代码开发

个性化 AI 助手

自动化工作流

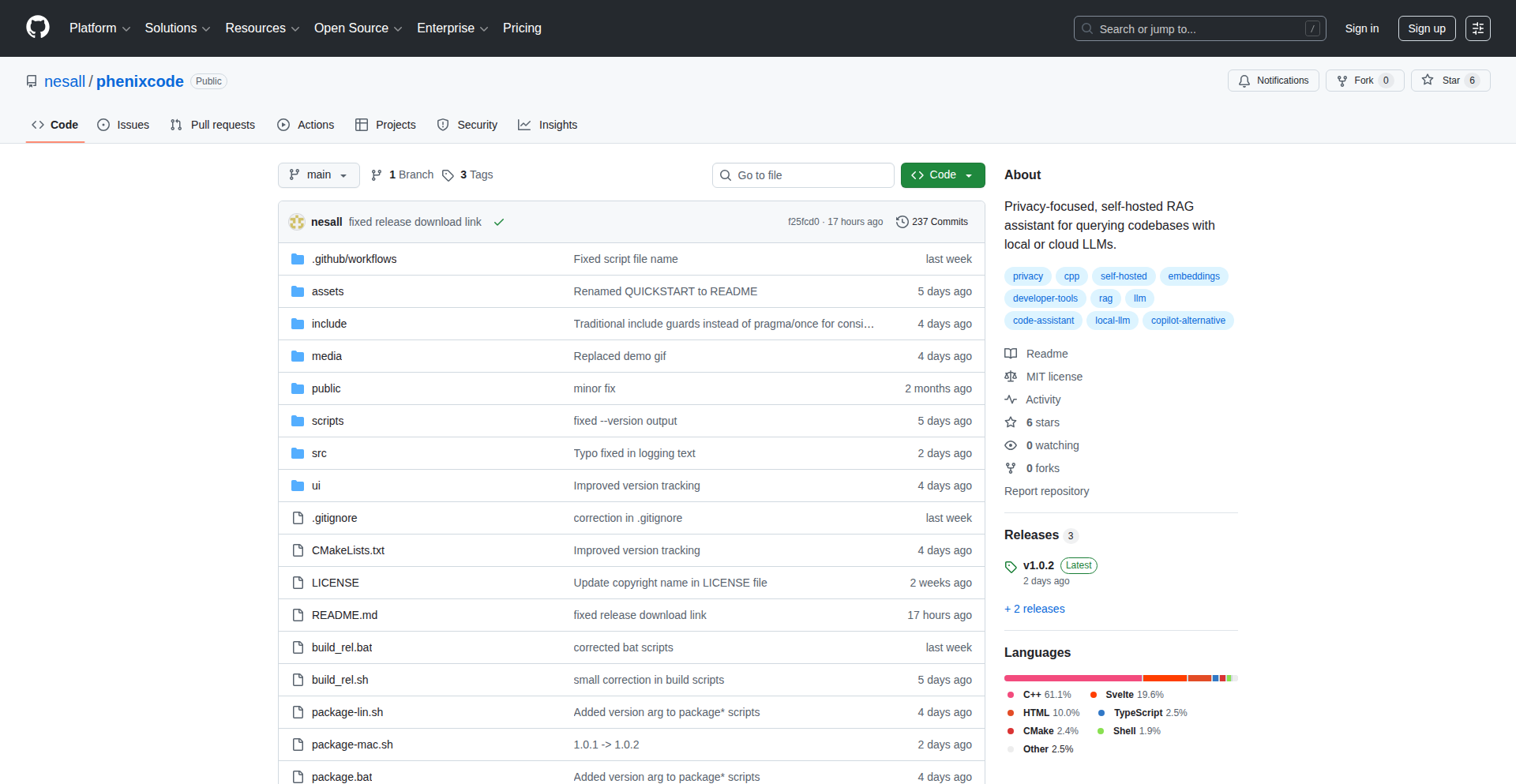

隐私安全与本地化 AI

代码生成与辅助

多模态 AI 应用

项目分布

AI/ML (35%)

Developer Tools (25%)

Productivity (15%)

Data Management (10%)

Cloud/DevOps (5%)

Other (10%)

今日热度产品榜单

| 排名 | 产品名称 | 点赞数 | 评论数 |

|---|---|---|---|

| 1 | 微码UI:1.8MB原生AI交互套件 | 15 | 23 |

| 2 | Jargon: AI驱动的知识图谱笔记 | 29 | 7 |

| 3 | RFC Hub: 技术提案元数据引擎 | 23 | 8 |

| 4 | Superset - 智能代码助手并行指挥官 | 22 | 3 |

| 5 | CurioQuest: 知识探索者 | 6 | 10 |

| 6 | Flowctl: 极简工作流引擎 | 15 | 1 |

| 7 | Furnace: 现代怀旧Chiptune音乐创作工作台 | 14 | 0 |

| 8 | GitHits 代码案例引擎 | 10 | 4 |

| 9 | NPM包流量可视化侦探 | 11 | 0 |

| 10 | FFmpeg 工程手册:视频处理的黑客宝典 | 10 | 0 |

1

微码UI:1.8MB原生AI交互套件

作者

jaramy

描述

这是一个极简的1.8MB原生应用,核心创新在于完全自建的UI框架,并深度整合了本地AI和视觉处理能力。它解决了许多移动应用体积庞大、依赖云端AI导致延迟高、以及UI框架臃肿的问题,为开发者提供了一种轻巧、高效且功能强大的本地化AI应用开发新范式。

人气

点赞 15

评论数 23

这个产品是什么?

这是一个非常小巧(只有1.8MB!)的原生应用程序,它自己设计了一套用户界面(UI),就像给应用穿上了一件独一无二的衣服,而且还内置了“大脑”(AI)和“眼睛”(视觉处理)。这意味着这个应用不依赖复杂的外部库,并且能在你的设备上直接进行智能识别和交互,速度更快,隐私性也更好。它的创新之处在于用极小的体积实现了强大的本地AI处理能力和灵活的UI定制,这在移动开发领域是非常罕见的。

如何使用它?

开发者可以将这个套件集成到自己的原生应用中,就像给应用添加了一个强大的AI助手和一套可定制的界面。比如,你想开发一个拍照识别物品的应用,或者一个能实时翻译手写文字的应用,都可以用它来快速实现。你可以根据自己的需求,用这套自建的UI框架来设计应用的外观,然后调用内置的AI和视觉库来完成诸如图像识别、文字识别、甚至简单的智能分析等任务,而无需担心应用的体积过大或者网络延迟。

产品核心功能

· 极简原生UI框架:开发者可以完全按照自己的想法定制应用界面的每一个像素,避免使用臃肿的通用UI库,让应用体积更小、运行更快,对用户来说就是更流畅、更个性化的体验。

· 本地AI推理引擎:应用内置了AI能力,可以直接在用户的设备上运行智能算法,这意味着数据不需要上传到云端,响应速度飞快,用户隐私也得到了更好的保护,例如可以实时识别用户手势或进行语音指令处理。

· 视觉处理能力:集成了一套能够处理图像和视频的库,可以用来识别物体、读取文字、分析画面内容,为应用添加“看”和“理解”的能力,比如用于照片内容分析或AR应用。

· 微小应用体积:整个应用的体积控制在1.8MB,这对于移动设备存储空间有限的用户来说是巨大的福音,也更容易下载和更新,降低了用户的门槛。

产品使用案例

· 场景:开发一个用于老年人的手机应用,需要界面非常简洁,操作易懂,并且能通过语音或拍照识别药品名称。技术价值:使用微码UI的极简UI框架设计大字体、高对比度的界面,并通过本地AI识别药品包装上的文字,无需网络即可完成,大大降低了老年人使用的复杂度,保证了信息获取的及时性和隐私性。

· 场景:做一个学习外语的APP,需要识别用户抄写的单词并给出反馈。技术价值:利用微码UI的视觉处理能力识别手写文字,再结合本地AI分析拼写和语法错误,实现即时反馈,这种离线能力让用户可以在任何地方学习,不受网络限制,提升了学习效率。

· 场景:创建一个能识别花卉并提供养护信息的APP。技术价值:集成微码UI的视觉识别AI,用户拍照即可识别花卉种类,APP随即显示详细的养护指南。由于AI在本地运行,识别速度快,且无需消耗用户的流量,提升了用户体验的便捷性和经济性。

· 场景:为嵌入式设备开发一个简单的用户交互界面,设备内存有限。技术价值:微码UI的1.8MB体积优势使其非常适合资源受限的嵌入式环境,可以实现基础的图像显示、按钮交互以及简单的AI功能,如目标检测,而不会占用过多宝贵的内存和处理资源。

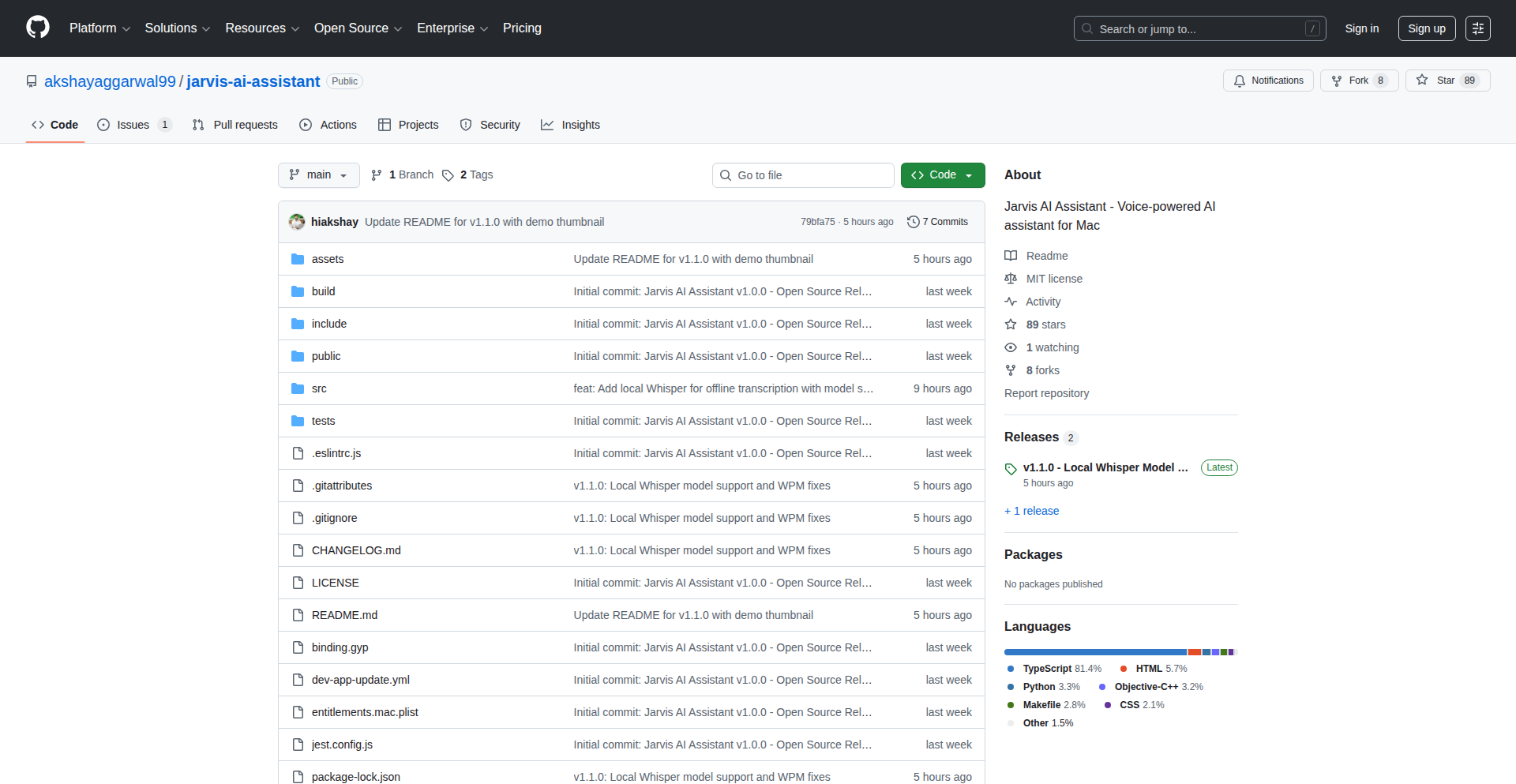

2

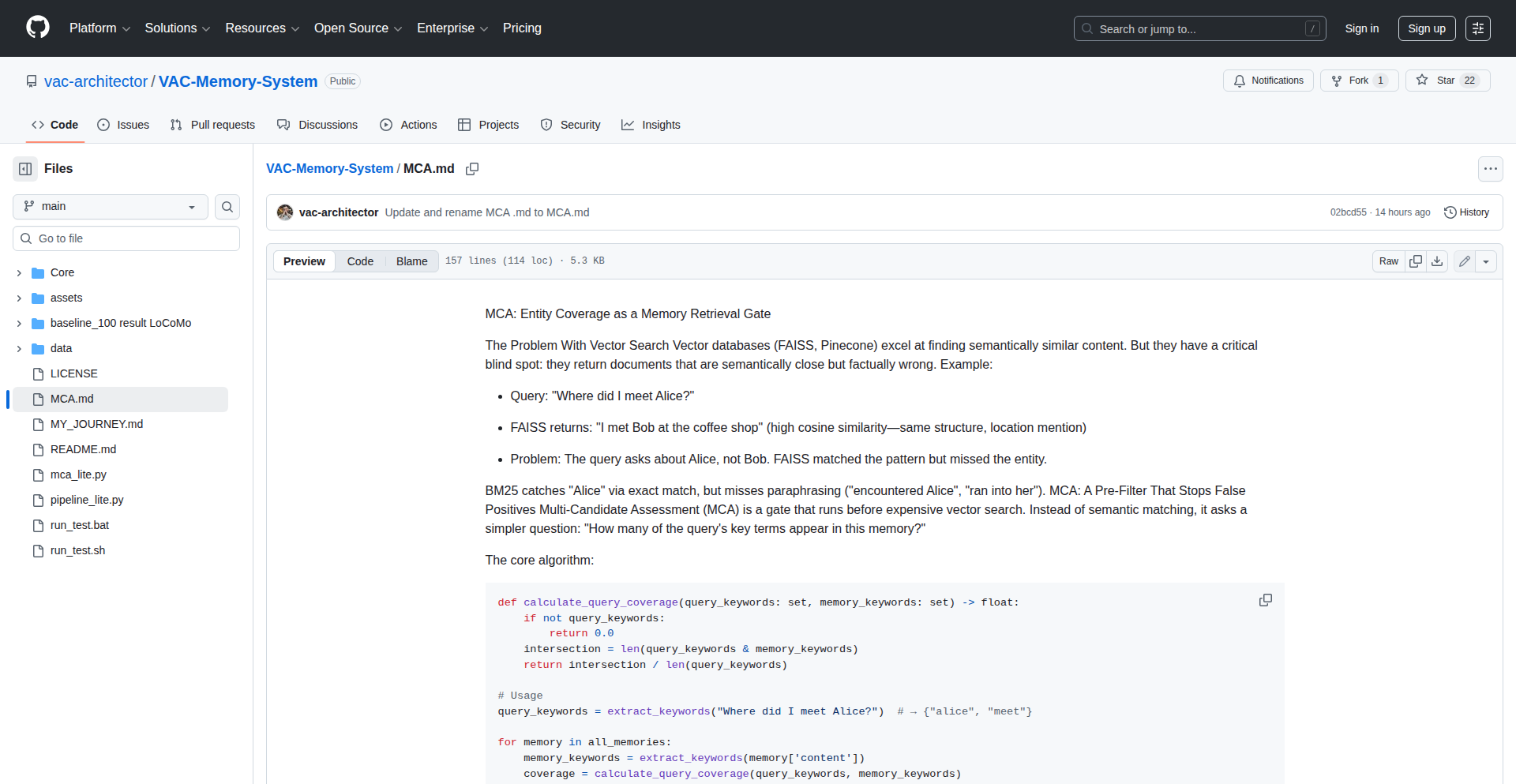

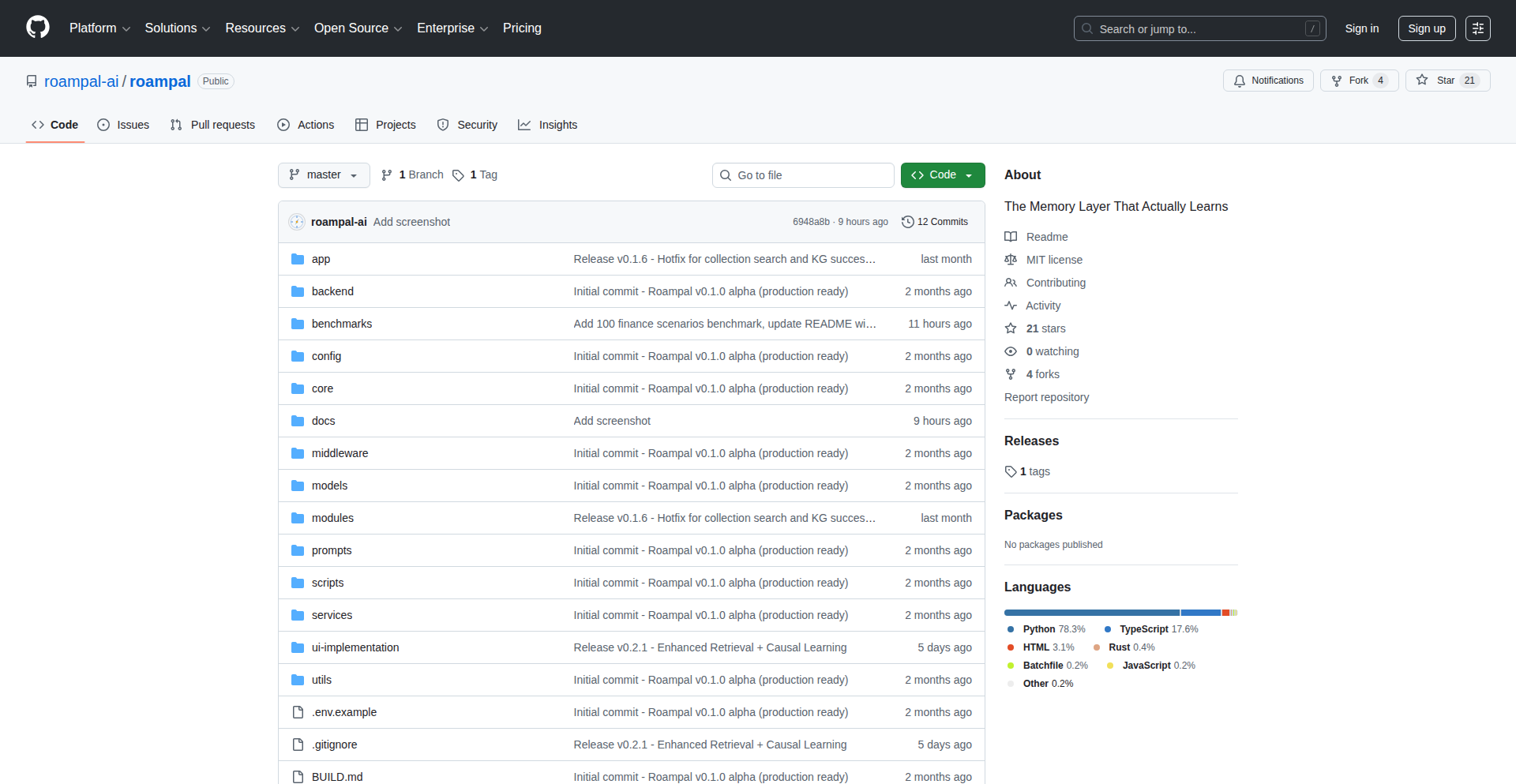

Jargon: AI驱动的知识图谱笔记

作者

schoblaska

描述

Jargon 是一个利用人工智能管理的 Zettelkasten(卡片盒笔记法)系统。它能够自动阅读文章、论文和 YouTube 视频,提取核心观点,并将相关的概念智能地连接起来,形成一个动态的知识图谱。这解决了信息过载和知识孤岛的问题,让你更容易发现和利用信息之间的联系。

人气

点赞 29

评论数 7

这个产品是什么?

Jargon 是一个智能的笔记管理工具,它背后的核心技术是利用大型语言模型(LLM),比如 Opus 4.5,来理解和处理你输入的各种内容(文章、PDF、视频链接)。它会像一个聪明的助手一样,从这些内容中提炼出关键信息,把它们变成一个个独立的“灵感卡片”。更厉害的是,它还能自动识别这些卡片之间的关联,并将它们连接起来,构建成一个网状的知识图谱。你可以直接在图谱中探索,或者通过提问来搜索信息,它不仅会在你已有的笔记中查找,还会联网搜索最新的相关内容,然后同样通过AI分析后融入你的知识库。它就像一个拥有超强记忆力和分析能力的知识管家,帮你组织和连接海量信息。

如何使用它?

开发者可以将 Jargon 集成到现有的开发流程中,作为信息收集和知识沉淀的强大工具。你可以将技术文章、API文档、Stack Overflow 上的热门解答、甚至相关的 YouTube 技术教程链接直接粘贴或上传到 Jargon。Jargon 会自动解析这些内容,提取出关键的技术概念、代码片段、解决方案和最佳实践,并形成可搜索的“灵感卡片”。例如,当你在学习一个新的框架时,可以将官方文档、相关的博客文章和示例代码链接导入 Jargon,它会自动为你梳理出核心API、常用模式和注意事项,并与其他你已有的相关知识点建立联系。当你遇到一个技术难题时,可以直接问 Jargon,它会结合你现有的知识库和最新的网络搜索结果,提供相关的解决方案和参考信息。

产品核心功能

· AI驱动的内容提取与摘要:Jargon能够自动从各种来源(文章、PDF、视频)提取核心观点和关键信息,为你节省大量阅读和总结的时间,让你快速抓住要点。

· 智能概念关联与知识图谱构建:通过AI分析,Jargon能自动识别不同信息之间的潜在联系,并将它们链接起来,形成可视化的知识图谱,帮助你发现隐藏在信息洪流中的关联,深化理解。

· 语义化搜索与问答系统:你可以用自然语言向Jargon提问,它会利用先进的搜索技术(包括语义搜索和混合搜索)在你庞大的知识库中查找答案,并结合最新的网络信息,提供全面、准确的回答,解决你信息检索效率低的问题。

· 研究线程与内容扩展:Jargon支持创建“研究线程”,当你对某个概念产生疑问时,它可以自动触发网络搜索,拉取相关内容,并将其吸收到你的知识体系中,形成一个持续学习和探索的闭环。

· 跨平台内容支持:支持处理文章链接、PDF文件和YouTube视频,意味着你可以将几乎所有类型的信息源都纳入Jargon的管理,实现全方位的信息整合。

产品使用案例

· 场景:学习一项新技术。开发者可以将该技术的官方文档、教程文章、相关的技术博客和GitHub代码仓库链接输入Jargon。Jargon会提取核心概念、API用法、常见模式,并将它们与开发者已有的知识(如其他框架的相似概念)关联起来。这有助于开发者更快地理解新技术,避免重复造轮子。

· 场景:解决一个棘手的编程问题。开发者将错误信息、相关的Stack Overflow帖子链接、以及自己尝试的解决方案描述输入Jargon。Jargon会分析这些信息,找出问题的根源,并搜索网络上可能存在的其他解决方案,将其整理成清晰的卡片,并链接到相关的知识点,帮助开发者快速找到解决途径。

· 场景:跟进技术趋势。开发者将行业新闻、研究论文摘要、技术大会视频链接输入Jargon。Jargon会从中提炼出重要的技术趋势、新的技术应用和潜在的影响,并与相关的领域知识关联,帮助开发者保持对前沿技术的敏锐度。

· 场景:撰写技术文档或报告。开发者可以将收集到的技术资料、数据和分析结果输入Jargon。Jargon能够帮助梳理思路,提取关键论据,并自动生成相关的参考链接,极大地提高了文档撰写和信息整合的效率。

3

RFC Hub: 技术提案元数据引擎

作者

tlhunter

描述

RFC Hub 是一款为解决技术提案生命周期管理痛点而生的工具。它不只是一个文档存储库,而是围绕技术提案的关键信息(如作者、评审人、状态、共识情况等)构建了一个结构化的元数据层。通过提取提案的真正含义,而非仅仅存储文本,RFC Hub 能够自动化流程,提高评审效率,并确保提案按照既定规则推进,让开发者和团队能够更顺畅地沟通和协作。

人气

点赞 23

评论数 8

这个产品是什么?

RFC Hub 是一个为管理技术提案(如产品需求文档、架构设计方案等)设计的系统。它通过结构化地存储和处理提案的元数据(比如谁是作者,谁需要评审,提案的当前状态,是否达成了共识等),来解决传统文档管理中信息分散、难以追踪的问题。它的创新之处在于,将提案的‘意义’从文档的文本中剥离出来,转化为可供系统理解和操作的数据,比如,它可以‘知道’某个提案是否已获得足够多的‘赞同’,从而决定是否可以进入下一步。这就像是为提案增加了一个‘大脑’,让它能自己管理自己的流程。

如何使用它?

开发者可以将现有的技术提案(无论是 Word 文档、Google Docs 还是纯文本)录入到 RFC Hub 中,并为提案添加相关的元数据,例如指定评审人、设置评审截止日期、标记提案的状态等。RFC Hub 提供了一个易于使用的界面来管理这些信息。对于新提案,可以利用其未来的模板功能,快速创建结构化的提案。此外,它还会集成 Slack 等工具,在提案状态变化时发送通知,让你不会错过重要更新,比如你批准的提案现在可以开始编写代码了。

产品核心功能

· 结构化提案管理:将提案的作者、评审人、状态、版本等信息进行结构化存储,方便快速检索和追踪,让你可以一眼看到所有你关注的提案进展,不用再大海捞角。

· 共识自动化检测:通过分析评审意见和投票情况,自动判断提案是否达成共识,避免共识被隐藏在大量评论中,让你及时了解提案的‘民意’。

· 状态驱动的工作流:当提案状态改变时(例如,评审通过,进入开发阶段),系统会自动发出通知,让你不必时刻盯着,确保信息及时触达,高效对接。

· 提案元数据提取:识别和提取提案的关键信息,使之成为可操作的数据,而不是仅仅被保存在文本中,这让系统能理解提案的‘含义’,实现更智能的管理。

· 评审效率提升:提供清晰的评审流程和工具,帮助团队成员更容易找到需要他们评审的提案,并清晰地了解评审的优先级,节省大家的时间。

· 未来规划的提案模板:支持创建和使用预设模板,统一不同类型提案的格式和信息收集,让提案创建更标准化,减少信息遗漏。

产品使用案例

· 在一个大型技术团队中,当一位开发者提交了一份新的架构设计提案,RFC Hub 可以自动将这份提案分配给相关的技术负责人和架构师进行评审。当所有评审人都批准后,RFC Hub 会自动发送通知给项目经理和开发团队,告知提案已准备好进入编码阶段,避免了人工逐一通知的麻烦。

· 一个产品团队正在开发一个新功能,需要收集用户界面(UI)相关的设计建议。他们可以使用 RFC Hub 创建一个 'UI RFC'(用户界面请求评论)类型的提案,并邀请 UI/UX 设计师和前端开发者参与评审。RFC Hub 可以跟踪每个设计师的反馈,并统计有多少人同意某个设计方案,从而帮助团队更快地达成一致,并确保最终的设计符合大多数人的意见。

· 某个公司希望优化内部技术决策记录(ADR)的管理。他们可以将每份 ADR 录入 RFC Hub,并定义一套评审流程。RFC Hub 能够记录下每个决策的关键信息,如‘是否被批准’、‘批准人’、‘决策原因’等,方便日后追溯和查阅,形成一个清晰的技术决策历史库。

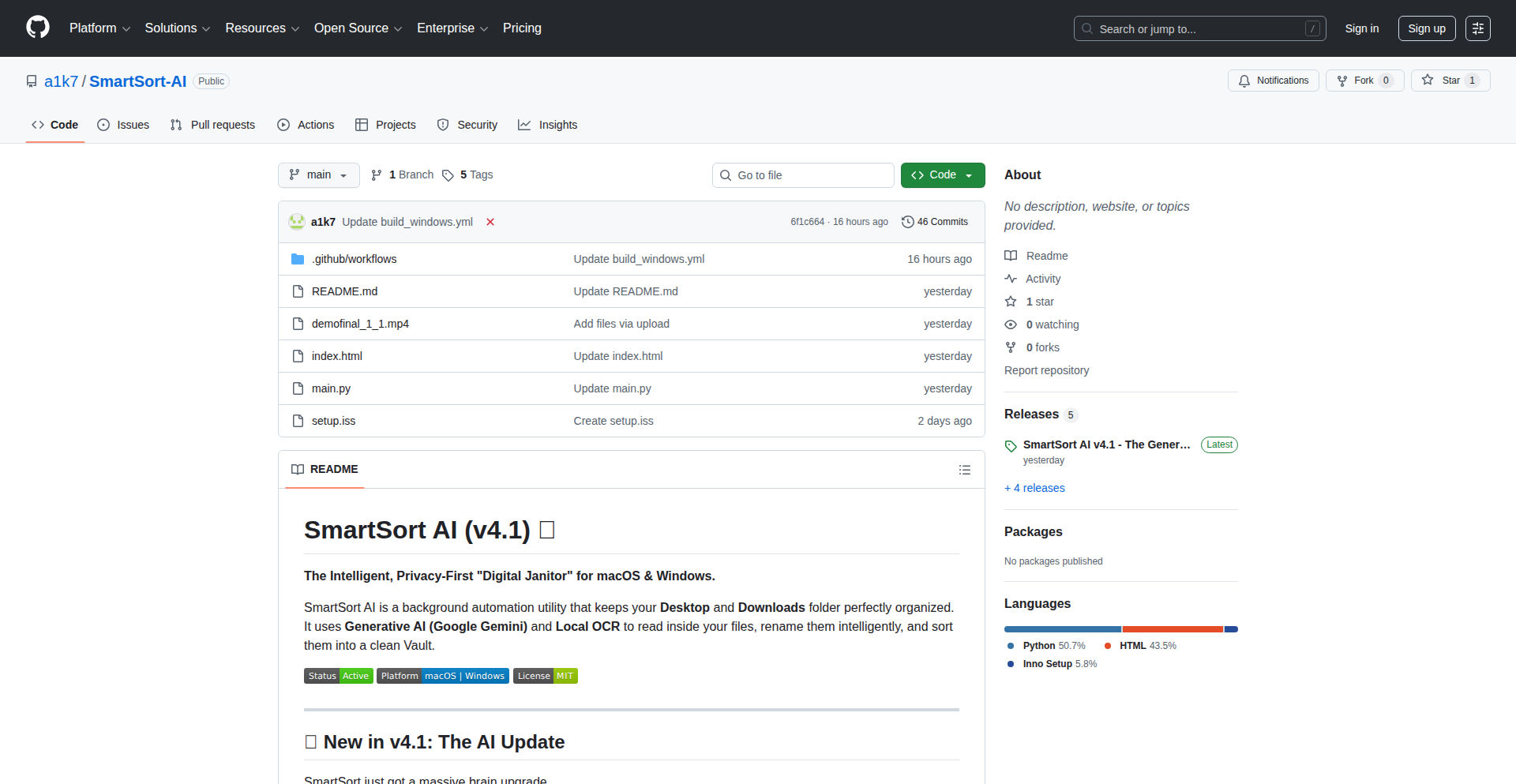

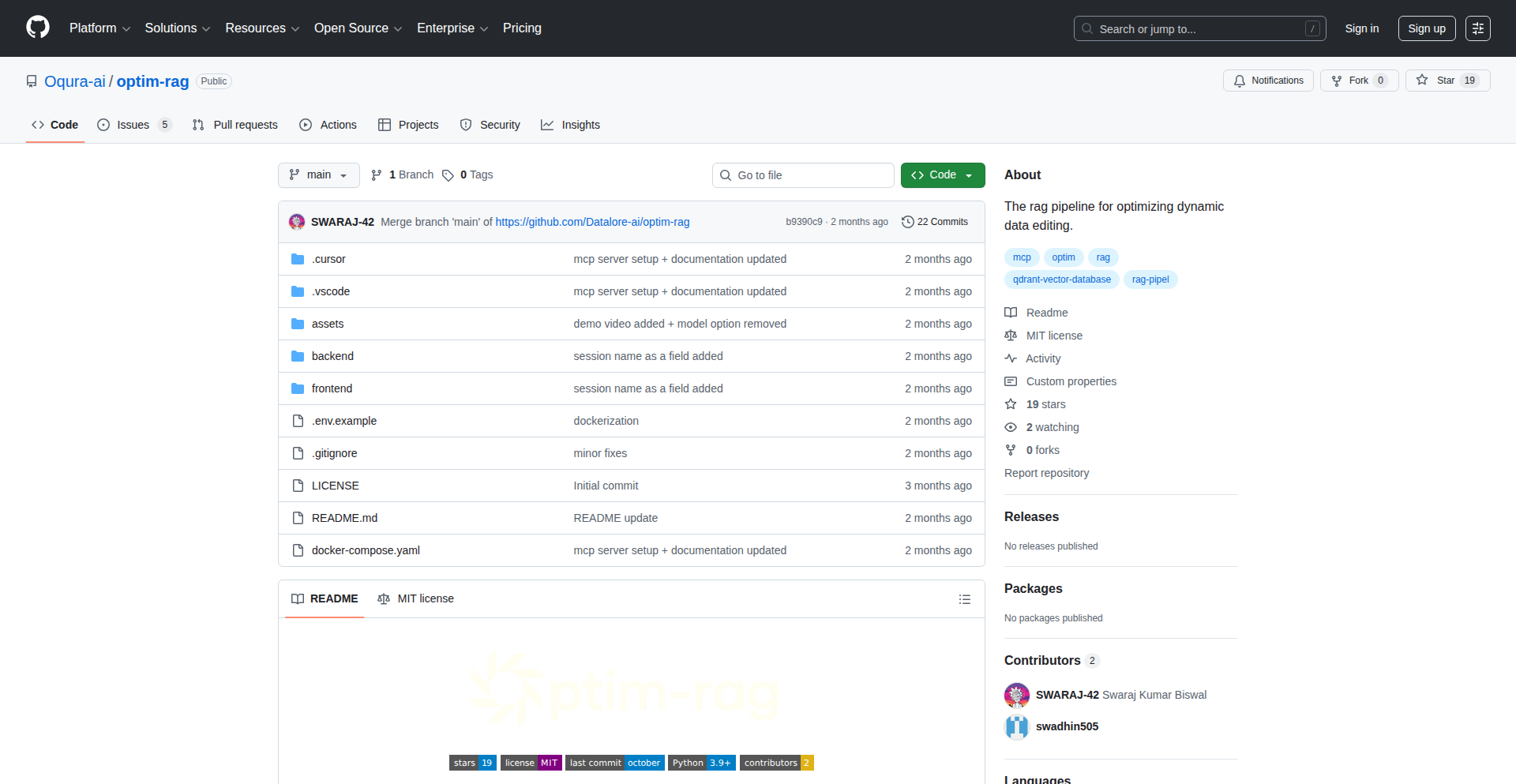

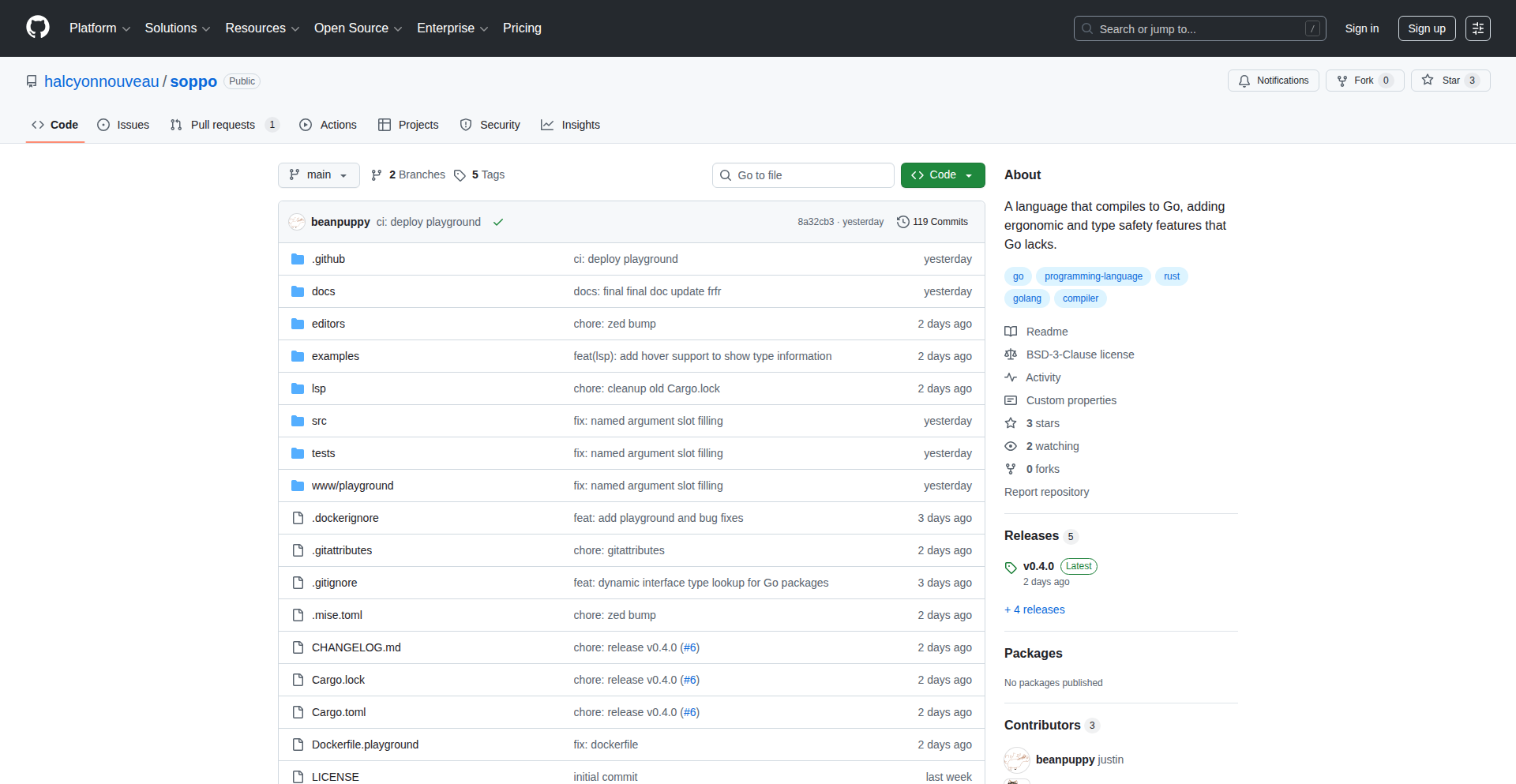

4

Superset - 智能代码助手并行指挥官

作者

hoakiet98

描述

Superset 是一款桌面应用程序,可以让你在自己的电脑上同时运行多个智能代码助手(比如 Claude Code, Codex 等)。它的核心创新在于,能让这些助手像流水线一样协同工作,避免开发者在等待一个助手完成任务时陷入停滞,并快速切换到需要人工干预的任务,极大地提升了开发效率。这就像给你配备了一个能同时指挥多个聪明小助手的超级大脑,让你的代码编写过程顺畅无比。

人气

点赞 22

评论数 3

这个产品是什么?

Superset 是一个能够让你的电脑像个智能代码工厂的工具。它允许你同时启动并运行很多不同的AI编程助手(例如,一个助手帮你写测试,另一个帮你优化代码)。它的技术原理是,为每个助手和它们的工作任务创建一个独立的环境,就像给每个助手一个专属的房间,这样它们就不会互相干扰。而且,当助手完成任务或者需要你帮忙时,它会及时通知你,让你永远掌握最新进展。它真正的价值在于,打破了过去一次只能让一个AI助手工作的局限,让你能更高效地利用AI的力量。

如何使用它?

开发者可以将 Superset 安装在自己的电脑上。当你需要同时进行多项编码任务时,比如让一个AI助手编写单元测试,同时让另一个AI助手重构代码,你只需在 Superset 中创建新的“工作区”(worktree),然后为每个工作区指定不同的AI助手和任务。Superset 会自动为你设置好环境,让你可以在不同的工作区之间无缝切换。当你看到AI助手完成任务的通知时,就可以立刻过去查看和接管。这就像是在你的开发工具箱里多了一个能高效调度AI资源的智能指挥中心。

产品核心功能

· 并行运行多个AI编码助手:这意味着你可以同时让一个AI帮你写代码,另一个AI帮你找bug,还有一个AI帮你生成文档,所有这些都在后台同时进行,而你只需要在一旁协调,从而大大缩短了开发周期。

· 独立的工作区管理:每个AI助手和它的任务都被隔离在一个独立的环境中,就像每个助手都有自己的工作台,这样可以避免它们之间因为共享资源而产生冲突,保证了工作的稳定性和数据的安全。

· 实时任务通知:当AI助手完成工作或需要你进行决策时,Superset 会立即发送通知。这确保了你不会错过任何关键时刻,能够及时地对AI的产出进行审核和指导,确保项目按时推进。

· 一键式Git工作区创建:Superset 能帮你快速创建代码版本管理(Git)的工作区,并自动配置好开发环境。这极大地简化了项目初始化和多任务切换的流程,让你能把更多精力放在写代码上,而不是繁琐的环境配置。

· 跨AI助手的智能上下文传递(未来功能):设想一下,一个AI助手(如Codex)帮你制定了一个代码计划,然后另一个AI助手(如Claude Code)根据这个计划去实现,最后再由Codex来审查。Superset 正在探索实现这种智能的“AI协作流水线”,让AI之间也能高效地接力工作,进一步提升开发效率。

产品使用案例

· 场景:大型项目重构。一位开发者需要同时对多个模块进行重构,并为每个模块编写新的测试用例。使用 Superset,他可以为每个模块创建一个独立的工作区,分别指派 Codex 负责重构,指派 Claude Code 编写测试。这样,他可以在等待两个AI助手工作的空闲时间,处理其他更紧急的任务,而无需在等待中浪费时间,代码重构和测试编写同时推进。

· 场景:并行开发独立功能。在一个需要快速迭代的产品中,多位开发者需要同时开发不同的独立功能。使用 Superset,项目经理可以将每个功能分配给一个AI助手,并在各自的工作区中进行开发。这样,即便其中一个功能需要大量AI辅助,也不会影响到其他功能的并行开发进度,保证了团队整体的开发效率。

· 场景:编写复杂的单元测试。开发者需要为一段复杂的业务逻辑编写详细的单元测试。他可以指派一个AI助手(如Codex)来分析业务逻辑,然后让另一个AI助手(如Claude Code)基于分析结果生成大量的测试代码。Superset 确保了这两个AI助手的工作环境独立,并且在完成后及时通知开发者进行审查,大大缩短了测试编写的周期。

· 场景:快速原型验证。当需要快速验证某个技术方案或新功能的可行性时,开发者可以使用 Superset 同时启动多个AI助手,让它们并行地生成不同版本的代码片段或原型。这样,开发者可以在短时间内收集到多个可供选择的解决方案,并快速做出决策,加速了产品的早期探索过程。

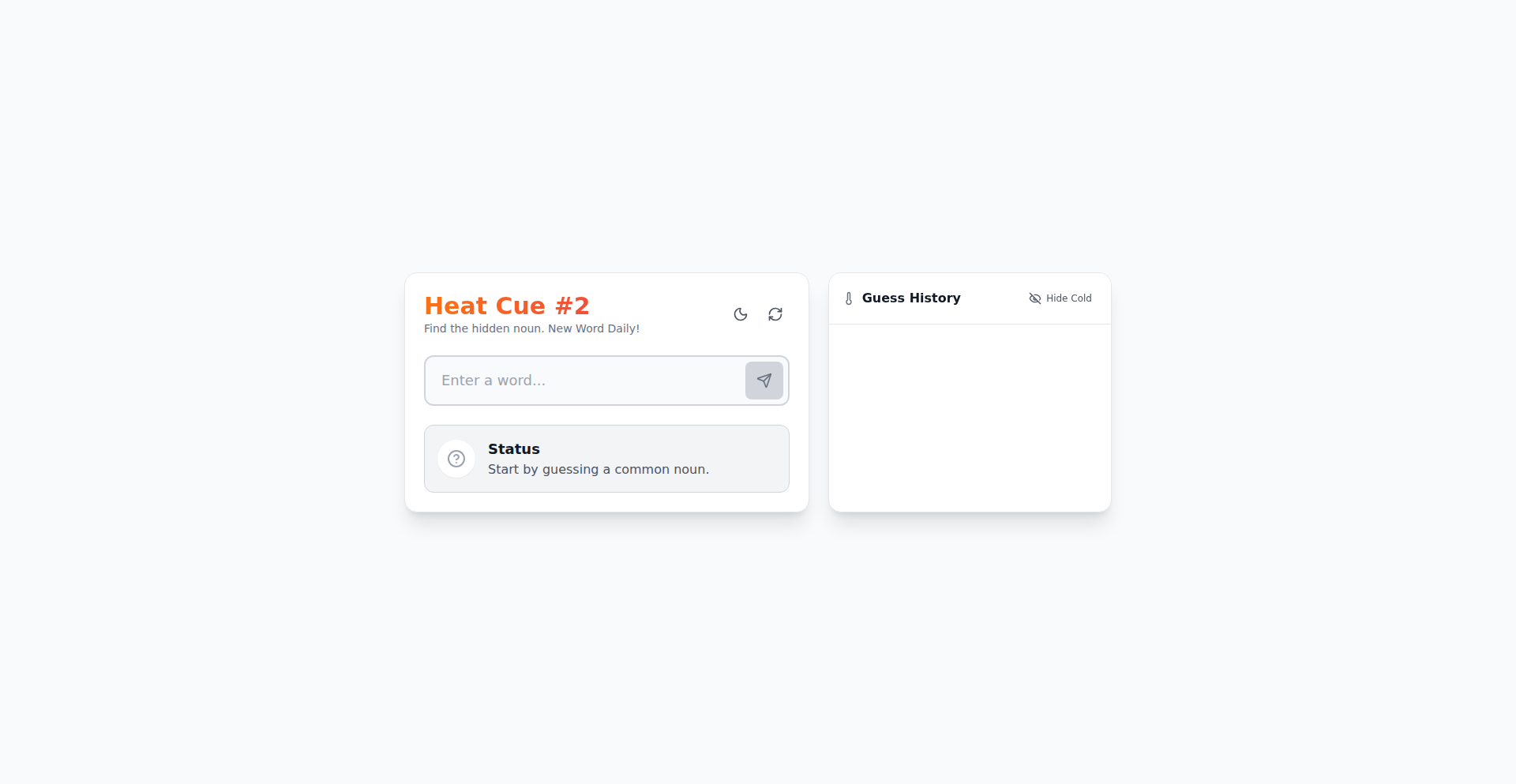

5

CurioQuest: 知识探索者

作者

mfa

描述

CurioQuest 是一个简单有趣的在线知识问答游戏。它的核心技术创新在于将大量知识点通过 PWA(渐进式 Web 应用)技术封装,使其能像手机应用一样安装在设备上,同时提供多语言支持和分级难度,方便用户随时随地进行碎片化学习和娱乐。

人气

点赞 6

评论数 10

这个产品是什么?

CurioQuest 是一个用代码构建的、可以安装在手机或电脑上的知识问答游戏。它收集了超过2600个有趣的事实和知识点,分布在7个类别中,每个类别还有4个不同难度的等级。最棒的是,它支持中英双语,而且你可以直接把它“安装”到你的设备上,不需要通过应用商店。这就像是把一个小型百科全书游戏放进了你的口袋,随时都可以点开来挑战自己,增长见识。

如何使用它?

开发者和普通用户都可以轻松使用 CurioQuest。对于普通用户,就像使用其他网站一样,访问链接即可开始游戏,你还可以将它添加到主屏幕,让它看起来和感觉都像一个原生应用。对于开发者,CurioQuest 展示了 PWA 的强大能力,它通过 Service Worker 技术实现了离线访问和快速加载,同时利用前端技术构建了流畅的用户体验。如果你想了解如何构建类似的 Web 应用,CurioQuest 的代码提供了一个很好的学习范例。

产品核心功能

· 知识问答游戏引擎:通过代码逻辑实现题库的随机抽取、用户答题、分数计算和结果反馈,让学习过程更具趣味性。

· PWA(渐进式 Web 应用):利用 Service Worker 和 Web App Manifest 技术,让应用可以离线运行,支持添加到主屏幕,提升用户体验和便捷性。

· 多语言支持:通过前端架构设计,能够轻松切换英文和葡萄牙语,满足不同语言用户群体的使用需求。

· 难度分级系统:将题目按照难度进行划分,满足不同知识水平用户的挑战需求,实现个性化的学习体验。

· 跨平台兼容性:基于 Web 技术开发,可以在各种支持浏览器的设备上运行,实现真正的“一次开发,多处运行”。

产品使用案例

· 学习者在通勤或休息时间,通过手机上的 CurioQuest 快速回顾历史、科学等领域的知识点,将碎片时间转化为学习机会。

· 教师可以利用 CurioQuest 作为课堂互动工具,增加教学的趣味性,激发学生的学习兴趣,并可以根据课堂进度调整难度。

· 对 PWA 开发感兴趣的开发者,可以通过研究 CurioQuest 的代码,学习如何实现应用的离线访问、缓存策略和添加到主屏幕功能,从而提升自己的 Web 应用开发技能。

· 想要快速了解某个领域趣味知识的用户,可以直接打开 CurioQuest,在游戏化的体验中获得知识,避免了枯燥的学习方式。

6

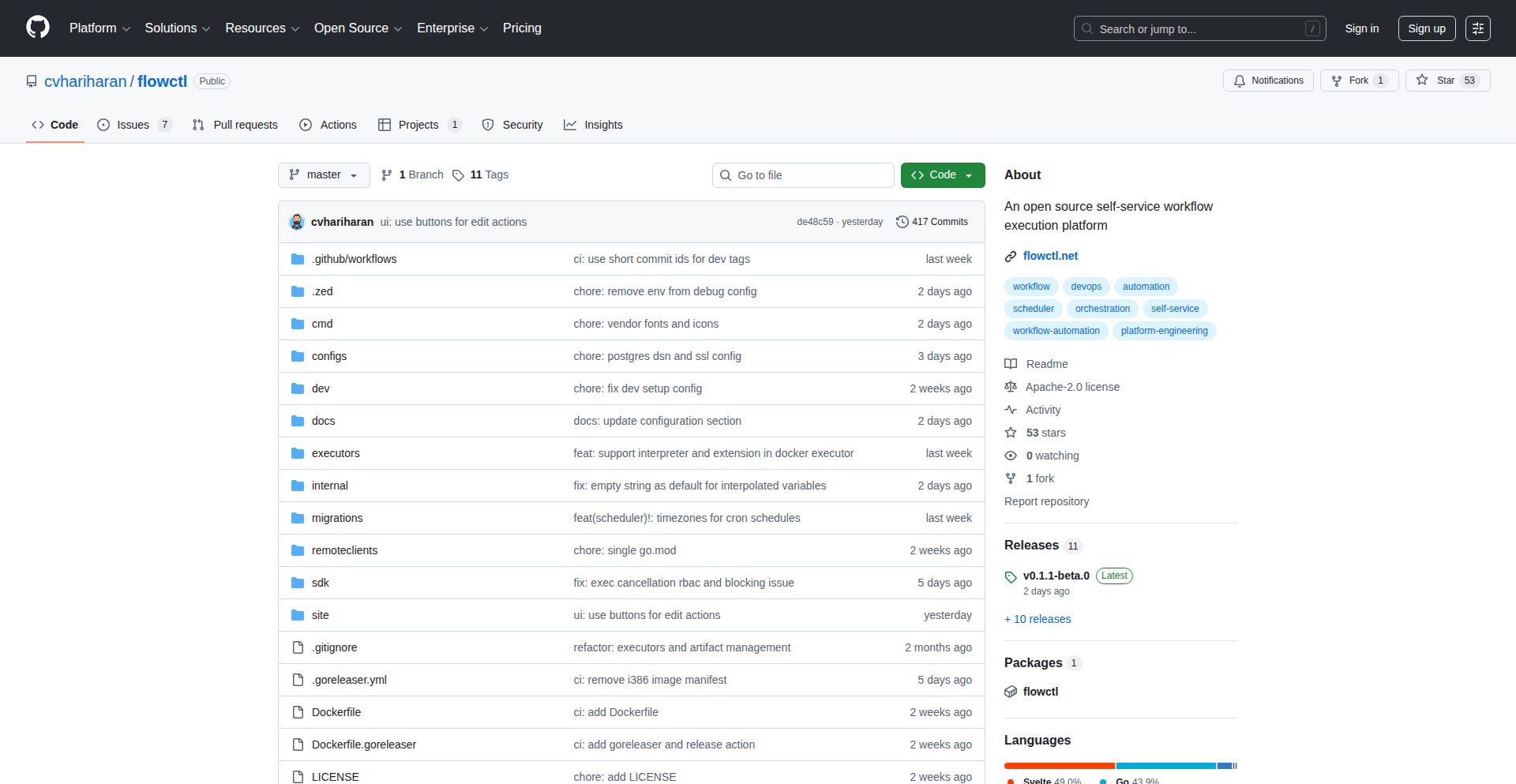

Flowctl: 极简工作流引擎

作者

cv_h

描述

Flowctl 是一款开源的自服务工作流自动化平台,它将复杂的任务流程打包成一个简单的可执行文件,让普通用户也能安全地触发和执行预设的操作。它解决了在日常运维、基础架构管理或自定义业务流程中,需要将重复性高、流程固定的任务,变成用户自助可控的操作的难题。其核心创新在于采用“执行器”(executor)的理念,使其能够灵活适应各种领域的任务,同时保持高度的简洁性和易用性,甚至可以实现无代理(agentless)的远程操作。

人气

点赞 15

评论数 1

这个产品是什么?

Flowctl 是一个能让你把一系列复杂的操作(比如给某台服务器开通 SSH 权限、部署一套新的服务、或者执行一个特定的业务流程)变得像点一下按钮一样简单的工具。它通过一个叫做“执行器”(executor)的概念,可以连接到各种不同的地方(比如远程服务器、Docker 容器)去执行你定义的任务。比如,你定义了一个“给新员工开通开发环境”的工作流,这个工作流可能包含创建用户、分配权限、安装软件等一系列步骤。Flowctl 能够将这些步骤串联起来,并且提供一个用户界面让非技术人员也能触发这个工作流,而无需理解背后的技术细节。它的创新之处在于,它能将所有这些复杂的配置和执行逻辑,浓缩成一个独立的二进制文件,这意味着部署和使用都非常方便,而且它还能做到完全不需要在目标服务器上安装任何额外的软件(无代理),这大大降低了安全风险和管理复杂度。所以,它对你来说,意味着你可以把重复性的、需要多人协作的、或者需要跨多个系统才能完成的任务,变成一个可自助、可追溯、易于操作的服务。

如何使用它?

开发者可以将 Flowctl 部署为一个服务,然后通过其提供的 Web UI 或者 API 来创建和管理工作流。例如,你可以定义一个工作流,让产品经理在需要时能够一键部署一个测试环境。这只需要在 Flowctl 中配置好目标服务器的 SSH 信息(Flowctl 会妥善保管这些敏感信息,比如加密存储)、定义好需要执行的脚本或 Docker 命令,并且设置好执行的权限和触发条件(比如手动触发、定时触发、或者需要审批后触发)。Flowctl 负责连接到目标服务器(通过 SSH),执行预设的脚本或命令,并将执行结果反馈给你。你还可以集成 SSO(单点登录)功能,让用户通过已有的身份系统登录,提高安全性。所以,对于开发者来说,它提供了一种标准化的方式来封装和自动化那些需要跨多个系统、涉及多步操作的技术任务,并将它们以服务化的形式提供给团队内的其他成员,降低了整体的运维负担。

产品核心功能

· SSO (OIDC) 与 RBAC 集成:提供安全的单点登录功能,并能细粒度地控制用户对工作流的访问权限,这意味着可以把敏感的操作自动化,同时确保只有授权人员才能执行,提高了安全性。

· SSH 远程执行(无代理):可以直接在远程服务器上执行命令,而无需在服务器上安装任何额外的客户端软件,大大简化了部署和维护,降低了安全风险。

· 审批流程:可以在工作流的执行过程中加入人工审批环节,确保重要操作在执行前经过复核,适用于对安全性和准确性要求高的场景。

· 定时调度(Cron):支持按照预设的时间表自动触发工作流,非常适合执行周期性的维护任务、数据备份或报告生成等。

· 可视化流程编辑器:提供一个图形化的界面来设计和配置工作流,使得定义复杂的流程变得直观易懂,即使是非技术人员也能参与到工作流的设计中。

· 加密凭证和密钥存储:安全地存储敏感信息,如数据库密码、API 密钥等,并在需要时将其安全地传递给工作流执行,避免了明文存储的风险。

· Docker 和脚本执行器:能够执行 Docker 容器内的命令,或者直接运行 Shell 脚本,提供了极大的灵活性来自动化各种技术任务。

· 命名空间管理:允许将工作流按照逻辑分组,方便管理大量的自动化任务,特别是在大型团队或复杂项目中,能提高效率和可维护性。

产品使用案例

· 在居家旅行时,开发者需要远程管理自己的家庭服务器,通过 Flowctl,他可以创建一个简单的 Web UI 来触发脚本,比如重启服务、查看日志、或者执行一个备份任务,而无需担心暴露服务器的 SSH 端口,降低了安全风险。

· 在公司里,IT 运维团队需要为新入职的员工快速配置开发环境,这通常涉及创建用户、安装软件、配置权限等一系列重复性操作。使用 Flowctl,可以将其封装成一个“新员工环境设置”的工作流,HR 或者 the new hire 自己就能触发,大大缩短了入职准备时间,也减轻了 IT 团队的负担。

· DevOps 团队需要一个简单的方式来管理基础架构的变更,比如更新某个服务的配置。通过 Flowctl,可以将这个更新过程自动化,设定好需要审批的环节,然后开发人员或运维人员就可以在需要时触发更新,确保变更的可控性和可追溯性。

· 一个电商平台需要定期清理过期订单的数据库记录。使用 Flowctl 的定时调度功能,可以设定好清理脚本,并配置好执行的频率,确保数据库的健康运行,而无需人工值守。

· 在一些需要执行复杂但重复性的数据处理任务时,比如生成月度报告。可以将数据提取、处理、格式化等步骤设计成一个 Flowctl 工作流,并设定为按月自动运行,省去了人工操作的麻烦,保证了报告的及时性和准确性。

7

Furnace: 现代怀旧Chiptune音乐创作工作台

作者

hilti

描述

Furnace 是一个基于ImGui技术的Chiptune音乐创作工具,它将复古的8位游戏音乐创作体验带回现代。它通过模拟早期游戏机的音频芯片,让开发者能以前所未有的方式创作和编辑Chiptune音乐,解决了在现代开发环境中难以找到易用且功能强大的复古音乐创作工具的痛点。所以,它让你能在电脑上轻松制作出经典游戏里的那种独特电子音乐。

人气

点赞 14

评论数 0

这个产品是什么?

Furnace 是一个运行在电脑上的软件,专门用来制作一种叫做Chiptune的电子音乐,这种音乐听起来很像老式电子游戏里的背景音乐。它的核心创新在于使用了ImGui(Immediate Mode GUI)这个技术。ImGui是一种特别适合快速开发用户界面的库,它允许开发者以一种非常直观和代码驱动的方式来构建复杂的交互界面,而不需要写很多复杂的界面布局代码。Furnace 利用ImGui实现了对早期游戏机音频硬件(比如NES、Game Boy等)的模拟,并提供了直观的界面来控制这些虚拟硬件发出声音、编写旋律和节奏。所以,它让你能用一种很“黑客”的方式,直接用代码和简单的界面来“指挥”虚拟的芯片生成复古的音乐。

如何使用它?

开发者可以通过克隆Furnace的GitHub仓库,然后在自己的开发环境中编译和运行它。它通常作为一个独立的应用程序运行,开发者可以通过鼠标点击和键盘输入来操作界面。例如,可以在音序器(sequencer)区域输入音符来编写旋律,调整虚拟音频发生器的参数来改变音色,还可以导出生成的音乐文件(如.wav或MIDI),以便在其他音乐制作软件中进一步编辑或直接使用。它特别适合那些对游戏开发、复古文化感兴趣,或者想为自己的项目添加独特复古音效的开发者。所以,你可以用它来为你制作的游戏、短片,或者任何需要怀旧电子音乐的项目,创作独一无二的背景音乐。

产品核心功能

· 模拟老式音频芯片(如NES PPU的APU):通过代码精确还原早期游戏机的声音生成机制,让开发者能够创作出地道的8位音乐,这提供了无与伦比的复古音色和创作限制带来的独特艺术性。所以,你可以用它创作出和超级马里奥、塞尔达传说一样的音乐。

· 直观的图形用户界面(基于ImGui):提供一个易于上手且响应迅速的界面,让用户能够快速地编辑音符、调整参数和预览音乐,大大提高了创作效率,克服了传统复古音乐工具操作的复杂性。所以,你不需要成为音乐大师,也能快速上手创作。

· 内置音序器和模式编辑器:允许用户以可视化的方式安排音符、创建重复的音乐片段(loops)和复杂的节奏型,这是构建完整音乐作品的基础,并且保留了复古音乐创作的结构特点。所以,你可以用它来编排一首完整的复古风格歌曲。

· 实时音频预览和导出功能:在创作过程中能够即时听到效果,并支持导出多种音频格式,方便与其他工具集成或用于最终产品,这使得创作过程更加流畅且易于将成果应用到实际项目中。所以,你创作的音乐可以马上听到,并能用在你想要的任何地方。

产品使用案例

· 独立游戏开发者为游戏添加怀旧风格BGM:在一个复古像素风的独立游戏项目中,开发者可以使用Furnace快速创作出与游戏画面风格高度匹配的Chiptune背景音乐,为游戏营造沉浸式的复古氛围,解决了寻找专业复古音乐人或购买昂贵授权音乐的难题。所以,你自己的游戏就能拥有像老任游戏一样的好听的音乐。

· 学习Chiptune音乐创作的开发者:对于想深入了解Chiptune音乐原理和创作技巧的开发者,Furnace提供了一个低门槛的实践平台,可以通过研究其代码和界面来学习模拟合成、音序器设计等技术,促进了技术和艺术的融合。所以,你可以边写代码边学怎么做复古电子乐。

· 制作短视频或动画的配乐:内容创作者在制作带有复古元素的短视频、YouTube系列或独立动画时,可以使用Furnace创作出独特且具有辨识度的背景音乐,为其作品增添个性和创意,摆脱了使用通用素材的单调感。所以,你的视频会因为独特的背景音乐而更吸引人。

· 电子音乐爱好者探索新的创作方式:对电子音乐感兴趣但又想尝试不同风格的音乐人,可以通过Furnace体验一种不同于现代DAW(数字音频工作站)的创作流程,这种限制性的创作环境反而能激发新的灵感和创意。所以,你可以用一种全新的方式来玩转电子音乐。

8

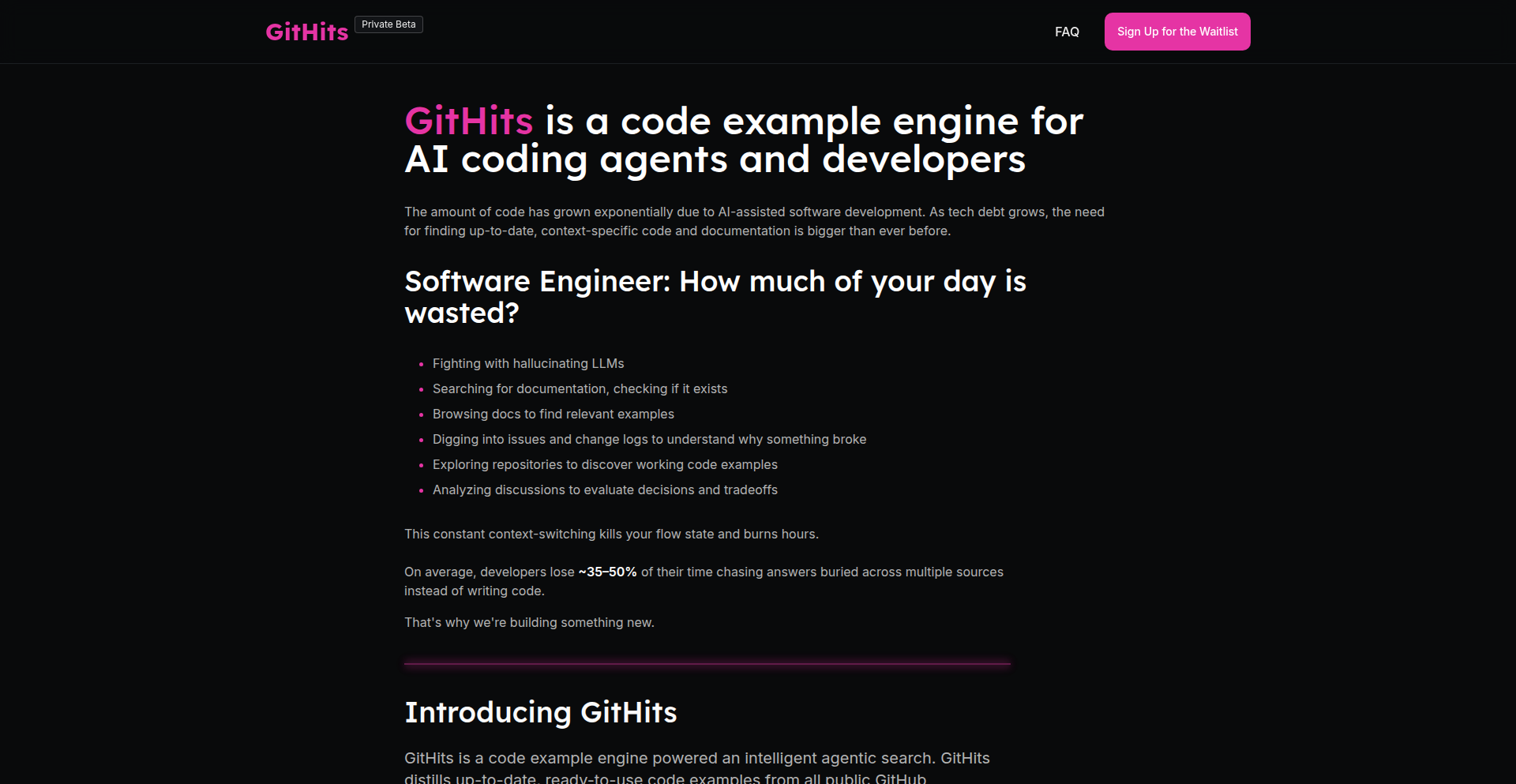

GitHits 代码案例引擎

作者

skvark

描述

GitHits 是一个智能的代码示例搜索引擎,它能深入分析数百万个开源代码库,找到解决特定编程问题的真实代码片段,并将其提炼成一个易于理解的示例。它旨在帮助开发者和AI代码助手快速找到实际问题的解决方案,克服传统搜索和AI模型的局限性。

人气

点赞 10

评论数 4

这个产品是什么?

GitHits 是一个专门为开发者和AI代码助手设计的工具,它不像传统的搜索引擎那样只能返回一堆链接,而是能直接找到并提炼出解决你编程难题的代码示例。想象一下,当你遇到一个棘手的bug或者不知道如何实现某个功能时,GitHits就能在浩瀚的开源代码海洋中,捞出别人已经成功解决问题的“教科书”般的代码片段。它的创新之处在于,它不仅仅是搜索代码,还会分析代码周围的文档、讨论和issue,综合判断出最可靠、最贴近实际应用的代码模式,并生成一个简洁高效的代码示例。这就像有一个经验丰富的程序员在旁边指导你,告诉你“看,大家都是这么做的”。

如何使用它?

开发者可以通过GitHits的网页界面直接使用,输入你遇到的问题或想要实现的功能描述,GitHits就会为你呈现相关的代码示例。更进一步,GitHits还支持通过MCP(Meta Code Protocol)与你喜欢的AI代码助手(如IDE插件)集成。这意味着,当你在写代码时遇到困难,AI助手可以直接调用GitHits来为你查找并提供实用的代码参考,大大提升开发效率,让AI助手不再只是“一本正经胡说八道”,而是能提供真正可用的代码。

产品核心功能

· 深度代码库搜索:GitHits能够索引并搜索数百万个开源代码库的真实代码,找到与开发者意图高度匹配的解决方案。这能帮你快速定位到别人已经解决过的问题,节省大量自行摸索的时间。

· 跨源信息整合:它不仅仅搜索代码文件,还会融合相关的文档、issue讨论和Pull Request等信息,综合分析出最有效的代码模式。这意味着你得到的代码示例是经过社区验证的,更加可靠。

· 智能示例提炼:GitHits能将分散在不同代码库中的相似解决方案聚类,并提炼出一个简洁、高效、可直接使用的代码示例。这让你无需阅读大量冗余代码,就能快速掌握核心实现思路。

· AI助手集成:通过MCP协议,GitHits可以无缝集成到AI代码助手和IDE中,为AI提供真实、最新的代码参考,让AI编程助手在解决实际问题时更加得心应手。

· 问题导向的搜索:GitHits的核心目标是“解除阻碍”,而不是泛泛的搜索。它专注于找到解决具体编程问题的最佳实践,让你尽快摆脱困境。

· 多信号质量排序:它使用多种信号(代码质量、社区反馈、代码活跃度等)来对搜索结果进行排序,确保你看到的是最优质、最相关的代码示例。

产品使用案例

· 场景:一名Python开发者想用pandas处理一个复杂的CSV文件,但遇到了数据清洗的难题,不知道如何高效地处理缺失值和异常格式。通过GitHits搜索“pandas data cleaning missing values”,GitHits会从大量的pandas项目里,找到最常用的、最有效的缺失值处理和数据格式转换代码模式,并生成一个可以直接复制粘贴使用的代码片段,让他快速解决问题。

· 场景:一名JavaScript开发者在构建一个交互式图表时,需要集成一个第三方库,但不知道如何将该库的API与自己的前端框架(如React)进行结合。在GitHits中输入“javascript chart library integration react”,它会分析那些成功集成的开源项目,提炼出使用该图表库在React组件中的常见模式和代码示例,开发者可以此为基础快速完成集成。

· 场景:AI代码助手在为开发者生成代码时,往往生成一些通用的、不一定适用于特定复杂场景的代码。通过GitHits,AI助手能够为其提供更贴近真实项目实践的代码参考,从而生成更准确、更实用的代码,例如在C++项目中,AI可以借助GitHits找到处理特定内存管理的最佳实践。

· 场景:一位Rust开发者在编写并发程序时,对如何安全地共享数据感到困惑。他可以通过GitHits搜索“rust concurrent data sharing safe”,GitHits会展示实际项目中是如何使用Rust的锁、原子类型等机制来安全地共享数据,并提供清晰的代码示例,帮助开发者理解并应用。

· 场景:开发者在一个项目中使用了多种不同的库,并且需要在它们之间进行数据传递和交互。GitHits可以帮助开发者找到那些成功实现了类似库间集成的项目,提供跨库集成的代码模式和最佳实践,解决不同技术栈之间的集成难题。

9

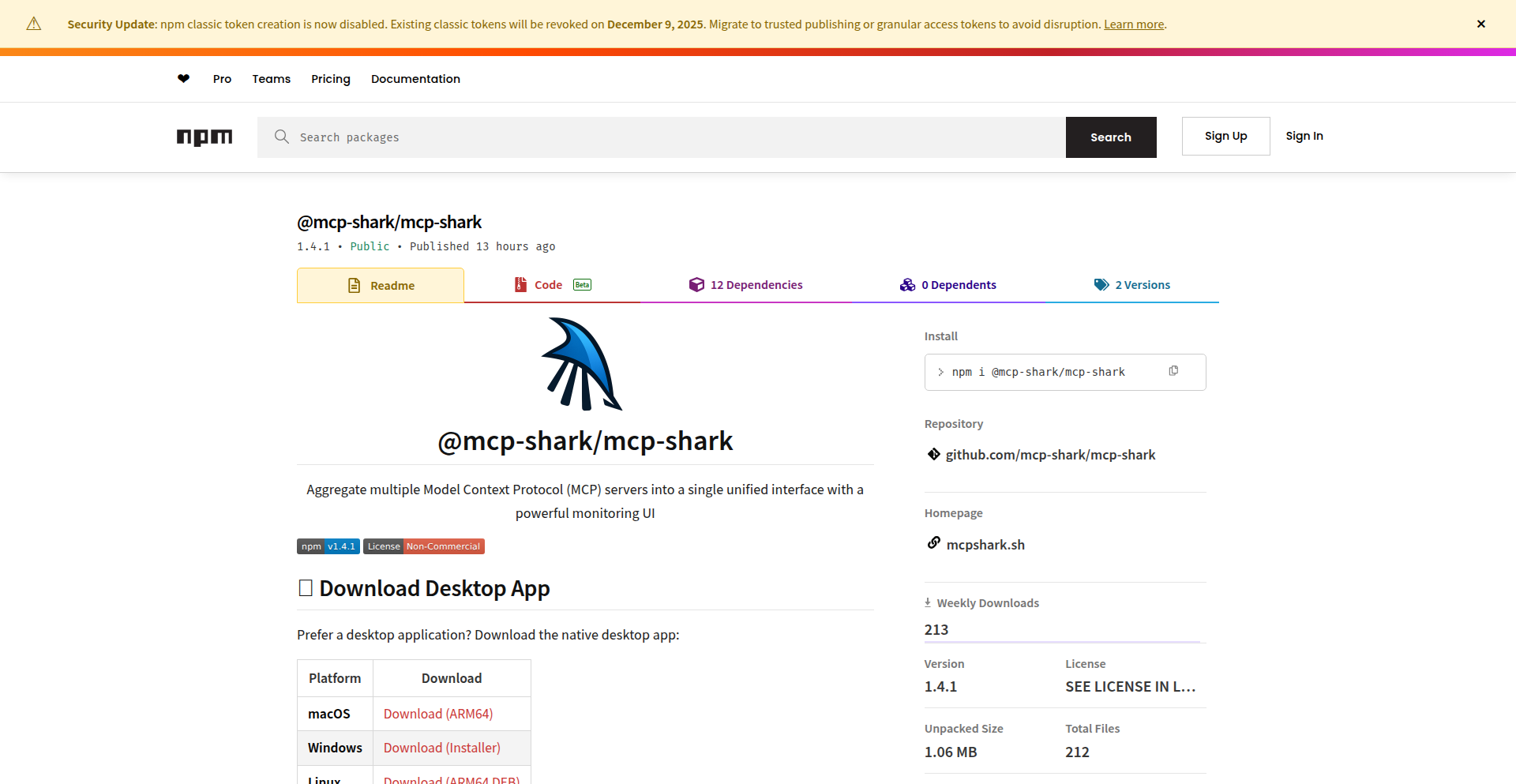

NPM包流量可视化侦探

作者

o4isec

描述

这个项目叫做MCP Traffic Analyze with NPM,它是一个利用Node Package Manager(NPM)来分析网络流量的可视化工具。它通过捕捉和分析NPM下载和更新时的网络请求,帮助开发者洞察包管理器在下载和管理依赖时的行为,发现潜在的网络问题或不寻常的流量模式。这对于优化开发环境、排查网络故障或了解NPM生态的运作方式非常有价值。

人气

点赞 11

评论数 0

这个产品是什么?

MCP Traffic Analyze with NPM 是一个能够让你看到NPM包下载和更新时到底在“做什么”的可视化工具。想象一下,当你运行`npm install`或者`npm update`时,你的电脑会和网络上的NPM仓库进行大量的通信,下载各种各样的代码文件。这个项目就像一个显微镜,它能捕捉到这些通信的每一个细节,比如哪些文件被下载了,从哪里下载的,下载速度怎么样,有没有出现错误等等。它的技术核心是利用网络抓包技术(proxy server),拦截NPM客户端和NPM仓库之间的通信,然后将这些原始数据转换成易于理解的图表和报告。它的创新之处在于,它专门针对NPM这个开发者常用的工具,将复杂的网络通信过程可视化,帮助开发者更直观地理解包管理的底层运作,从而能更快地发现和解决与NPM相关的网络问题。

如何使用它?

对于开发者来说,使用这个项目非常简单。你可以在你的开发机器上运行这个工具,它会充当一个代理服务器。然后,你配置你的NPM客户端,让它通过这个代理服务器去访问NPM仓库。当你执行NPM命令时,所有的网络请求都会经过MCP Traffic Analyze。这个工具会将捕获到的流量数据实时地显示在用户界面上,你可以看到下载进度、文件列表、请求时间等信息。如果你在开发过程中遇到NPM下载缓慢、下载失败、或者想了解某个包下载了哪些文件,都可以用这个工具来分析。它就像是给你的NPM操作加上了一个“监控摄像头”,让你能清楚地知道发生了什么。

产品核心功能

· 实时网络流量捕获:它能够实时捕获NPM在下载或更新包时产生的所有网络请求,就像一个交通摄像头捕捉车辆信息一样。这让你能够了解NPM在进行什么操作。

· 详细流量数据分析:对于捕获到的每一个请求,它都能提供详细信息,比如请求的URL、请求方法、响应状态码、下载速度、文件大小等。这就像是为每一辆“车”打上了详细的“标签”,让你了解它的“行程”和“状态”。

· 可视化流量报告:它将捕获到的流量数据以直观的图表形式展示出来,比如下载进度条、请求瀑布图、错误率统计等。这使得复杂的网络数据变得易于理解,就像把交通拥堵情况用地图和颜色标注出来一样,让你一眼就能看出问题所在。

· 错误和异常检测:它可以帮助你识别NPM下载过程中的错误,比如连接超时、文件损坏等,并将其突出显示。这相当于交通摄像头不仅记录车辆,还能自动报警“前方有事故”,帮助你及时发现问题。

· 依赖关系可视化(潜在功能):虽然不是明确列出,但通过分析下载的文件,理论上可以推导出包的依赖关系,并进行可视化展示。这就像根据车辆的行驶轨迹,推断出它们的目的地和关联性,让你了解整个“车队”的构成。

· 优化网络配置建议(潜在价值):通过分析不同网络环境下的下载速度和稳定性,可以为开发者提供网络配置的优化建议。这就像根据不同路况,推荐最佳的行驶路线一样,帮助开发者更高效地使用NPM。

产品使用案例

· 开发者在团队协作时,发现某个开发者机器上NPM下载速度异常缓慢,通过MCP Traffic Analyze,可以定位到是特定NPM仓库地址访问不稳定,从而排查网络设备或DNS设置问题。

· 一个新的NPM包发布,开发者想快速了解它包含了哪些文件,以及是否包含一些不常见的依赖,可以使用MCP Traffic Analyze来监控下载过程,并查看具体的文件列表和下载详情。

· 在CI/CD流水线中,NPM依赖安装失败,但错误信息不明确。将MCP Traffic Analyze集成到流水线中,可以捕获详细的网络请求和响应,帮助快速定位是网络中断、仓库认证问题还是文件传输错误。

· 开发者想要评估不同NPM镜像源的速度和稳定性,可以通过MCP Traffic Analyze分别代理不同镜像源进行测试,然后比较下载速度和成功率,做出最优选择。

· 某个NPM包在特定网络环境下总是下载失败,MCP Traffic Analyze可以捕获到失败时的具体网络请求,查看响应头和响应体,从而推断出是服务器配置问题、防火墙拦截还是数据包损坏等原因。

10

FFmpeg 工程手册:视频处理的黑客宝典

作者

endcycles

描述

这是一个由资深开发者整理的 FFmpeg 工程手册,聚焦 FFmpeg 这个强大的多媒体处理工具的深度技术原理和工程实践。它不是一个简单的教程,而是深入挖掘 FFmpeg 内部机制,解释其工作流程、核心算法和常用命令背后的技术逻辑,帮助开发者更高效、更深入地使用 FFmpeg 解决复杂的音视频处理问题,体现了用代码解决复杂工程挑战的黑客精神。

人气

点赞 10

评论数 0

这个产品是什么?

这是一个深入剖析 FFmpeg 技术细节的工程手册。FFmpeg 是一个非常强大的开源项目,可以用来处理几乎所有的音视频格式,比如转换视频格式、压缩视频、提取音频、添加字幕等等。这个手册的不同之处在于,它不只是教你怎么用命令,而是告诉你 FFmpeg 为什么这么做,它的内部是如何工作的。比如,它会解释视频编码(就像把视频压缩成小文件)和解码(把小文件还原成视频)的原理,以及 FFmpeg 是如何通过不同的编码器(就像不同的压缩算法)来达到不同的效果的。这就像一本武功秘籍,告诉你招式背后的内功心法,让你能更灵活地运用,甚至创造出新的招式。所以,这对我来说,就是能让我更理解和掌握视频处理这个领域,写出更高效、更专业的音视频处理代码。

如何使用它?

开发者可以通过阅读这个工程手册来深入理解 FFmpeg 的工作原理。它提供了对 FFmpeg 核心组件、API 设计、内部数据流以及常用功能的详细解释。你可以把它当作一个参考资料库,当你遇到复杂的音视频处理需求,比如需要定制化的转码逻辑、实现流媒体传输、或者进行视频分析时,可以通过查阅手册找到 FFmpeg 内部机制的解答,从而编写出更精准、更高效的解决方案。它还可以帮助你理解 FFmpeg 的源码,进行二次开发或贡献代码。所以,这对我来说,就是当我面对一个棘手的音视频问题时,能找到 FFmpeg 内部的线索,用最适合的方式解决它,而不仅仅是套用现成的命令。

产品核心功能

· 深度解析 FFmpeg 内部架构:理解 FFmpeg 如何组织和管理不同的音视频处理模块,掌握其设计哲学,从而更好地集成或扩展 FFmpeg 的功能。这能帮助我写出更健壮、更易于维护的音视频处理代码。

· 详述音视频编码与解码原理:深入理解 H.264、VP9 等编码格式以及 AAC、Opus 等音频格式的工作原理,以及 FFmpeg 如何实现这些编解码过程,从而选择最合适的编解码器以达到最佳的压缩比和质量。这能让我在视频压缩和传输时,做到“又要马儿跑得快,又要马儿不吃草”,以最小的体积获得最好的观看体验。

· 剖析 FFmpeg API 和常用命令:不仅列出命令,更解释命令背后调用的 FFmpeg 内部函数和参数含义,帮助开发者理解命令的实际作用和潜在影响,从而更精准地控制音视频处理过程。这让我能用命令行精确指挥 FFmpeg 完成我想做的任何事情,而不仅仅是碰运气。

· 讲解流媒体协议和传输:理解 RTMP, HLS, DASH 等流媒体协议的工作原理,以及 FFmpeg 如何在这些协议下进行音视频的封装、传输和处理,为开发实时音视频服务或点播服务提供技术支撑。这能让我搭建起自己的视频直播或视频点播平台。

· 提供性能优化和调试技巧:分享 FFmpeg 在实际应用中的性能瓶颈分析方法和调试技巧,帮助开发者提高处理速度,减少资源消耗,并快速定位和解决问题。这能让我避免因为处理速度慢而导致项目延期,让视频处理像流水线一样顺畅。

· 探讨 FFmpeg 的工程实践和设计模式:分享 FFmpeg 项目背后的工程经验和代码组织方式,以及处理复杂多媒体任务的设计模式,为开发者构建大规模音视频处理系统提供借鉴。这能让我从巨人的肩膀上学习,构建更强大、更可靠的音视频处理系统。

产品使用案例

· 一个内容平台需要将用户上传的各种格式视频(如 MP4, MOV, AVI)统一转换为 WebM 或 H.265 格式,以适应不同设备和网络环境的播放。使用 FFmpeg 工程手册可以深入理解不同编码格式的特性,并精确配置 FFmpeg 参数,实现高效、高质量的批量转码,满足跨平台播放需求。这解决了视频兼容性差、播放卡顿的问题。

· 一个直播应用需要将摄像头采集到的实时视频流编码后推送到服务器,并能支持不同清晰度的码流。通过手册可以理解 RTMP 协议和 H.264 编码器的工作原理,并根据实时性要求优化编码参数,确保低延迟、高画质的直播体验。这解决了直播卡顿、画面模糊等痛点。

· 一个视频编辑软件需要实现快速视频剪辑和合并功能,同时支持添加各种字幕格式。手册中对 FFmpeg 的多路复用(muxing)和解复用(demuxing)的讲解,能帮助开发者设计出高效的视频剪辑逻辑,并理解如何正确处理字幕流。这使得用户可以快速编辑视频,而不用等待漫长的渲染过程。

· 一个安全监控系统需要对海量监控录像进行存储和检索,并能在需要时快速提取关键帧进行分析。理解 FFmpeg 的关键帧提取(keyframe extraction)能力,并结合手册中的性能优化技巧,可以高效地处理大量视频数据,降低存储成本,并快速定位需要的信息。这解决了海量视频存储和检索效率低的问题。

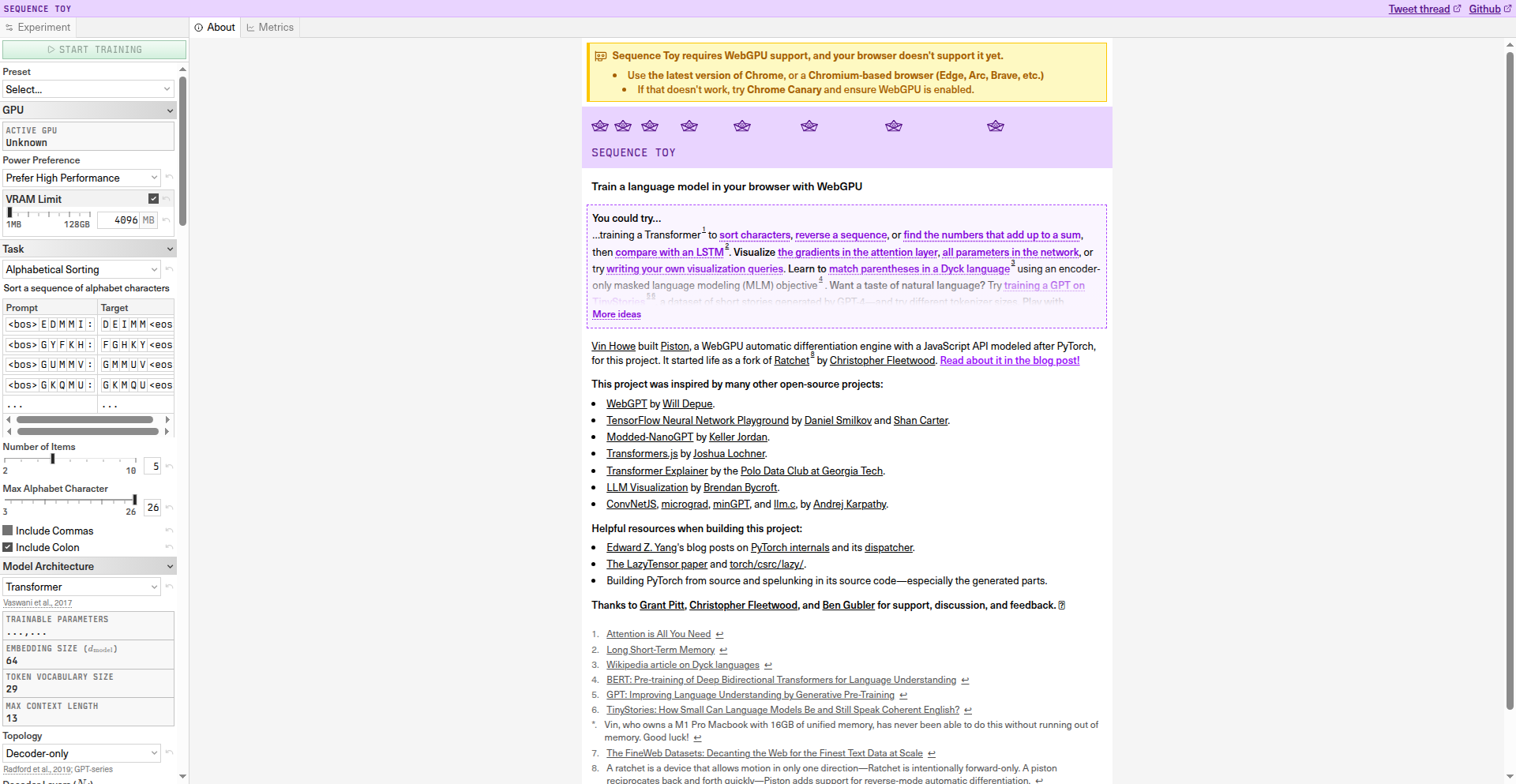

11

Wingfoil: 极致低延迟 Rust 流处理引擎

作者

terraplanetary

描述

Wingfoil 是一个用 Rust 语言编写的流处理框架,专注于实现超低延迟的数据传输。它解决了在需要实时响应的场景下,传统流处理框架延迟过高的问题,通过精巧的技术设计,让数据像飞翔的翅膀一样快速流动,非常适合需要毫秒级延迟的应用。

人气

点赞 6

评论数 1

这个产品是什么?

Wingfoil 是一个高性能的流处理框架,就像一个高速公路系统,专门为数据流设计。它的核心创新在于使用了 Rust 语言,这种语言在内存安全和性能方面表现出色,让 Wingfoil 能够避免很多常见的性能瓶颈。它通过优化数据在网络传输和内部处理的每一个环节,最大限度地减少数据从产生到被处理的时间差,达到“超低延迟”。这意味着数据能够以最快速度到达目的地,几乎感觉不到延迟,这对于需要即时反馈的应用至关重要。

如何使用它?

开发者可以将 Wingfoil 集成到需要实时处理大量数据的应用程序中。比如,你可以用它来构建一个能够实时分析股票行情的交易系统,或者一个可以立即响应用户操作的游戏后端。使用起来,你可以将 Wingfoil 视为一个管道,数据从一端进入,经过 Wingfoil 高效的处理和传输,然后从另一端出来,以极快的速度被使用。这通常涉及到编写一些 Rust 代码来定义数据源、数据处理逻辑以及数据目的地,然后将 Wingfoil 嵌入其中。

产品核心功能

· 超低延迟数据传输:Wingfoil 通过精细的内存管理和异步IO,确保数据包在网络上传输和内部处理时的时间损耗降到最低,这对于实时交易、在线游戏和物联网数据分析等对时间要求极高的场景非常有价值。

· Rust 语言优势:利用 Rust 内存安全和零成本抽象的特性,Wingfoil 在保证高性能的同时,也大大降低了因内存问题导致的程序崩溃风险,为构建稳定可靠的实时系统提供了保障。

· 流式数据处理:Wingfoil 能够持续不断地处理数据流,而不是一次性处理全部数据。这使得它非常适合处理海量、连续生成的数据,确保所有数据都能被及时纳入分析或响应。

· 可扩展性设计:框架设计考虑了未来的扩展性,方便开发者添加新的处理模块或与其他系统集成,能够应对不断增长的数据量和复杂的处理需求。

产品使用案例

· 金融交易系统:在股票、外汇等交易市场,毫秒级的延迟可能意味着巨大的收益或损失。Wingfoil 可以用来构建一个低延迟的交易执行引擎,确保交易指令能够以最快速度发出和响应。

· 在线游戏服务器:对于多人在线游戏,玩家的操作需要被服务器实时感知并反馈给其他玩家。Wingfoil 可以帮助构建一个响应迅速的游戏服务器后端,减少玩家操作的卡顿感。

· 物联网实时监控:例如,智能工厂的传感器数据需要被实时收集和分析,以便及时发现异常并做出反应。Wingfoil 可以处理海量的传感器数据流,实现低延迟的故障检测和预警。

· 实时数据分析仪表盘:需要将来自各种数据源的实时数据快速汇集并展示在仪表盘上,以便管理者做出即时决策。Wingfoil 可以高效地处理这些数据流,确保仪表盘上的信息永远是最新鲜的。

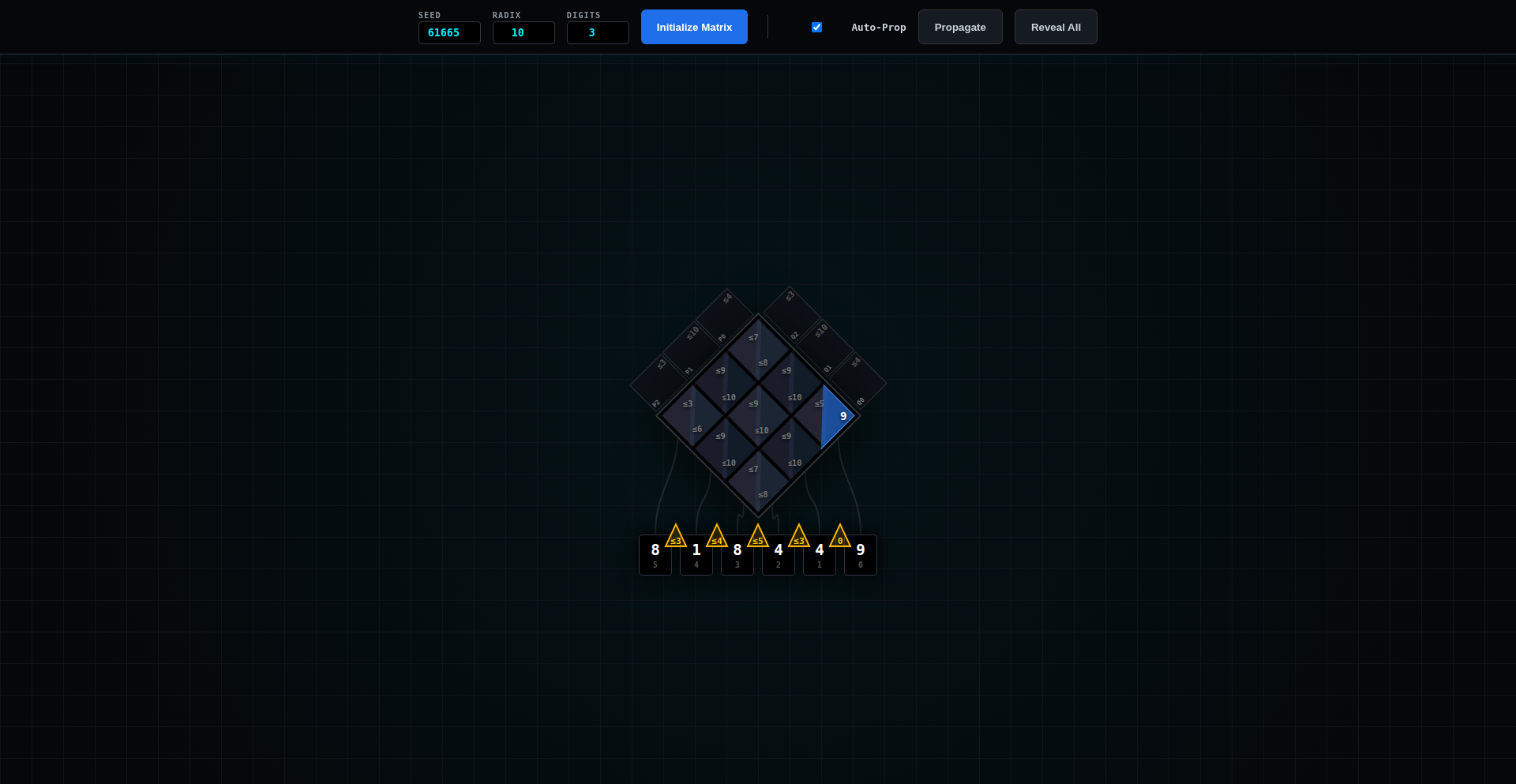

12

多进制半质因数约束谜题生成器

作者

keepamovin

描述

这是一个创新的趣味数学游戏,它通过将数学中的“半质数”(两个质数相乘得到的数)的概念,拓展到任意进制(radix)下,并结合“约束谜题”(Constraint Puzzle)的玩法,让玩家在数字和进制的双重维度上进行挑战。其技术核心在于能够灵活地生成和校验不同进制下的半质数因数分解谜题,这为数学爱好者和程序员提供了一个既烧脑又富有启发性的工具。

人气

点赞 1

评论数 5

这个产品是什么?

这个项目是一个数学谜题生成器,它的独特之处在于,它不是基于我们最熟悉的十进制,而是允许你在任何一种数字计数系统(比如二进制,也就是逢二进一;或者十六进制,也就是逢十六进一)里玩一个“猜数”的游戏。游戏的目标是找到一个数字,这个数字是由两个质数(只能被1和它本身整除的数)相乘得来的,并且这个过程需要在指定的进制下进行。想象一下,你不是在普通的十进制下分解一个数,而是在一个陌生的进制下,这大大增加了游戏的难度和趣味性。技术上,它的创新在于能够精确地处理不同进制下的数论运算,特别是涉及质数和因数分解的算法,并根据设定的规则自动生成复杂度适中的谜题,这背后是对数学算法的深度实践。

如何使用它?

开发者可以将这个项目看作是一个可以嵌入到各种应用程序中的数学引擎。例如,可以把它集成到一个教育APP中,用来教授学生不同进制的数学概念以及质因数分解的原理,让学习过程变得更加生动有趣。也可以将其作为一个游戏的核心玩法,开发一款独特的益智游戏,吸引喜欢挑战的玩家。对于数学研究者,它可以作为一个实验平台,探索不同进制下数论性质的可能性。使用上,开发者可以通过API调用来生成谜题,指定进制、数字范围和难度级别,然后将生成的谜题以图形界面或文本形式呈现给用户。

产品核心功能

· 任意进制数分解引擎:能够处理和计算任意进制下的数值,并进行数学运算,这对于跨进制的数学游戏或工具至关重要。

· 半质数生成与校验:能够高效地生成半质数(两个质数的乘积),并在目标进制下进行验证,这是谜题的基础,确保了题目的数学正确性。

· 约束谜题生成器:根据用户设定的规则(如数字范围、进制、质数因子限制等),自动生成具有挑战性的谜题,实现算法驱动的关卡设计。

· 跨进制数学运算库:提供在不同进制之间进行转换和运算的通用能力,为处理多进制数学问题提供坚实的技术支持。

· 趣味性与教育性集成:将抽象的数学概念转化为易于理解和操作的谜题,兼顾了游戏的趣味性和数学教育的价值,让学习不再枯燥。

产品使用案例

· 在教育技术领域,开发一款能够帮助中小学生理解不同进制(如二进制、八进制、十六进制)的数学学习APP。通过这个项目,学生可以在一个直观的游戏环境中,练习如何在这些进制下进行数字分解和因数查找,从而深刻理解数制转换和数论基础,解决“抽象概念难以理解”的教育痛点。

· 面向独立游戏开发者,可以基于此项目开发一款新颖的数学益智游戏。例如,设计一个太空探险游戏,玩家需要破解外星文明的密码(即在未知进制下的半质数谜题)来解锁星门。这能为玩家提供一种前所未有的解谜体验,解决“同质化游戏玩法”的问题,吸引追求独特体验的玩家群体。

· 在编程挑战平台或CTF(Capture The Flag)竞赛中,设计一系列涉及多进制数论的题目。这个项目可以作为一个强大的出题工具,自动生成具有迷惑性和挑战性的数学谜题,帮助参赛者锻炼在复杂数学和编程环境下的问题解决能力,为安全和算法竞赛领域提供新的挑战方向。

13

CodeViz: 代码洞察图谱引擎

作者

LiamPrevelige

描述

CodeViz 是一款 VS Code 插件,它能理解你的代码,并自动生成可编辑的架构图(支持 C4 模型和 UML)。它的技术创新在于,不再仅仅分析代码结构,而是利用 AI(借鉴了 Gemini-CLI 的思路)解析代码的实际行为和逻辑,生成更符合人类理解的图示,并能直接链接回源代码,方便开发者理解和协作。

人气

点赞 4

评论数 2

这个产品是什么?

CodeViz 是一个能将你的代码“看懂”并转化为可视化图表的工具。它不像传统的静态分析工具那样只关注代码结构(比如函数调用关系),而是通过更智能的方式(类似 Gemini-CLI 的技术,可以理解代码的意图和流程)来解读代码,生成 C4 模型或 UML 图。这些图不只是图片,而是可以与代码联动的。最酷的是,你可以点击图中的某个部分,它会直接带你去看对应的代码,或者让 AI 帮你可视化特定的代码流程。这解决了开发者很难快速理解复杂代码库、团队成员之间沟通成本高的问题。它用 AI 的方式来“阅读”代码,并用图的方式“讲述”代码。

如何使用它?

开发者可以在 VS Code 中安装 CodeViz 插件。安装完成后,你可以打开你的项目代码,插件会自动分析你的代码,并生成可视化的架构图。你可以选择生成 C4 模型图来理解系统的整体架构,或者生成 UML 图来查看具体的类或组件关系。更重要的是,你可以与这些图进行交互:点击图中的节点可以跳转到源代码,还可以要求 AI 帮你可视化特定的功能实现流程,比如“展示用户登录的整个流程”。对于团队来说,可以将生成的图导出,用于团队会议、代码评审或新成员的入职培训。它就像一个拥有“读心术”的助手,帮助你和团队更容易地理解和讨论代码。

产品核心功能

· 代码到架构图自动生成:利用 AI 技术解析代码,生成 C4 模型和 UML 架构图,解决代码复杂度导致的可视化难题。

· 图与代码双向跳转:点击图中的任何节点(如服务、组件、类),都能直接定位到源代码,大大提高理解效率。

· AI 驱动的流程可视化:通过自然语言向 AI 提问,即可可视化特定的代码执行流程,例如“展示订单处理流程”,帮助快速理解复杂逻辑。

· 可编辑的图表编辑器:生成的图表可以直接在插件内进行编辑和调整,方便根据实际情况进行补充和修改。

· GitHub PR 集成:可以将 GitHub 的 Pull Request 直接导入,可视化 PR 的改动内容,方便代码评审。

· 团队协作支持:提供付费版本支持实时协作,让团队成员可以共同编辑和讨论架构图,提升团队沟通和决策效率。

· 多语言支持:支持大约 15 种主流编程语言的代码分析,覆盖范围广。

产品使用案例

· 新成员入职:团队新成员刚加入项目,可以通过 CodeViz 生成的项目架构图快速了解项目的整体结构和关键模块,大大缩短学习曲线。

· 代码评审(PR Review):在代码评审时,直接生成 PR 的改动对应的架构图,可以更直观地理解改动的影响范围和设计思路,提升评审效率。

· 系统设计和重构:在进行系统设计或代码重构时,利用 CodeViz 生成现有架构图,可以帮助团队成员统一对现有系统的认知,更容易发现设计缺陷和改进点。

· 技术分享和演示:在团队内部或对外进行技术分享时,使用 CodeViz 生成的清晰、可交互的架构图,比纯代码或静态图更能吸引听众,并帮助他们理解复杂的技术概念。

· 遗留代码理解:面对难以理解的遗留代码库,CodeViz 的 AI 分析能力可以帮助你快速梳理出代码的逻辑和结构,降低维护难度。

14

Claude-to-Prod 粘合层

作者

mrgoonie

描述

这是一个能够帮助开发者将Claude AI生成的代码,平滑过渡到可直接部署的生产级软件的中间层。它解决了AI生成代码在实际生产环境中可能遇到的部署、集成和生产就绪性问题,让AI的创造力真正落地。

人气

点赞 5

评论数 0

这个产品是什么?

这是一个神奇的“胶水”项目,它位于Claude AI的代码生成能力和你最终想要部署运行的真实软件之间。通常,AI生成的代码虽然有创意,但可能缺少一些在实际生产中必不可少的环节,比如配置、依赖管理、安全加固,或者跟现有系统的集成。这个项目就像一个智能化的助手,它能理解Claude生成的代码,并自动添加或调整这些关键部分,让代码可以直接放到服务器上运行,或者无缝集成到你的现有技术栈里。它的创新之处在于,它提供了一个标准化的、可配置的流程,来处理AI代码的“生产化”难题,而不仅仅是生成代码。

如何使用它?

开发者可以把Claude生成的代码提交给这个项目。它会根据你设定的环境和需求,自动进行一系列处理。例如,它可能帮你分析代码的依赖项,并自动生成`package.json`或`requirements.txt`文件;它可能会根据你的部署目标(比如Docker、Kubernetes或简单的服务器部署),生成相应的配置文件;它还可以集成一些常用的安全检查和性能优化工具。简单来说,你只需要告诉它你想要一个什么样的“生产就绪”的代码,然后把AI生成的代码给它,它就能帮你完成剩下的“精装修”工作,省去了大量手动配置和调试的时间。

产品核心功能

· AI代码生产就绪转换:自动分析Claude生成的代码,并添加必要的生产环境配置(如依赖管理、环境变量配置),让代码可以直接部署。

· 部署自动化支持:生成针对特定部署目标(如Docker镜像、CI/CD流程)的配置文件,大大简化部署流程。

· 代码集成辅助:提供API或SDK,帮助将AI生成的代码块与现有项目无缝集成,无需大量重构。

· 质量保障插件:集成基础的代码审查和安全扫描工具,提升AI生成代码的可靠性和安全性。

· 可配置的生产化规则:允许开发者定义一套规则,来指导AI代码如何进行生产化处理,满足个性化需求。

产品使用案例

· 假设你使用Claude AI生成了一个新的API服务,用于处理用户数据。这个项目可以帮你自动生成Dockerfile,让你可以轻松地将这个API容器化部署到云服务器上,快速启动你的新服务。

· 如果你正在开发一个复杂的Web应用,并让Claude帮你生成了几个前端组件。这个项目可以帮你自动生成组件所需的CSS样式和JavaScript集成代码,让你能更快地将这些新功能加入到你的项目中,而无需手动处理大量的样式和脚本冲突。

· 当你需要快速原型开发一个微服务时,Claude可能会生成核心逻辑。这个项目可以帮你生成服务启动脚本、基础的错误处理和日志记录,让你能快速地将这个原型部署到测试环境,并进行验证,而不用担心基础服务的搭建。

· 对于需要频繁迭代的AI模型服务,Claude可能会生成模型部署和推理的代码。这个项目可以帮你生成模型推理服务的API接口和配置,让你能够快速地为模型部署一套可调用的服务,方便后续的A/B测试和持续改进。

15

AI真假辨别挑战

作者

amiban

描述

一个基于React开发的趣味小游戏,旨在展示当前AI在模仿文学、演讲和图像生成方面的惊人能力。通过提供AI生成的莎士比亚风格诗歌、马丁·路德·金风格演讲、逼真图像以及电影对话,让用户挑战辨别真伪。这个项目突出了AI模仿的逼真程度,同时也揭示了AI目前在模仿过程中可能出现的细微破绽,如过度解释、隐喻模糊或过于完美的风格。

人气

点赞 5

评论数 0

这个产品是什么?

这是一个AI内容真伪辨别的互动游戏。它的技术原理是通过集成先进的AI模型(如语言模型和图像生成模型),生成模仿特定风格(如经典文学、名人演讲、写实照片、电影台词)的内容。例如,它会生成一段听起来像是莎士比亚写的十四行诗,或者一段听起来像是马丁·路德·金的演讲。游戏的核心创新在于,它不仅仅是展示AI的生成能力,更重要的是让用户通过观察AI生成内容的细微特征(尽管这些特征正在快速消失),来尝试辨别哪些是AI制造的,哪些是真实存在的。这就像是给AI生成的内容做了一场“听诊”或“透视”。

如何使用它?

开发者可以使用这个项目作为AI内容生成与辨别技术能力的参考。它可以被集成到教育平台,用于讲解AI的最新进展及其对内容创作的影响;也可以作为一种有趣的互动工具,在技术交流活动或产品发布会上吸引参与者,提高他们对AI技术的认知度。例如,一个AI内容审核工具的开发者,可以研究这个项目所揭示的AI模仿的“痕迹”,并思考如何构建更强大的AI内容检测算法。普通用户则可以直接访问并参与挑战,享受辨别真伪的乐趣,同时直观感受AI技术的进步。

产品核心功能

· AI文学模仿生成:通过AI生成具有特定文学风格(如莎士比亚风格)的内容,让用户感受AI在模仿文字艺术方面的能力,理解AI如何学习并重现历史文化元素。

· AI演讲模仿生成:利用AI生成模仿著名演讲者(如马丁·路德·金)风格的文本,展示AI在模仿口语表达和思想风格上的潜力,帮助开发者理解AI如何处理情感和语气的微妙之处。

· AI图像生成与挑战:生成高度逼真的AI图像,让用户挑战辨别真假,体现AI在视觉内容创作上的突破,为开发者提供AI图像识别与生成技术的实际应用范例。

· AI电影对话模拟:生成模仿电影风格的对话,展示AI在叙事和角色扮演方面的能力,为游戏开发者或虚拟现实内容创作者提供灵感。

· 辨别AI生成内容的提示:提供AI生成内容时可能暴露的微小破绽(如过度解释、比喻不够具体、风格过于完美),帮助用户在娱乐中学习如何审视AI生成的内容,提升信息辨别能力。

· 用户得分统计与反馈:记录用户的答题情况,并提供反馈,让用户了解自己的辨别能力,同时作者也可以收集数据,了解AI模仿的有效性,这对AI研究者非常有价值。

产品使用案例

· 在AI伦理和内容创作的课堂上,教师可以展示这个项目,让学生亲身体验AI的模仿能力,引发关于“真实性”与“模仿”的讨论,帮助学生理解AI在内容创作领域带来的挑战。

· 技术社区的会议中,可以将此作为互动环节,让参会者在茶歇时间进行挑战,活跃气氛,同时让开发者直观感受当前AI生成内容的水平,激发关于AI内容安全和检测技术的研究兴趣。

· 内容审核团队可以参考此项目,了解AI生成内容的逼真程度,思考如何构建更有效的AI内容检测工具,以应对日益增长的AI生成虚假信息。

· 游戏开发者可以研究AI生成的对话和图像,从中获取灵感,探索在游戏NPC对话、场景设计等方面应用AI的可能性,提升游戏内容的丰富度和真实感。

· 艺术家和设计师可以利用AI生成图像的功能,尝试新的创作风格和概念,同时也可以通过挑战辨别AI图像,反思和提升自己创作的独特性和艺术价值。

16

AI智能代理成本优化器

作者

weebhek

描述

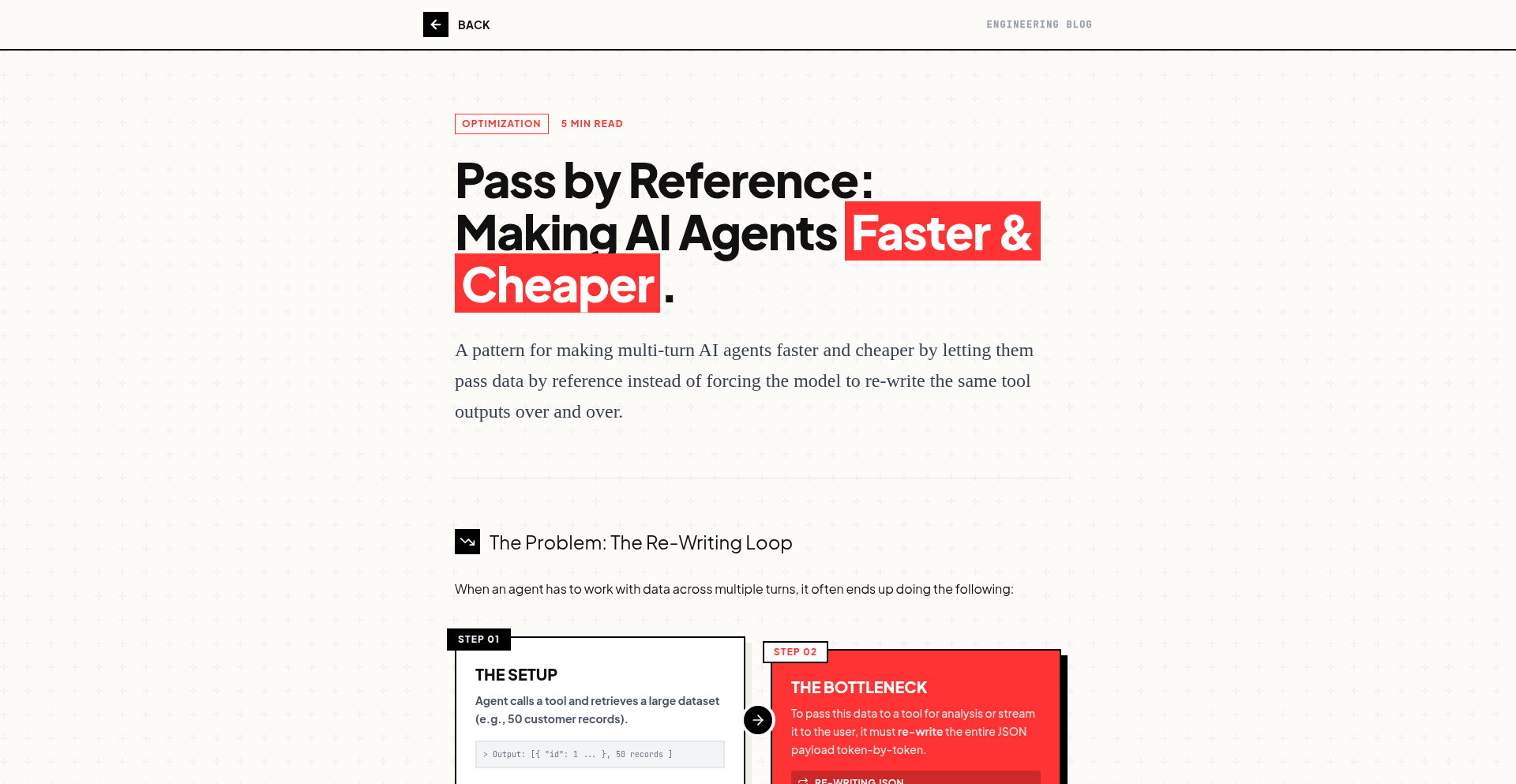

一个通过一项小小的改动,能让多轮AI代理的成本和延迟降低80%-90%的创新项目。它解决了目前AI代理应用中普遍存在的计算资源消耗过大和响应速度慢的问题。

人气

点赞 4

评论数 1

这个产品是什么?

这是一个针对多轮AI(也就是AI可以和你来回对话、思考多次)应用的小型技术优化工具。它的核心创新在于,通过一种巧妙的、可以算作是“旁门左道”但非常有效的方法,大幅减少了AI在每次对话轮次中需要进行的复杂计算。简单来说,就像是给AI找到了一条更省力、更快速的思考路径,让它不需要每次都从头开始计算,从而节省了大量的计算时间和能量,也大大降低了使用AI的费用和等待时间。对于开发者来说,这意味着他们可以用更低的成本、更快的速度,构建和部署需要复杂AI交互的应用,提升用户体验。

如何使用它?

开发者可以将这个优化器集成到他们现有的AI代理系统中。通常,多轮AI的流程是:用户输入 -> AI处理 -> AI输出 -> 用户输入... 这种循环。这个项目提供的“小改动”就是在这个循环的关键节点上进行干预。具体集成方式可能取决于开发者使用的AI框架(比如LangChain、LlamaIndex等),但基本思路是利用项目提供的函数或配置,在AI进行下一次推理(思考)之前,注入一些优化后的信息或改变其处理方式。这样做之后,AI在后续的对话中就能更快地给出响应,并且消耗的计算资源(也就是你支付给云服务商的钱)也会显著减少。它就像给你的AI系统打了个“节能包”,让AI跑得更经济、更迅速。

产品核心功能

· AI推理成本降低:通过优化AI在多轮对话中的计算路径,大幅减少每次AI思考所需的计算资源,直接降低AI服务的使用费用,解决了AI应用太烧钱的问题。

· AI响应延迟缩短:AI思考过程的简化意味着用户等待AI回复的时间也大大缩短,提升了用户在与AI交互时的流畅度和满意度,解决了AI回复太慢让人抓狂的问题。

· 易于集成性:该优化方案被设计成一个“小改动”,意味着开发者可以相对轻松地将其应用到现有的AI代理框架和流程中,无需进行大规模的系统重构,降低了技术采纳的门槛。

· 多轮对话效率提升:专为多轮AI对话场景设计,能在AI连续交互中持续发挥作用,确保即使在复杂的对话流程中,AI也能保持高效和经济的运行状态,解决了AI对话越长越慢、越贵的问题。

产品使用案例

· 构建智能客服聊天机器人:在用户与客服机器人进行多次询问和解答时,使用此优化器可以显著降低服务成本,同时让用户更快获得答案,提升客户满意度。以前用户问一句等半天,现在几乎能即时响应。

· 开发AI辅助写作工具:当用户需要AI帮助润色、续写、改写文章时,AI需要进行多次思考和调整。该优化器能让AI在这些复杂的写作辅助场景下,更快地生成高质量内容,并且降低使用成本,让AI写作更普及。

· 部署AI驱动的问答系统:在需要AI理解复杂问题并进行多步推理才能给出答案的场景(例如,需要AI分析大量文档并回答特定问题),此优化器能加速AI的分析过程,减少计算消耗,使得AI问答系统更具实用性。

· 创建AI游戏NPC对话:在游戏中,AI控制的NPC需要进行大量的、实时的对话互动。使用这个优化器能让NPC的对话更流畅、反应更快,同时不会因为频繁的AI计算而拖慢游戏性能或增加服务器负担,带来更沉浸的游戏体验。

17

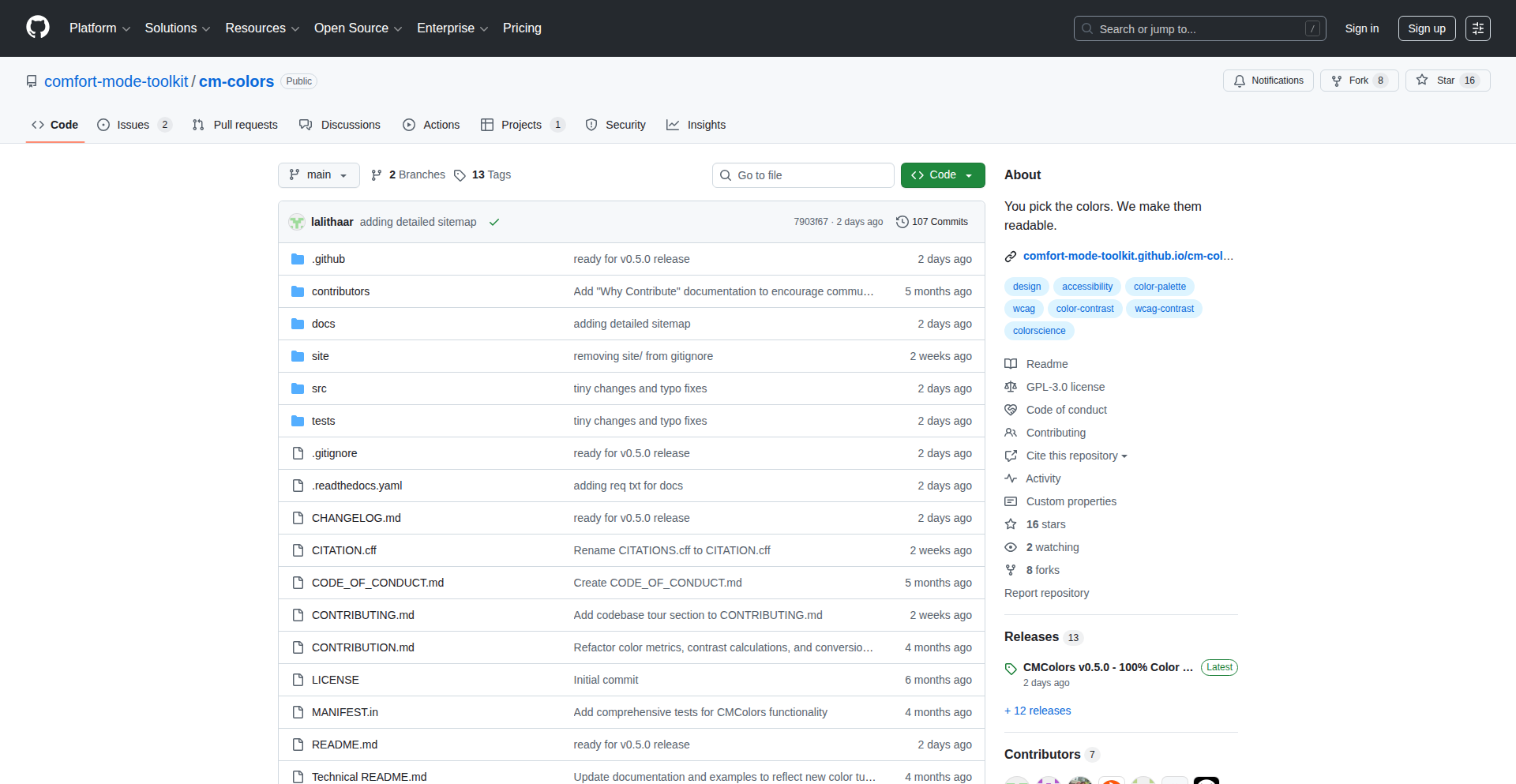

视觉友好色差自动微调库

作者

lalithaar

描述

一个能自动调整文字颜色,使其在网页上更容易阅读,同时保持视觉上与原色相似的开源小工具。它解决了颜色对比度不足导致的可读性差的问题,并提供了一个能在代码检查工具(CI)中使用的颜色对比度检测器。

人气

点赞 5

评论数 0

这个产品是什么?

这是一个名为Cm-colors的开源库,它的核心技术在于利用算法智能地微调文本颜色,以确保其满足WCAG(Web内容可访问性指南)关于颜色对比度的AA或AAA级别要求。简单来说,就是它能让你的文字在各种背景下都看得清楚,不容易出现眼睛累、看不清的情况,并且调整后的颜色看起来和原来的颜色几乎一样,不会破坏你精心设计的UI风格。这解决了开发者在设计UI时,即使选了好看的颜色,也常常因为颜色对比度不够而影响用户体验的痛点。所以这对我有什么用?它能让你在保证设计美观的同时,轻松实现网页的可访问性,让更多人(包括视力不佳的用户)都能顺畅地阅读你的内容,避免因为可读性差导致用户流失。

如何使用它?

开发者可以将这个库集成到他们的前端项目中。对于需要调整颜色的部分,可以通过调用库提供的函数来传入原始颜色和背景颜色,库会自动计算并返回一个经过微调、对比度达标的新颜色。此外,它还提供了一个可以集成到持续集成(CI)环境的Linter(代码检查工具),可以在代码提交前自动检查颜色对比度是否达标,及时发现并修正问题。所以这对我有什么用?你可以轻松地在你的网站或应用中实现高对比度,提高用户体验,并且通过CI自动化检查,确保每一个页面都符合可访问性标准,节省手动检查和修改的时间。

产品核心功能

· 自动微调文本颜色以满足WCAG AA/AAA对比度要求:通过智能算法,对原始颜色进行微小调整,使其达到可访问性标准,确保文字清晰可读,同时尽量保持原色调。这对我有什么用?让你的设计不再因为颜色对比度问题而受限,保证用户体验。

· 保留原设计风格的颜色调整:微调算法优先考虑视觉一致性,确保调整后的颜色在视觉上与原色相差无几,不破坏整体UI设计。这对我有什么用?你可以在提升可读性的同时,依然保持你独特的设计美感。

· 集成到CI环境的颜色对比度Linter:提供一个能在代码自动化检查流程中运行的工具,自动检测页面上的颜色对比度是否达标。这对我有什么用?让你能够在开发早期就发现并解决颜色可访问性问题,避免后期返工,提高开发效率。

· 开源免费使用:项目的许可协议是开源的(FOSS),开发者可以自由地在任何项目中使用,无需支付费用。这对我有什么用?零成本地提升你的产品质量和用户体验。

产品使用案例

· 一个电商网站前端开发,设计师提供了一套漂亮的配色方案,但在实际开发中发现部分按钮文字和背景的对比度不足,不易点击。使用Cm-colors后,文字颜色被自动调整到清晰可见,用户操作更流畅。这对我有什么用?解决了关键交互元素的可见性问题,提升用户转化率。

· 一个博客平台,需要保证所有文章内容的文本可读性。通过将Cm-colors集成到模板中,所有文章标题和正文颜色都能自动调整到满足WCAG标准,无论用户使用何种背景主题。这对我有什么用?确保了内容的普适性,让所有读者都能轻松阅读。

· 一个大型软件的UI开发团队,为了统一和保证产品的可访问性,将Cm-colors的Linter集成到代码提交流程中。每当有开发者提交修改颜色相关的代码,Linter都会自动运行,不符合要求的代码会被阻止合并。这对我有什么用?从源头把控代码质量,保证了整个产品线在可访问性方面的高度一致性,节省了大量的人工审核成本。

18

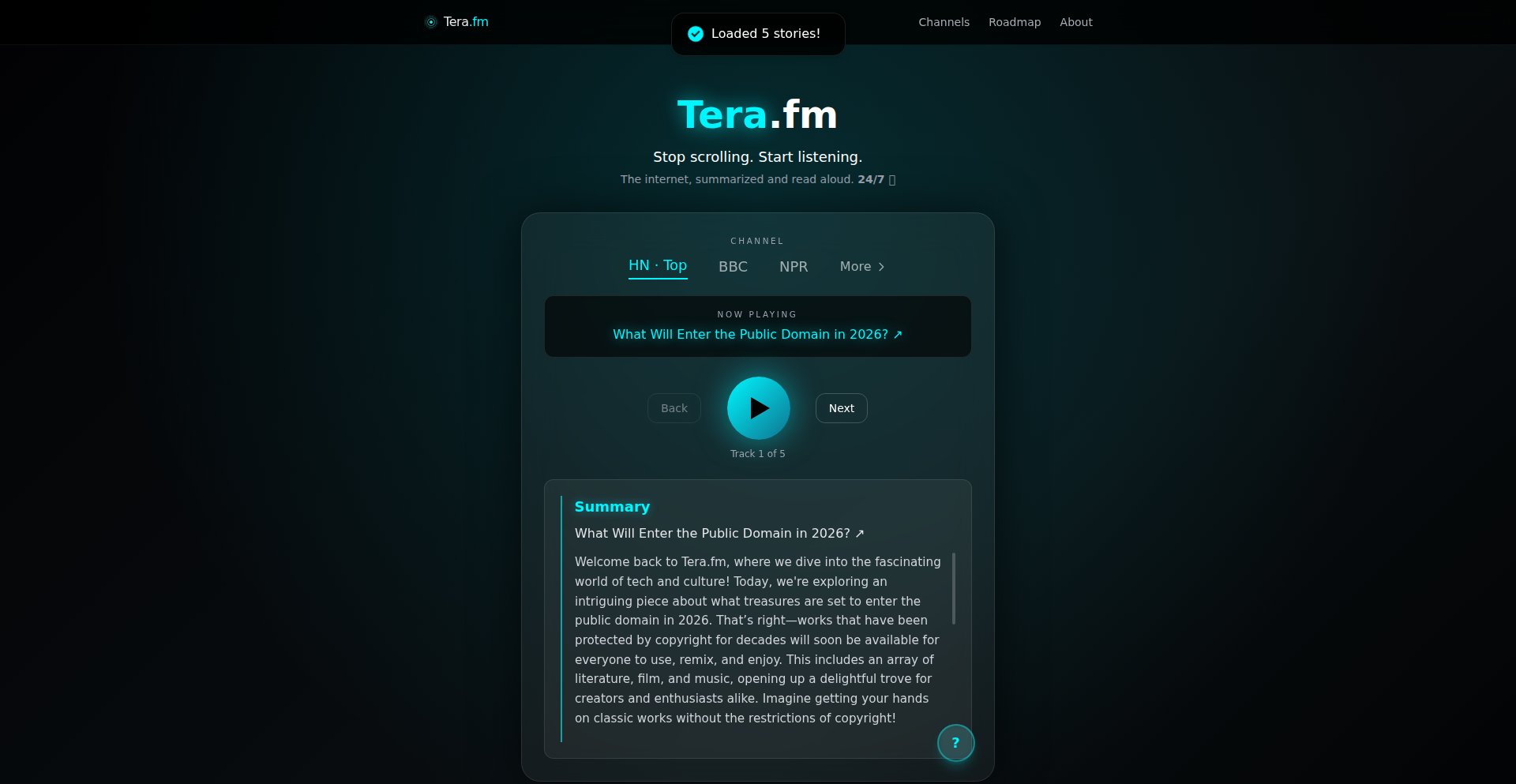

Tuner.fm: 倾听代码之外的声音

url

作者

digi_wares

描述

Tuner.fm 是一个将 Hacker News 文章转化为音频播客的创新项目。它解决了信息过载和阅读疲劳的问题,让开发者可以在通勤、运动或其他不方便阅读的场景下,依然能高效获取技术资讯。其核心技术在于利用自然语言处理(NLP)和文本转语音(TTS)技术,将枯燥的技术文章变成悦耳的音频内容。

人气

点赞 3

评论数 1

这个产品是什么?

Tuner.fm 是一个利用先进的自然语言处理(NLP)技术,将 Hacker News 上的技术文章转化为音频的服务。简单来说,它就像一个智能的播报员,能把你喜欢的技术文章‘读’出来。它的创新之处在于,它不仅仅是简单的文本朗读,而是通过算法理解文章结构和重点,让你听得更轻松、更高效,甚至能根据内容调整语速和音调。所以,它对你来说,意味着不再错过任何重要的技术动态,即使你没空盯着屏幕。

如何使用它?

开发者可以通过访问 Tuner.fm 网站,输入 Hacker News 文章的链接,或者直接浏览平台上精选的 HN 文章列表,然后点击‘播放’按钮即可收听。该项目也提供了 API 接口,这意味着你可以将 Tuner.fm 的音频转化能力集成到你自己的应用程序中,比如开发一个自定义的新闻聚合器,或者一个智能助手中,让它在特定时间为你播报 HN 最新文章。所以,这对你来说,意味着你可以将 HN 的信息流无缝融入你的工作流程或生活方式,甚至可以定制化你的听觉体验。

产品核心功能

· 文章转音频:将 Hacker News 文章的文本内容通过文本转语音技术转化为高质量的音频,让用户可以‘听’Hacker News。技术实现上,会用到先进的TTS引擎,保证发音自然,语速可调,让你听得更舒服。应用场景是任何不便阅读的场景,比如通勤途中、运动时,或者眼睛疲劳时。所以这对我有什么用?让我在忙碌之余,也能轻松跟上技术前沿。

· 智能摘要与重点突出:项目可能通过NLP技术识别文章的关键信息和技术要点,并在播报时进行适当的强调,比如调整语速或语调,让用户能更快抓住文章核心。技术实现上,这涉及到文本情感分析和实体识别等技术。应用场景是帮助用户在短时间内理解技术文章的精髓。所以这对我有什么用?节省宝贵的时间,快速掌握最新技术动态。

· 文章链接解析与整合:能够智能解析 Hacker News 的文章链接,并自动抓取文章内容,提供便捷的收听入口。这避免了用户需要手动复制粘贴的麻烦。技术实现上,涉及到网页抓取和内容解析技术。应用场景是提供流畅无缝的用户体验,让收听 HN 文章变得轻而易举。所以这对我有什么用?让我更专注于内容本身,而不是操作的繁琐。

· API接口服务:提供API接口,允许其他开发者将文章转音频的功能集成到自己的应用中。这体现了开源和社区共享的精神。技术实现上,是构建RESTful API服务。应用场景是为其他工具和平台提供核心功能,扩展其应用范围。所以这对我有什么用?让我可以构建更个性化的技术信息获取工具,或者利用HN音频功能丰富我的项目。

产品使用案例

· 开发者在通勤地铁上,不想刷手机,打开 Tuner.fm,就可以听到今天 Hacker News 上最热门的几篇技术文章,比如关于最新的AI模型进展或是某个开源项目的更新,轻松获取信息。这样在通勤的20分钟里,就完成了信息获取,避免了错过重要技术动态。

· 一位全栈工程师,在健身房锻炼时,不想被打断,但又想了解某个新兴编程语言的最新社区讨论。他可以通过 Tuner.fm 的移动端应用,戴上耳机,一边跑步一边‘听’完 Hacker News 上关于这个语言的讨论,保持技术敏感度,同时不影响锻炼。

· 一位项目经理,需要快速了解行业动态,但白天会议繁多。晚上他可以在睡前,让 Tuner.fm 播放几篇关于他关注领域(如DevOps或云原生)的 HN 文章。即使眼皮沉重,也能通过听觉接收信息,确保他不会落伍于技术趋势。

· 一个初创团队,正在开发一个新的开发者工具,他们希望集成一个‘朗读文章’的功能,以便用户在浏览技术文档时,可以切换到语音模式。他们可以通过 Tuner.fm 提供的API,快速为他们的工具添加这项功能,而无需自己从头开发TTS集成,极大地加快了产品开发速度。

19

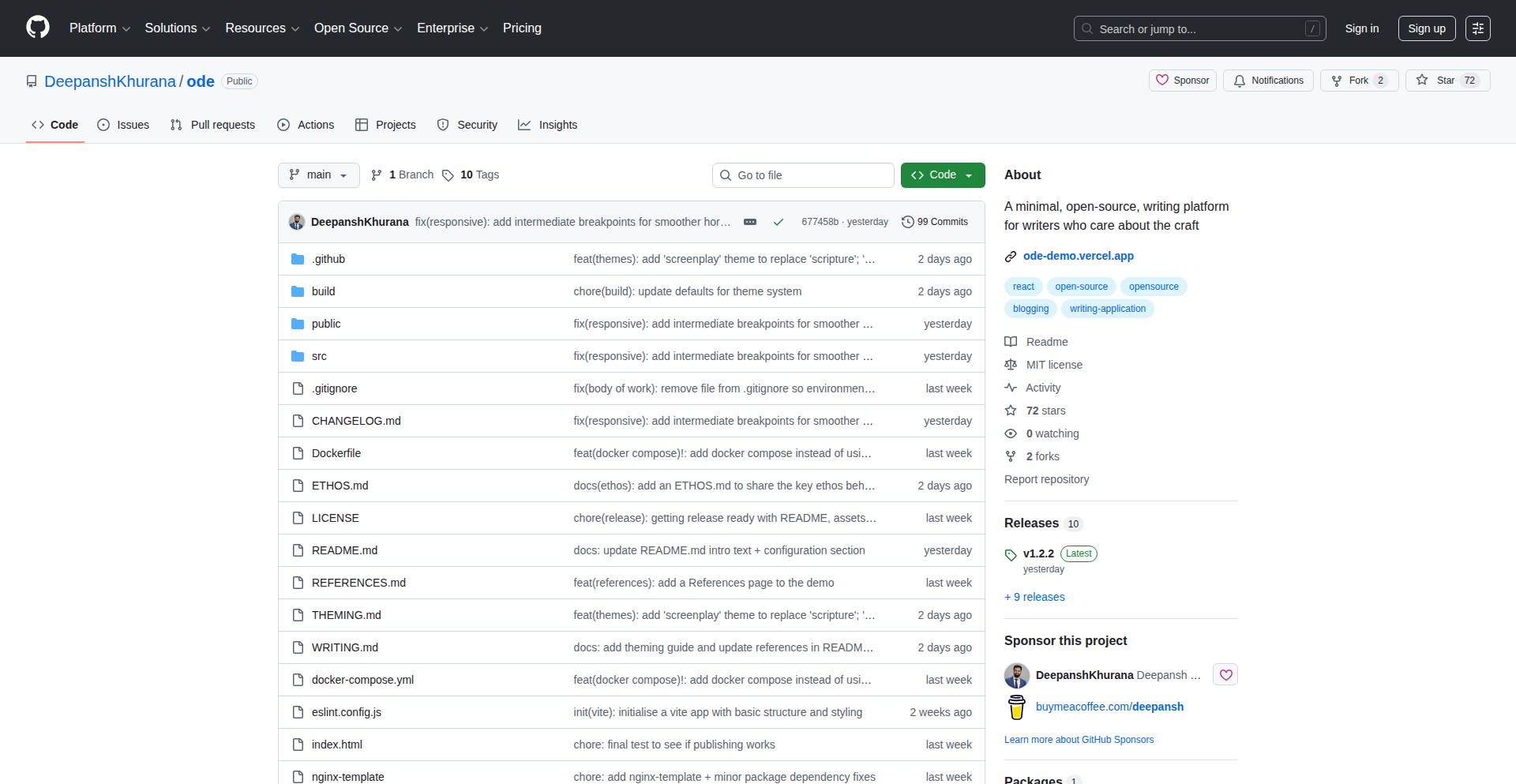

Ode: 极简写作与阅读的静态站点生成器

作者

deepanshkhurana

描述

Ode 是一款专为注重写作本身而非工具繁琐流程的创作者设计的,自托管的静态网站生成器。它能将简单的 Markdown 文件转化为美观、高性能的个人博客或写作作品集。通过极简的设计理念和强大的定制化能力,Ode 让你能专注于内容创作,而无需担心复杂的配置和运营。

人气

点赞 3

评论数 1

这个产品是什么?

Ode 是一个使用 Markdown 文件作为内容来源,通过预设模板和主题生成静态网站的工具。它的核心创新在于“静默式”工作流,即尽量减少对用户写作过程的干扰,提供纯粹的写作和阅读体验。它解决了现代写作平台过于臃肿、功能冗余的问题,让你能回归写作的本质。通过预设和主题,你可以轻松调整网站的外观,并且 RSS 和 sitemap 的自动生成,也能帮助你的内容更好地被发现。它的“build-time generation”(构建时生成)技术,意味着网站在生成后运行速度极快,用户访问体验流畅。

如何使用它?

开发者可以通过 `docker-compose` 快速搭建 Ode 的运行环境。将你的写作内容保存在指定的 Markdown 文件仓库中,然后通过配置文件 (`config.yaml`) 进行个性化设置,例如选择不同的主题、预设方案等。Ode 会在构建时自动将这些 Markdown 文件转化为静态 HTML、CSS 和 JavaScript 文件,可以直接部署到任何静态文件服务器上。这对于想要拥有自己独立博客,又不想处理复杂后端维护的个人开发者或内容创作者来说,是一个非常便捷的选择。

产品核心功能

· Markdown 内容写作与管理:通过简单的 Markdown 文件组织你的文章和作品,无需学习复杂的排版语言,让写作回归纯粹。

· 美观的阅读模式与导航:提供舒适的阅读界面,支持手势操作和键盘导航,并且拥有独特的“checkpointing”功能,方便你随时回到上次阅读的位置,找回阅读的连贯性。

· 多样化的预设与主题:内置10种预设风格,并允许用户进行深度定制,轻松切换网站的外观,打造独一无二的个人品牌。

· 即时可见的 RSS 和 Sitemap:网站构建时自动生成 RSS Feed 和 Sitemap,帮助你的内容更容易被搜索引擎收录和被其他平台聚合,增加内容的曝光机会。

· 极速的构建时生成:通过预先生成所有页面,确保网站加载速度飞快,为用户提供流畅的浏览体验。

· 高度可定制的配置:通过 `config.yaml` 文件,可以灵活调整网站的方方面面,满足个性化需求,体现了黑客文化中对工具的深度掌控。

产品使用案例

· 个人技术博客:开发者可以将自己的技术文章、学习笔记等内容,用 Markdown 撰写,并通过 Ode 生成一个简洁、快速且易于维护的个人技术博客,专注于分享技术心得。

· 写作作品集展示:作家、诗人或内容创作者可以利用 Ode 来展示自己的文学作品、短篇故事等,创建一个优雅的个人作品集网站,突出作品本身的魅力。

· 项目文档站:对于开源项目,开发者可以用 Ode 生成项目的官方文档站,使用 Markdown 编写,保证文档更新的便捷性和阅读的流畅性,方便社区贡献。

· 个人生活分享:任何希望分享生活感悟、旅行日记等内容的用户,都可以通过 Ode 快速搭建一个属于自己的“数字日记本”,记录生活,分享美好。

20

ChronoScribe: 时间轴写真日志

作者

amiban

描述

ChronoScribe 是一款极简的社交照片记录应用,它回归了社交媒体的本源:只允许用户发布照片,并以严格的时间顺序呈现。它摒弃了当前社交应用流行的AI内容生成、视频 Reels 和复杂的算法推荐,旨在让用户轻松了解朋友的真实生活动态,避免信息过载。其核心技术创新在于对『反算法』和『纯粹时间顺序』的坚持。

人气

点赞 4

评论数 0

这个产品是什么?

ChronoScribe 是一个专注于用户发布的原始照片、并以纯粹时间顺序展示的社交应用。它没有复杂的算法来决定你看到什么,也没有AI生成内容或视频短片。技术原理在于,它后端存储和检索数据时,仅依赖于内容的发布时间戳,不做任何排序或过滤。创新之处在于,它大胆地选择『不做』,对抗了当前主流社交平台『越多越好、越智能越好』的模式,提供了一种『少即是多』的体验。所以这对我有什么用?这意味着你不会错过朋友发布的任何一张照片,而且能以最真实、最直接的方式了解他们最近的生活。

如何使用它?

开发者可以将 ChronoScribe 的核心理念集成到现有的社交平台或作为独立应用。对于开发者而言,可以利用其『时间戳优先』的数据处理逻辑,构建一个无需复杂推荐引擎就能保证内容实时性的后台。使用场景可以包括:为特定小圈子(如家人、密友)构建一个私密的、无干扰的照片分享空间;或者作为一种『数字日记』工具,记录个人生活点滴,并确保所有记录都按时间顺序排列,便于回顾。集成方式主要是通过其提供的API接口,将照片上传至后端,并从后端按照时间顺序拉取展示。所以这对我有什么用?你可以轻松创建一个只属于你和亲密伙伴的、没有噪音的照片分享平台,或者一个能让你清晰回顾人生轨迹的数字日志。

产品核心功能

· 纯粹照片发布:用户只能上传照片,杜绝了视频、AI生成内容等,确保内容形式的统一和原始。这保证了信息的纯粹性,让社交回归分享生活瞬间本身。

· 严格时间顺序展示:所有内容按照发布时间先后顺序呈现,没有任何算法干预,保证了用户看到的是最真实、最及时的信息流。这解决了信息过载和算法操纵的问题,让用户掌握信息的控制权。

· 无算法推荐:不依赖算法为用户推荐内容,用户看到的是100%朋友发布的全部内容。这回归了社交的本质——连接和分享,让用户体验更公平、更直接。

· 极简交互设计:专注于照片和时间轴,减少不必要的功能和干扰,让用户更专注于核心体验。这降低了用户的认知负担,提升了用户的使用效率和愉悦感。

产品使用案例

· 创建一个家庭相册应用,父母和孩子可以随时分享照片,而无需担心照片被算法淹没或错过,所有照片都按时间顺序,方便回顾家庭成员的成长历程。

· 为一个小型的摄影俱乐部开发一个作品展示平台,会员上传作品后,所有作品都能按照发布时间清晰展示,方便大家同步欣赏最新作品,形成一个纯粹的作品时间轴。

· 作为一个个人旅行日记的工具,用户每到一个新地点就随手拍张照片并发布,应用自动按时间排序,形成一本真实的、图文并茂的旅行日志,方便日后回顾整个旅程。

· 为大学社团或学生组织开发一个活动记录工具,成员上传活动照片,所有人都能按时间看到活动的全貌,便于追溯和分享活动的精彩瞬间,不被复杂功能分散注意力。

21

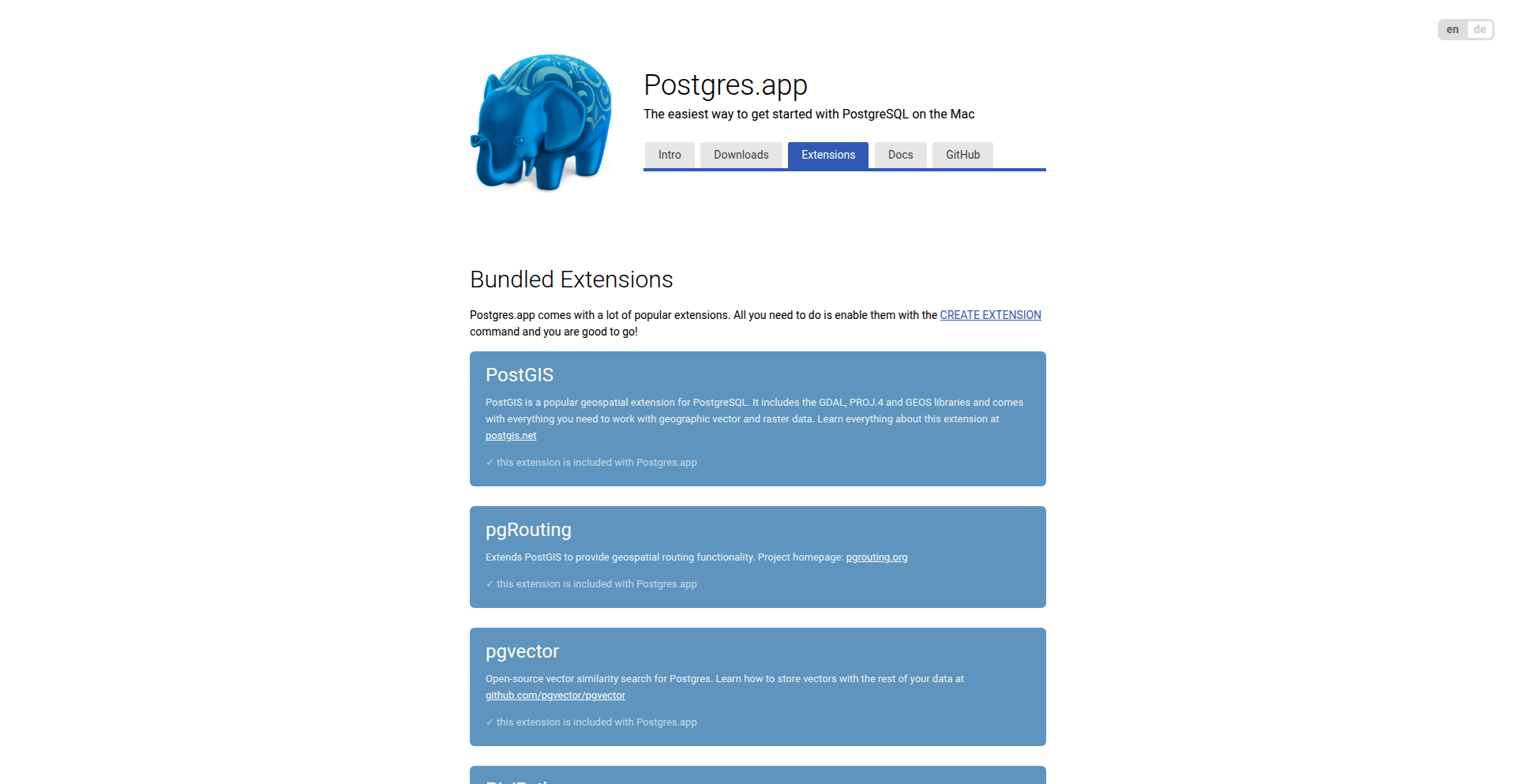

Postgres.app 扩展商店

作者

postgresapp

描述

Postgres.app 扩展商店是一个为 macOS 用户设计的创新项目,它极大地简化了 PostgreSQL 数据库在 Mac 上的安装和使用。本次更新的核心创新在于引入了可下载的扩展功能,这意味着用户不再局限于 Postgres.app 自带的功能,而是可以根据自己的需求,方便地添加各种 PostgreSQL 扩展,从而让 Postgres.app 成为一个更强大、更灵活的本地开发数据库解决方案。

人气

点赞 4

评论数 0

这个产品是什么?

Postgres.app 扩展商店是一个允许用户在 Mac 上轻松安装和管理 PostgreSQL 数据库的工具,并且现在它提供了一个便捷的方式来下载和添加额外的 PostgreSQL 扩展。这解决了用户希望使用 Postgres.app,但又需要其官方未包含的特定功能(比如一些高级的数据分析、地理信息处理或全文搜索的扩展)的痛点。它通过一种简单易用的机制,让你能像安装应用一样,轻松地为你的 PostgreSQL 添加新能力,而无需进行复杂的编译和配置。

如何使用它?

开发者可以在 Postgres.app 中找到“扩展商店”的入口,浏览可用的扩展列表。选择你需要的扩展后,只需点击下载并按照提示操作,即可将其安装到你的 PostgreSQL 实例中。这使得你可以在本地 Mac 环境中,快速地试验和集成新的数据库功能,例如为 Web 应用开发添加全文搜索能力,或者为数据科学项目集成地理空间分析工具,而无需担忧环境配置的复杂性。

产品核心功能

· 可下载的 PostgreSQL 扩展: 允许用户按需添加 PostgreSQL 官方未内置的额外功能,技术上通过预编译好的扩展包和简单的安装脚本实现,这解决了开发者在本地环境中缺乏特定数据库扩展的限制,极大地提高了开发效率和灵活性。

· 简化的安装流程: 提供一键式安装体验,无需手动编译和配置,技术上通过自动化脚本和预打包的二进制文件实现,这使得非专业数据库管理员也能轻松上手,极大地降低了使用门槛。

· 本地开发环境友好: 专门为 Mac 用户设计,提供开箱即用的 PostgreSQL 服务器,技术上通过打包整个 PostgreSQL 和必要的依赖项实现,为前端、后端或全栈开发者提供了一个稳定、便捷的本地数据库测试和开发环境。

· 持续的功能扩展: 鼓励社区贡献和添加更多扩展,技术上通过开放的扩展机制和社区反馈循环实现,这保证了 Postgres.app 能够不断满足开发者日益增长的需求,保持技术的前沿性。

产品使用案例

· 作为一名 Web 开发者,我需要在本地环境中测试我的应用程序,该程序需要使用 PostgreSQL 的全文搜索功能来提高搜索效率。使用 Postgres.app 扩展商店,我只需几分钟就能安装好 PostgreSQL,然后在扩展商店中找到并安装 `pg_trgm` 扩展,就能立即在我的本地数据库上进行开发和测试,而无需花费数小时配置一个复杂的开发环境。

· 一名数据分析师希望在 Mac 上处理一些地理空间数据,这需要 PostgreSQL 的 PostGIS 扩展。通过 Postgres.app 的扩展商店,我可以直接下载并安装 PostGIS,然后就能在本地使用 SQL 查询来分析地图数据,而无需担心在 Mac 上安装和编译 PostGIS 的繁琐过程,这极大地节省了我的研究时间。

· 一个团队正在开发一个需要 PostgreSQL 数据库的项目,但团队成员的 Mac 配置不尽相同,担心本地环境不一致导致开发问题。使用 Postgres.app 及其扩展商店,团队可以快速搭建统一的本地数据库环境,并安装相同的扩展,确保开发过程中的一致性,有效避免了“在我这里可以运行”的常见开发难题。

22

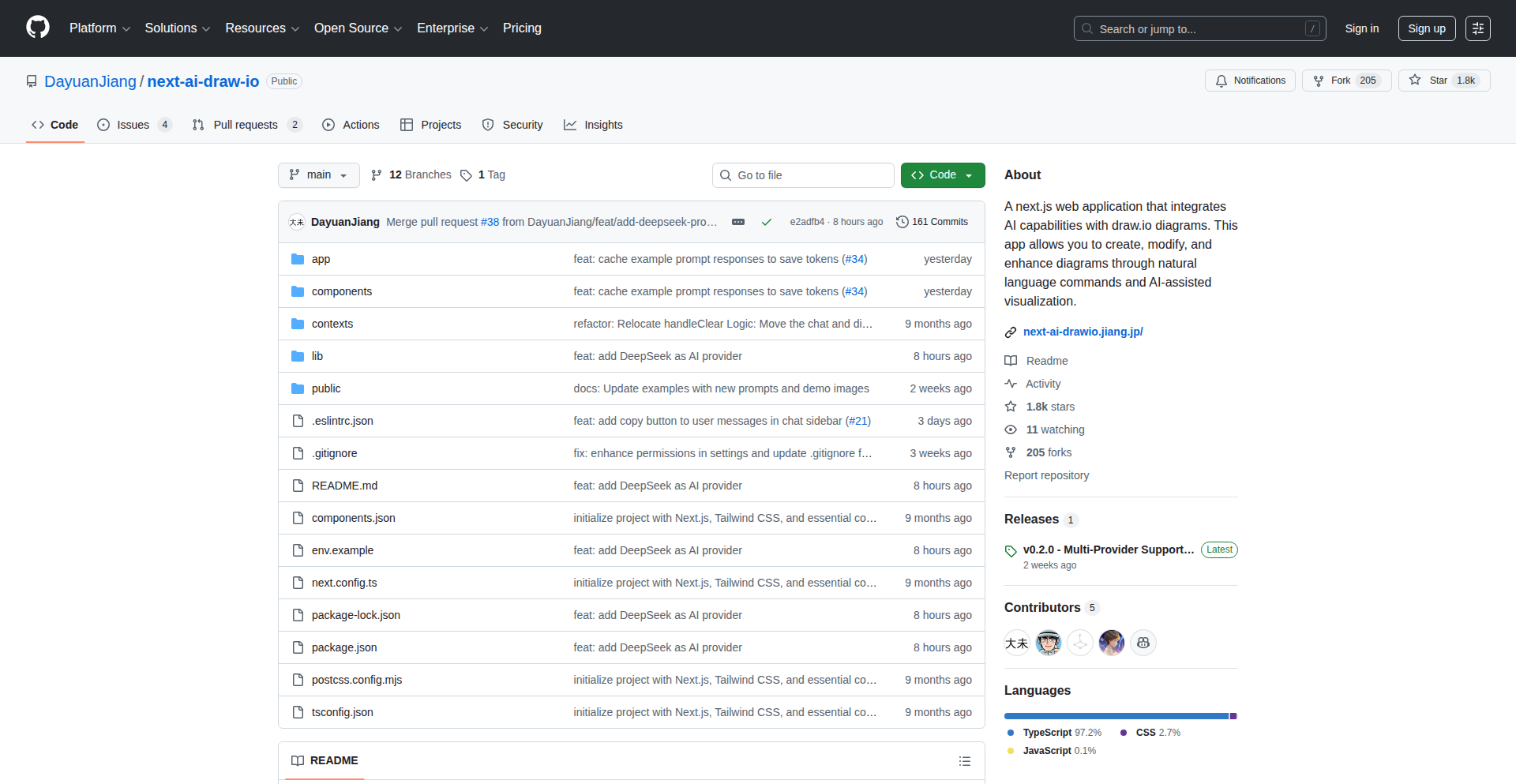

AI绘图助手 (LLM-Powered Diagram Builder)

作者

jiangdayuan

描述

这是一个能让你用大语言模型(LLM)来创建draw.io图表的开源工具。它不是生成一张静态图片,而是直接操作draw.io的内部数据格式(XML)。这意味着你可以先用AI帮你搭建一个基础架构图,然后在图上进行手动修改,接着再让AI帮你进一步完善。它支持云服务(AWS, GCP, Azure)的图标,还能绘制动态连接线和矢量图形,并且兼容多种AI模型。

人气

点赞 2

评论数 2

这个产品是什么?

这个项目是一个创新的工具,它巧妙地结合了大语言模型(LLM)的智能生成能力和draw.io的可视化绘图功能。不同于一般的AI图片生成器,它不是生成一张无法编辑的图片,而是直接生成draw.io可以识别和编辑的XML代码。这意味着AI可以根据你的文字描述,生成一张可交互、可修改的流程图、架构图或概念图。它还内置了对AWS、GCP、Azure等主流云平台的特定图标支持,以及对动画连接线和简单矢量图形(比如画一只猫)的支持,让你和AI协同工作,非常灵活。

如何使用它?

开发者可以通过两种主要方式使用这个工具:1. 作为在线工具:访问演示网站,输入你想要的图表描述(例如:“画一个包含用户、API网关、微服务和数据库的AWS架构图”),AI就会生成draw.io文件。2. 集成到自己的开发流程中:可以将这个工具的代码集成到你的项目里,通过API调用AI来生成图表,或者在CI/CD流程中自动生成架构文档。开发者可以先用AI生成一个粗略的草图,然后下载下来在draw.io里进行精细调整,再上传回去让AI根据修改内容进一步优化,实现人机协同的效率提升。

产品核心功能

· AI驱动的图表生成:用户只需用自然语言描述想要的图表内容,AI即可生成可编辑的draw.io XML文件,极大提升了图表绘制的效率和便捷性。

· 云服务原生图标支持:内置AWS、GCP、Azure等主流云平台的图标库,让创建云架构图时更加准确和直观,无需手动导入或寻找图标,直接解决云基础设施可视化难题。

· 动态连接与矢量图形:支持创建动态的连接线,以及用AI绘制简单的矢量图形,为图表增加了更多的表现力和趣味性,让概念传达更生动。

· 模型无关性:能够兼容多种主流的AI模型,包括OpenAI、Anthropic、Bedrock和Ollama等,这意味着开发者可以根据自己的需求和偏好选择最适合的AI模型,保证了工具的通用性和可扩展性。

产品使用案例

· 在软件架构设计中:当需要快速绘制一个复杂的微服务架构图时,开发者可以输入描述,AI瞬间生成基础架构,然后开发者再手动调整,AI还可以根据调整后的描述进行细化,大大缩短了设计周期。

· 在系统部署规划时:需要规划一个多云混合部署方案?用自然语言描述你的部署需求,AI能快速生成包含AWS、GCP、Azure资源的架构图,并自动匹配相应图标,方便后续的沟通和评审。

· 在技术文档撰写时:撰写技术文档需要大量图表?这个工具能让你快速生成流程图、状态图等,然后可以轻松地将生成的图表集成到文档中,让文档更具专业性和可读性。

· 作为教育工具:用于教授AI概念或学习新的技术栈时,可以通过简单的文本描述,让AI生成可视化的图表,帮助学习者更快地理解抽象概念。

23

Hyvor Post & Relay: 隐私优先的邮件通讯与自托管发送服务

作者

supz_k

描述

Hyvor Post 是一个注重隐私的电子报平台,不进行任何跟踪,让你能以最纯粹的方式与订阅者沟通。Hyvor Relay 是一个可以自己部署的邮件发送服务,为开发者提供了比 AWS SES 或 Mailgun 等传统服务更具成本效益和控制力的替代方案。其创新之处在于 Hyvor Post 专注于内容而无干扰,Hyvor Relay 则通过内置的健康检查和自动化 DNS 设置,极大地简化了复杂的邮件发送配置,降低了出错的可能性。

人气

点赞 4

评论数 0

这个产品是什么?

这是一个由 HYVOR 公司推出的开源项目,分为两个部分。Hyvor Post 是一个电子报平台,它的核心是‘隐私第一’,这意味着它不会追踪你的订阅者,让他们收到的信息是最纯粹的。想象一下,就像你直接给朋友写信,没有中间商在看。Hyvor Relay 则是可以部署在你自己的服务器上的邮件发送服务,就像自己搭建一个信使,负责把邮件送出去。它比市面上现有的很多服务(比如 AWS SES)更便宜,而且完全由你掌控。它的技术亮点在于,它内置了很多‘健康检查’功能,比如帮你检查收件人地址是不是真的存在,邮件头信息是不是合规,这些在发送邮件时非常重要,就像信使在出发前检查邮票和信封一样,能大大减少邮件发送失败的几率。它还能帮你自动设置一些技术上必需的记录(DNS records),避免因为设置错误导致邮件发不出去。

如何使用它?

对于想要独立运营电子报的博主、创作者或小型企业来说,可以使用 Hyvor Post 来创建和管理他们的邮件列表,并发送内容给订阅者。它就像一个简洁的博客平台,但专注于邮件通讯。对于需要大量发送邮件的开发者,例如发送注册确认邮件、通知邮件或者营销邮件,可以将 Hyvor Relay 集成到他们的应用中。通过简单的 API 调用,就可以将邮件发送出去。Hyvor Relay 的自托管特性意味着你可以完全控制邮件发送过程,并且可以选择更具成本效益的硬件和网络资源。举个例子,如果你正在开发一个SaaS产品,需要发送用户注册验证邮件,你可以将 Hyvor Relay 部署在自己的服务器上,通过简单的HTTP请求就可以触发邮件发送,而无需依赖第三方服务,降低了成本并提高了数据隐私性。

产品核心功能

· 隐私至上的电子报管理:Hyvor Post 允许你建立和管理订阅者列表,发送新闻通讯,并且完全不进行用户跟踪,这意味着你可以专注于内容创作,而不用担心数据隐私问题,让你与订阅者建立更信任的关系。

· 自托管邮件发送服务:Hyvor Relay 提供了一个可以部署在自己服务器上的邮件发送基础设施,你可以通过 API 发送邮件,相比传统服务,这能显著降低你的邮件发送成本,并赋予你对发送过程的完全控制权。

· 自动化邮件发送配置检查:Hyvor Relay 内置了对 DKIM、SPF、PTR 等邮件发送关键配置的健康检查,能够在你发送邮件前就发现潜在的问题,极大地降低了邮件被标记为垃圾邮件的风险,确保你的邮件能准确送达。

· 自动 DNS 记录管理:为了简化邮件发送的复杂性,Hyvor Relay 包含了一个 DNS 服务器,可以帮助开发者自动化配置必要的 DNS 记录,这使得即使不熟悉 DNS 配置的开发者也能轻松搭建邮件发送系统,减少了技术门槛。

· 开源与开放性:两个项目都采用 AGPLv3 开源许可,这意味着开发者可以自由地使用、修改和分发代码,并能看到其完整的技术实现,促进了社区的协作和创新。

产品使用案例

· 个人博客作者希望建立一个忠实的读者群体,通过 Hyvor Post,他可以轻松地收集订阅者邮箱,并定期发送最新文章的摘要,同时保证订阅者的隐私不受侵犯,建立更紧密的社区联系。

· 一个小型电商网站需要发送订单确认邮件和发货通知,使用 Hyvor Relay 自托管邮件服务,可以显著降低每月大量的邮件发送费用,并且能够完全控制邮件发送的响应时间和数据,提升用户体验。

· 一个SaaS开发者需要为新用户发送注册验证邮件,并定期发送产品更新通知。集成 Hyvor Relay 意味着他们不再需要依赖昂贵的第三方邮件服务,可以通过自己的服务器快速、稳定地发送邮件,同时数据也留存在自己的掌控之下。

· 一个技术社区希望创建一个分享技术文章和活动信息的电子报。Hyvor Post 提供了一个干净、无广告的平台,让社区成员可以专注于接收有价值的信息,而不会被无关的跟踪器打扰,提升了信息的传递效率和用户体验。

· 对于那些对数据隐私高度敏感的应用(例如健康、金融领域),Hyvor Relay 提供了一个解决方案,确保敏感的邮件数据不会被第三方服务商访问或存储,完全符合严格的数据安全和隐私法规要求。

24

LogiCart - 意图驱动的智能购物代理

作者

ahmedm24

描述

LogiCart 是一个基于pgvector构建的智能购物代理,它能理解用户的购物意图,并主动推荐商品。不同于传统的搜索和过滤,LogiCart的核心创新在于利用向量数据库(pgvector)来捕捉用户需求的深层含义,从而实现更精准、更符合用户心意的商品推荐。这就像一个懂你的导购,而不是一个只提供列表的搜索引擎。

人气

点赞 3

评论数 1

这个产品是什么?

LogiCart 是一个利用AI和向量数据库(pgvector)来理解用户购物意图的智能代理。传统的购物平台往往需要用户明确输入关键词、选择分类、设置价格范围等,而LogiCart则通过分析用户输入的自然语言描述,将其转化为高维度的向量表示。pgvector作为PostgreSQL的一个扩展,能够高效地存储和查询这些向量,从而找到与用户意图最相似的商品。这意味着,即使你表达得不那么精确,LogiCart也能“读懂”你的需求,并为你找到最合适的商品。其创新之处在于,它将“意图识别”与“向量相似性搜索”结合,实现了比关键词匹配更智能、更个性化的购物体验。

如何使用它?

开发者可以将LogiCart作为一个服务集成到自己的电商平台、APP或者任何需要商品推荐的场景中。通过API接口,你可以将用户的查询(例如“我想要一件适合春秋穿的、有点休闲风格的蓝色外套”)发送给LogiCart。LogiCart会将其转化为向量,并在你提供的商品数据库(同样需要将商品信息转化为向量存储在pgvector中)中进行相似性搜索,返回最匹配的商品列表。你可以根据返回的商品ID、名称、图片等信息,在你的应用中展示给用户。这种集成方式非常灵活,可以用于优化现有的搜索功能、构建个性化推荐系统,甚至开发全新的交互式购物体验。

产品核心功能

· 意图向量化:将用户输入的自然语言描述转化为计算机能理解的向量,这使得AI能够捕捉到语言背后隐藏的含义和偏好,价值在于让系统能理解更复杂的、非线性的用户需求。

· 向量相似性搜索:利用pgvector在海量商品向量中快速找出与用户意图向量最相似的商品,价值在于提供远超传统关键词匹配的精准度,大大减少用户筛选时间。

· 意图驱动的商品推荐:基于向量相似性结果,主动向用户推荐最可能感兴趣的商品,价值在于将被动搜索转变为主动推荐,提升用户发现新商品的机会和满意度。

· 可扩展的商品数据库集成:支持将大量商品信息转化为向量并存储在pgvector中,方便与现有的商品管理系统对接,价值在于可以快速部署和扩展到不同规模的电商场景。

产品使用案例

· 电商网站:当用户输入“有没有适合送给喜欢摄影的朋友的生日礼物”,LogiCart可以理解“摄影”、“生日礼物”以及隐含的“送礼”的场景,推荐相机配件、摄影书籍、创意礼品等,而不仅仅是包含“礼物”关键词的商品。

· 时尚APP:用户可以说“我最近想买一条显瘦的黑色长裤,面料要舒服的”,LogiCart可以根据对“显瘦”、“舒适面料”等属性的向量理解,优先推荐经过训练模型认为符合这些描述的裤子,而不需要用户输入繁琐的筛选条件。

· 内容平台:在订阅服务中,用户可以表达“我最近对硬科幻小说特别感兴趣,特别是关于太空探索的”,LogiCart能够通过分析用户输入的意图,推荐相关的电子书、有声读物或者作家访谈,提供更符合用户口味的内容。

· 线下零售辅助:结合智能屏幕,顾客可以描述“我需要一件适合参加户外婚礼的正装,但又不希望太正式”,LogiCart可以识别出“户外婚礼”、“正装”与“不希望太正式”的矛盾意图,推荐适合的轻礼服或时尚的套装。

25

xv6-Rust 模块实验

作者

ferryistaken

描述

这是一个在 xv6 操作系统内核中实验性地使用 Rust 语言编写模块的项目。其技术创新在于将一种现代、内存安全的编程语言(Rust)引入到经典的、主要用 C 语言编写的微内核(xv6)中。这为操作系统内核开发提供了新的思路,探索了 Rust 在系统底层开发的潜力,目标是提升内核的稳定性和安全性,同时保留xv6原有的教育和研究价值。

人气

点赞 4

评论数 0

这个产品是什么?

这个项目是在一个叫做 xv6 的小型类 Unix 操作系统内核中,尝试用 Rust 这种编程语言来编写一部分功能模块。xv6 是一个很经典的操作系统教学和研究平台,大部分是用 C 语言写的。而 Rust 是一种以内存安全著称的编程语言,它的设计能够很大程度上避免一些常见的程序错误,比如空指针解引用(就像试图访问一个不存在的内存地址),或者数据竞争(多个部分同时修改同一份数据导致的混乱)。所以,在这个项目里,开发者探索的是如何把 Rust 的安全特性带入到操作系统这种对稳定性和安全性要求极高的底层环境中。这有点像给一个老式但可靠的机器,尝试安装一些用更现代、更安全材料制造的新零件,看看能不能让它运行得更平稳、更不容易出故障。这对于理解如何构建更健壮的操作系统内核非常有启发。

如何使用它?

对于开发者来说,这个项目提供了一个学习和研究 xv6 内核与 Rust 语言结合的实践平台。开发者可以通过研究项目中的 Rust 代码,理解如何在 C 语言为主的内核环境中嵌入 Rust 模块,以及如何处理 Rust 与 C 之间的接口(这通常需要一些特殊的技巧,叫做 FFI,或者 Foreign Function Interface)。更进一步,开发者可以尝试在这个基础上进行扩展,比如用 Rust 编写新的设备驱动、文件系统模块,或者其他内核子系统,来感受 Rust 在系统级编程中的优势。如果你对操作系统原理、底层开发或者 Rust 语言感兴趣,这个项目就是你动手实践和深入学习的好例子。你可以把它看作是一个沙盒,让你在安全的环境里尝试用 Rust 改造或扩展一个真实的内核。

产品核心功能

· Rust 模块的编译与集成:实现了将用 Rust 编写的代码编译成 xv6 内核可识别的模块,并通过特定的机制(如链接器脚本和内联汇编)将其集成到内核的构建过程中。这意味着开发者可以直接在内核中运行 Rust 代码,而不是把它当作一个独立的程序。这让你可以利用 Rust 的优势来编写内核的核心组件,从而提升内核的健壮性。

· Rust 与 C 的互操作性探索:解决了 Rust 代码如何调用 C 语言编写的 xv6 内核函数,以及 C 语言代码如何调用 Rust 函数的问题。这是将 Rust 引入现有 C 代码库的关键,它允许逐步引入 Rust,而无需完全重写。这意味着你可以一点一点地用 Rust 来优化内核的某些部分,而不会破坏现有的功能。

· 内存安全特性的引入:通过使用 Rust,项目旨在为 xv6 内核带来内存安全保证,减少因内存访问错误导致的崩溃或安全漏洞。这对于提高操作系统的稳定性和安全性至关重要,意味着你的系统将更不容易因为一些低级错误而宕机或受到攻击。

· 实验性的新功能开发:为开发者提供了一个起点,可以尝试用 Rust 来实现 xv6 的新功能或改进现有功能,例如更安全的设备驱动程序或更高效的内存管理。这让你有机会在操作系统最底层的层面进行创新,探索新的技术可能性,并为未来的操作系统设计贡献力量。

产品使用案例

· 安全设备驱动开发:想象一下,你需要为一个新的硬件设备编写驱动程序,这个驱动程序运行在操作系统的内核里。用传统的 C 语言,一个微小的内存错误就可能导致整个系统崩溃。而使用这个项目提供的 Rust 模块框架,你可以用 Rust 来编写这个驱动,Rust 会在编译时和运行时帮你检查很多潜在的内存问题,大大降低了驱动程序出错的风险。所以,你可以构建一个更稳定、更不容易导致系统宕机的设备驱动。

· 实验性文件系统模块:如果你想尝试开发一个全新的文件系统,比如一个性能更好或者更具弹性的文件系统,你可以用 Rust 来编写它的核心逻辑。Rust 的安全特性可以帮助你确保文件系统的操作不会损坏数据,也不会因为并发访问引起混乱。这意味着你可以更有信心地去创新文件系统的设计,并且减少因为程序错误导致数据丢失的担忧。

· 内核性能优化模块:在某些对性能要求极高的场景下,开发者可能会想尝试用 Rust 来重写 xv6 内核中的一部分性能瓶颈代码。Rust 的底层控制能力和其内存安全机制的结合,可能在不牺牲太多性能的情况下,提供更可靠的代码。所以,你可以通过使用 Rust 来优化内核的特定部分,同时保持代码的健壮性,从而提升整体系统的效率和稳定性。

26

ViralLoop: 裂变式增长引流平台

作者

soyzamudio

描述

ViralLoop 是一个专注于利用病毒式裂变机制来构建和管理等候列表(waitlist)的平台。它通过鼓励用户邀请朋友来加速获取的机制,将传统的等候列表转化为用户增长的引擎。其核心创新在于将游戏化和社交分享原理巧妙地融入到产品等待体验中,让等待不再枯燥,而是成为用户主动传播的动力。

人气

点赞 3

评论数 1

这个产品是什么?

ViralLoop 是一个能帮助你快速积累用户,特别是潜在客户的工具。想象一下,你有一个很酷的新产品或服务即将上线,但现在还没有准备好。你可以创建一个等候列表,然后让人们注册。ViralLoop 的特别之处在于,它不是让用户默默排队,而是给他们一个理由去邀请更多人加入。比如,邀请越多的人,他们在等候列表中的排名就越靠前,或者能解锁一些独家福利。这就像一个病毒传播模型,每个人都可以是传播者,从而帮助你指数级地增长潜在用户的数量。它的技术实现思路是将用户邀请、积分/排名系统、社交分享渠道(如微信、微博、Twitter等)以及用户数据分析集成起来,形成一个闭环。

如何使用它?

开发者可以通过嵌入 ViralLoop 的代码片段到你的网站或应用中,来快速启动一个等候列表。用户访问你的页面时,会看到注册并参与分享的选项。系统会自动生成一个独特的邀请链接给每个注册用户。当他们的朋友通过这个链接注册时,邀请者就能获得相应的积分或排名提升。你可以自定义分享奖励,例如解锁早期访问权限、折扣码、专属内容等。这使得开发者可以非常便捷地在自己的产品早期阶段,利用现有的用户基础或早期兴趣用户,通过口碑传播实现冷启动。

产品核心功能

· 自定义等候列表页面:允许开发者根据自己的品牌风格定制注册和分享页面的外观,确保用户体验的一致性。其价值在于提升品牌专业度和用户信任感。

· 病毒式邀请机制:通过为每个用户生成独特的分享链接,并设计激励机制(如排名提升、奖励解锁),鼓励用户主动传播。价值在于将用户等待时间转化为社交裂变增长的动力。

· 多渠道社交分享集成:支持一键分享到主流社交媒体平台,降低用户分享门槛。价值在于扩大传播范围,触达更多潜在用户。

· 实时排名与进度展示:向用户清晰展示其在等候列表中的当前排名以及距离解锁奖励或上线还有多远。价值在于提供透明度,增强用户的参与感和期待值。

· 用户数据分析与洞察:提供注册用户来源、邀请成功率、分享活跃度等数据报告。价值在于帮助开发者了解用户增长的有效性,优化营销策略。

产品使用案例

· 新App上线前预热:一个即将发布手机App的团队,使用ViralLoop创建等候列表。用户注册后,邀请三位好友注册即可获得App上线首月的会员资格。这使得App在上线前就积累了大量对产品感兴趣的种子用户。

· 线上课程推广:一个教育机构在推出新的在线课程前,通过ViralLoop引导用户注册,并许诺邀请越多好友报名,课程折扣越大。通过这种方式,在正式开课前就吸引了大量潜在学员,并利用他们的社交网络进行免费推广。

· 游戏社区招募内测玩家:一款新游戏的开发者,需要一批核心玩家进行内测。他们利用ViralLoop的机制,让注册用户邀请朋友来申请内测资格,邀请最多的人将优先获得内测名额,从而高效地招募到了一批活跃且有传播力的玩家。

27

市场脉搏LLM数据流

作者

_bshada

描述

这个项目搭建了一个特殊的服务器,能把印度证券交易所(NSE/BSE)实时的股票和期权交易数据,像流水一样传输给大型语言模型(LLM)。它让LLM能够理解并分析最新的市场行情,从而生成投资交易策略或市场分析报告,就像一个虚拟的股票分析师。

人气

点赞 2

评论数 2

这个产品是什么?

这是一个能够实时连接到印度股票市场(NSE/BSE)的服务器,它就像一个翻译官,把股票的买卖价格、交易量等关键信息,转换成LLM能够理解的格式。创新的地方在于,它让那些原本只能处理文本信息的LLM,第一次能够接触到动态变化的金融市场数据。这就像给一个只会看书的聪明脑袋,提供了一个观察真实世界的窗口,让它能做出更贴近现实的判断。

如何使用它?

开发者可以将这个服务器集成到他们现有的LLM应用中。通过简单的API调用,就可以让LLM获取实时的市场数据。例如,一个投资分析平台可以调用这个服务,让LLM分析当前的市场趋势,并给出投资建议。或者,一个交易机器人可以利用这些数据,自动执行交易策略。它提供了一种将金融市场数据引入AI分析流程的便捷方式。

产品核心功能

· 实时市场数据采集:从NSE/BSE交易所抓取最新的股票和期权交易数据,保证数据的时效性,这对于需要快速反应的交易和分析至关重要。

· 数据流式传输至LLM:将采集到的市场数据转化为LLM易于理解的格式,并实时推送,让LLM能够持续接收并处理最新信息。

· LLM分析与洞察生成:赋予LLM分析实时市场数据的能力,使其能够生成交易信号、风险评估、市场趋势预测等,极大地扩展了LLM在金融领域的应用。

· 自定义数据适配:允许开发者根据LLM的需求,对数据进行一定的预处理和格式调整,以达到最佳的分析效果。

产品使用案例

· 搭建一个AI驱动的股票市场分析助手:开发者可以利用此项目,为股票分析师提供一个能实时感知市场变化的AI工具,LLM能够根据最新数据推荐潜在的投资机会,或发出风险预警。

· 开发更智能的量化交易策略:将此项目的数据流接入到自研的交易算法中,让交易策略能够基于实时市场动态进行更精确的判断和操作,从而提高交易的成功率。

· 构建实时的金融新闻与情感分析系统:结合市场数据和新闻文本,LLM可以更准确地判断市场情绪,识别新闻对股价的潜在影响,为投资者提供更全面的信息。

28

速成AI规则模拟器

作者

chwmath

描述

这是一个在短短3小时内使用自然语言规则快速构建的AI行为模拟器,特别适用于模拟复杂的企业资源(ER)管理场景。它最大的技术创新在于,开发者无需编写复杂的代码,而是通过描述性的语言来定义AI的行为逻辑,极大地降低了AI模型开发的门槛,并能快速迭代。

人气

点赞 1

评论数 3

这个产品是什么?

这个项目是一个快速原型开发工具,它能让你用最自然的方式(就像写说明书一样)来告诉计算机,AI应该怎么做。举个例子,如果你想模拟一个公司里的员工如何处理报销,你可以写“当员工提交报销单时,如果金额小于100元,直接批准;如果大于100元,则需要部门经理审批”。这个模拟器就能理解这些规则,并模拟出AI的行为。它的技术核心在于一个强大的自然语言处理(NLP)引擎,能够将人类的语言指令转化为计算机可执行的逻辑,并在短时间内完成一个可工作的AI模型,特别适合用于快速验证想法或构建原型。

如何使用它?

开发者可以将这个模拟器集成到他们的开发流程中,用于快速测试AI在特定场景下的反应。例如,在一个新的游戏项目中,你可以用自然语言规则来定义NPC(非玩家角色)的行动逻辑,然后快速运行模拟器看看效果,而不是一开始就花费大量时间编写复杂的AI代码。你也可以用它来模拟业务流程,比如客户服务中的AI应答规则,输入规则,立即看到AI如何响应。它的集成方式可能通过API调用,或者直接运行其内置的模拟环境。

产品核心功能

· 自然语言规则定义AI行为:通过写人类能读懂的句子来定义AI的决策和动作,这使得AI开发不再是程序员的专属,任何人都可以参与到AI逻辑的设计中,其价值在于极大地加速了AI原型设计和迭代速度。

· 快速模拟运行:能够根据输入的自然语言规则,立即生成一个可运行的模拟器,让你在几分钟内就能看到AI的表现,这对于快速验证创意和解决方案至关重要。

· 易于理解和修改AI逻辑:由于规则是用自然语言编写的,即使是非技术人员也能轻松理解AI的思考过程,并且可以方便地修改规则以调整AI的行为,大大降低了AI开发的沟通成本和维护难度。

· 企业资源(ER)场景优化:特别针对企业资源管理等复杂场景进行了优化,能够模拟出员工、经理、系统等多个角色的交互行为,帮助企业更直观地理解和优化内部流程。

产品使用案例

· 游戏开发场景:开发者可以用“当玩家接近宝箱时,如果玩家拥有钥匙,则打开宝箱并获得物品”这样的规则,快速模拟游戏角色与环境的交互,而无需编写复杂的寻路和状态机代码。

· 教育和培训模拟:用于创建交互式学习体验,例如模拟一个历史事件中的决策过程,让学习者通过输入不同的指令来观察AI角色如何反应,从而理解不同选择的后果。

· 业务流程原型设计:企业用户可以定义“当客户提交退货申请,如果商品未拆封,则自动批准退款;如果已拆封,则转为人工审核”这样的规则,快速模拟一个客户服务流程,以优化其服务效率。

· AI产品概念验证:创业者或产品经理可以用这个工具快速搭建一个AI驱动的产品原型,用自然语言描述其核心功能,并在早期阶段就向潜在用户展示,以收集反馈和验证市场需求。

29

Watsn.ai - 智能真相探针

作者

flx1012

描述

Watsn.ai 是一款无需注册,上传或录制视频即可进行真实性验证的工具。它利用了当前最先进的多模态模型,结合面部微表情、语音模式和上下文信息,试图实现对视频内容真实性的突破性判断。通过科学分析,它能够辅助判断视频内容的真伪,为信息辨别提供新的思路。

人气

点赞 2

评论数 2

这个产品是什么?

Watsn.ai 是一个基于人工智能的视频真实性分析工具。它的核心技术在于运用了最前沿的多模态(multimodal)人工智能模型。简单来说,它不再只看视频画面,而是同时分析视频中的多个维度:视频画面里的细微表情变化(比如人们紧张或说谎时会不自觉地做出一些微表情),说话时的语音语调和节奏(语速、音高、停顿等都能反映情绪状态),以及视频内容的整体语境和逻辑。通过综合这些信息,它试图比单纯的人类判断更客观、更准确地识别视频中是否存在欺骗或不实信息。这就像让一个超级聪明、能同时观察、聆听并理解一切的AI来帮你判断一个人说的是否是实话。

如何使用它?

开发者可以将 Watsn.ai 集成到各种需要验证信息真实性的应用场景中。例如,可以集成到社交媒体平台的审核系统中,自动标记可能包含虚假信息的视频;或者用于新闻内容的分发平台,提前预警不可信的内容。对于内容创作者来说,也可以上传自己的视频进行自查,确保信息准确无误。未来,甚至可以想象它被用于在线教育,帮助学生辨别教学视频的真伪。集成方式可以通过API调用,将待验证的视频数据发送给 Watsn.ai 进行分析,然后返回一个置信度分数或相关的分析报告。

产品核心功能

· 微表情分析:通过AI识别视频中人物的细微面部肌肉运动,这些微表情常常是情绪和真实意图的无意识流露,从而辅助判断信息的可信度。这可以帮助我们识别那些故作镇定或掩饰真实情绪的表达。

· 语音模式分析:AI会分析说话者的语速、音高、语调、呼吸频率等语音特征,这些声学信息与人的情绪和压力水平高度相关,能够为判断信息真伪提供线索。例如,语速突然加快或音调异常升高可能暗示着紧张。

· 上下文整合分析:系统会理解视频内容的整体叙事和逻辑,结合微表情和语音数据,进行多维度综合判断,识别信息是否与实际情况或常识相悖。这能帮助我们发现那些表面看起来无懈可击,但逻辑上却存在问题的陈述。

· 实时验证能力:支持上传现有视频或进行实时视频录制,即时进行真伪验证,为用户提供快速的信息反馈。这使得它能够适应多种紧急和即时的信息验证需求。

产品使用案例

· 在社交媒体上,当用户上传一段声称是某事件的真实视频时,Watsn.ai 可以快速分析视频,标记出其中可能存在的剪辑痕迹、表演痕迹或情绪上的不一致,帮助平台过滤掉虚假或误导性的内容,保护用户免受信息欺骗。

· 对于独立记者或事实核查机构,Watsn.ai 可以作为一个辅助工具,在初步核查一段视频证据时,提供一个基于AI的初步评估,快速判断该视频的真实性,提高核查效率。例如,一个政治家在公开演讲中的一段视频,Watsn.ai可以分析其在关键问题上的微表情和语气,判断其是否真心相信自己所说。

· 用户可以在求职面试或重要谈判前,使用Watsn.ai分析对方的视频,了解其真实意图和情绪状态,为沟通和决策提供更多参考。这可以帮助个人在重要的交流场景中,更深入地理解对方。

· 在娱乐领域,可以用来分析网络名人或公众人物的采访视频,增加内容的趣味性和讨论性,例如,分析某个网红在谈论自己的收入时是否表现出不自然。这为公众提供了一个更加有趣和信息丰富的视角来观察公众人物。

30

BirdWrite AI 内容引擎

作者

devanimecx

描述

BirdWrite 是一个 AI 驱动的内容生成引擎,旨在帮助开发者和内容创作者快速高效地生成高质量的文本内容。它通过先进的自然语言处理(NLP)和机器学习技术,能够理解用户的意图,并输出结构清晰、语言流畅的文章、故事、代码注释等。它的创新之处在于将 AI 的强大能力转化为开发者易于集成的工具,解决内容创作效率瓶颈,并为个性化内容输出提供可能性。

人气

点赞 2

评论数 1

这个产品是什么?

BirdWrite 是一个让你电脑里的“AI 大脑”为你写作的工具。它就像一个非常聪明的助手,能够理解你说的话(比如你想要写什么主题的文章,或者想写什么样的故事),然后利用它学到的海量知识和语言规律,帮你把想法变成文字。它的技术核心是“自然语言处理”和“机器学习”,简单来说就是让电脑学会理解和生成人类的语言。创新之处在于,它不是一个只能在网页上使用的独立应用,而是可以被集成到你的开发流程中,比如自动帮你写代码文档,或者帮你构思营销文案,让你不用再花费大量时间从零开始写字。

如何使用它?

开发者可以将 BirdWrite 集成到他们的应用程序或工作流程中,通过 API 调用来生成文本。例如,你可以用它来:

1. 自动为你的代码生成详细的说明文档(Code Documentation)。

2. 在游戏开发中,根据设定的角色属性和情节,生成 NPC 的对话或背景故事。

3. 在 Web 应用中,为用户评论或产品描述生成初步草稿。

4. 将它作为一个“写作辅助”插件,集成到你常用的编辑器(如 VS Code)中,在写作时随时调用。

简单来说,就是你可以通过编程的方式,让 BirdWrite 帮你写东西,把它当成一个能输出文字的“服务”。

产品核心功能

· AI 文章生成:能够根据用户输入的关键词、主题或摘要,生成符合要求的文章草稿,极大地提高了内容生产效率。

· 代码注释自动生成:分析代码逻辑,自动生成可读性强的注释,减轻开发者编写文档的负担,提升代码可维护性。

· 故事与创意内容创作:支持生成虚构故事、诗歌、剧本等创意内容,为内容创作者提供灵感来源和快速原型制作能力。

· 多风格文本输出:能够根据指令调整输出内容的语气、风格和专业度,满足不同场景的需求。

· API 集成能力:提供灵活的 API 接口,方便开发者将其集成到各种自定义工具和平台中,实现自动化内容工作流。

产品使用案例

· 场景:一个独立游戏开发者需要为游戏中的大量 NPC 设计背景故事和对话。BirdWrite 可以根据角色的性格、阵营和剧情节点,快速生成多样化的对话和故事线,节省了大量人工写作时间。

· 场景:一个 SaaS 产品团队需要为新功能编写详细的用户指南和 API 文档。BirdWrite 可以分析功能描述和代码,自动生成初稿,开发者只需在此基础上进行少量修改和润色,即可发布。

· 场景:一个博客作者希望定期发布高质量的技术文章,但受限于写作速度。将 BirdWrite 集成到写作流程中,可以帮助作者快速生成文章框架和段落,作者专注于内容深度和独到见解的完善,显著提升了发布频率。

· 场景:一个电商平台希望为每件商品生成吸引人的产品描述。BirdWrite 可以根据商品特点和目标用户群体,生成不同风格的营销文案,帮助提高转化率。

31

CVE-Stream API

作者

cybersec_api

描述

这是一个由开发者Cybersec_api创建的CVE(通用漏洞披露)信息搜索API。当开发者在构建安全工具时,常常会遇到官方漏洞数据库响应慢、有访问限制的问题。为了解决这个问题,他处理了25年的CVE数据(1999-2025),经过清洗后,将其存储在一个轻量级的SQLite数据库中,并通过FastAPI框架暴露出来,能够返回适合AI和自动化工具使用的结构化JSON数据。它旨在提供一个快速、免费的CVE信息访问途径。

人气

点赞 1

评论数 2

这个产品是什么?

CVE-Stream API是一个为安全开发者设计的、快速且免费的CVE(通用漏洞披露)信息搜索服务。它将25年来(1999-2025)的CVE数据进行清洗和优化,存储在SQLite数据库中,并通过Python FastAPI框架提供服务。创新的地方在于它解决了官方CVE数据库(如NVD)响应慢、限制多的痛点,以结构化的JSON格式输出数据,特别适合集成到AI安全工具或自动化安全扫描项目中。所以,这对我来说意味着,我可以在开发安全应用时,更高效、更低成本地获取准确的漏洞信息,而不必担心API访问速度和配额问题。

如何使用它?

开发者可以通过RapidAPI平台访问CVE-Stream API。注册并获取API密钥后,就可以通过HTTP请求调用API来搜索CVE信息。例如,你可以根据漏洞ID、CVE编号、产品名称或者受影响的软件版本等关键词进行查询。API会返回一个包含详细漏洞信息的JSON对象,其中可能包括漏洞描述、CVSS评分、受影响的组件、修复建议等。你可以将这些数据直接集成到你的安全扫描工具、威胁情报平台、漏洞管理系统或安全研究报告生成器中。集成方式通常是通过代码中的HTTP客户端库(如Python的requests库、JavaScript的axios库等)来发送请求并处理返回的JSON数据。所以,这对我来说意味着,我可以轻松地将一个强大的漏洞数据库功能嵌入到我的任何应用程序或脚本中,实现自动化的漏洞分析和响应。

产品核心功能

· 快速CVE信息检索:通过优化的SQLite数据库和高效的API接口,能够迅速响应查询请求,解决官方数据库响应慢的问题。这意味着在紧急的安全响应场景下,我能更快地获取关键漏洞情报。

· 结构化JSON输出:返回的数据格式清晰、易于解析,特别适合AI模型和自动化脚本处理。这意味着我的安全工具可以更容易地理解和利用漏洞数据,实现更智能的安全分析。

· 全面的历史数据覆盖:包含了1999年至2025年的CVE数据,为长期安全趋势分析和历史漏洞追溯提供了基础。这意味着我可以进行更深入的安全研究,了解漏洞的演变和影响。

· 免费API访问(含免费套餐):降低了开发者入门和使用成本,让更多人能够负担得起高质量的安全数据服务。这意味着即使是小型团队或个人开发者,也能享受到强大的漏洞数据库功能,而无需承担高昂的费用。

· LLM友好数据处理:数据经过清洗,适合用于大型语言模型(LLM)的上下文处理,有助于构建更智能的安全AI应用。这意味着我可以用这个API作为数据源,训练或驱动我的安全AI助手,使其更懂漏洞信息。

产品使用案例

· 安全自动化工具:当安全扫描器发现一个可疑的软件版本时,可以使用CVE-Stream API快速查询是否存在已知的漏洞,并根据漏洞的严重程度决定后续的响应措施。例如,一个Web应用防火墙(WAF)可以集成此API,实时识别并阻止针对已知漏洞的攻击。

· 威胁情报平台:将CVE-Stream API的数据源接入到威胁情报平台,可以帮助安全分析师聚合、关联和分析最新的安全威胁信息,识别潜在的攻击向量和目标。例如,可以根据近期爆发的漏洞,预测可能的攻击目标区域。

· 漏洞管理系统:企业可以用此API来补充或替换现有的漏洞扫描器或数据库,更高效地跟踪和管理其IT资产的漏洞状态。例如,当发现服务器存在某个软件版本时,系统可以自动查询并预警相关的CVE,并提示更新。

· 安全研究和教育:安全研究人员和学生可以利用这个API进行漏洞挖掘、安全趋势分析和安全教育内容的制作。例如,可以分析过去十年间高危漏洞的分布规律,撰写技术报告或制作教学视频。

· AI安全助手开发:开发者可以利用API提供的数据,训练或微调AI模型,使其能够理解和回答关于漏洞的各种问题,或自动生成安全建议。例如,可以构建一个能根据用户描述的系统配置,智能推荐潜在安全风险的AI助手。

32

隐私协议一键生成器

作者

jiaweixie

描述

这是一个在VS Code编辑器中运行的插件,能够自动扫描你的应用程序代码,并根据代码中使用的技术和数据处理方式,为你生成一份定制化的隐私政策。它解决了开发者需要花费大量时间和精力来编写符合法规要求的隐私政策的痛点,让技术创新者能够更专注于产品开发。

人气

点赞 3

评论数 0

这个产品是什么?

这是一个专门为开发者设计的VS Code插件,它利用代码扫描技术来理解你的应用程序在数据收集、处理和存储方面的行为。例如,如果你的应用使用了地图服务,它会识别出可能需要告知用户收集地理位置信息;如果使用了广告 SDK,它会识别出可能需要告知用户收集设备标识符。通过分析这些技术细节,插件能够生成一份更准确、更符合你实际情况的隐私政策,而不是一份通用模板。这对于避免法律风险和赢得用户信任至关重要。所以这对我有什么用?它可以为你节省数小时甚至数天的法律咨询和文档撰写时间,确保你的应用合规,让你安心开发。

如何使用它?

开发者只需要在VS Code中安装这个插件,然后打开你的项目。插件会在后台自动分析你的代码,检测与数据隐私相关的技术使用情况(比如第三方库、API调用等)。当插件完成分析后,它会提供一个生成隐私政策的选项,你可以一键生成。生成的隐私政策可以直接导出,你可以进行审查和微调。这对于希望快速上线并确保合规性的个人开发者或小型团队来说非常方便。所以这对我有什么用?你无需离开熟悉的开发环境,就能快速获得一份初步的、有针对性的隐私政策,大大加快了产品发布流程。

产品核心功能

· 代码内容扫描与技术识别:通过解析代码,自动识别应用中可能涉及到的数据收集和处理的技术点,如数据存储方式、第三方服务集成等,以便在隐私政策中准确说明。价值:确保隐私政策能反映应用的真实数据实践。

· 隐私政策生成:基于扫描识别出的技术点,自动生成结构完整、内容相关的隐私政策草稿,覆盖常见的隐私条款。价值:极大地减少了手动撰写隐私政策的时间和精力。

· 定制化建议:根据代码分析结果,为隐私政策中特定部分提供定制化建议,使其更符合应用的具体情况。价值:避免使用泛泛的、不适用于自身应用的通用条款,提高政策的有效性。

· VS Code集成:作为VS Code插件运行,提供流畅的开发工作流集成,无需切换工具。价值:让开发者在编码过程中就能轻松完成合规性工作,提高开发效率。

产品使用案例

· 一个独立开发者开发了一个社交分享应用,使用了Firebase来存储用户数据和Google Analytics进行用户行为分析。开发者只需安装插件,扫描代码后,插件就能识别出Firebase和Google Analytics的使用,并在生成的隐私政策中自动添加关于用户数据存储和行为分析的条款。价值:确保了应用在用户数据方面的合规性,避免了潜在的法律纠纷。

· 一个游戏开发者使用Unity引擎,并集成了Facebook SDK用于广告变现和用户登录。插件能够识别Unity引擎可能涉及的特定数据处理,以及Facebook SDK的集成,从而生成包含广告追踪、用户身份验证等信息的隐私政策。价值:游戏开发者能够快速满足不同平台(如App Store, Google Play)对隐私政策的要求。

· 一个Web应用开发团队,使用了AWS S3作为文件存储,并利用了第三方邮件服务发送通知。插件能够识别AWS S3存储的文件类型和邮件服务的使用,并在隐私政策中说明用户上传的文件可能存储在哪里,以及发送通知时可能收集的电子邮件地址等信息。价值:提高了Web应用在用户数据处理透明度,增强了用户信任。

33

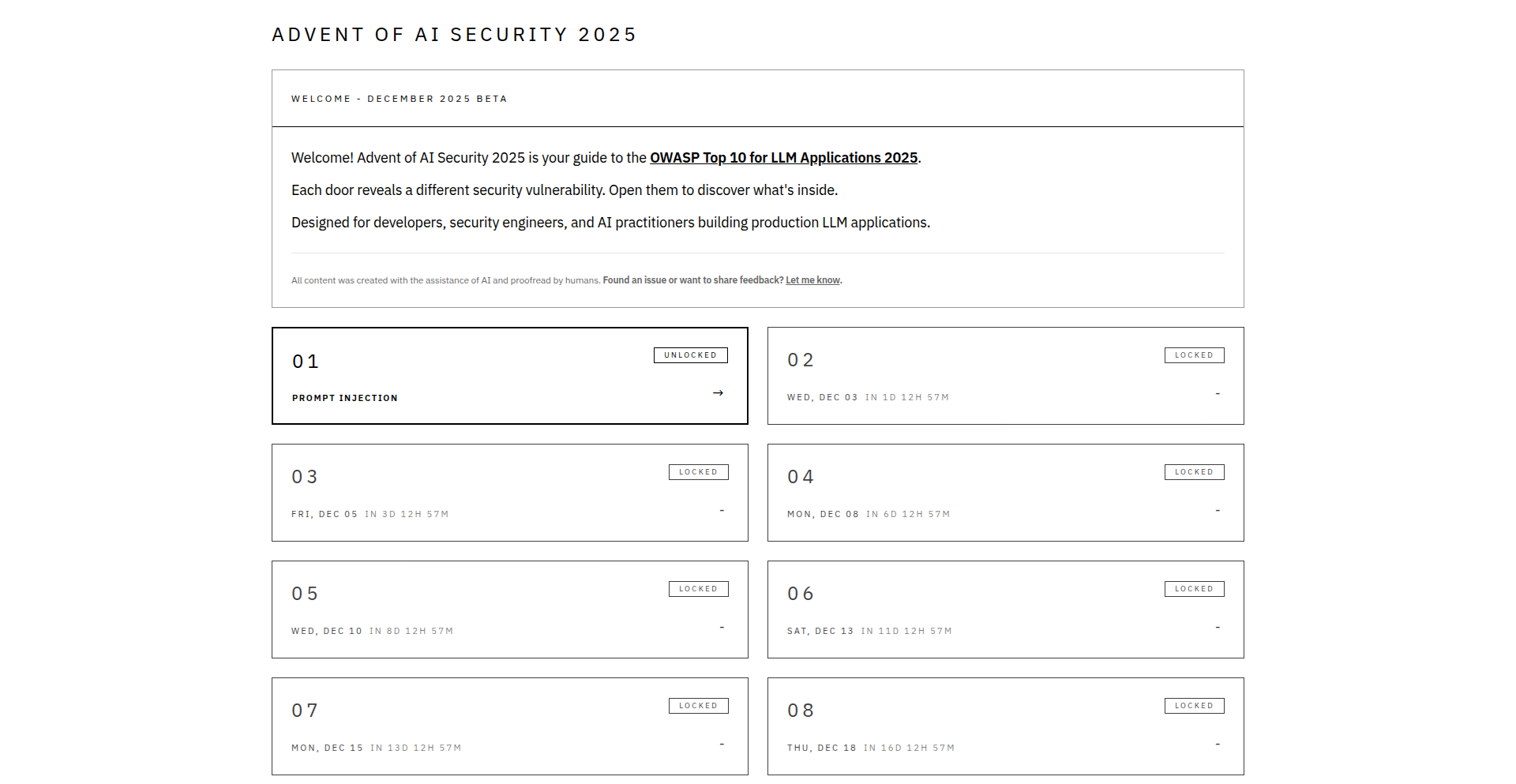

AI安全启示录2025 (Advent of AI Security 2025)

作者

icepuma

描述

这是一个为期30天的AI安全挑战项目,旨在通过实践学习和探索AI在安全领域的应用与对抗。它通过每日发布的挑战,鼓励开发者深入理解AI模型的工作原理,并学习如何发现、利用和防御AI系统中的安全漏洞。这种集训式的学习方式,是将前沿AI安全知识转化为可操作技能的创新实践。

人气

点赞 1

评论数 2

这个产品是什么?

Advent of AI Security 2025 是一个通过每日实践挑战来学习AI安全概念的项目。它的技术原理是通过一系列精心设计的编程任务,让开发者亲身体验AI模型的构建、训练、评估以及可能存在的安全风险。创新之处在于它将抽象的AI安全理论,转化为开发者可以通过代码直接接触和解决的实际问题,模拟真实的AI安全攻防场景。所以这对我有什么用?你可以通过参与,获得在AI安全领域的实践经验,了解AI模型容易受到哪些攻击,以及如何保护AI系统不受侵害,从而提升你的AI安全技能。

如何使用它?

开发者可以通过访问项目提供的GitHub仓库或相关链接,获取每日的挑战说明和必要的代码模板。挑战通常涉及使用Python和流行的AI库(如TensorFlow、PyTorch)来实现特定的安全测试或防御机制。你可以从最基础的AI模型理解开始,逐步深入到对抗样本的生成、模型逃逸攻击、数据隐私泄露等更复杂的主题。所以这对我有什么用?你可以将项目提供的代码集成到你自己的AI开发流程中,用于测试你的AI模型的安全性,或者在你学习AI新技术的过程中,同步学习其安全风险和防护方法。

产品核心功能

· 每日AI安全攻防挑战:提供一系列从易到难的编程任务,涵盖AI模型的不同安全维度,每个任务都旨在教会开发者一种AI安全技术或攻防思路,帮助开发者边学边练,获得即时反馈。

· 代码实践与实验环境:提供可运行的代码示例和指导,让开发者无需从零开始搭建复杂的AI安全实验环境,可以快速上手,专注于学习和理解AI安全的核心概念和实现细节,直接提升实践能力。

· 真实AI安全场景模拟:挑战内容基于当前AI安全研究的热点和实际应用中的安全问题,让开发者接触到最前沿的AI安全知识,了解AI在实际部署中可能面临的风险,如模型投毒、数据隐私泄露等,提升解决实际安全问题的能力。

· 社区协作与知识共享:鼓励参与者在社区(如GitHub Issues、Discord)分享解题思路和学习心得,形成互相学习、共同进步的技术氛围,通过集体的智慧加速对AI安全复杂问题的理解和掌握,拓展人脉。

· AI安全工具与技术探索:项目鼓励开发者探索和学习现有的AI安全检测工具和防护技术,并将其应用到挑战中,从而了解当前AI安全领域的技术生态,并学习如何利用现有工具解决实际问题,提升工程效率。

产品使用案例

· 在开发一个图像识别AI模型时,参与者可以通过挑战学习如何生成对抗样本,测试模型是否容易被微小的、人眼无法察觉的干扰欺骗,从而提高模型鲁棒性。

· 当你需要部署一个处理敏感用户数据的AI模型时,可以利用项目中的挑战来学习如何检测模型是否存在数据泄露风险,比如攻击者能否通过输入特定数据来恢复训练集中的原始信息,从而加强数据保护。

· 对于需要开发AI驱动的推荐系统,项目提供的挑战可以帮助开发者理解如何防止推荐系统被恶意操纵,例如通过注入虚假用户行为来影响推荐结果,确保推荐的公平性和有效性。

· 如果你正在构建一个AI客服机器人,可以通过挑战学习如何防范模型被“越狱”,避免模型泄露内部知识、生成不当内容或执行未经授权的操作,提高AI系统的安全性和可靠性。

· 在进行AI模型审计时,可以借鉴项目中的挑战思路,去系统性地发现模型在公平性、偏见、透明度等方面可能存在的安全隐患,并学习如何缓解这些问题,构建更负责任的AI。

34

存储性能探针

作者

shutty

描述

一个由开发者手动进行的存储性能基准测试项目,深入分析了AWS S3、S3 Express、EBS以及实例存储的读数据延迟。其技术创新在于,通过精细化的测试方法,揭示了不同存储方案在实际读操作中的细微性能差异,为开发者提供了宝贵的性能选择依据。

人气

点赞 3

评论数 0

这个产品是什么?

这是一个用于评估和对比不同云存储和本地存储方案读取数据速度的项目。它不是一个现成的服务,而是开发者通过代码执行的一系列详细测试。通过模拟真实的应用场景,项目测量了数据从存储介质到达应用程序的时间,即“读延迟”。这种细致的分析,对于需要高性能数据访问的应用(比如数据库、缓存、大型文件处理等)来说,能够帮助开发者理解哪种存储方案能提供最快的响应速度。

如何使用它?

开发者可以通过查看项目代码(如果作者有开源的话)来理解测试方法和工具。虽然这不是一个可以即插即用的工具,但其测试思路和方法可以被开发者借鉴和复用。例如,如果你正在为你的应用程序选择云存储,你可以参考这里的测试方法,在你自己的环境中搭建类似的测试,来验证不同存储方案在你特定应用场景下的表现。其价值在于提供了一种“自己动手”验证性能的方法,而非仅仅依赖服务商提供的理论数据。

产品核心功能

· AWS S3读延迟基准测试:通过实际测量S3的读操作速度,让开发者了解在访问对象存储时可能遇到的延迟情况,方便在高并发读写场景下进行权衡。

· S3 Express读延迟基准测试:分析S3 Express(一种针对特定高性能场景的S3版本)的读延迟,帮助开发者判断是否值得为更高的性能付出成本。

· EBS(Elastic Block Store)读延迟基准测试:评估AWS提供的块存储卷的读性能,这对于需要类似本地硬盘性能的数据库和应用程序来说至关重要。

· 实例存储(Instance Store)读延迟基准测试:测量服务器本地附加存储(通常是SSD)的读速度,展示了物理硬件直接访问的极限性能,为对延迟极其敏感的应用提供参考。

· 多存储方案性能对比分析:将不同存储方案的测试结果进行横向比较,清晰地呈现出各种存储介质的优劣势,帮助开发者做出明智的技术选型决策。

产品使用案例

· 需要低延迟实时数据服务的Web应用:开发者可以通过参考此项目,选择EBS或实例存储,以确保用户能够快速获取所需信息,提升用户体验。

· 大规模数据集分析处理:在处理大量数据时,理解不同存储的读性能对整个处理流程的耗时至关重要。此项目提供的基准数据能帮助选择最适合的存储方案,缩短分析时间。

· 数据库部署优化:数据库的读写性能直接影响应用程序的响应速度。了解EBS或S3 Express的读延迟,可以帮助开发者选择最能满足数据库性能需求的存储类型。

· 高吞吐量媒体流服务:对于需要快速传输大量媒体文件(如视频、音频)的服务,理解S3或S3 Express的读性能,有助于构建更流畅、无卡顿的用户体验。

35

Paper2Song:将学术论文变成音乐的创意引擎

作者

syntaxers

描述

Paper2Song 是一款将复杂的学术论文(特指 NeurIPS 2025 会议论文)转化为独特音乐的创新项目。它不仅仅是简单的文本转音频,而是通过创新的技术手段,让研究成果能够以一种全新的、更具感染力的方式被“听见”。解决了学术信息传播的痛点,让科研成果更易于理解和传播,尤其适合需要快速了解大量信息的研究者和公众。

人气

点赞 2

评论数 1

这个产品是什么?

Paper2Song 是一个利用技术将机器学习领域的学术论文,尤其是 NeurIPS 2025 的论文,变成音乐的项目。它的核心创新在于,它能分析论文的内容(比如主题、方法、结论等),并将这些信息映射到音乐的各个维度,如旋律、节奏、音色等。这就像是给每一篇论文都写了一首专属的“主题曲”,让原本枯燥的文字变得生动有趣。所以这对我有什么用?你可以通过听觉来快速感知论文的核心思想,而无需逐字阅读。

如何使用它?

开发者可以通过 Paper2Song 的在线平台,选择 NeurIPS 2025 的论文,项目会自动将其转化为一首独一无二的音乐。你可以在平台上搜索特定主题的论文,发现那些你可能从未关注过的研究领域,并通过音乐来发现灵感。它还支持分享你发现的“灵感之曲”,与他人交流。所以这对我有什么用?你可以轻松地浏览和发现前沿研究,甚至可以通过音乐来激发自己的创新思路,而无需花费大量时间去阅读每一篇论文。

产品核心功能

· 论文内容到音乐的映射:通过复杂的算法分析论文的文本内容,提取关键信息,并将其转化为音乐的结构和元素,实现“听懂”论文。所以这对我有什么用?让你用耳朵就能捕捉到论文的精髓。

· 多维度音乐生成:不只是简单的朗读,而是利用旋律、节奏、和弦和音色来表现论文的不同方面,如研究的复杂性、创新性等。所以这对我有什么用?提供更丰富、更具表现力的信息载体。

· 主题搜索与发现:允许用户按主题搜索论文,并通过音乐来发现新的研究领域或研究方向。所以这对我有什么用?帮助你高效地探索感兴趣的研究领域,发现潜在的合作或研究机会。

· 音乐驱动的科研探索:将科研过程与音乐艺术结合,创造一种全新的科研信息消费和传播方式。所以这对我有什么用?让科研过程变得更加有趣和具有启发性,打破信息壁垒。

产品使用案例

· 一个机器学习研究员需要快速了解 NeurIPS 2025 大会的所有论文,但他只有有限的时间。他可以使用 Paper2Song,通过听取每篇论文的“歌曲”来快速判断其是否与自己的研究方向相关,从而节省大量阅读时间。所以这对我有什么用?大幅提高信息筛选效率。

· 一个对人工智能感兴趣但缺乏专业背景的公众,可以通过 Paper2Song 聆听不同 AI 论文的“歌曲”,以一种轻松愉快的方式了解 AI 的发展动态和前沿技术。所以这对我有什么用?让复杂的科学概念变得通俗易懂。

· 一位音乐爱好者,想探索科技与艺术的结合点,他可以利用 Paper2Song 发现那些由科研论文转化而来的独特音乐,体验科技带来的艺术创新。所以这对我有什么用?提供一种新颖的艺术体验,感受科技的魅力。

36

PICA:实验自动化与仪器控制的开源利器

作者

prathameshnium

描述

PICA(Python-based Instrument Control and Automation)是一个开源的Python软件套件,它能像一个总指挥一样,协调和自动化各种复杂的实验室精密仪器,执行材料科学研究中的特定测量流程。它提供了一个直观的图形界面,让研究人员能轻松设置实验参数并运行自动化测量,例如测量电流随电压的变化(I-V sweeps)、电阻随温度的变化(Resistivity vs. Temperature)以及热释电测量循环(Pyroelectric measurement loops)。PICA旨在成为像LabVIEW这样的商业软件的、更灵活、更易于访问的替代品。

人气

点赞 3

评论数 0

这个产品是什么?

PICA 是一个用Python编写的、开源的实验室仪器控制和自动化软件。想象一下,你有一个复杂的科学实验,需要用到很多高精度的仪器,比如能精确控制电流电压的源表、测量温度的控制器、测量电容电感的仪器等。以往,你可能需要购买昂贵的商业软件(如LabVIEW),或者花费大量时间编写复杂的代码来让这些仪器协同工作。PICA就是为了解决这个问题而生的。它的创新之处在于:

1. **开源与图形界面(GUI)**:这意味着任何人都可以免费使用、修改和分享它。同时,它提供了一个用户友好的图形界面,即使你不是编程专家,也能通过点选和输入参数来设置和运行实验,大大降低了使用门槛。

2. **进程隔离(Process Isolation)**:在进行精密测量时,如果某个仪器驱动程序出错或者超时,很容易导致整个软件崩溃,前功尽弃。PICA采用了先进的“多进程架构”,将控制每个仪器的任务放在独立的“小房间”里运行。这样,一个“小房间”出了问题,不会影响到其他“小房间”和主控制界面,实验的稳定性和可靠性大大提高。

3. **实时数据可视化**:实验过程中,数据不断产生。PICA能够实时地将这些数据绘制成图表,让你随时了解实验的进展情况,可以及时发现异常并调整参数。这就好比在开车时,仪表盘能实时显示速度、油量等信息,让你对车况了如指掌。

4. **实验室验证的可靠性**:PICA并非纸上谈兵,它已经在印度一家知名的科学研究机构的实验室中,经过了严格的低温(80K至320K)运输测量验证,证明了其在实际科研场景中的稳定性和有效性。

所以,PICA的价值在于,它用一种更开放、更易用、更稳定的方式,帮助科研人员自动化复杂的实验流程,节省时间和成本,并提高实验的精确度和可靠性。

如何使用它?

开发者可以使用PICA来搭建和运行各种科学实验。其使用场景主要包括:

1. **集成高精度仪器**:如果你的实验室拥有Keithley SourceMeters、Lakeshore Controllers、LCR Meters等精密仪器,PICA可以直接与它们通信,并根据预设的协议进行控制。例如,你可以通过PICA的界面,指示源表输出特定的电压,然后测量电流的变化。

2. **自动化测量流程**:你可以将一系列测量步骤打包成一个自动化脚本。比如,设定一个实验是“测量材料在不同温度下的电阻值”。通过PICA,你可以设置一个温度扫描的范围和步长,仪器会自动在每个温度点进行电阻测量,并将所有数据记录下来,而无需人工逐个操作。

3. **二次开发与定制**:对于有编程背景的开发者,PICA的开源特性意味着你可以基于它进行二次开发。如果你有特殊的仪器控制需求,或者需要集成PICA到现有的系统中,可以修改或扩展PICA的代码,实现更高级的功能。

4. **部署到研究环境**:PICA提供了一个完整的图形界面,可以轻松安装和运行在研究人员的电脑上。通过简单的配置,连接仪器,即可启动自动化实验。其多进程架构也确保了在复杂的实验环境中运行的稳定性。

集成方式上,开发者可以通过Python的包管理工具(如pip)安装PICA,然后通过其提供的API(应用程序编程接口)或者直接使用其GUI来与仪器交互。对于需要更高定制化的场景,可以直接修改PICA的Python源代码。

产品核心功能

· 图形用户界面(GUI)用于实验参数设置和流程控制:这使得即使不是编程专家的研究人员也能轻松上手,通过可视化的方式配置复杂的测量任务,极大降低了学习成本和操作难度。

· 多进程架构用于仪器控制的进程隔离:这保证了单个仪器驱动的故障不会导致整个实验软件崩溃,提高了实验的稳定性和容错能力,确保了数据采集的连续性,避免了因意外中断而导致实验失败。

· 实时数据可视化与绘图功能:在实验进行过程中,能够即时显示测量数据并生成图表。这有助于研究人员实时监控实验进程,及时发现异常情况,并对实验参数进行微调,提高实验的效率和数据的质量。

· 支持多种主流高精度实验室仪器(如Keithley SourceMeters、Lakeshore Controllers、LCR Meters)的控制:这提供了广泛的硬件兼容性,让用户能够利用PICA统一管理和自动化不同类型的精密设备,无需为每种仪器寻找独立的控制软件。

· 预设了材料科学研究中的常见实验协议(如I-V sweeps, Resistivity vs. Temperature, Pyroelectric measurement loops)的自动化:用户可以直接调用或修改这些成熟的实验模板,快速启动标准化的测量流程,节省了从零开始编程的时间,并保证了实验的可重复性。

产品使用案例

· 一个材料科学实验室的研究员需要测量一种新材料在不同温度下的导电性能。他使用PICA,通过GUI设置温度范围(从80K到320K,步长为5K),并指定LCR Meter在每个温度点自动测量电阻。PICA会自动控制制冷设备降温到设定温度,稳定后由LCR Meter进行测量,然后记录数据并自动升高温度进行下一轮测量。这比手动操作和记录数据节省了数十小时的工作量,并确保了数据的精确性。

· 一个物理系的研究生需要研究半导体器件的电流-电压特性曲线。他使用PICA连接Keithley SourceMeter,通过GUI界面设置电压扫描的起始值、结束值和步长。PICA会驱动SourceMeter按照设定的电压序列进行扫描,并实时读取对应的电流值。实时绘图功能让他可以在实验过程中就看到曲线的初步形状,判断是否存在异常,例如器件击穿或接触不良。最终,PICA自动保存了完整的I-V数据,为后续的器件模型分析提供了基础。

· 一个研究团队正在进行热释电效应测量,需要精确控制样品的温度变化速率,并同步采集热释电信号。他们使用PICA,结合Lakeshore温控器和另一个信号采集设备。通过PICA的脚本功能,他们可以编写一个复杂的协议,要求温控器以特定的速率升高温度,同时PICA驱动信号采集设备以高采样率记录热释电电流。PICA的进程隔离机制在这种多设备同步控制的任务中尤为重要,确保了每个设备的稳定运行,防止了数据丢失。

· 一个初创公司在开发新型传感器,需要对传感器在不同环境条件下的响应进行大量测试。他们希望有一个灵活的解决方案,能够适应未来传感器设计的变化。PICA的开源特性和模块化设计,允许公司在PICA的基础上进行定制开发,添加对他们特有测试设备的支持,并构建一套标准化的自动化测试流程。这比购买昂贵的专用测试设备和软件,提供了更高的性价比和灵活性。

37

VoicePayOS: 签名支付的语音助手

作者

gauravguitara

描述

VoicePayOS 是一个创新的项目,它让语音助手能够安全地代表用户进行支付,并符合支付卡行业(PCI)合规性要求。通过利用 HTTP 消息签名(RFC 9421),它解决了当前语音助手在支付环节需要手动操作(如发送支付链接或 OTP)的痛点,实现了更流畅、安全的语音支付体验。

人气

点赞 3

评论数 0

这个产品是什么?

VoicePayOS 是一个技术方案,让语音助手可以通过数字签名的方式,在用户授权下代表用户完成支付。它的核心在于使用 HTTP 消息签名(一种加密技术,类似于给消息盖个独一无二的戳)来确保支付请求的合法性和安全性。当用户通过语音助手购物时,语音助手(比如 demo 中的 Pete 和 Penny)会将商品添加到购物车,并在支付时,由一个专门的支付助手生成一个签名后的支付请求。这个签名包含了支付助手(Agent)的身份信息,并经过了数字签名。商家可以通过一个叫做 OpenBotAuth 的注册系统来验证这个签名的有效性,就像验证一个官方签发的文件一样。验证通过后,支付就能顺利进行,并且整个过程都符合支付行业的安全标准。所以,这意味着未来你可以直接对着语音助手说“帮我买这个”,而不用担心支付安全问题,整个支付流程会更加顺畅和便捷。

如何使用它?

开发者可以将 VoicePayOS 集成到他们的语音助手产品中,特别是那些需要处理支付交易的场景。具体来说,可以在语音助手构建过程中,引入 OpenBotAuth 这个框架来管理支付助手的身份和密钥。当用户需要支付时,支付助手会生成一个包含支付信息的 HTTP 请求,并使用其 OpenBotAuth 密钥对其进行签名。这个带有签名的请求会发送给商户。商户端需要集成一个验证逻辑,通过调用 OpenBotAuth 提供的注册服务来获取支付助手的公钥,然后验证签名的合法性。一旦签名被验证通过,支付就能够安全地进行。开发者可以通过研究 OpenBotAuth 的 GitHub 仓库来了解具体的集成细节和 API 调用方式。所以,如果你正在开发一个需要支付功能的语音应用,VoicePayOS 提供了一种安全、合规、且用户体验更好的支付集成方案。

产品核心功能

· 语音助手购物车构建: 允许用户通过语音交互,让语音助手(如 Pete)智能地添加商品到购物车,简化了购物流程。这为你提供了一种更自然的购物方式,无需手动点击和搜索。

· 支付助手授权与支付: 引入独立的支付助手(如 Penny),负责确认订单总额并请求支付授权,提高了支付流程的专业性和安全性。这意味着支付过程更加规范,减少了误操作的可能性。

· HTTP 消息签名实现 (RFC 9421): 使用标准的 HTTP 消息签名技术,为支付请求生成数字签名,确保了支付请求的不可篡改和身份的真实性。这保证了你的支付信息在传输过程中不会被篡改,并且支付行为确实是你授权的。

· OpenBotAuth 注册与验证: 通过 OpenBotAuth 注册和管理支付助手的身份信息(公钥),并提供验证服务,让商户能够安全地验证支付请求的来源。这就像一个身份验证中心,确保了与你进行支付的助手是合法的,从而提升了整体支付的安全性。

· Visa TAP 风格的模拟支付: 集成了 Visa TAP 协议的模拟支付流程,展示了支付指令在真实支付生态中的运作方式,为开发者提供了参考和实验平台。即使这是模拟的,也让你看到了未来支付的趋势,并为实际集成提供了技术思路。

· 运行时签名与会话令牌: 能够在运行时提供一个签名的购物车或会话令牌,满足支付指令的合规性要求(如 SCA)。这意味着即使支付发生在语音交互中,也能满足严格的安全合规标准,让支付更加安心。

产品使用案例

· 在线零售商的语音助手集成: 假设一个在线零售商希望为用户提供更便捷的购物体验,他们可以将 VoicePayOS 集成到自家的语音助手。当用户通过语音说“我想买一件XXT恤”,语音助手就能添加到购物车,并在用户确认后,通过签名支付完成购买,无需离开语音交互界面。解决了用户需要在多个应用间跳转支付的繁琐问题。

· 企业级服务中的语音支付: 对于企业用户,可能需要通过语音命令来批准和支付某些服务费用。VoicePayOS 可以让企业内部的语音助手代表用户进行审批和支付,并生成合规的签名凭证,用于审计和记录。这简化了内部支付流程,并提高了效率和合规性。

· 金融服务领域的支付创新: 金融机构可以利用 VoicePayOS 来探索更智能的支付方式,例如,通过语音助手管理订阅服务或进行小额支付。通过数字签名确保了交易的安全性,并满足了监管要求。这为金融服务带来了新的技术应用方向,提升了用户体验。

· 呼叫中心场景下的安全支付: 在呼叫中心,客服人员可以通过语音引导用户完成支付。VoicePayOS 可以在此过程中,由语音助手代表用户生成签名的支付请求,避免了用户直接在电话中透露敏感支付信息,大大增强了支付的安全性。这解决了呼叫中心支付过程中信息泄露的风险。

38

WhisperFlow 开源版:你的AI语音交互新引擎

作者

imaka

描述

WhisperFlow 开源版是一个将大型语言模型(LLM)与语音识别(ASR)能力深度融合的开源项目。它巧妙地利用了 OpenAI 的 Whisper 模型强大的语音转文本能力,并将其与 LLM 的理解和生成能力相结合,实现了一种更自然、更智能的语音交互体验。这解决了传统语音助手反应迟钝、理解有限的问题,让AI能像人一样理解和回应你的话语。

人气

点赞 2

评论数 1

这个产品是什么?

WhisperFlow 开源版是一个开源的AI语音交互系统。它的核心技术是将Whisper模型(一个非常擅长将语音转换成文字的AI模型)和大型语言模型(LLM,就是像ChatGPT那样能够理解和生成文字的AI模型)结合起来。简单来说,它能听懂你说的每一个字,并且能理解你的意图,然后用智能的文字回应你。它不像以前的语音助手那样只能执行简单的指令,而是能进行更深入的对话和任务处理。这项技术的创新在于,它打通了语音输入和AI理解的整个链条,让AI真正地“听”懂并“思考”。所以这对我有什么用?这意味着你可以用更自然的方式与AI互动,就像和一个人聊天一样,AI能更好地理解你的复杂指令和问题,并给出更贴切的回答。

如何使用它?

开发者可以将WhisperFlow 开源版集成到自己的应用或服务中。你可以通过Python或其他编程语言调用其API,将用户录制的语音文件或实时音频流发送给WhisperFlow,它会返回AI理解后的文本以及AI生成的回应。例如,你可以在一个在线客服系统中集成它,让AI直接听懂用户的语音问题并给出解答;或者在智能家居设备中,让它响应更复杂的语音指令。技术上,你可以通过Docker部署,或者直接在Python环境中安装相关库来使用。所以这对我有什么用?你可以轻松地为你的产品添加强大的AI语音交互功能,提升用户体验,拓宽应用场景。

产品核心功能

· 语音到文本转换:利用Whisper模型,高精度地将各种口音和背景噪音的语音转换成文字。价值:确保AI能够准确理解用户输入,是后续所有智能处理的基础。应用场景:会议记录、语音笔记、内容创作辅助。

· 意图理解与上下文感知:将转换后的文本输入给LLM,让AI理解用户的真实意图,并能记住之前的对话内容。价值:AI不再是死板的机器,能够理解更复杂的语境和多轮对话。应用场景:智能客服、教育辅导、个人助理。

· 智能文本生成与回应:LLM根据用户意图和上下文生成自然流畅的文本回复。价值:提供人性化的交互体验,AI的回应更具信息量和实用性。应用场景:内容创作、信息查询、个性化推荐。

· 灵活的API接口:提供易于集成的API,方便开发者将其嵌入现有系统。价值:降低开发门槛,快速实现AI语音交互功能。应用场景:Web应用、移动App、桌面软件、嵌入式设备。

产品使用案例

· 场景:一个需要处理大量客户语音咨询的在线客服平台。使用:集成WhisperFlow,AI可以直接听懂客户的语音问题,理解客户遇到的困难,并通过LLM生成针对性的解决方案回复。解决问题:大大提高了客服效率,降低了人工成本,让客户无需打字就能获得帮助。

· 场景:一个需要进行深度学习的教育App。使用:学生可以通过语音向AI提问,WhisperFlow能理解学生的问题并提供详细的解释,甚至可以通过对话引导学生思考。解决问题:提供了更加个性化和互动式的学习体验,让学习过程更生动有趣。

· 场景:一个智能家居控制系统。使用:用户可以通过自然语音控制家里的电器,如“小爱同学,帮我把客厅的灯调暗一点,然后播放我喜欢的音乐”。WhisperFlow能准确识别指令并执行。解决问题:提升了智能家居的便捷性和用户体验,让操作更加人性化。

39

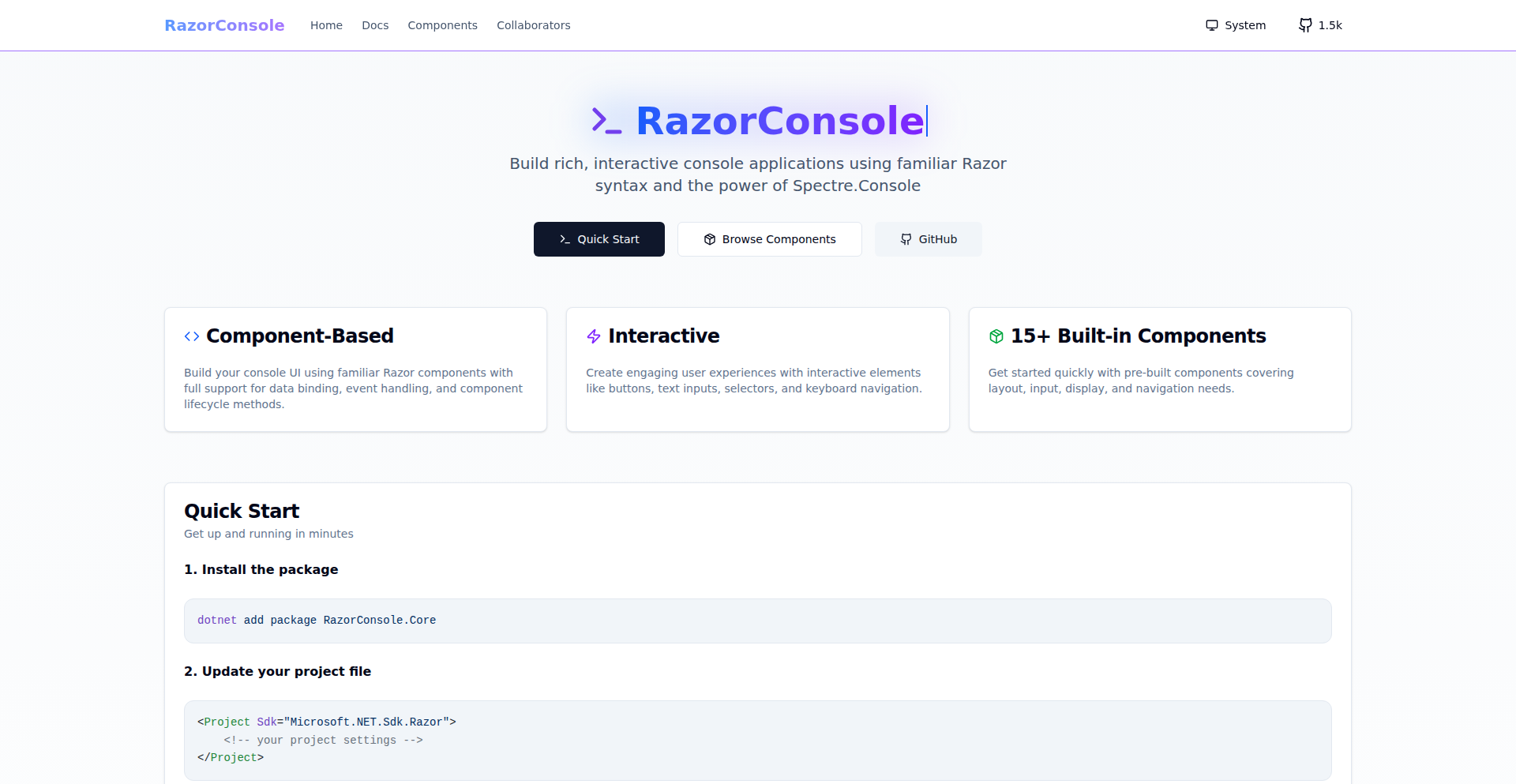

RazorTermUI

作者

BigBigMiao

描述

RazorTermUI 是一个创新的库,它允许开发者使用熟悉的 Razor 组件语法来构建交互式的终端应用程序,并将这些组件渲染到 Spectre.Console 中。它借鉴了 React Ink 的思想,提供了一种声明式、可组合的 UI 构建方式,让终端应用的用户界面开发变得像构建 Web 应用一样直观,解决了在终端环境下创建复杂、动态用户界面的痛点。

人气

点赞 3

评论数 0

这个产品是什么?

RazorTermUI 是一个技术库,它让你能够用写 Web 界面(比如 Blazor 或 Razor Pages)的方式来写命令行工具的用户界面。它把你在 Web 开发中常用的组件化、声明式(就是你只需要告诉它‘我想要什么’,而不是‘怎么一步步做’)的思路带到了终端应用里。想象一下,你可以像写 HTML 和 C# 一样,用 Razor 语法来设计你的命令行工具的菜单、表格、提示框等等,然后这些设计会被 Spectre.Console 这个强大的工具渲染成漂亮的终端界面。最核心的创新在于,它把 Web UI 的组件化模型和终端应用的交互结合起来,让开发者不再需要用底层的、命令式的代码来一点点绘制终端内容,而是可以专注于 UI 的逻辑和结构。

如何使用它?

开发者可以通过引入 RazorTermUI 库到他们的 .NET 项目中来使用。首先,你需要安装 Spectre.Console 相关的 NuGet 包。然后,你可以创建一个 Razor 组件(`.razor` 文件),就像你在 Blazor 应用中那样,用 Razor 语法来定义你的终端 UI 元素,比如按钮、输入框、列表等。这些组件可以直接包含 C# 代码来处理逻辑。最后,你使用 RazorTermUI 提供的 API,将这些 Razor 组件渲染成 Spectre.Console 的可渲染对象,并显示在终端上。这就像是在你的命令行应用中嵌入了一个微型的 Web UI 框架。

产品核心功能

· 使用 Razor 组件定义终端 UI:开发者可以用熟悉的 Razor 语法(HTML + C#)来编写交互式终端的用户界面,这意味着你可以利用现有的 Web UI 开发经验来构建命令行工具,大大降低了学习成本,所以这对我来说,意味着我可以用更少的时间和精力,来创造更美观、功能更丰富的终端应用。

· 声明式 UI 构建:如同 React 或 Blazor 一样,你可以声明式地描述你的 UI 状态,而库会负责更新终端显示,而不是让你手动管理屏幕上的每个字符。这极大地简化了 UI 开发,减少了出错的可能性,所以这对我来说,意味着我可以更专注于应用的业务逻辑,而不是纠结于如何更新终端屏幕上的文字。

· 组件化和可组合性:你可以将 UI 拆分成小的、可复用的组件,就像搭积木一样构建复杂的界面。这提高了代码的可维护性和可重用性,所以这对我来说,意味着我可以更高效地开发,并且更容易维护和扩展我的命令行工具。

· 与 Spectre.Console 集成:RazorTermUI 将 Razor 组件渲染成 Spectre.Console 的渲染对象,利用了 Spectre.Console 强大的终端渲染能力,可以生成丰富的视觉效果。所以这对我来说,意味着我的终端应用不仅可以交互,还可以拥有令人印象深刻的视觉表现。

· 状态管理和响应式更新:当你的组件状态改变时,UI 会自动更新,保持终端显示与应用状态同步。这使得构建动态、实时的终端应用成为可能,所以这对我来说,意味着我可以创建更具响应性和用户友好的终端工具。

产品使用案例

· 构建交互式数据可视化仪表盘:在终端中展示实时更新的图表、表格和统计数据,例如监控服务器状态、网络流量等。这在需要远程访问或在没有图形界面的环境中操作时非常有用,解决的问题是:如何在终端环境中提供比纯文本更丰富、更动态的信息展示。

· 创建复杂的命令行配置工具:设计一个带有菜单、表单、进度条和确认提示的配置向导,让用户可以通过友好的界面来配置软件或系统。解决的问题是:如何让命令行工具的用户体验不再是枯燥的命令行输入,而是像使用图形界面一样便捷。

· 开发终端游戏或益智应用:利用其声明式 UI 和组件化的特性,构建可以在终端中运行的简单游戏,如文本冒险、棋盘游戏等。解决的问题是:如何突破终端应用的传统限制,创造更多娱乐性和趣味性的应用场景。

· 实现交互式代码检查或辅助工具:开发一个能够实时分析代码、提供反馈和建议的终端工具,用户可以通过交互式界面进行选择和操作。解决的问题是:如何提升开发者在命令行环境下的工作效率,提供更智能、更便捷的代码辅助。

· 构建可定制化的终端任务管理器:允许用户通过选择、编辑和执行任务来管理系统进程或自动化工作流,并提供可视化的反馈。解决的问题是:如何让用户更直观、更灵活地管理和控制复杂的系统任务。

40

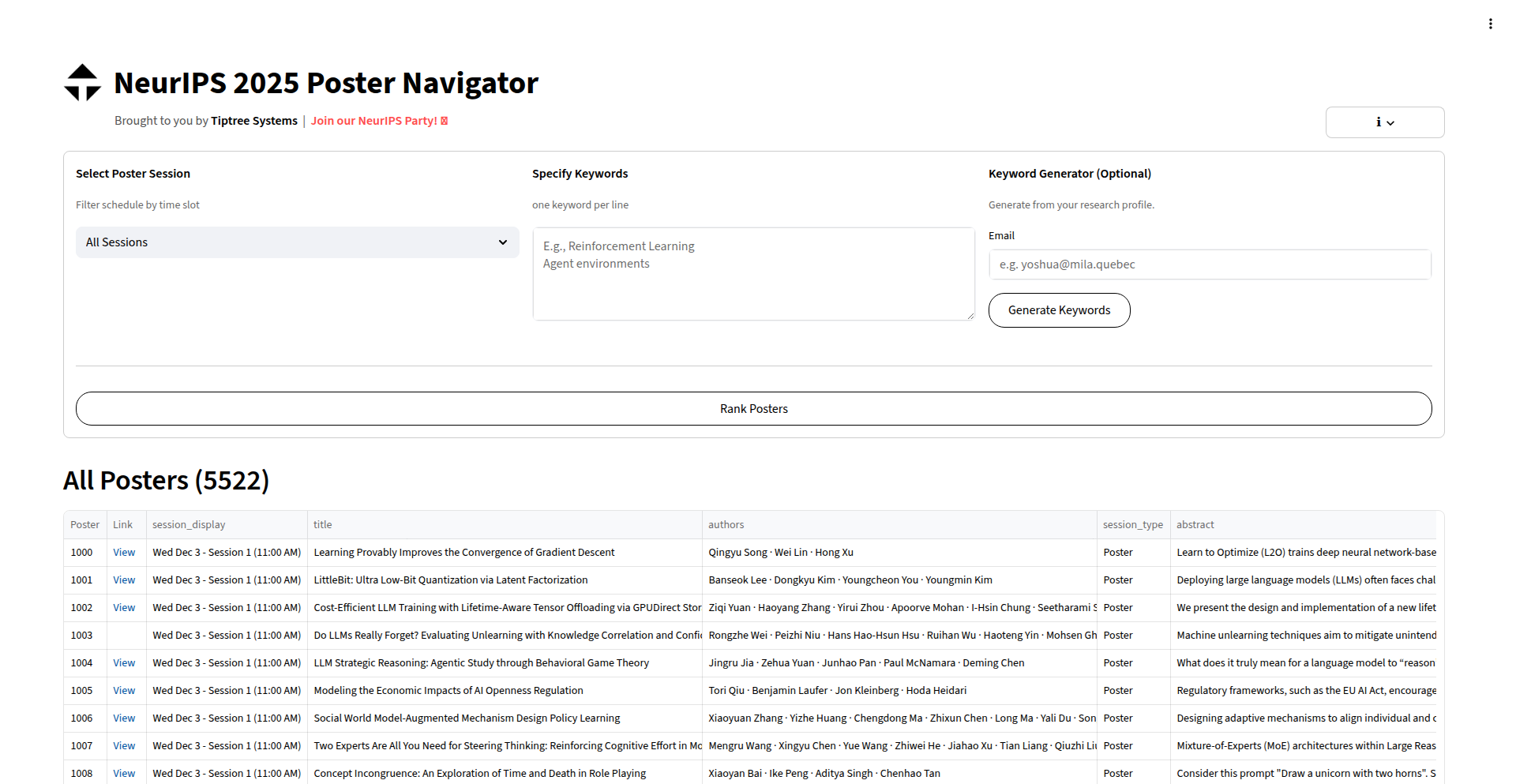

AI赋能的NeurIPS海报导航仪

作者

martincsweiss

描述

这是一个利用AI技术(Codex、Gemini-CLI、Claude Code)快速构建的Web应用,旨在解决大型学术会议(如NeurIPS 2025)海量海报信息难以查找的问题。它通过解析研究领域、关键词等信息,帮助用户高效定位感兴趣的学术海报,大大提升了参会者的信息获取效率。

人气

点赞 3

评论数 0

这个产品是什么?

这是一个由AI辅助开发的、用于导航大型学术会议海报的应用。传统会议海报查找通常需要翻阅冗长的下拉列表,效率极低。本项目通过集成大型语言模型(LLM)的能力,能够理解海报的内容标签(如研究领域、关键词),并提供智能搜索和过滤功能。创新点在于,它快速复用了现有AI模型(Codex、Gemini-CLI、Claude Code)的强大文本处理和理解能力,以极短的开发时间(仅几个小时)实现了原本可能需要复杂NLP工程才能解决的问题。所以这对我有什么用?它能让你在海量学术信息中,迅速找到你真正关心的研究内容,节省宝贵的时间。

如何使用它?

开发者可以通过访问项目提供的Web界面,输入你感兴趣的研究领域、关键词或论文作者名。应用会利用AI对NeurIPS 2025的海报数据进行分析和匹配,生成一个经过筛选和排序的列表,直接展示最相关的海报信息。集成方式上,由于是Web应用,用户可以直接通过浏览器访问,无需任何安装或配置。如果需要将此能力集成到其他系统中,可以考虑通过API调用(如果项目后续开放的话)。所以这对我有什么用?你可以将它作为一个高效的工具,在会议期间快速找到你想深入了解的海报,或者提前规划你的参会路线。

产品核心功能

· 智能海报搜索:利用AI模型理解用户输入的关键词,匹配海报的标题、摘要等信息,找出最相关的海报。价值是能够超越简单的文本匹配,理解语义,找到隐藏关联。应用场景是快速找到特定主题或作者的海报。

· 按研究领域过滤:允许用户选择特定的研究领域(如机器学习、计算机视觉等),仅展示属于该领域的海报。价值是能够缩小搜索范围,聚焦特定方向。应用场景是学术研究者筛选特定学科的海报。

· 关键词高亮和关联:在搜索结果中,可能对匹配的关键词进行高亮显示,并提供相关关键词的建议。价值是增强用户对海报内容的感知,并引导进一步探索。应用场景是用户在浏览结果时,快速把握海报的核心内容。

· 免注册和免费使用:无需用户注册,直接提供服务。价值是降低使用门槛,保护用户隐私。应用场景是任何人都可以随时随地使用,无需顾虑信息泄露。

产品使用案例

· 作为一名参加NeurIPS 2025的参会者,我需要在短时间内了解大量前沿研究。使用这个导航仪,我输入“Transformer模型在NLP中的应用”作为关键词,它立刻为我筛选出了十几个相关的海报,我可以直接点击链接查看海报详情,而不用在茫茫的下拉列表中耗费时间。

· 作为一名对特定研究方向(例如:图神经网络)感兴趣的研究员,我可以在导航仪中选择“图神经网络”作为研究领域,并输入我关注的几个顶级实验室的名称,它能快速帮我汇总这些实验室在该领域的所有 poster,极大地节省了我逐一查找的时间。

· 一位新的研究者,不熟悉NeurIPS会议的细分领域,但他知道自己对“可解释AI”感兴趣。他可以将“可解释AI”作为关键词输入,导航仪通过AI的理解能力,不仅能找到直接包含该关键词的海报,还能找到与之相关的、使用不同术语表达同一概念的海报,帮助他发现更多潜在的优质内容。

41

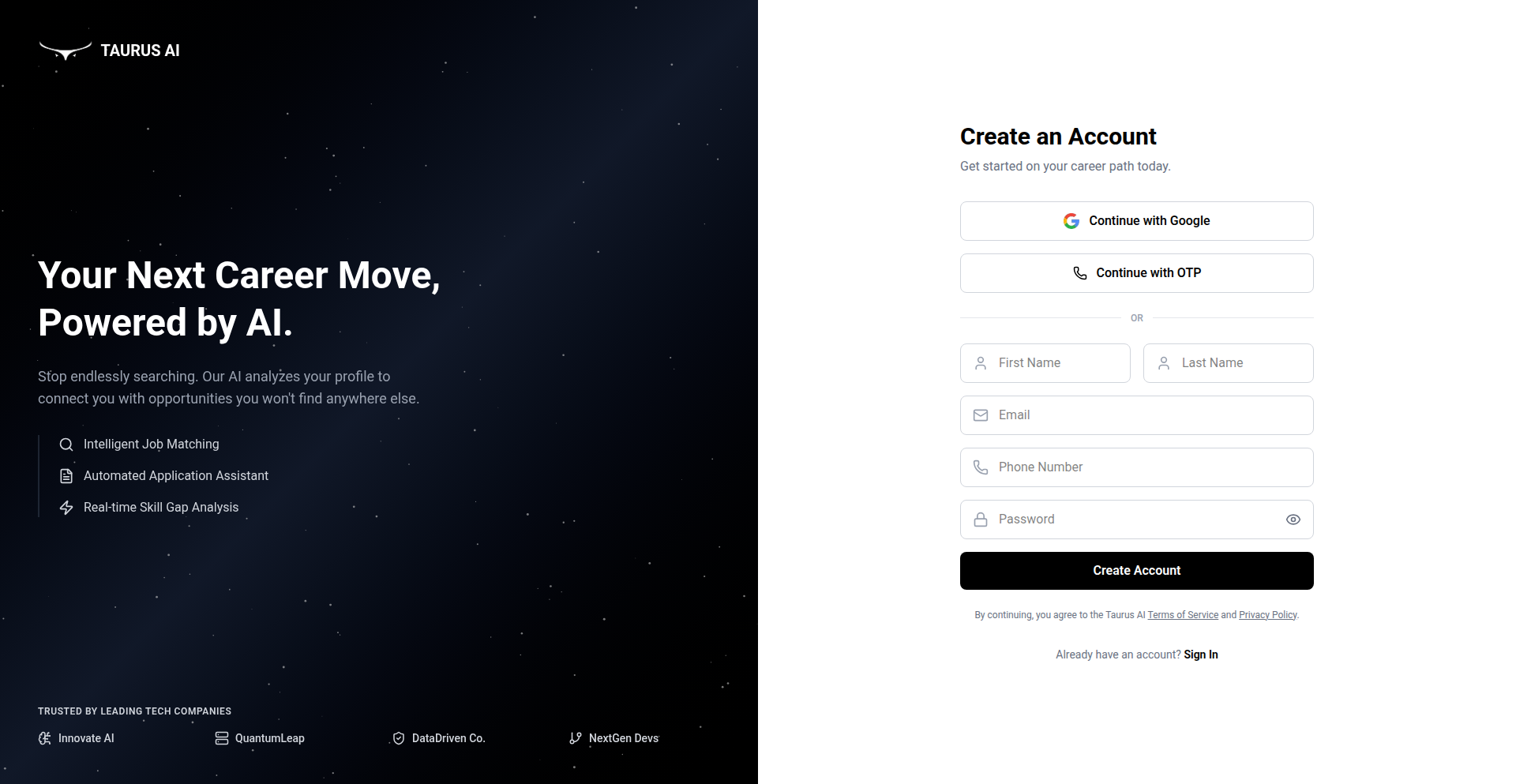

AI智能匹配简历重塑引擎

作者

taurusai

描述

该项目利用AI技术,能够根据你申请的具体职位要求(Job Description),在几秒钟内为你生成一份高度定制化的简历。它特别优化了以满足招聘人员和ATS(申请人追踪系统)的筛选需求,解决了传统简历千篇一律、难以突出重点的问题,极大地提高了简历被关注和通过初筛的几率。

人气

点赞 2

评论数 0

这个产品是什么?

这是一个基于人工智能的简历生成和优化工具。它的核心技术在于运用自然语言处理(NLP)和机器学习算法,能够深入理解你申请职位描述(JD)中的关键词、技能要求、经验重点,然后分析你现有的简历信息,智能地提取、重组和润色内容,生成一份能够最大程度匹配目标职位、更容易通过ATS筛选且吸引招聘官注意力的简历。简单来说,就是AI帮你把你的经历“翻译”成招聘方最想看到的语言。

如何使用它?

开发者可以通过访问Taurus AI提供的在线平台或API接口来使用。上传你个人的基础简历信息(可能包括工作经历、教育背景、项目经验、技能列表等),然后输入你想要申请的职位的Job Description。系统会即时处理,并输出一份经过优化的、针对该职位的定制简历。这可以集成到求职流程中,让你在每次申请新职位时,都能快速获得一份“量身定制”的简历,省去了大量手动修改和优化的时间。

产品核心功能

· AI驱动的JD语义分析:通过NLP技术精准捕捉职位描述中的核心技能、职责和期望,让你明白招聘方到底要什么,从而知道往简历上写什么。

· 智能简历内容匹配与重组:根据JD分析结果,自动从你的现有信息中提取最相关的经验和技能,并以最有利的方式呈现,确保简历内容直接击中痛点。

· ATS优化规则适配:理解ATS的工作原理,调整简历的格式、关键词密度和布局,使其更容易被ATS系统识别和评分,减少简历被机器筛掉的风险。

· 个性化语言风格调整:AI能够根据JD的语气和行业特点,调整简历的表述风格,让简历更显专业和贴合,提升招聘官的第一印象。

· 实时生成与快速迭代:在几秒钟内即可生成定制简历,方便求职者快速响应招聘信息,并支持多次迭代优化,直到满意为止。

产品使用案例

· 场景:软件工程师申请一个强调特定后端框架(如Rust、Go)和云服务(如AWS、GCP)的高级职位。问题:手动将自己零散的项目经历和技能转化为与JD高度匹配的描述非常耗时且效果不佳。Taurus AI:输入JD,AI自动从工程师的现有信息中提取相关的Rust/Go项目经验和AWS/GCP使用实例,并以量化的方式(如果可能)或清晰的职责描述呈现,显著提高简历通过ATS和初步筛选的几率。

· 场景:市场营销专员申请一个需要社交媒体营销和数据分析经验的职位。问题:原简历可能只泛泛提及“社交媒体推广”,无法体现具体成果和数据。Taurus AI:AI能识别JD中对“ROI提升”、“用户增长”等关键词的要求,并引导用户或从已有信息中挖掘与这些目标相关的具体案例和数据,生成一份更具说服力的营销成果报告式简历。

· 场景:应届毕业生申请一份需要一定实习经验的入门级职位。问题:缺乏直接相关经验,但有校内项目或社团活动经历。Taurus AI:AI能够识别JD中对“团队合作”、“项目管理”、“解决问题能力”等软技能的要求,并从学生的校内项目、课程设计或社团活动经历中提取相符的亮点,将其转化为招聘方看重的能力证明,弥补经验上的不足。

42

WebPage2Vid: 网页视频导出黑客工具

作者

markjivko

描述

这是一个本地化的网页转视频工具,能将任意网页变成一段视频,支持AV1或H264编码,并能自定义帧率、滚动速度,甚至能在macOS上保持设备像素比。这解决了直接截图或录屏无法完美展示网页动态效果和交互的问题,非常适合制作网站演示、个人作品集、竞品分析和营销内容。

人气

点赞 2

评论数 0

这个产品是什么?

WebPage2Vid 是一个能够让你在自己的电脑上,将任何一个网页内容直接转换成视频文件的技术工具。它的核心技术在于模拟浏览器渲染和滚动过程,然后将这些画面捕捉下来,并以视频格式(支持AV1和H264这两种高效的视频编码方式)输出。创新的地方在于它能让你精细控制视频的‘播放速度’(滚动速度)和‘流畅度’(帧率),甚至能在苹果电脑上完美还原网页的精细度。这比传统的屏幕录制更可控,更专业。

如何使用它?

开发者可以通过集成这个模块到自己的项目中,或者作为一个独立的命令行工具来使用。你可以把它想象成一个‘高级截图’工具,但它生成的是动态视频。例如,你可以写一段代码,让它自动访问你的网站,然后导出一段高质量的演示视频,无需手动操作录屏软件。它的配置是可视化的(YAML文件),方便你调整参数,实现‘让网页动起来’的效果。

产品核心功能

· 将任意网页导出为视频:这意味着你可以把任何一个你访问过的网页,无论是有交互的动态页面还是静态展示页,都能变成一段视频。解决了‘只看图说不清’的问题,可以直接用视频展示功能。

· 支持AV1和H264视频编码:AV1和H264是目前非常先进和高效的视频编码格式,它们能在保证视频清晰度的同时,让视频文件变得更小,传输和存储都更方便。这意味着你导出的视频既清晰又‘轻巧’。

· 自定义帧率:帧率决定了视频的流畅度,你可以根据需求调整。比如,慢动作演示时可以用低帧率,追求丝滑效果时可以用高帧率。这让你能精确控制视频的‘观感’。

· 自定义滚动速度:你可以设定网页滚动的速度,让视频更具表现力。比如,你可以让它快速滚动展示大量内容,或者缓慢滚动详细介绍某个部分。让视频内容展示更富于变化。

· macOS设备像素比导出:对于macOS用户来说,这个功能非常棒,它能确保视频完美还原网页在高清屏幕上的细节,避免模糊不清,让你的作品看起来更专业、更精致。

产品使用案例

· 网站演示视频制作:假设你开发了一个新网站,想要快速制作一段演示视频给客户看,你可以直接用WebPage2Vid导出,比录屏更省事,而且视频更稳定。解决了‘反复录屏,效果不佳’的痛点。

· 个人作品集展示:作为开发者,你可以在个人网站或作品集中嵌入用WebPage2Vid导出的项目演示视频,比纯文字和截图更能生动地展示你的技术能力和项目成果。解决了‘静态展示,缺乏吸引力’的问题。

· 竞争对手分析:你需要快速研究竞争对手的网站,并记录其特点。WebPage2Vid可以让你快速导出对方网站的视频,方便对比分析。解决了‘手动记录,效率低下’的挑战。

· 用户体验测试记录:在进行UI/UX测试时,可以用它来记录用户操作流程中的具体问题,生成的视频能清晰展示问题发生的场景和过程,方便开发团队复盘。解决了‘录屏文件过大,不易查找问题’的困扰。

· 营销推广素材生成:如果你需要为产品制作短视频广告,可以将网页上的产品信息、用户评价等动态内容导出成视频,用于社交媒体推广。解决了‘制作营销视频,技术门槛高’的难题。

43

CodeProt 智能降噪代码审查助手

作者

allenz_cheung

描述

CodeProt 是一个利用人工智能(AI)技术,专门为开发者设计的代码审查工具。它能够智能地识别和过滤掉代码审查过程中不重要的、干扰性的信息(也就是“噪音”),从而显著提高审查的准确性,让开发者能更专注于真正关键的问题。这解决了传统代码审查中信息过载、效率低下的痛点。

人气

点赞 1

评论数 1

这个产品是什么?

CodeProt 是一个基于AI的代码审查工具,它运用了自然语言处理(NLP)和机器学习(ML)等AI技术。它的核心创新在于,它不是简单地查找代码中的错误,而是通过学习大量的代码和审查数据,去理解代码的意图和上下文,从而分辨出哪些是真正需要关注的潜在问题(比如安全漏洞、性能瓶颈),哪些只是风格上的小瑕疵或者不影响大局的低优先级提示。这样一来,开发者在审查代码时,就能收到更精准、更少干扰的反馈,大大提升了审查的效率和质量。所以,它能让你在代码审查时,快速抓住重点,不再被海量不重要的提示淹没。

如何使用它?

开发者可以将CodeProt集成到现有的开发工作流中,例如通过Git钩子(Git hooks)或CI/CD(持续集成/持续部署)流程。当代码提交或合并时,CodeProt会自动运行,对新提交的代码进行AI分析,并将审查结果(高精度的潜在问题列表)反馈给开发者。你可以把它想象成一个非常聪明的“代码体检医生”,在你提交代码时,它会快速帮你检查出身体(代码)里最需要关注的“病灶”。所以,它能无缝融入你的开发节奏,让你在写完代码后,就能立刻得到一个高质量的“健康报告”。

产品核心功能

· AI驱动的智能降噪:利用机器学习模型,精准识别代码中的潜在问题,过滤掉低价值的提示,让审查更高效。所以,它让你在审查代码时,直接看到最重要的问题,节省你的时间。

· 高精度问题检测(94%):通过大量数据训练,确保发现的问题具有高相关性和准确性,减少误报,避免不必要的返工。所以,它能帮你避免因为误报而浪费精力去修改不重要的问题。

· 上下文感知分析:理解代码的逻辑和意图,进行更深层次的代码审查,发现隐藏的bug和风险。所以,它能帮你发现那些不容易被肉眼发现的深层代码隐患。

· 开发流程集成:支持与Git、CI/CD工具集成,实现自动化代码审查,提升团队协作效率。所以,它能自动帮你审查代码,让你的团队开发更顺畅。

产品使用案例

· 在敏捷开发周期中,开发者提交了一个新功能。CodeProt能够快速审查代码,并准确指出其中一个潜在的性能瓶颈,避免了该问题在上线后才被发现。所以,它能帮你更快地迭代产品,同时保证代码质量。

· 一个大型项目,团队成员众多,代码风格各异。CodeProt能够统一审查标准,过滤掉大量风格提示,只突出显示关键的安全漏洞,大大减轻了项目负责人的审查压力。所以,它能让多人协作开发的项目,管理起来更轻松。

· 修复一个棘手的bug后,开发者担心引入新的问题。CodeProt能够对其修复的代码进行审查,并确认没有引入新的风险,让开发者安心地将修复合并。所以,它能让你在修改代码时,更有信心,减少不确定性。

44

AI智囊团 (CSuite.Now)

作者

intabli

描述

CSuite.Now 是一个创新的AI驱动平台,它能即时为你提供12位具备不同专业背景的AI高管顾问,帮助企业解决战略、运营等难题,无需雇佣、无需等待,极大地提升了领导力容量,降低了成本。

人气

点赞 2

评论数 0

这个产品是什么?

这是一个利用人工智能技术模拟高管团队的项目。它不是真的雇佣人类高管,而是通过复杂的AI算法,让AI扮演CEO、CFO、CTO等不同角色的高管,并能根据你提出的问题,给出专业的商业洞察和建议。其创新之处在于,它能够实时访问并整合多位AI高管的知识和经验,形成一个全方位的咨询团队,解决企业在快速发展过程中遇到的复杂问题,这比传统咨询公司或内部团队响应更快,成本更低。

如何使用它?

开发者或企业管理者可以通过CSuite.Now的在线平台,输入遇到的商业挑战或战略问题。AI高管团队会根据问题的性质,协同分析并给出多角度的建议。例如,你可以询问关于市场扩张策略、产品定价模型、技术栈选择、融资方案等问题。平台会根据你选择的AI高管组合,提供定制化的解决方案。你可以把它想象成一个24/7随时待命的、拥有各领域专家头脑的顾问团。

产品核心功能

· 即时AI高管咨询:通过AI模拟不同领域的高管,随时提供商业策略和决策建议,解决了传统咨询服务等待时间长、成本高的问题,让你立刻获得专家级的指导。

· 多维度战略分析:AI高管团队协同工作,从不同视角(财务、技术、市场、运营等)分析问题,提供更全面、更深入的解决方案,帮助你规避风险,抓住机遇。

· 成本效益领导力扩展:无需雇佣昂贵的高管人才,利用AI即可获得同等甚至更高级别的战略支持,极大地降低了企业在人才上的投入,释放更多资源用于核心业务。

· 动态问题解决:AI能够快速响应并学习新信息,针对企业不断变化的需求提供实时、动态的解决方案,保持企业竞争力。

· 知识整合与洞察:整合海量商业知识库和实践经验,AI高管能够提供基于数据和趋势的精准洞察,为你的决策提供强有力的数据支持。

产品使用案例

· 一家初创公司在考虑进入新市场,但不确定市场规模、竞争格局和最佳进入策略。通过CSuite.Now,他们可以咨询AI的CEO、CMO和CTO,获取关于市场研究、潜在进入风险、产品定位和技术可行性的详细建议,从而制定出更可靠的市场进入计划。

· 一家成熟企业面临供应链中断的风险,需要快速评估影响并制定应对方案。他们可以向AI的COO和CFO咨询,分析供应链的脆弱性、制定替代供应商方案、预测财务影响,并快速做出调整,保障业务连续性。

· 一家科技公司在选择下一代技术栈时遇到分歧,需要权衡不同方案的优劣。他们可以向AI的CTO咨询,了解不同技术的优缺点、集成难度、长期维护成本和对产品发展的影响,从而做出明智的技术决策。

45

Play.code AI 浏览器编码工作站

作者

ianberdin

描述

这是一个无需安装、在浏览器中就能使用的AI编程助手,它可以帮助开发者快速编写代码、自动化任务、创建网页原型等。它集成了市面上多种先进的AI模型,并支持多文件编辑,让编程变得更便捷高效,特别适合学习、原型开发和业务自动化。

人气

点赞 1

评论数 1

这个产品是什么?