Show HN Today: Discover the Latest Innovative Projects from the Developer Community

ShowHN Today

ShowHN TodayShow HN 今日精选:2025-10-01最热门的开发者项目展示

SagaSu777 2025-10-02

探索2025-10-01 Show HN上最热门的开发者项目,包括创新技术、AI应用等激动人心的新发明。深入了解这些引人注目的项目!

今日内容汇总

趋势洞察

今天的Show HN展示了一个充满活力的技术创新图景,核心亮点是AI和LLM技术的深度渗透与应用。开发者们正以前所未有的创造力,将AI从单纯的聊天机器人,发展为能够解决特定行业难题、优化开发流程、甚至模拟复杂人类体验的强大工具。特别值得关注的是,许多项目正致力于解决AI的效率、成本和可控性问题,例如通过缓存、模型路由、本地化部署等方式,让AI应用更加普惠和可靠。同时,AI与数据、特定领域(如数据库设计、硬件开发、甚至模拟自闭症体验)的结合,预示着AI的未来将更加专业化和场景化。对于开发者和创业者而言,这意味着巨大的机会:深入理解AI的最新进展,并将其与垂直领域的痛点相结合,就能创造出极具价值的产品。黑客精神体现在,不畏艰难,用代码和算法去解决那些看似不可能的问题,将复杂的概念转化为易于理解和使用的工具。敢于尝试,大胆创新,将是抓住未来技术浪潮的关键。

今日最热门产品

名称

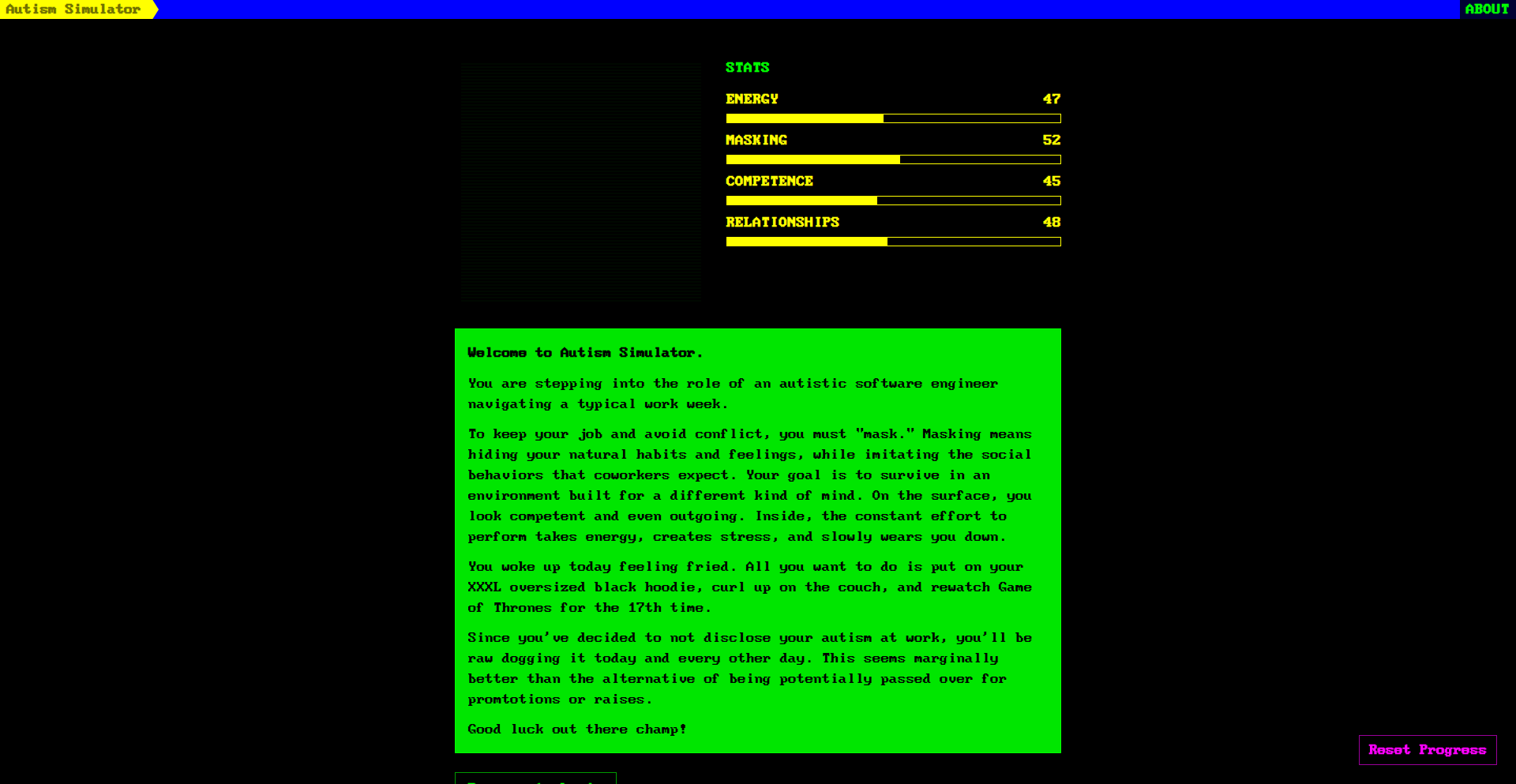

Autism Simulator

亮点

该项目通过模拟现实生活中的经验,以一种非直接的方式(通过选择和统计数据)来展示“掩饰”(masking)、“决策疲劳”(decision fatigue)和“倦怠”(burnout)等与自闭症相关的日常挑战。它创新地将抽象的体验具象化,让开发者可以学习到如何利用交互和数据可视化来传达复杂的、非言语性的感受,从而增进对他人的理解和同理心。

热门类别

AI/LLM

Developer Tools

Productivity

Open Source

热门关键字

AI

LLM

Open Source

Developer Tools

Productivity

Automation

Data

技术趋势

AI驱动的开发工具

个性化AI体验

LLM的效率与成本优化

AI在特定领域的应用

开发者生产力工具

本地化和隐私保护AI

数据交互与可视化

项目分布

AI/LLM (40%)

Developer Tools (25%)

Productivity (15%)

Data & Analytics (10%)

Open Source (5%)

Other (5%)

今日热度产品榜单

| 排名 | 产品名称 | 点赞数 | 评论数 |

|---|---|---|---|

| 1 | 共情模拟器:自闭症体验展 | 612 | 688 |

| 2 | AI数据库结构设计助手 | 115 | 35 |

| 3 | Butter: LLM 记忆缓存代理 | 22 | 11 |

| 4 | Resterm:终端里的全能API调试器 | 25 | 1 |

| 5 | Alloy Automation MCP - 智能系统连接器 | 9 | 5 |

| 6 | Go-FSST: 飞速静态符号压缩引擎 | 12 | 2 |

| 7 | 硬件上下文层 | 14 | 0 |

| 8 | AI 赋能的智能漏洞挖掘器 | 10 | 1 |

| 9 | 光年引擎 | 6 | 4 |

| 10 | Ocrisp: 一键式RAG落地工具 | 9 | 0 |

1

共情模拟器:自闭症体验展

作者

joshcsimmons

描述

一款基于个人和社区经验构建的模拟器,通过互动选择和统计数据,直观展现自闭症谱系人群在日常生活中可能遇到的“伪装”(masking)、“决策疲劳”(decision fatigue)和“职业倦怠”(burnout)等体验。其核心创新在于将难以言喻的内心感受和行为模式,转化为开发者和普通大众能够通过技术交互理解和共情的具象化过程。

人气

点赞 612

评论数 688

这个产品是什么?

这个项目是一个名为“共情模拟器”的在线工具,它不是一个严格意义上的“游戏”,而是通过模拟自闭症谱系人群在日常生活中的一些典型挑战来增进理解。它的技术原理在于构建了一个状态机(state machine),用户在模拟器中会面临一系列选择,每个选择都会影响到用户的“精力值”、“社交压力值”等隐藏状态。 最终,这些状态会以可视化的图表或统计数据呈现出来,展示例如“伪装”行为(在社交场合中假装符合他人预期)消耗了多少精力,或者“决策疲劳”如何导致选择困难。 其创新之处在于,它用代码和数据驱动的方式,将自闭症谱系人群常常难以用语言清晰表达的内部感受,转化成一种可量化、可交互的体验,让没有亲身经历过的人,也能“看”懂、“感觉”到这些挑战。 这是一种用技术“讲故事”和“传递共情”的独特方式。

如何使用它?

开发者可以通过 Web 浏览器直接访问此模拟器。 在技术集成上,它本质上是一个前端应用,可能使用了 JavaScript 来处理交互逻辑和状态管理,以及一些数据可视化库(如 Chart.js 或 D3.js)来展示统计结果。 普通用户可以理解为,就像玩一个简单的选择题游戏,选择你认为最合适的应对方式,然后看看结果。 对于希望在产品设计、人机交互、团队管理等方面提升包容性的开发者或团队而言,可以将这个模拟器的设计思路借鉴到他们的工具中,例如设计更能减少决策疲劳的界面,或者创建更能支持有不同沟通需求的用户的功能。

产品核心功能

· 状态模拟引擎:根据用户的选择,动态调整用户的“精力”、“社交压力”、“感官负荷”等核心状态参数,背后是用代码逻辑模拟真实世界中一系列复杂因素的影响,让用户感受到不同选择带来的直接后果。

· 情境选择界面:呈现一系列描述性的场景和多项选择,每个选项都基于真实经历,用户需要做出判断,这种交互设计让理解过程变得生动有趣,就像在做一场“人生模拟”,但聚焦于特定人群的挑战。

· 可视化数据呈现:将模拟过程中累积的状态数据,以图表(如精力消耗曲线、决策树等)的形式直观展示,让抽象的“伪装”、“疲劳”等概念变得具体可感,帮助用户量化理解这些体验的强度和影响。

· 经验分享和迭代机制:项目作者积极收集用户反馈,并据此不断调整模拟器的内容和逻辑,这体现了黑客精神中“快速迭代、社区驱动”的特点,使得模拟器能更准确地反映现实。

· 共情教育模块:通过直观的模拟体验,帮助用户理解自闭症谱系人群在日常互动和工作中可能面临的困难,从而促进同理心和包容性的提升,这是一个用技术实现社会价值的典范。

产品使用案例

· 在设计用户界面时,团队成员可以运行模拟器,体验在信息过载或强迫性社交要求下,用户可能出现的“决策疲劳”和“感官超载”,从而更有针对性地设计简洁、直观、可自定义的界面。

· 一位产品经理在规划团队协作工具时,可以模拟“伪装”行为对个体精力的消耗,从而反思如何设计更少社交压力、更鼓励真实表达的沟通机制,以减少团队成员的“隐藏成本”。

· 一位HR在培训新员工时,可以引导大家体验模拟器,理解不同人在面对社交场合或高强度工作时的不同反应,以此促进团队成员之间的相互理解和支持,营造更具包容性的工作环境。

· 一位技术作者在撰写关于可访问性(accessibility)的文章时,可以引用模拟器的案例,说明一些看似微小的设计改动(如减少闪烁的动画、提供清晰的指令),对有特定需求的用户来说,能显著降低他们的“感官负荷”和“认知负担”。

· 一位独立开发者在构建自己的在线工具时,可以借鉴模拟器中状态机和可视化反馈的设计思路,将其应用于自身的项目,例如为用户提供关于其操作行为的“成本”或“收益”可视化,从而帮助用户更好地管理他们的数字生活。

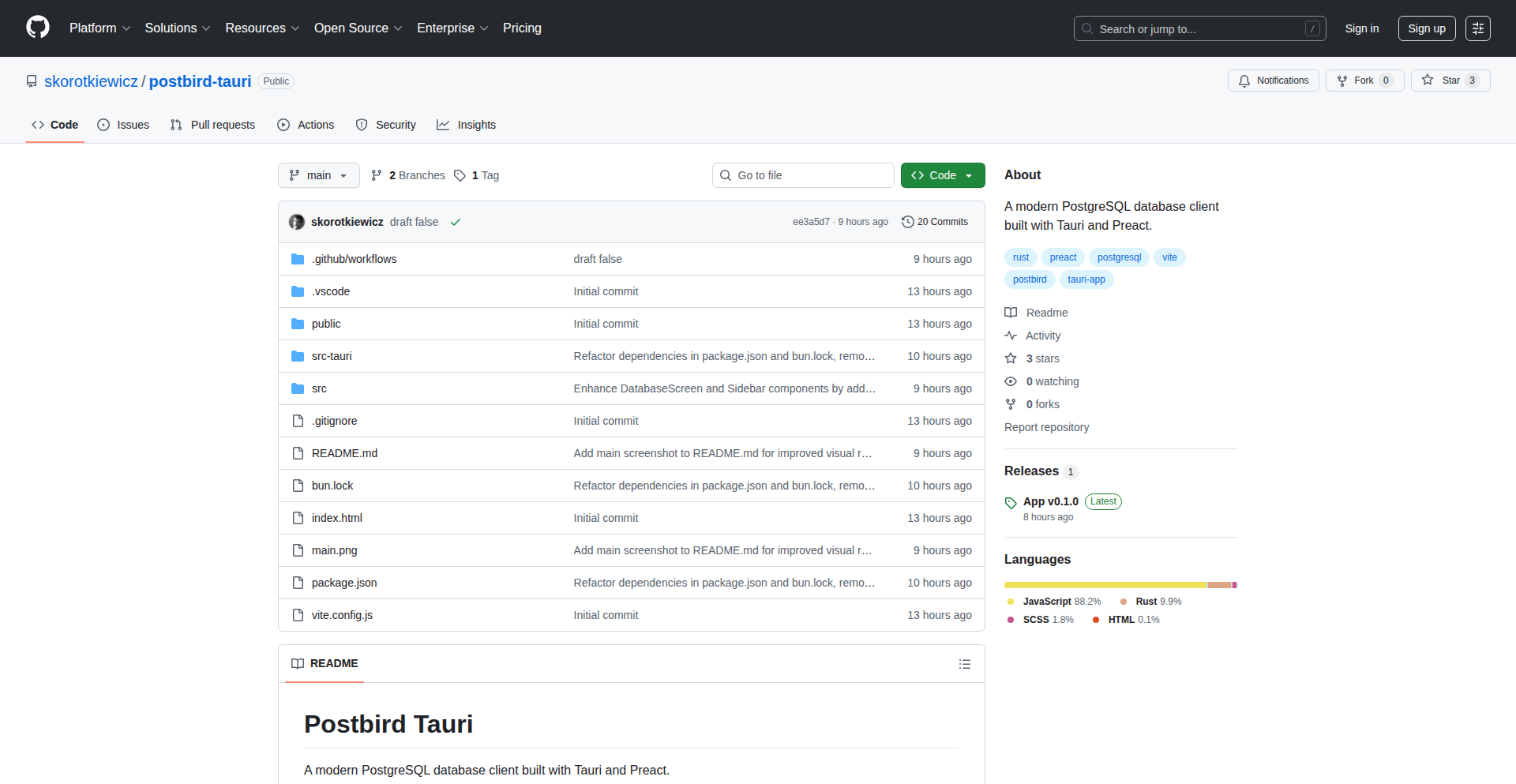

2

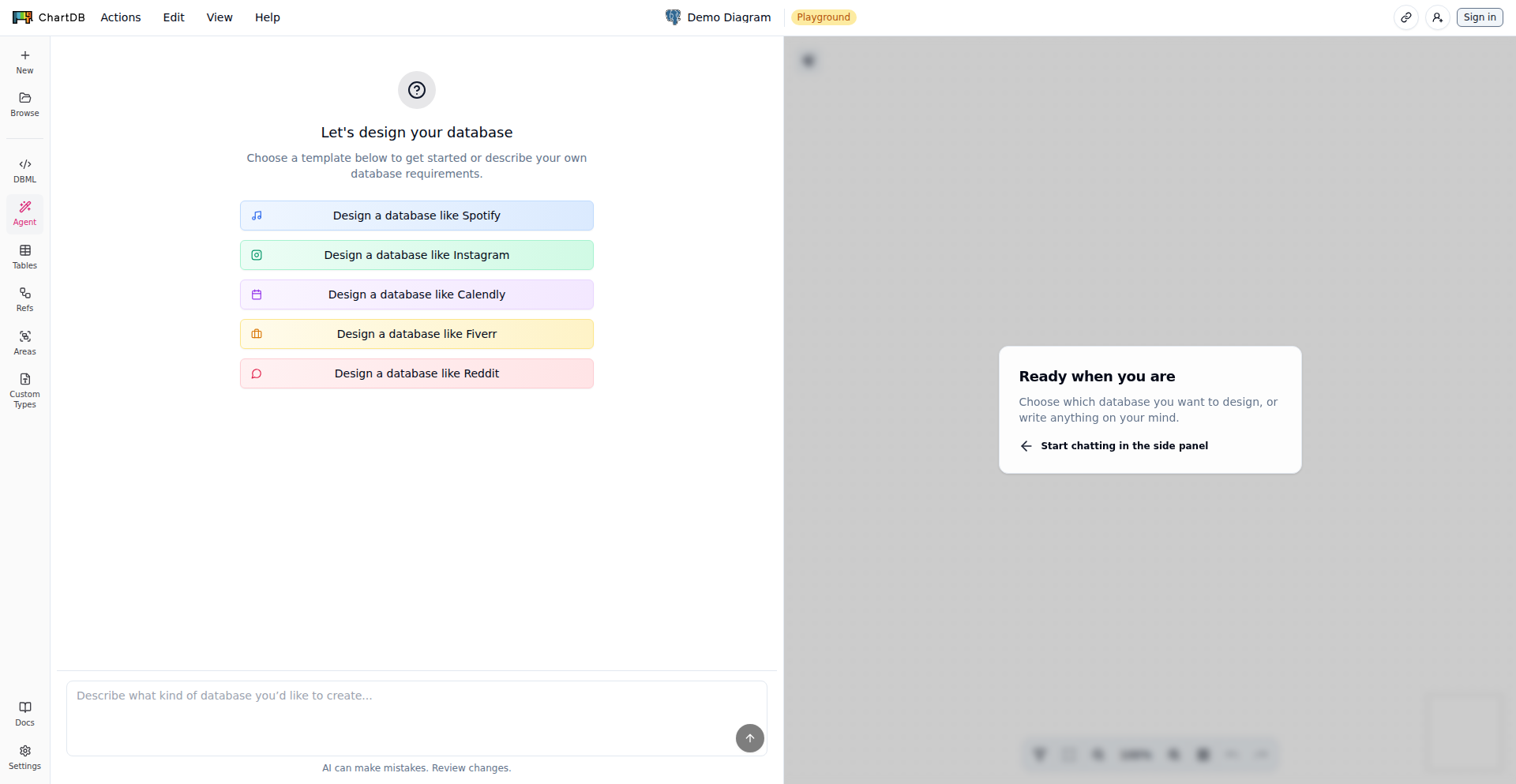

AI数据库结构设计助手

作者

guyb3

描述

ChartDB Agent 是一个革命性的数据库结构设计工具,它利用人工智能,让开发者可以用自然语言来创建或修改数据库结构。它能够将你的想法转化为可视化的数据库图,并最终生成可执行的SQL代码,大大简化了数据库设计的复杂性。

人气

点赞 115

评论数 35

这个产品是什么?

ChartDB Agent 是一个基于AI的数据库结构设计助手。传统的数据库设计需要开发者对SQL和数据库概念有深入了解,并手动编写复杂的DDL(数据定义语言)语句来创建表、定义字段和关系。ChartDB Agent 的创新之处在于,它允许你用日常英语描述你想要的数据库结构,比如“我需要一个用户表,包含姓名、邮箱和注册日期”,AI就会理解并生成相应的数据库表结构。它就像是数据库设计的“智能编辑器”,将复杂的文本指令转化为直观的图形界面,让数据库设计变得像写作一样简单。

如何使用它?

开发者可以通过访问ChartDB Agent的在线AI工具(https://chartdb.io/ai)来开始使用,无需注册即可体验。你可以用自然语言描述你想要创建的数据库表,例如“创建一个订单表,包含订单号、下单时间和商品列表”。AI会根据你的描述生成一个可视化的ER图(实体关系图),你可以在图上直观地看到表、字段和它们之间的关系。你还可以进一步细化设计,比如添加新的表、字段或修改已有的关系。一旦满意,你可以选择导出生成的SQL脚本,然后将其应用到你的数据库中。对于需要管理现有数据库的开发者,还可以注册账号,将ChartDB Agent连接到你的数据库(无需直接访问数据库,它会通过查询来理解结构),然后用自然语言提出修改建议,AI会帮助你生成相应的Schema变更脚本。

产品核心功能

· 自然语言生成数据库结构:将用日常英语描述的需求转化为数据库表、字段和关系,解决了开发者需要花费大量时间记忆和编写SQL DDL语句的问题,让思路能够快速落地。

· AI辅助的数据库结构构思:通过AI大脑,帮助开发者头脑风暴新的数据表、字段和它们之间的联系,提供设计灵感,解决创意枯竭的难题。

· 可视化ER图迭代设计:提供直观的ER图界面,让开发者能够清晰地审视和修改数据库结构,解决了复杂数据库结构难以理解和调整的痛点。

· 确定性SQL脚本导出:根据最终的ER图生成准确、可执行的SQL脚本,保证了设计的准确性和易用性,避免了手动编写SQL可能出现的语法错误和逻辑疏忽。

产品使用案例

· 新项目快速原型设计:一个初创团队在开发新产品时,需要快速搭建用户、产品、订单等一系列数据模型。使用ChartDB Agent,产品经理或初级开发者只需用自然语言描述业务逻辑,AI即可快速生成基础的数据库结构,极大缩短了项目启动的准备时间。

· 已有数据库结构优化:一位开发者发现现有数据库的某个模块设计不合理,查询效率低下。他可以直接将现有数据库结构导入ChartDB Agent,然后用自然语言提出修改需求,例如“将用户表中的地址信息拆分成独立的地址表,并与用户表建立关联”,AI会生成相应的ALTER TABLE语句,帮助他安全地优化数据库结构,提升应用性能。

· 跨职能团队协作:在一家公司,产品、开发和测试团队之间对数据库结构的理解存在差异。ChartDB Agent提供了一个统一的、可视化的平台,开发人员可以用自然语言描述设计思路,产品人员可以通过ER图直观理解,大家通过同一份设计文档协同工作,减少了沟通成本和误解。

3

Butter: LLM 记忆缓存代理

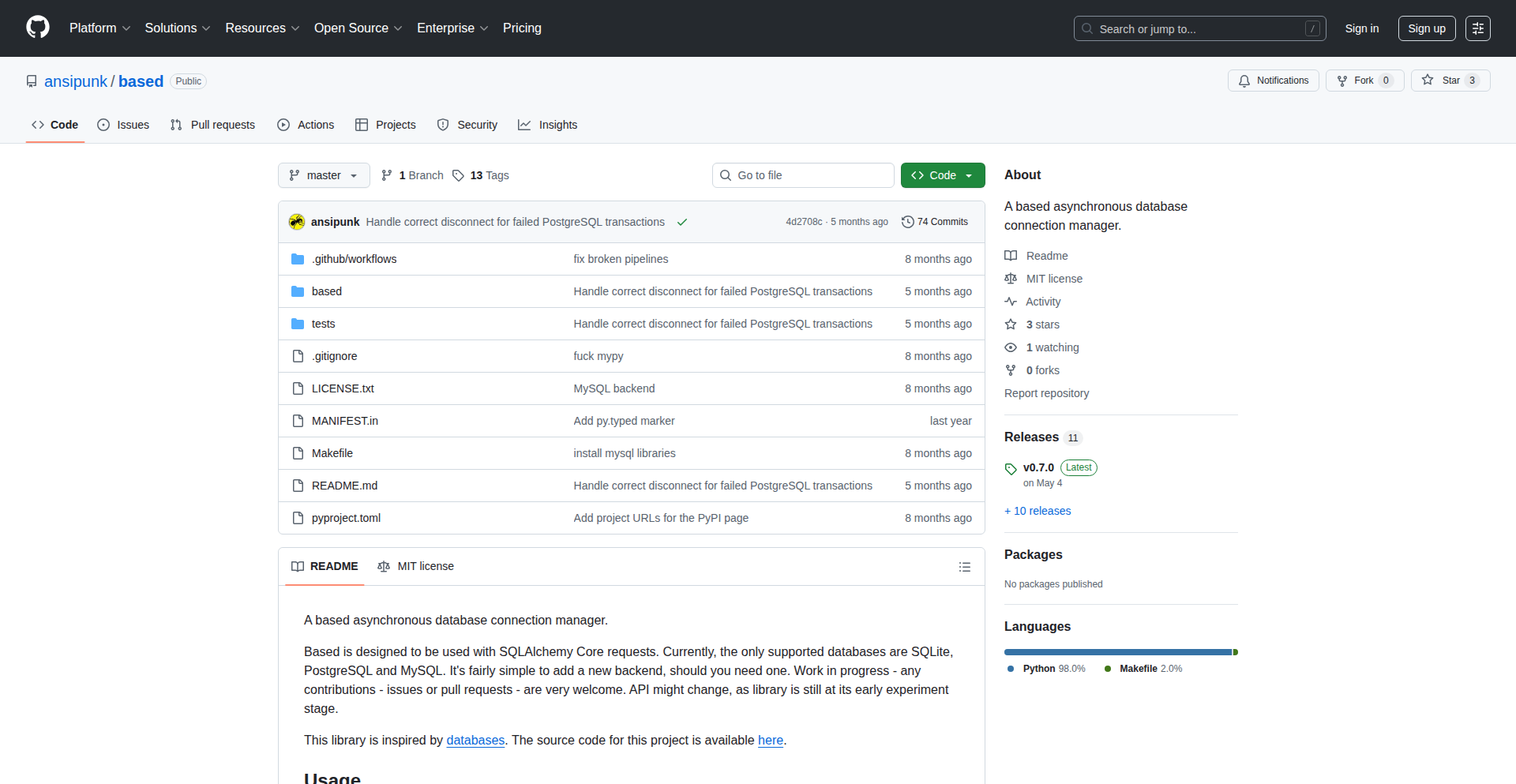

作者

edunteman

描述

Butter 是一个巧妙的 OpenAI 兼容 API 代理,它的核心创新在于为大型语言模型(LLM)引入了“记忆”功能。通过缓存 LLM 的生成结果,Butter 可以在重复的、结构相似的请求时,直接提供之前生成过的答案,而不是每次都重新调用 LLM,从而大幅提高效率并降低成本。它特别之处在于能够理解请求的“模板”,即使请求内容略有不同,也能智能地复用缓存。

人气

点赞 22

评论数 11

这个产品是什么?

Butter 是一个能让 LLM 拥有“记忆”的代理工具。你可以把它想象成一个中间层,在你和 OpenAI(或其他 LLM 服务)之间。当你向 LLM 提问时,Butter 会先看看自己有没有“记住”过类似的问题和答案。如果找到了,它就直接把储存的答案给你,省去了重新跑一遍 LLM 的麻烦。如果找不到,它才会去问 LLM,然后把这次的新答案也“记”下来,以备下次之用。它的“模板感知”能力,就像是它能识别出一些通用的问题模式,即使问题里的一些细节(比如人名、地点)变了,它也能明白这其实是同一个类型的问答,从而更有效地利用缓存。这意味着,你无需支付每次都生成答案的费用,也无需等待 LLM 重新思考,从而大大加快了你的应用响应速度。

如何使用它?

开发者可以将 Butter 作为 LLM API 的入口点。在你的代码中,原本直接调用 OpenAI API 的地方,现在改为调用 Butter 的 API。Butter 会自动处理缓存的逻辑。例如,如果你有一个问答机器人,用户经常问一些相似的问题,Butter 就可以缓存这些答案。当用户再次提出类似问题时,Butter 会迅速返回缓存结果。它还可以集成到需要大量 LLM 交互的自动化系统中,例如内容生成、数据分析等。通过配置 Butter,开发者可以显著降低 LLM API 的调用成本,并提升应用的整体性能。

产品核心功能

· LLM 请求缓存: 能够存储 LLM 的生成结果,当遇到相同的请求时,直接返回缓存中的答案,无需再次调用 LLM。这极大地节省了 API 调用成本和响应时间。

· 模板感知缓存: 能够识别出请求的结构性相似性,即使请求中的变量信息不同,也能智能地复用缓存。这意味着,即使问题稍有变化,Butter 也能判断并使用已有的答案,提高了缓存的命中率。

· OpenAI 兼容 API: 提供了与 OpenAI API 相似的接口,使得开发者可以轻松地将 Butter 集成到现有项目中,只需少量修改代码即可。

· 低成本快速原型开发: 对于需要大量 LLM 交互的项目,Butter 可以显著降低开发和测试阶段的 API 调用成本,让开发者能够更快地进行实验和迭代。

· 提高应用响应速度: 通过直接返回缓存结果,Butter 大大缩短了 LLM 的响应时间,从而提升了最终用户的使用体验。

产品使用案例

· AI 驱动的客服机器人: 当用户反复询问关于产品功能、退货政策等常见问题时,Butter 可以直接提供预存的答案,无需每次都调用 LLM,确保客服响应的即时性和一致性。

· 内容生成工具的草稿优化: 在生成文章、博客或产品描述的初稿时,Butter 可以缓存一些常用的句子结构或段落。当用户需要修改或重新生成时,Butter 可以快速提供一个接近的草稿,再进行微调,提高创作效率。

· 数据分析和报告生成: 对于需要 LLM 来总结数据、提炼洞察的场景,Butter 可以缓存对相同数据集的分析结果。当数据集或分析需求相似时,可以快速生成报告,避免重复劳动。

· AI Agent 的重复性任务自动化: 在构建 AI Agent 处理自动化任务时,Butter 可以缓存 Agent 的决策过程或生成的内容。这样,当 Agent 遇到相似的场景时,能够更快地做出反应,提高自动化系统的效率。

· 教育和培训平台中的问答系统: 在学生或学员提问时,Butter 可以缓存针对常见概念或操作的解答。这样,教师或平台可以节省大量重复解答的时间,专注于更复杂的指导。

4

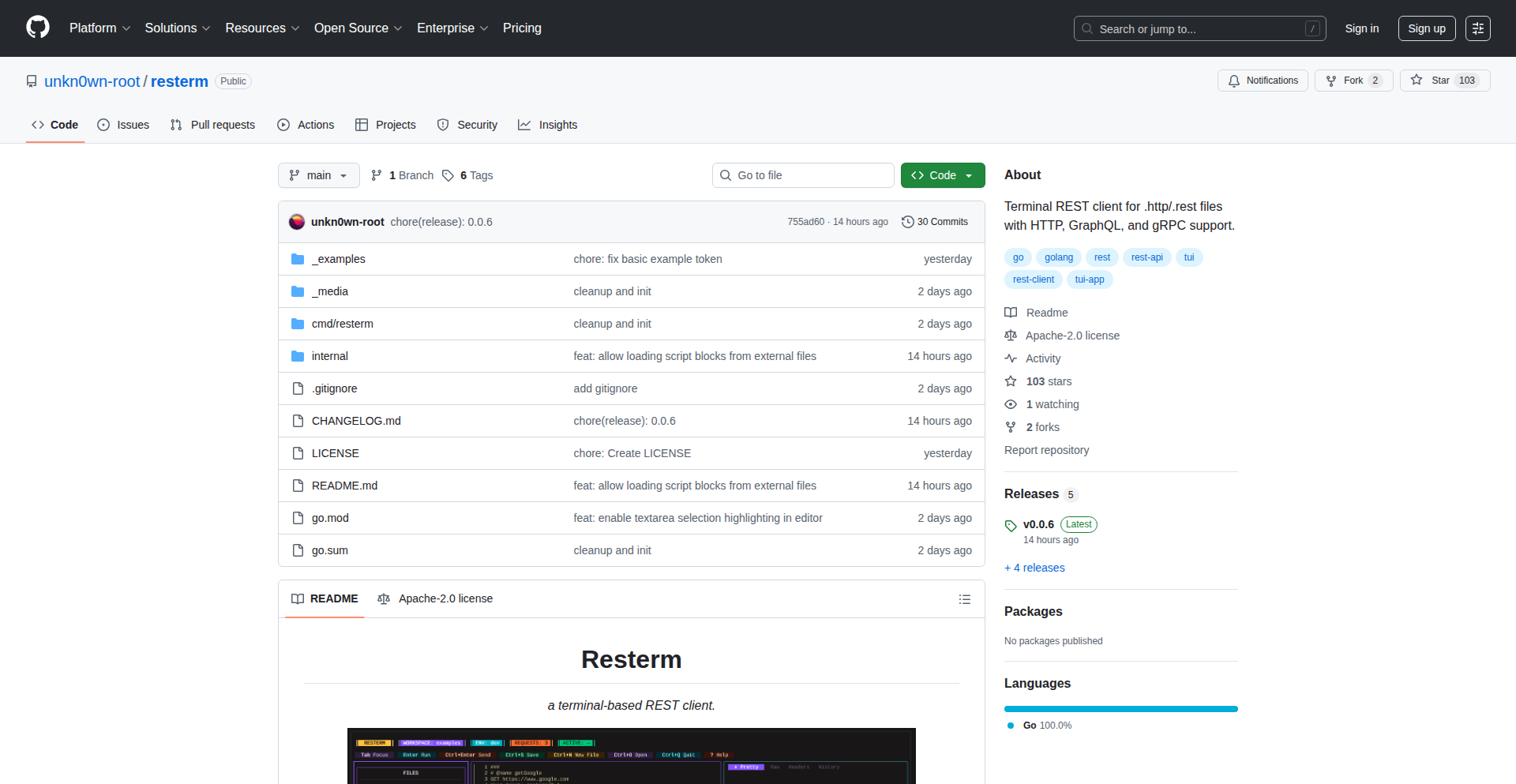

Resterm:终端里的全能API调试器

作者

unkn0wn_root

描述

Resterm 是一个运行在终端里的工具,它可以让你方便地调试那些通过网络发送请求的程序接口(API)。它支持目前最流行的几种API通信方式:REST、GraphQL 和 gRPC。这意味着,无论你的后端服务是哪种技术,Resterm 都能帮你快速测试和查找问题,尤其是在你不想离开终端界面的情况下。它的创新之处在于将这三种不同的API调用方式整合在一个统一的、用户友好的终端界面中,极大地提高了开发效率和调试体验。

人气

点赞 25

评论数 1

这个产品是什么?

Resterm 是一个可以在命令行界面(终端)下使用的 API 调试工具。它能够让你像在图形界面软件里一样,发送请求给你的后端服务,然后查看返回的结果。 对于 REST API,你可以发送 GET、POST 等请求,并设置请求头和请求体。 对于 GraphQL,它可以智能地帮你构建查询语句,并解析返回的数据。 而对于 gRPC,它能够理解 gRPC 的服务定义,让你能够直接调用远程服务。 它的技术创新在于,将这三种原本可能需要不同工具才能调试的 API 类型,统一到了一个简洁的终端体验中。 所以这对我有什么用? 这就像是给你的代码库配备了一个万能的“听诊器”,你可以直接在终端里“听”到你的后端服务是否正常工作,以及它返回的数据是否符合预期,无需打开复杂的图形界面工具,节省了大量时间。

如何使用它?

开发者可以通过命令行直接运行 Resterm,然后输入 API 的地址和请求参数。 比如,你可以输入 `resterm graphql http://your-api.com/graphql` 来连接一个 GraphQL 服务,然后编写你的查询语句。 对于 REST API,你可以指定 URL、HTTP 方法(如 POST)以及请求体。 对于 gRPC,你需要提供服务的描述文件(如 `.proto` 文件)和目标地址。 Resterm 提供了命令补全和历史记录功能,让你可以更流畅地输入和执行命令。 它可以集成到你的开发工作流中,例如在编写代码的间隙,快速测试刚刚修改的 API。 所以这对我有什么用? 它让你能够快速、高效地在终端环境中完成 API 测试和调试,让你在开发过程中能够更专注于代码编写,而不是被繁琐的工具切换所打断。

产品核心功能

· 支持 REST API 调试:可以方便地发送各种 HTTP 请求,设置请求头和请求体,查看响应状态码和内容,帮助开发者快速验证 RESTful 服务的正确性。

· 支持 GraphQL API 调试:能够智能解析 GraphQL schema,允许开发者在终端中编写和执行 GraphQL 查询,并高亮显示返回的数据结构,使得 GraphQL API 的调试更加直观。

· 支持 gRPC API 调试:可以加载 gRPC 服务定义文件(proto),并允许开发者在终端中调用远程 gRPC 服务,查看请求和响应,解决了 gRPC 服务在终端调试的痛点。

· 统一的终端界面:将 REST、GraphQL 和 gRPC 三种不同的 API 调用方式整合在同一个命令行工具中,避免了开发者在不同工具间切换的麻烦,提升了开发效率。

· 交互式查询构建:提供命令补全、历史记录等功能,使得在终端中构建复杂的 API 请求变得更加便捷,如同在图形界面中操作一样流畅。

产品使用案例

· 在微服务架构开发中,当需要同时与多个不同类型的后端服务进行交互时,Resterm 可以让开发者在同一个终端窗口中快速切换和测试这些服务,无需打开多个图形界面工具,解决了服务间依赖调试的复杂性。

· 当需要进行CI/CD自动化测试时,Resterm 可以被集成到脚本中,用于自动化地发送 API 请求并检查响应,确保部署的代码能够正常运行,解决了自动化 API 验证的难题。

· 在网络环境不佳或远程服务器上进行开发时,Resterm 作为一个轻量级的终端工具,无需安装复杂的图形界面依赖,可以直接在命令行下进行 API 调试,解决了远程开发环境下的调试限制。

· 对于习惯使用终端进行开发的开发者来说,Resterm 提供了一个原生且高效的 API 调试体验,让他们可以完全在熟悉的命令行环境中完成从代码编写到 API 测试的全过程,提升了黑客式编程的效率。

5

Alloy Automation MCP - 智能系统连接器

作者

mnadel

描述

Alloy Automation MCP 是一个专门为 AI 代理设计的连接器,它能让 AI 智能地访问和操作那些对企业至关重要的系统,比如 QuickBooks、Xero(财务软件)、Notion(笔记和项目管理)、HubSpot(客户关系管理)以及 Salesforce(客户关系管理)。它解决了将 AI 与这些复杂商业系统集成时遇到的技术难题,让开发者能更快速地构建应用。它还提供了一个 API,允许开发者进行更深入的定制集成。其核心亮点在于安全可靠的身份验证和密钥管理,确保了数据安全。

人气

点赞 9

评论数 5

这个产品是什么?

Alloy Automation MCP 就像一个万能的“翻译官”和“协调员”,它让你的 AI 助手能够理解并操作那些平时很复杂的商业软件。想象一下,你的 AI 客户服务机器人需要查询某个客户在 Salesforce 里的订单信息,或者需要把一个新任务添加到 Notion 里。MCP 就是那个能够让 AI 和这些软件“对话”并“干活”的桥梁。它通过预先构建好的服务器,覆盖了市面上许多主流的商业工具,就像给 AI 配备了一套标准的“操作手册”,省去了开发者自己去研究每个软件复杂的接口(API)的麻烦。而且,MCP 的安全措施非常到位,它使用一种叫做“作用域认证”(scoped auth)的技术,确保 AI 只能访问它被授权访问的数据,并且会独立管理所有敏感的密钥信息,就像给 AI 设置了严格的“通行证”和“保管箱”。所以,这对我有什么用?它能让你的 AI 应用变得更强大、更实用,能处理更多真实世界的商业任务,而且省去了大量的集成开发时间和技术成本。

如何使用它?

开发者可以将 Alloy Automation MCP 集成到他们的 AI 应用中,让 AI 代理能够通过 MCP 访问预先配置好的商业系统。你可以选择你需要的工具(例如,如果你用 HubSpot 管理客户,就启用 HubSpot 的连接器),然后部署一个 MCP 服务器。之后,你的 AI 代理就可以通过简单的指令,让 MCP 去执行任务,比如“在 HubSpot 中创建一个新的联系人”或者“从 QuickBooks 中检索最近的付款记录”。如果需要更高级的定制,MCP 还提供了一个叫做“Connectivity API”的接口,开发者可以直接通过代码调用,实现比 MCP 预设功能更复杂的集成。所以,这对我有什么用?你可以通过非常少的代码,就让你的 AI 应用连接到你正在使用的各种商业工具,让 AI 能够实际地为你的业务流程提供支持,大大加速产品开发。

产品核心功能

· AI 智能系统访问:通过预设的服务器,让 AI 代理能够轻松访问 QuickBooks、Xero、Notion、HubSpot、Salesforce 等商业系统,解决 AI 无法直接操作这些软件的技术难题,应用场景是为 AI 赋能,使其能执行数据查询、信息录入、流程自动化等任务。

· 免集成技术难题:无需深入了解每个商业软件的复杂技术接口,Alloy Automation MCP 已经帮你做好了兼容,开发者可以直接调用,极大地降低了技术门槛,应用场景是快速开发和部署 AI 驱动的业务应用。

· 安全可靠的密钥管理:采用作用域认证(scoped auth)和独立的密钥管理系统,确保 AI 访问数据时的安全性和合规性,防止敏感信息泄露,应用场景是任何涉及企业敏感数据的 AI 应用。

· 可扩展的 Connectivity API:提供编程接口,允许开发者进行深度定制化集成,满足更复杂、更个性化的技术需求,应用场景是构建高度定制化的企业级 AI 解决方案。

· 跨平台工具支持:覆盖了市面上众多主流的商业工具,意味着你的 AI 应用可以在不同的技术栈和业务场景下通用,提高了技术的通用性和复用性,应用场景是构建多功能、跨平台集成的 AI 服务。

产品使用案例

· 开发一个AI客服助手,该助手能够连接到Salesforce,查询客户的历史订单记录,并根据客户ID在HubSpot中更新客户信息,解决客服人员需要跨系统查询和操作的痛点,极大地提高了工作效率。

· 构建一个AI驱动的财务报告自动化工具,该工具能通过MCP连接到QuickBooks和Xero,自动抓取财务数据,生成月度或季度财务报告,省去了手动导出和整理数据的繁琐过程,提高了财务数据的时效性和准确性。

· 创建一个AI项目管理助手,能够连接到Notion,根据指令自动创建新的项目、任务列表,并分配给团队成员,解决了手动创建和管理大量项目条目的技术难题,让项目管理流程更加顺畅。

· 为企业开发一个AI数据同步解决方案,通过MCP连接到多个CRM和ERP系统,实现跨系统的数据自动同步和更新,避免数据不一致的问题,提高了企业数据的整体质量和可靠性。

6

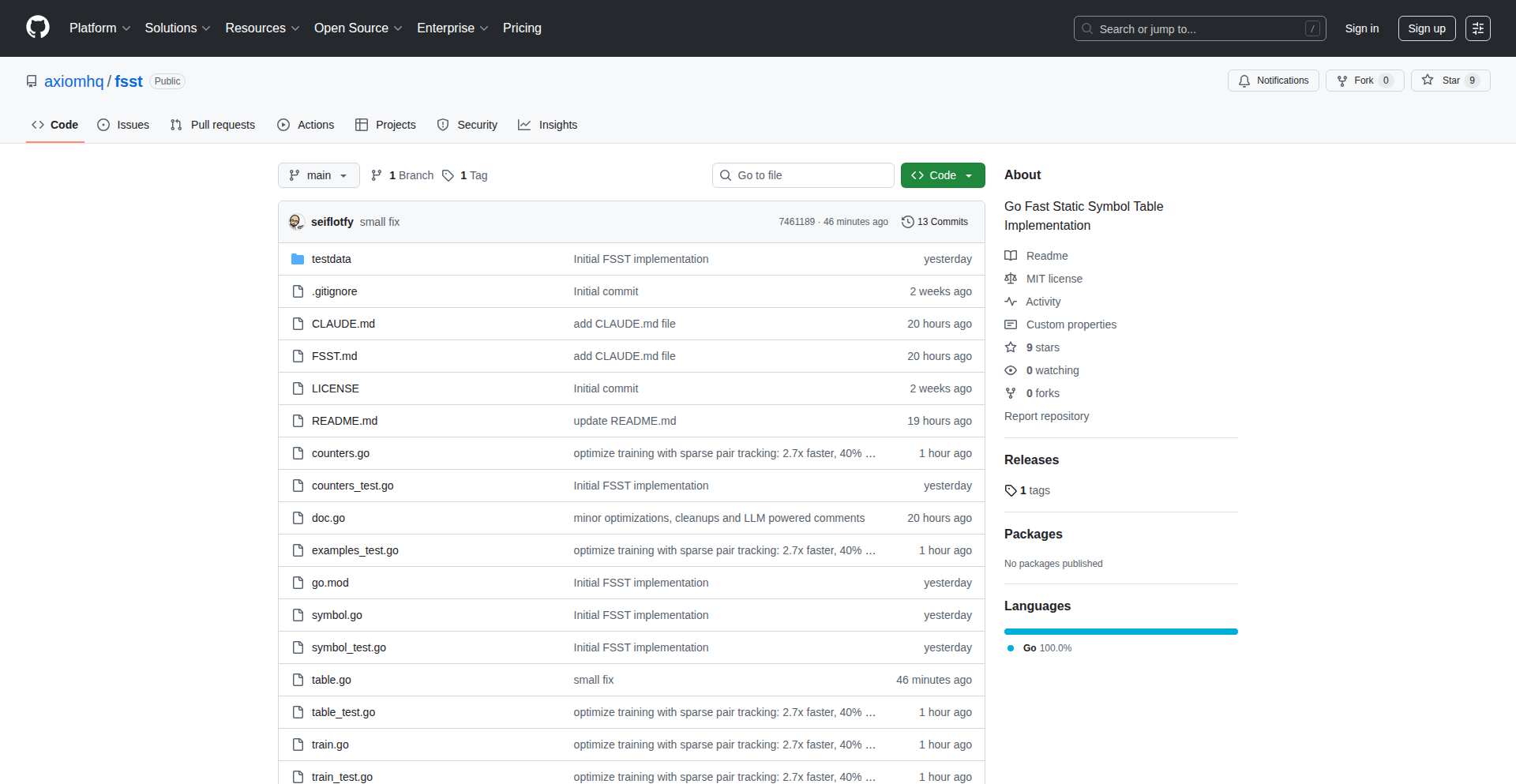

Go-FSST: 飞速静态符号压缩引擎

作者

seiflotfy

描述

Go-FSST 是一个用 Go 语言实现的 FSST(Fast Static Symbol Table Compression)库,它专注于高效地压缩静态符号表数据,尤其擅长处理日志和 JSON 等结构化数据。通过创新的算法,它能够在保证极快压缩和解压速度的同时,大幅减小数据体积。所以这对我来说,意味着可以更省空间地存储大量日志和配置信息,并且在需要时能迅速地访问它们。

人气

点赞 12

评论数 2

这个产品是什么?

Go-FSST 是一个先进的数据压缩技术,叫做 FSST(Fast Static Symbol Table Compression)的 Go 语言实现。简单来说,它就像一个非常聪明的“收纳箱”,能够把大量重复的、有规律的文本信息(比如日志里的常用词、JSON 里的键名)打包得非常紧凑。它的创新之处在于,它不是简单地把重复的内容替换成短代码,而是通过一种叫做“静态符号表”的技巧,预先分析好需要压缩的数据,然后生成一套专门的压缩规则。这使得压缩和解压的过程都非常快速,即使数据量很大,也能迅速完成。所以这对我来说,意味着存储和处理大量文本数据将变得更高效,节省磁盘空间和提高访问速度。

如何使用它?

开发者可以将 Go-FSST 集成到他们的 Go 项目中,用于压缩和解压日志文件、配置文件(特别是 JSON 格式)、数据库中的文本字段等。你可以先用 Go-FSST 的训练功能(training)分析你的数据,生成一个压缩模型(symbol table),然后利用这个模型来压缩你的原始数据。当需要读取数据时,再用 Go-FSST 的解压功能(decode)根据模型还原出原始数据。例如,你可以用它来压缩服务器生成的海量日志,大幅减少存储成本,并在需要检索特定日志时快速解压,而不会显著影响查询性能。所以这对我来说,意味着我可以轻松地在应用程序中实现高效的数据压缩,从而优化存储和 I/O 性能。

产品核心功能

· 数据训练与模型生成:分析原始文本数据,学习其内在规律,生成一套高效的压缩规则(symbol table)。这使得压缩算法能根据具体数据进行优化,而不是使用通用的、效率较低的方法。所以这对我来说,意味着压缩效果能最大化,数据体积减小得更多。

· 高效压缩:利用生成的压缩规则,将原始文本数据快速地转换成更小的压缩格式。这个过程非常迅速,即使处理大量数据也能保持高吞吐量。所以这对我来说,意味着我可以节省宝贵的存储空间,并且在需要压缩数据时不会花费太多时间。

· 快速解压:能够根据训练生成的模型,迅速地将压缩后的数据还原成原始文本。解压速度同样非常快,确保了数据访问的及时性。所以这对我来说,意味着虽然数据被压缩了,但我获取和使用原始数据时依然能获得流畅的体验,不会有明显的延迟。

· 支持日志和JSON数据:特别针对日志文件和JSON数据这类包含大量重复模式的文本进行了优化,能够取得显著的压缩效果。所以这对我来说,意味着我处理日常开发中常见的日志和配置信息时,能享受到最佳的压缩效率。

· 集成示例与辅助工具:提供了训练、编码/解码的辅助函数以及示例代码,方便开发者快速上手和集成。所以这对我来说,意味着我不需要从零开始学习复杂的压缩算法,能更快地将这项技术应用到我的项目中。

产品使用案例

· 日志存储优化:一个Web服务器每天产生大量的访问日志,这些日志包含许多重复的URL、用户代理字符串等。使用Go-FSST可以大幅压缩这些日志文件,例如将原本需要10GB的日志压缩到1GB,极大地降低了存储成本。在需要分析日志时,快速的解压速度也能保证日志分析工具的流畅运行。所以这对我来说,意味着我可以节省大量服务器存储空间,并且还能快速地进行日志分析。

· 配置数据管理:一个大型分布式系统需要存储大量的配置项,其中许多键名和字符串值在不同的配置块中是重复的。将这些配置信息(如JSON格式)用Go-FSST压缩后存储,可以显著减小配置文件的体积,加快配置加载速度,尤其是在启动大量服务实例时。所以这对我来说,意味着我的系统配置管理将更加高效,启动速度更快。

· 数据库文本字段压缩:在数据库中存储大量文本型字段,如用户评论、文章内容等,这些文本可能包含大量的重复词语或短语。通过Go-FSST对这些字段进行压缩存储,可以有效减少数据库的存储占用,并可能提高查询效率(如果数据库支持对压缩字段进行优化)。所以这对我来说,意味着我的数据库将占用更少的空间,并且可能提高数据访问的性能。

· IPC消息压缩:在微服务架构中,不同服务之间的通信(IPC)可能产生大量的数据。如果通信消息包含重复的模式,使用Go-FSST进行压缩可以减少网络传输的数据量,提高通信效率,降低延迟。所以这对我来说,意味着我的服务间通信将更加快速和节省带宽。

7

硬件上下文层

作者

nimabanai

描述

一个能够理解你硬件设计细节的AI助手,它可以接入你正在使用的编程工具,比如像Cursor这样的代码编辑器,让你在编写固件或调试硬件问题时,AI能准确地理解你的硬件原理图、元器件规格书等信息,不再给出模糊不清或错误的建议。它就像一个为你的硬件项目量身定制的“硬件大脑”,让开发过程更高效、更准确。

人气

点赞 14

评论数 0

这个产品是什么?

这是一个叫做“硬件大脑”(Hardware Brain)的项目,它的核心技术是将复杂的硬件信息,如电路原理图(目前主要支持KiCad格式)、元器件的详细规格书(Datasheets)以及其他技术文档(如应用笔记),转化为AI能够理解和实时查询的知识库。传统的AI工具在面对特定硬件项目时,往往因为缺乏对具体硬件细节的了解而给出泛泛的答案,或者因为信息量太大而无法处理。Assemble Labs的这个项目,通过一个MCP(Master Control Program,在此可以理解为“主控程序”)服务器,将你的硬件信息“喂给”AI,从而让AI能够像一个资深的硬件工程师一样,在编程、调试时提供高度相关的、准确的反馈。它的创新之处在于,它不是一个全新的AI应用,而是作为一个“插件”,能够无缝集成到你现有的AI开发环境中,解决AI在硬件开发中的“上下文缺失”和“理解不足”的问题。

如何使用它?

开发者在使用这个项目时,首先需要准备好项目的硬件设计文件,目前主要是KiCad格式的原理图,以及主要元器件的规格书。然后,将这些文件上传到Assemble Labs的MCP服务器。服务器会将这些信息处理成一个可供AI调用的“硬件知识库”。接着,你就可以在你常用的AI开发工具(如Cursor、Claude Code、Gemini等)中,通过特定的方式(比如通过API调用或配置插件),将这个“硬件大脑”接入进来。这样,当你向AI提问关于你的硬件设计、固件编写或硬件调试的问题时,AI就能利用这个“硬件大脑”提供的上下文信息,给出更精准、更有针对性的答案。例如,你可以问AI“如何配置某个芯片的ADC以读取特定传感器的数值”,AI就会根据你提供的硬件原理图和该芯片的规格书,给出具体的寄存器设置和代码示例。

产品核心功能

· 硬件信息解析与索引:能够解析KiCad格式的原理图、元器件规格书等,建立一个结构化的硬件知识库,方便AI进行检索。这解决了AI无法直接理解硬件设计图纸和技术文档的技术难题。

· 实时上下文提供:将解析后的硬件信息转化为AI可用的上下文,并在AI进行代码生成或问题诊断时,实时提供相关信息。这使得AI的回答不再是泛泛之谈,而是紧密围绕用户具体的硬件项目。

· AI工具集成:作为MCP服务器,可以接入到主流的AI开发工具和IDE中,让开发者无需学习新的工具,就能在熟悉的环境中获得AI的硬件开发支持。这解决了新应用学习成本高的问题。

· 固件生成与调试辅助:能够帮助生成低级别的固件代码,并支持在硬件上进行测试和调试,形成一个完整的开发闭环。这加速了软件和硬件的协同开发过程。

产品使用案例

· 在一个复杂的嵌入式系统开发场景中,工程师需要为一个新的产品编写低功耗的固件。传统的AI工具只能提供通用的低功耗模式设置,但无法考虑工程师具体使用的微控制器型号、外围接口以及特定的电源管理芯片。通过Assemble Labs的“硬件大脑”,AI能够精确理解工程师的硬件原理图,了解具体芯片的功耗特性和配置选项,从而生成高度优化的固件代码,并且在遇到内存或功耗瓶颈时,AI能够基于硬件信息给出有效的解决方案。

· 一名软件工程师在调试一块新设计的硬件时,发现传感器数据异常。他无法确定问题是出在传感器本身、连接电路还是驱动代码。将硬件原理图和传感器规格书上传到“硬件大脑”后,AI可以分析传感器与微控制器的连接方式,检查相关驱动代码是否正确调用了硬件寄存器,并与规格书中的电气特性进行对比,从而快速定位到问题是由于某个连接引脚的配置错误导致数据传输中断,显著缩短了调试时间。

8

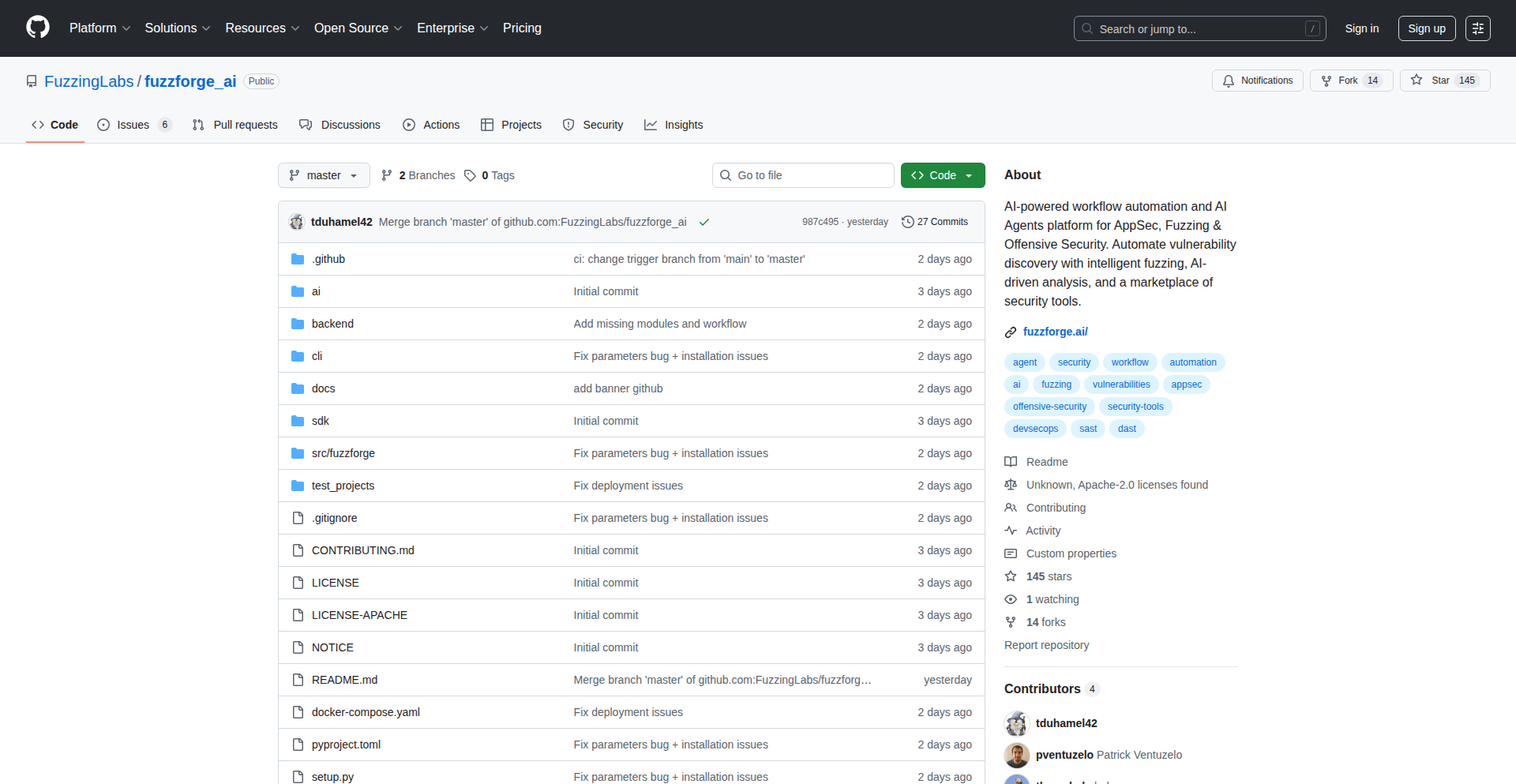

AI 赋能的智能漏洞挖掘器

作者

unbalancedparen

描述

Fuzz Forge 是一个利用人工智能(AI)与模糊测试(fuzzing)技术相结合的漏洞发现工具。它通过智能生成测试用例,自动化地寻找软件中的潜在安全漏洞,解决传统漏洞挖掘方法效率低、覆盖率不足的问题。

人气

点赞 10

评论数 1

这个产品是什么?

Fuzz Forge 是一个通过AI和模糊测试来寻找软件安全漏洞的工具。简单来说,模糊测试就像是给软件喂大量的、甚至是“胡言乱语”的数据,看它会不会出错。Fuzz Forge 的创新之处在于,它不像传统的模糊测试那样随机生成数据,而是用AI来学习软件的行为模式,然后更聪明地、更有针对性地生成那些最有可能触发漏洞的“刁钻”数据。所以这对我有什么用?它可以帮你更高效地发现自己软件中的安全隐患,从而在攻击者找到之前就修复它们,保护你的产品和用户。

如何使用它?

开发者可以将 Fuzz Forge 集成到他们的 CI/CD(持续集成/持续部署)流程中。通过配置 Fuzz Forge 来针对特定的代码模块或二进制文件进行测试,AI模型会学习目标程序的输入格式和行为,然后生成大量的变异输入(fuzzing inputs)来探测潜在的崩溃、内存泄露或其他异常行为。当发现异常时,Fuzz Forge 会记录下触发问题的输入,方便开发者定位和修复。所以这对我有什么用?你可以把它变成一个自动化的安全检查员,在你每次更新代码后,都能帮你扫描出新的安全漏洞,减少手动安全审计的负担。

产品核心功能

· AI驱动的测试用例生成:利用机器学习模型分析目标程序的行为,智能生成高效率的测试输入,而不是盲目随机生成。这能大大提高发现漏洞的几率。所以这对我有什么用?更快、更准地找到那些隐藏很深的bug。

· 自动化崩溃与异常检测:Fuzz Forge 能够自动监测程序在接收到生成测试用例后的运行状态,一旦发生崩溃、内存错误或其他异常,就会立即记录下来。所以这对我有什么用?帮你及时发现那些可能导致程序崩溃或数据损坏的严重问题。

· 集成式漏洞报告:对于发现的潜在漏洞,Fuzz Forge 会提供详细的报告,包括触发问题的具体输入数据和异常发生时的上下文信息。所以这对我有什么用?方便你快速定位问题根源,加速修复过程。

· 可配置的测试策略:开发者可以根据目标程序的特点和关注的安全领域,调整 Fuzz Forge 的测试策略和参数,使其更符合实际需求。所以这对我有什么用?让安全测试更灵活,能够专注于你最关心的部分。

产品使用案例

· 在开发一个网络服务时,开发者可以利用 Fuzz Forge 针对服务的API接口进行模糊测试,以发现可能导致拒绝服务攻击(DoS)或远程代码执行(RCE)的安全漏洞。AI能够学习API的预期输入格式,并生成各种边界和异常情况下的请求,从而比随机测试更有效地找到潜在弱点。所以这对我有什么用?保护你的网络服务免受恶意攻击,确保用户数据安全。

· 对于一个处理文件输入的应用程序(如图像编辑器或文档解析器),开发者可以使用 Fuzz Forge 来测试其文件解析模块。AI可以帮助生成格式不规范、带有恶意构造的文件,以探测可能的文件解析漏洞,如缓冲区溢出或路径遍历。所以这对我有什么用?防止因文件处理不当而引发的安全漏洞,保护用户文件不被非法访问或篡改。

· 在开发操作系统内核或驱动程序时,Fuzz Forge 可以用来测试系统调用的处理逻辑。AI生成的各种系统调用组合和参数,可以用来挖掘内核级别的安全漏洞,防止系统崩溃或特权提升。所以这对我有什么用?提高操作系统的稳定性和安全性,防止关键系统被攻破。

9

光年引擎

作者

egretfx

描述

光年引擎是一个开源的网页模拟引擎,专门用于进行相对论物理学的模拟计算。它通过强大的前端渲染能力,将复杂的物理学概念以直观的方式呈现在网页上,让开发者能够轻松构建和展示诸如黑洞、引力波等涉及高速和强引力场效应的物理现象。其创新之处在于将高性能计算与Web技术结合,使得原本需要专业软件才能实现的模拟,现在可以在浏览器中完成,极大地降低了研究和教育的门槛。

人气

点赞 6

评论数 4

这个产品是什么?

光年引擎是一个让你能在网页浏览器里模拟宇宙中的极端物理现象的工具。简单来说,它就像一个能让你在电脑屏幕上“玩转”黑洞、引力波这些高大上物理概念的游戏引擎。它的厉害之处在于,它用了先进的计算方法(比如处理快速移动和巨大引力时需要用到的一些数学技巧)把这些复杂的物理过程搬到了浏览器里,而且是用开放源代码的方式,这意味着任何人都可以查看、修改和使用它。所以,它对物理学家、天文学家、教育者以及任何对宇宙奥秘感兴趣的人来说,提供了一个易于访问、可视化强的模拟平台,不再需要昂贵的专业软件或深厚的编程功底就能进行探索。

如何使用它?

开发者可以将光年引擎集成到自己的网页应用中,用于创建交互式的科学可视化内容。你可以用它来构建一个讲解相对论的教育网站,让学生通过拖拽参数来观察不同质量和速度下的宇宙景象;或者开发一个展示引力波传播过程的演示页面;甚至可以将其作为大型科研项目的可视化前端,用于展示模拟结果。集成方式通常是通过JavaScript API调用,你可以加载预设的物理场景,或者自定义参数来运行新的模拟,并将结果实时渲染到网页上。简单地说,就是你只需要写一些JavaScript代码,就能让你的网页“动”起来,模拟出宇宙级别的物理效果。

产品核心功能

· 相对论效应可视化: 能够模拟并直观地展示物体在接近光速或强引力场下的行为,比如时间膨胀、长度收缩等,帮助理解爱因斯坦的相对论。

· 引力场模拟: 可以模拟不同质量天体产生的引力场,以及引力波的产生和传播,让用户看到宇宙的“涟漪”。

· 高性能前端渲染: 利用现代Web技术(如WebGL)实现流畅、高质量的3D图形渲染,将复杂的物理计算结果生动呈现。

· 可配置的模拟参数: 允许用户自由调整模拟的初始条件,如天体质量、初始速度、能量密度等,进行不同场景的探索。

· 开源与可扩展性: 基于开源协议,允许开发者自由修改和扩展引擎功能,构建更复杂的模拟场景或集成其他科学库。

· 跨平台兼容性: 作为Web引擎,可以在支持现代浏览器的任何设备上运行,无需安装额外软件,大大提高了可访问性。

产品使用案例

· 在物理学教育网站中,展示一个黑洞吞噬恒星的模拟过程,让学生通过调整恒星大小和轨道,直观理解引力作用和潮汐力,解决传统教学方式难以具象化的问题。

· 为天文学研究项目开发一个可视化工具,用于展示模拟的星系碰撞过程,帮助研究人员更清晰地分析模拟结果,提升科研效率。

· 创建一个互动式的网页,让用户输入太阳系中行星的质量和轨道参数,然后实时模拟其在相对论效应下的运动轨迹,增加趣味性和学习深度。

· 开发一个科普小游戏,让玩家通过控制飞船速度和方向,尝试在强引力场中进行“太空漂移”,体验相对论效应带来的物理挑战。

· 为科学纪录片制作一个高动态范围的网页预览,展示引力波探测器LIGO的数据模拟,使观众在没有专业背景的情况下也能理解其工作原理。

10

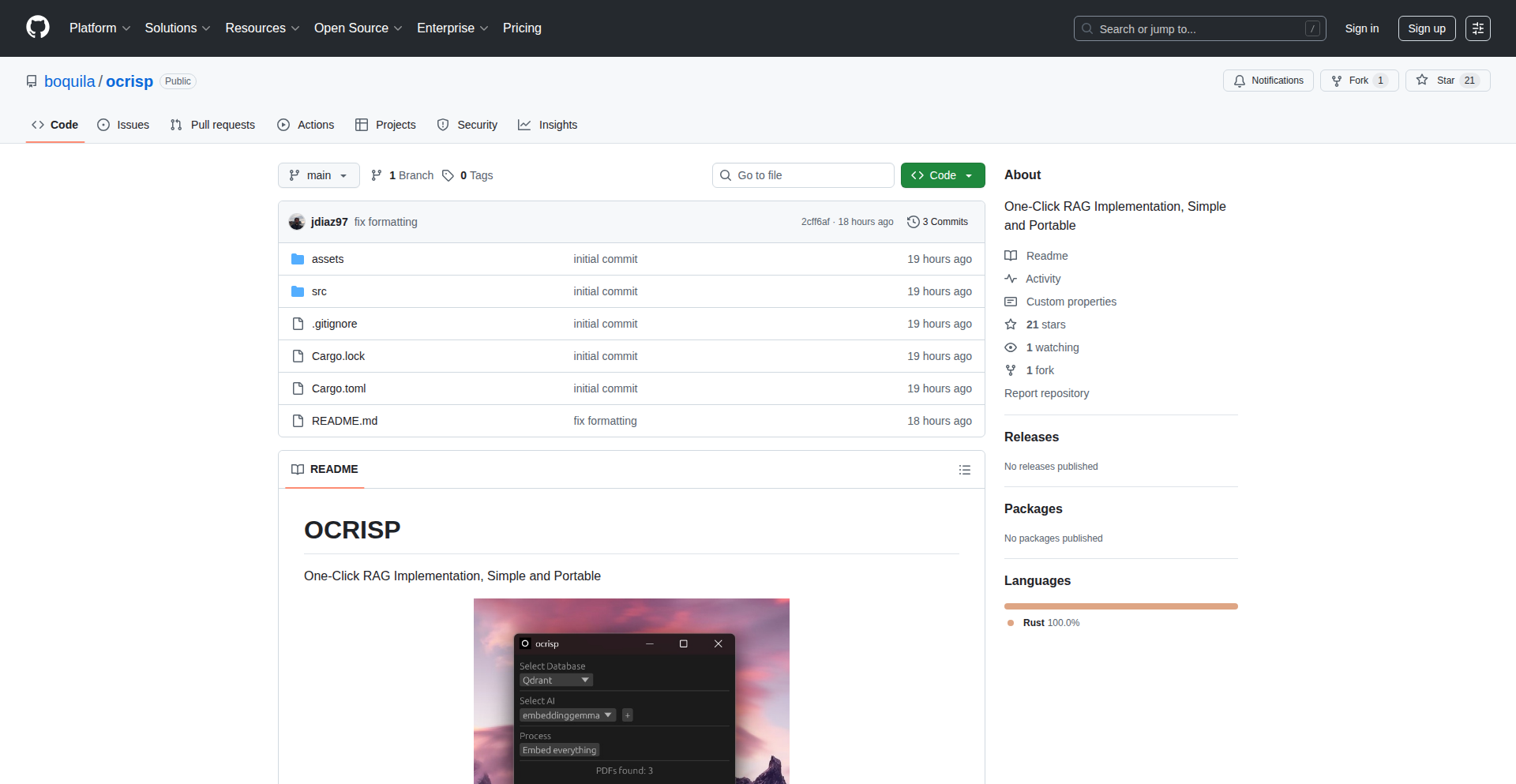

Ocrisp: 一键式RAG落地工具

作者

jdiaz97

描述

Ocrisp是一个将“检索增强生成”(RAG)这一强大的AI技术,以简单、便携的方式实现的项目。它允许开发者快速部署一个能连接自己的数据和大型语言模型(LLM)的系统,让AI能够基于你的特定信息进行回答,而无需复杂的配置。这解决了AI在没有针对性知识时回答泛泛而谈的问题,让AI真正“懂”你的业务。

人气

点赞 9

评论数 0

这个产品是什么?

Ocrisp是一个方便开发者快速搭建“检索增强生成”(RAG)系统的工具。RAG技术的核心思想是,让大型语言模型(LLM)在回答问题时,能够先从你提供的私有知识库(比如文档、数据库等)中检索相关信息,然后将这些信息作为上下文,与问题一起喂给LLM,让LLM基于这些信息生成更准确、更具针对性的回答。Ocrisp的创新在于,它将这个过程打包成了一个“一键式”的解决方案,大大降低了RAG技术的部署门槛,让开发者无需深入了解复杂的向量数据库、embedding模型配置等,就能快速搭建自己的AI助手。想象一下,你不再需要担心AI回答时“胡说八道”,而是能给出基于你公司内部知识的答案,这就是RAG的价值,而Ocrisp让这个价值触手可及。

如何使用它?

开发者可以通过Ocrisp提供的简单接口和配置,快速将自己的文本数据(如Markdown文件、TXT文件、PDF等)接入到RAG系统中。它支持将这些数据进行预处理、向量化(将文本转换成计算机能理解的数字表示,方便搜索),并与一个大型语言模型(LLM)进行连接。使用场景非常广泛,例如:

1. **内部文档问答:** 将公司内部的知识库、用户手册、开发文档导入Ocrisp,让员工能够通过自然语言快速查找信息,提高工作效率。

2. **智能客服:** 集成Ocrisp到客服系统中,让AI客服能够基于产品手册和FAQ回答用户问题,减少人工客服的压力。

3. **内容生成助手:** 开发者可以利用Ocrisp连接自己的代码库或技术博客,让AI助手在编写新代码或文档时,能够参考已有的内容,减少重复劳动。

Ocrisp的设计目标是“简单和便携”,意味着你可以轻松地在本地环境或云端部署,快速启动一个AI应用。

产品核心功能

· 数据预处理与向量化:将各种格式的文本数据转化为AI可理解的向量表示,方便后续的快速检索。这就像把书本里的文字变成了一种特殊编码,让计算机能快速找到相关的部分。

· 智能检索模块:根据用户的问题,从海量的向量数据中高效找出最相关的文本片段。这是RAG的核心,确保AI能找到“对症下药”的依据。

· LLM集成接口:无缝对接主流的大型语言模型,将检索到的信息和用户问题结合,让AI生成精准的答案。这就像给AI装上了“参考书”和“理解能力”,让它能根据参考书的内容来回答问题。

· 一键式部署与配置:极大地简化了RAG系统的搭建过程,让开发者无需深入技术细节也能快速上线。让原本复杂的技术变得像打开开关一样简单,节省大量开发时间和精力。

产品使用案例

· 在一个初创公司,需要为内部技术团队构建一个能快速查询代码规范和最佳实践的系统。使用Ocrisp,开发者将现有的技术文档上传,OCRisp自动处理并建立检索索引,团队成员可以直接用自然语言提问,比如“如何处理用户登录错误?”,AI就能从文档中检索相关内容并给出答案。这解决了信息查找分散、效率低下的问题。

· 一位独立开发者正在开发一个基于AI的写作助手,希望AI能够参考他过去的博客文章来生成新的内容。通过 Ocrisp,他可以将自己的博客文章导入,让AI在创作新文章时,能检索并借鉴他已有的风格和观点,生成更符合他个人特色的内容,避免了“空洞的AI生成”。

· 一个小型电商平台需要一个能够回答关于产品详情、售后政策等问题的智能客服。使用Ocrisp,他们可以将产品手册、FAQ和退换货政策等信息整合,构建一个AI客服,能够准确回答用户关于“这款手机的防水等级是多少?”或“退货流程是怎样的?”等问题,提高了用户满意度和运营效率。

11

Ontosyn: 论文探索与智识聚合平台

作者

weyxie

描述

Ontosyn 是一个专为研究人员打造的现代化论文阅读器,它通过简洁的用户界面、创新的论文内导航(如书签、引用跳转回溯)以及集成的人工智能助手,极大地改善了管理和阅读学术论文的体验。AI助手不仅能理解用户需求,还能智能推荐相关论文并直接添加到用户的论文库中,从而帮助用户高效地追踪前沿研究并深入理解内容。

人气

点赞 8

评论数 0

这个产品是什么?

Ontosyn 是一个利用现代技术改进学术论文阅读和管理体验的平台。它解决了传统论文管理软件笨重、导航不便的问题。其核心创新点在于:1. **智能导航**:用户在阅读论文时,可以轻松地为重要部分添加书签,或者在点击参考文献跳转后,能快速回到原处,这就像是给论文装上了一个智能化的目录和回溯功能。2. **AI助手集成**:内置的AI助手不仅仅是一个聊天机器人,它还能根据你的论文库和阅读偏好,主动推荐你可能感兴趣的最新研究,并且可以直接一键加入你的库中。它还能理解你的具体需求,比如你昨天提到的按作者搜索推荐,我们一小时内就实现了,这代表了AI对用户需求的快速响应能力。你可以把它想象成一个24/7为你工作的学术研究助理。

如何使用它?

开发者可以将 Ontosyn 集成到他们的研究工作流程中,作为管理和消化海量学术文献的主要工具。 使用场景包括:1. **个人知识库构建**:在阅读过程中,将有价值的论文、重要段落标记下来,随时回顾。2. **快速信息检索**:利用AI助手,输入关键词或作者名,快速找到相关论文,无需在各大数据库间频繁切换。3. **研究前沿追踪**:AI助手会主动推送与你研究方向相关的最新成果,帮助你保持信息同步。 集成方式上,Ontosyn 提供了简洁的Web界面,用户可以直接通过浏览器访问,无需复杂的安装过程,就像使用任何在线服务一样方便。

产品核心功能

· 现代化论文阅读界面:提供清晰、无干扰的阅读体验,让用户更专注于内容本身,而不用被繁琐的界面分散注意力。

· 增强型论文内导航:允许用户设置书签,点击参考文献后能便捷地返回原句,极大地提高了在长篇论文中定位信息和追踪思路的效率。

· 集成AI研究助手:能够理解用户的研究兴趣,推荐高度相关的论文,并能根据用户反馈(如按作者搜索)快速响应并更新推荐结果,让你的论文发现过程更主动、更智能。

· 论文库管理:方便地组织、存储和搜索用户添加的论文,将零散的文献集中管理,构建个人或团队的研究知识库。

· 自动推荐相关论文:基于现有论文库和用户浏览历史,AI能够预测用户潜在的研究需求,主动推送可能感兴趣的、尚未发现的论文,节省用户大量挖掘时间。

· 一键添加论文至库:在AI推荐或用户发现感兴趣的论文时,只需简单点击即可将其加入到 Ontosyn 的个人论文库中,简化了文献收集流程。

产品使用案例

· 研究人员在撰写综述文章时,可以利用 Ontosyn 快速定位到之前阅读过的、与特定主题相关的论文,并找到关键引用,从而高效地梳理文献脉络。

· 一名工程师在研究某个新技术时,可以通过 Ontosyn 的AI助手输入技术关键词,获取一系列相关的最新学术论文,并迅速将有价值的论文加入到自己的研究库中,从而快速了解技术现状和发展趋势。

· 一位博士生在阅读大量论文时,可以使用 Ontosyn 的书签功能标记出关键的实验方法或结论,方便日后回顾和引用,同时AI助手也能帮助他发现可能被忽略但与其课题密切相关的其他研究。

· 项目团队可以共同使用 Ontosyn 构建一个共享的论文库,AI助手可以根据团队的整体研究方向推荐新论文,并支持团队成员快速分享和讨论,提高团队协作效率。

12

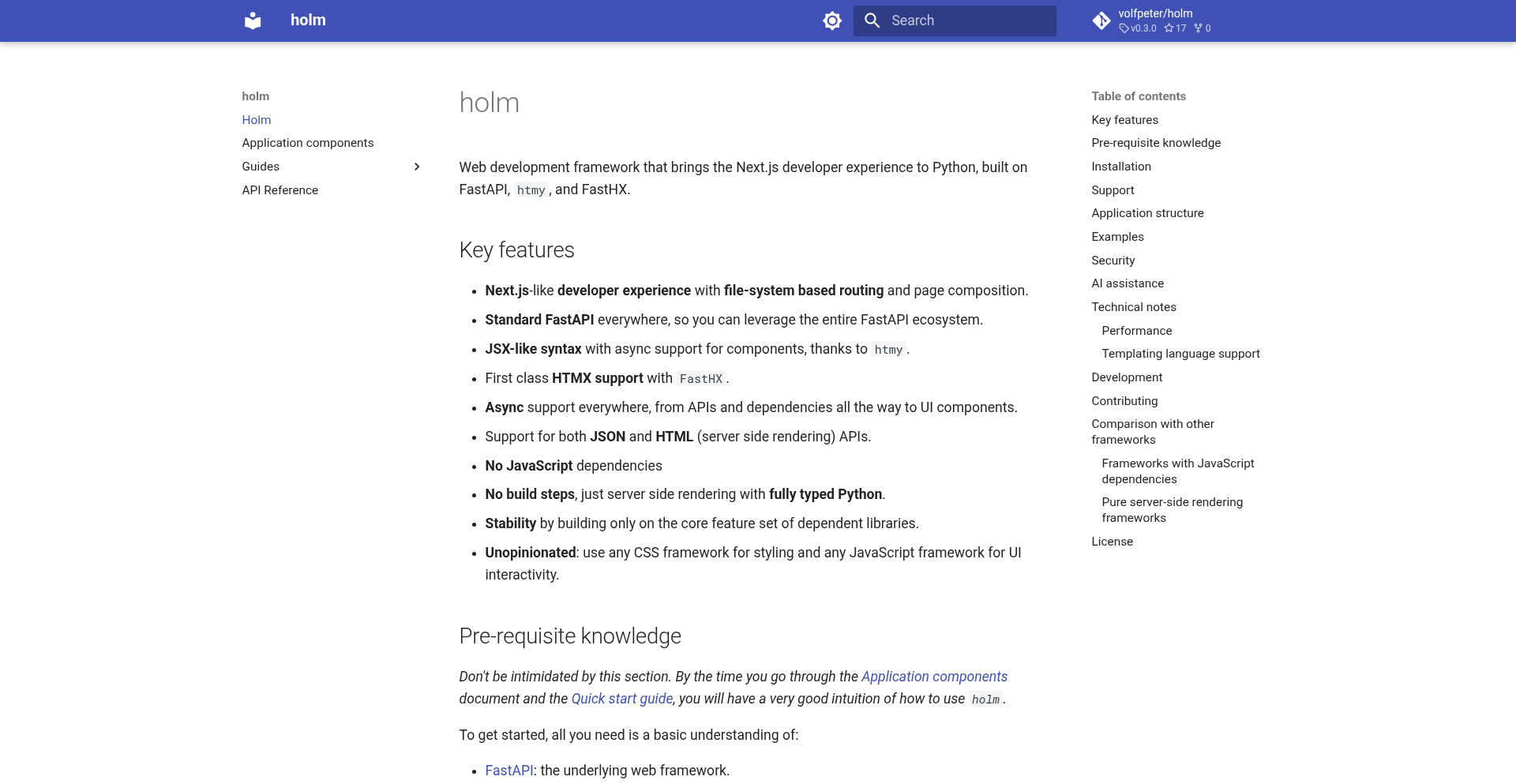

FastAPI-HTMX 幻影渲染器

作者

volfpeter

描述

这是一个非常早期的项目,但它为 FastAPI 服务端渲染提供了一个强大而便捷的方案。它像 Next.js 一样,能够利用 HTMX 的能力,在服务端直接生成富交互的 HTML 内容,从而让前端变得更轻量。解决了开发者需要在服务端和客户端之间频繁切换、管理大量 JavaScript 状态的痛点,让 Python 开发者也能轻松构建高性能、动态的 Web 应用。

人气

点赞 5

评论数 2

这个产品是什么?

这是什么项目?说明技术原理和创新之处,保持一定技术深度

这个项目可以被看作是 FastAPI 生态系统中一个创新的服务端渲染(SSR)解决方案。它巧妙地融合了 FastAPI(一个现代、快速的 Python Web 框架)和 HTMX(一个允许直接在 HTML 中使用 AJAX、CSS Transitions 等现代 Web 功能的库)。

其核心创新在于,它允许你在 Python 代码中,直接以声明式的方式构建响应给 HTMX 的 HTML 片段,而无需像传统的 JavaScript 框架那样,在客户端渲染。你可以想象成,你在 Python 里写 HTML,然后 FastAPI 帮你把这些 HTML 像魔法一样直接推送到浏览器,HTMX 再根据这些 HTML 动态地更新页面,而无需重新加载整个页面。

它解决了什么技术问题?

1. **减少客户端 JavaScript 复杂度:** 很多时候,页面的动态交互可以完全由服务端生成 HTML 来实现,这极大地减轻了前端 JavaScript 的负担,降低了开发和维护的难度。

2. **提升开发效率:** 对于熟悉 Python 的开发者来说,可以在熟悉的语言环境中完成复杂的 Web 交互逻辑,减少了上下文切换的成本。

3. **性能优化:** 服务端渲染通常能带来更好的首屏加载速度和 SEO 表现。

4. **与 FastAPI 无缝集成:** 项目依赖 FastAPI,这意味着你可以直接利用 FastAPI 的所有特性,如路由、依赖注入、数据验证等,而无需修改 FastAPI 本身。

如何使用它?

开发者怎么使用这个项目?给出技术使用场景和集成方式

开发者可以将这个项目集成到现有的 FastAPI 应用中,或者构建全新的 FastAPI 应用。

1. **依赖安装:** 首先,需要安装 FastAPI 和该项目依赖的其他库。

bash

pip install fastapi htmx httpx # 假设 htmx 是它的一个依赖

2. **服务端构建 HTML:** 在 FastAPI 的路由处理函数中,你可以使用该项目的库来生成 HTMX 兼容的 HTML 片段。例如,你可以定义一个 Python 函数,它返回一个包含动态内容的 HTML 字符串,这个字符串可以直接被 HTMX 识别并更新页面。

3. **前端集成 HTMX:** 在你的 HTML 模板(例如使用 Jinja2)中,需要引入 HTMX 库,并添加 HTMX 属性(如 `hx-get`, `hx-post`, `hx-target` 等)到需要交互的元素上。

**技术使用场景:**

* **构建动态表单:** 用户提交表单后,服务端根据数据动态生成新的表单项或显示结果,直接更新页面部分内容。

* **无限滚动加载:** 当用户滚动到页面底部时,HTMX 请求服务端,服务端返回新的内容列表,并动态追加到页面上。

* **实时更新:** 服务端主动向客户端推送更新,HTMX 接收到后更新特定 UI 区域。

**集成方式:**

你可以将其作为一个独立的渲染层,与 FastAPI 的路由紧密结合。当一个请求到达 FastAPI 时,路由函数会调用该项目的渲染逻辑,生成 HTML,然后通过 FastAPI 的响应返回给浏览器。HTMX 在浏览器端负责捕获这些响应并执行相应的 DOM 更新。

产品核心功能

· 声明式 HTML 构建:允许开发者用 Python 代码像写 HTML 一样构建动态的 UI 片段,从而实现服务端渲染。这让 Python 开发者可以用熟悉的语言编写前端逻辑,大大降低了开发门槛。

· HTMX 协议适配:项目能够生成 HTMX 能够直接理解和执行的响应,这意味着页面上的动态交互(如AJAX请求、部分内容更新)可以在服务器端直接完成,减少了客户端JavaScript的负担。

· FastAPI 原生集成:完全基于 FastAPI 构建,可以直接利用 FastAPI 强大的路由、中间件、依赖注入等特性,无需对 FastAPI 进行任何修改,实现平滑过渡和高性能。

· 减少客户端状态管理:通过将大部分 UI 逻辑迁移到服务器端,大大简化了客户端的状态管理,避免了复杂的 JavaScript 状态同步问题,使得构建可维护的 Web 应用变得更容易。

· 性能优化潜力:服务端渲染能够提升首屏加载速度,并且通过 HTMX 实现局部刷新,也避免了不必要的全页刷新,对应用性能有积极影响。

产品使用案例

· 一个电商网站的商品列表页面,用户点击“加载更多”按钮时,不需要刷新整个页面,而是通过 HTMX 请求后端,后端直接返回下一页的商品 HTML 片段,然后动态添加到当前列表下方,用户体验流畅。

· 一个用户管理后台,当管理员进行用户信息的增删改操作后,后端返回一个包含更新后用户列表的 HTML 片段,HTMX 接收到后直接替换掉页面上的旧列表,用户可以立即看到最新的数据。

· 一个带有评论功能的博客,当用户发布一条新评论后,后端渲染出新评论的 HTML,并将其插入到评论区的顶部,整个过程无需页面刷新,实现类似原生应用的实时反馈。

· 一个仪表盘应用,其中的图表或数据表格需要定期刷新。后端可以定时向 HTMX 发送更新指令,HTMX 接收到后,请求后端获取最新的数据 HTML 片段,然后更新对应的图表或表格区域,保持数据实时性。

13

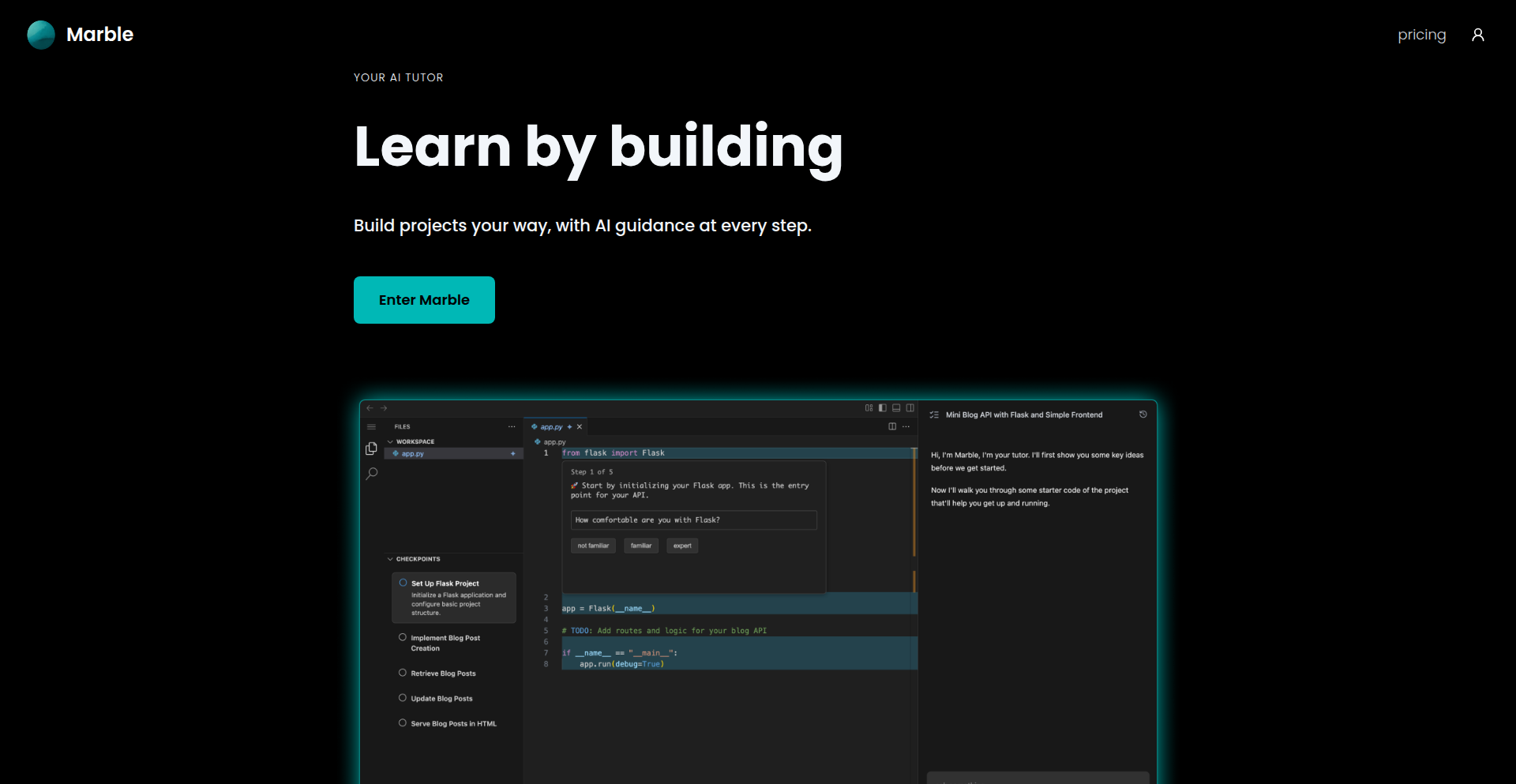

Marble: AI 驱动的深度学习代码探索器

作者

miguelacevedo

描述

Marble 是一个创新的 AI 工具,旨在帮助开发者更深入地理解端到端项目,而非仅仅依赖 AI 生成代码(“vibe-coding”)。它通过在云端的 VSCode 环境中,利用 AI 自动完成项目初始化、依赖配置和样板代码,让开发者能更快地专注于项目的核心挑战。Marble 不仅能生成可用的代码,更能通过 AI 驱动的交互,帮助开发者建立对项目架构和代码的深刻理解,实现高效的技术技能学习。

人气

点赞 5

评论数 1

这个产品是什么?

Marble 是一个基于 AI 的学习和开发工具,它打破了传统 AI 编码助手只关注“结果”而不关注“过程”的局限。它通过在云端一个高度定制化的 VSCode 环境中运行,利用 AI 来处理繁琐的初始化工作,比如安装必要的软件库(packages)和生成基础的代码框架(boilerplate code)。这意味着开发者可以跳过那些枯燥且耗时的准备步骤,直接投入到项目的核心逻辑和技术难点中。更重要的是,AI 不仅仅是代码的生产者,它还能成为一个智能的学习伙伴,帮助开发者理解代码背后的工作原理、架构设计,甚至能主动提出相关联的、能激发好奇心的问题,引导开发者进行更深入的探索。所以,Marble 的创新之处在于它把 AI 从一个单纯的代码生成器,变成了一个能够深度赋能开发者理解力和学习能力的智能导师。

如何使用它?

开发者可以在 Marble 中选择自己想要学习的新技术或技能,Marble 就会据此推荐一个适合的项目。一旦选择,Marble 会在云端为你准备一个配置好的 VSCode 开发环境,里面已经安装好了所有必需的软件库,并且预置了项目的启动代码。开发者可以直接在这个环境中开始编写核心的业务逻辑,或者让 AI 协助完成一些重复性的编码任务。在开发过程中,你可以随时与 AI 互动,询问关于代码、架构或者特定技术点的问题,AI 会给出解释,甚至指向相关的学习资源,帮助你构建完整的知识体系。这种方式极大地加快了学习新技术的速度,并确保学习是深入和扎实的。集成方式上,你可以直接在 Marble 的 Web 界面中使用,它提供了完整的开发环境,无需在本地进行复杂的配置。

产品核心功能

· AI 驱动的项目发现与启动:根据开发者想学习的技能,AI 推荐并自动初始化一个完整的项目,包括设置开发环境和安装依赖,让开发者能快速上手,解决“从零开始太麻烦”的问题。

· 自动化代码生成与辅助:AI 负责生成项目中的重复性、模式化的代码(boilerplate code),并可以根据指令完成具体的编码任务,从而节省开发者大量时间,让他们专注于更具创造性和挑战性的部分。

· 深度技术理解与学习:AI 不仅生成代码,还能解释代码的功能、架构,并提出引人思考的问题,帮助开发者建立对项目的深刻认知,解决“只知道怎么用,不知道为什么这样用”的学习困境。

· 云端集成开发环境:提供一个预配置好的、基于 Docker 的 VSCode 环境,开发者无需本地安装和配置,即可随时随地进行项目开发和学习,提高开发效率和灵活性。

产品使用案例

· 一个初级后端开发者想要学习 Go 语言和 gRPC:他可以在 Marble 中选择学习 Go 和 gRPC,Marble 会自动创建一个 Go 项目,并配置好 gRPC 服务端和客户端的骨架代码,安装所有必要的库。开发者只需专注于编写业务逻辑,AI 会解释 gRPC 的工作原理和通信机制,帮助他快速掌握这一技术栈。

· 一位前端工程师想要尝试新的 React 状态管理库 Zustand:在 Marble 中选择学习 Zustand,AI 会生成一个使用 Zustand 管理状态的 React 应用基础框架,并展示如何进行状态的创建、读取和更新。AI 还能解释 Zustand 的设计理念和优势,帮助开发者理解其适用场景。

· 一位全栈开发者想要快速构建一个原型来验证想法:他可以在 Marble 中描述他的想法,AI 会快速生成一个包含前后端基础代码的项目,比如一个简单的 REST API 和对应的前端界面。这使得开发者能迅速看到一个可运行的原型,而不是花费大量时间在搭建基础环境和编写重复代码上。

14

Mac空间记忆恢复器

作者

dailyanchovy

描述

这个项目通过一套脚本,让现代macOS系统恢复到经典macOS时代那种文件夹会记住自己位置和大小的“空间查找器”行为。它解决了现代macOS文件夹窗口位置和大小混乱的问题,让你能像使用人脑的空间记忆一样,更直观、高效地管理文件,从而提升工作效率。

人气

点赞 2

评论数 4

这个产品是什么?

这是一个能够让macOS文件夹窗口“记住”自己位置和大小的工具。在旧版的macOS中,每个文件夹打开时都会保持上次关闭时的窗口位置和尺寸,这利用了我们大脑出色的空间记忆能力,使得我们能快速找到并切换到熟悉的文件夹。但现代macOS版本改变了这种行为,导致每次打开文件夹时窗口位置和大小都可能随机变化,打断了我们的工作流程。这个项目就是通过一套脚本,重新实现并恢复了这种“空间记忆”功能,让每个文件夹窗口都能记住自己的“家”。

如何使用它?

开发者可以通过运行提供的一系列脚本来安装和启用这个功能。一旦脚本运行成功,macOS系统就会自动管理每个文件夹窗口的位置和大小。想象一下,你上次关闭一个项目文件夹时,它是在屏幕的左上角,并且是最大化状态,下次你再打开这个文件夹时,它就会自动出现在屏幕左上角并保持最大化,你无需重新调整,可以直接开始工作。这就像给文件管理加了一个“智能助手”,能理解你的使用习惯。

产品核心功能

· 文件夹位置记忆:脚本会记录并恢复每个文件夹窗口上次关闭时在屏幕上的精确位置,让你能像回忆老朋友一样快速找到它。

· 文件夹大小记忆:脚本会保存并恢复每个文件夹窗口上次关闭时的尺寸,保证你每次打开都能看到熟悉的窗口布局,无需反复缩放。

· 空间记忆优化:通过恢复这种行为,充分利用人脑的空间记忆能力,减少在文件查找和切换过程中大脑的负担,让你能更专注于实际工作内容。

产品使用案例

· 场景:程序员经常需要同时打开多个项目文件夹,例如一个用于代码编辑器,一个用于文档,一个用于资源文件。在现代macOS中,这些窗口经常会重叠或随机排列,需要花费时间去整理。使用这个工具后,每个项目文件夹打开时都会回到它上次被放置的位置和大小,比如代码文件夹总是在屏幕的左侧,文档文件夹总是在右侧,大大提高了切换和查找效率。

· 场景:设计师在处理素材时,经常会打开包含图片的文件夹。如果每次打开都位置和大小都不同,寻找特定图片会变得困难。这个工具能让图片文件夹固定在某个屏幕区域,并保持合适的显示大小,使得设计师可以更流畅地浏览和管理素材,减少视觉干扰。

· 场景:任何需要频繁操作大量文件夹的用户,比如内容创作者、数据分析师等。通过恢复文件夹的空间记忆,可以极大地减少他们因为窗口混乱而产生的挫败感,从而提升整体的工作效率和满意度。

15

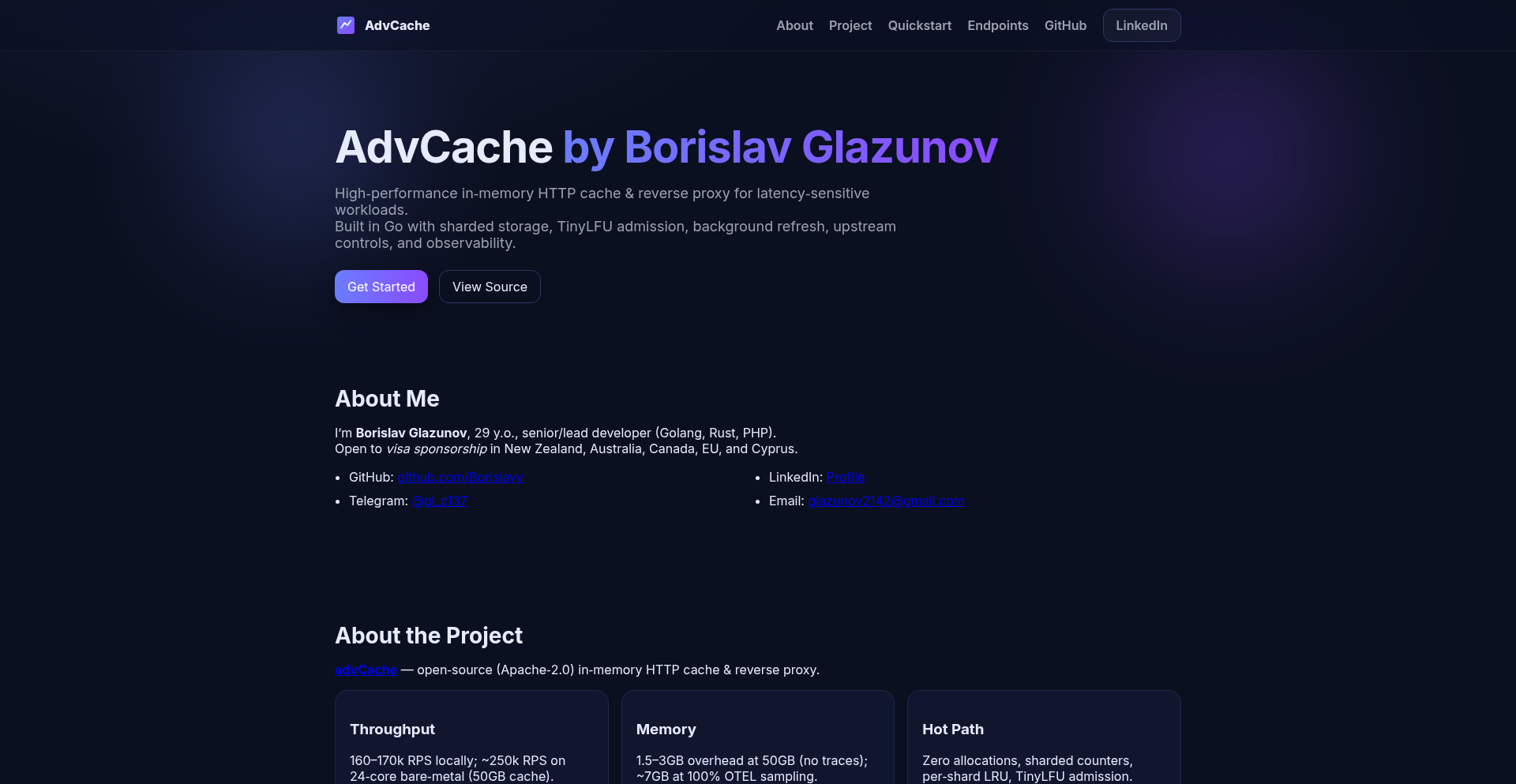

Hooch: 开源 HTTP 缓存与反向代理

作者

sanchez_c137

描述

Hooch 是一个开源项目,它提供了一个高效的 HTTP 缓存和反向代理功能。它能够智能地缓存网络请求的响应,并在后续的请求中直接提供缓存内容,从而显著提高应用程序的响应速度和降低服务器压力。同时,作为反向代理,它还可以作为前端接口,统一管理后端多个服务,提供负载均衡、SSL 终止等能力,让后端服务更加健壮和易于管理。

人气

点赞 4

评论数 1

这个产品是什么?

Hooch 是一个利用先进缓存策略和网络转发技术的软件。它就像一个聪明的“中间人”,帮助你的应用程序更快速地获取数据。当你的应用需要某个数据时,Hooch 会先检查自己有没有这个数据的“副本”(缓存)。如果有,它会立刻把副本给你,比去源头拿要快多了。如果没有,它会去源头拿,然后顺便把副本存起来,下次再用。反向代理的特性则意味着它可以站在你的多个后端服务前面,帮你处理所有进出的请求,就像一个大堂经理,分配工作,保护内部。它的技术核心在于高效的缓存算法,比如如何判断缓存是否失效,以及如何快速检索缓存,还有灵活的转发规则配置,让它能适应各种复杂的网络环境。所以这对我有什么用?它能让你的应用响应更快,用户体验更好,同时也能减轻你服务器的负担,省钱又省力。

如何使用它?

开发者可以将 Hooch 部署为一个独立的代理服务,然后在应用程序或客户端配置中,将所有对外部资源的 HTTP 请求指向 Hooch。例如,你可以在你的 Web 应用或移动应用的 API 调用配置中,将目标 URL 指向 Hooch 的地址。Hooch 会根据预设的规则来决定是直接从缓存提供服务,还是转发请求到真实的后端服务器。对于需要更精细控制的场景,开发者可以通过配置文件定义缓存策略(如缓存时长、缓存键的生成方式)、转发规则(如基于 URL 路径、请求头进行匹配转发)以及健康检查等。这使得 Hooch 能够无缝集成到现有的技术栈中,无论是微服务架构还是单体应用,都能从中获益。所以这对我有什么用?你可以轻松地让你的应用程序访问数据更快,并且能够更灵活地管理你的后端服务。

产品核心功能

· HTTP 缓存:通过将常用的请求响应存储在本地,显著减少重复的网络请求,提升数据访问速度。这对于频繁访问相同数据的场景非常有用,例如用户个人资料、产品列表等。

· 反向代理:作为前端入口,接收所有客户端请求,并根据配置将请求转发给后端的不同服务。这有助于统一 API 接口、实现负载均衡、提升安全性,并简化后端服务的部署和管理。例如,你可以用它来为你的多个微服务提供一个统一的入口。

· 请求/响应拦截与修改:在请求到达后端或响应返回给客户端之前,Hooch 可以进行中间处理,例如修改请求头、响应头,甚至修改响应体内容。这为实现一些定制化需求提供了便利,比如添加认证信息、压缩响应数据等。

· 健康检查与负载均衡:Hooch 可以监控后端服务器的健康状况,并将请求智能地分发给健康的服务器,确保服务的可用性。这对于构建高可用性的系统至关重要。

· SSL 终止:Hooch 可以处理 SSL/TLS 加密和解密,将加密的 HTTPS 请求解密后转发给后端,后端服务无需处理 SSL,从而简化配置并提高性能。

产品使用案例

· 提升静态资源加载速度:将网站的 CSS、JavaScript、图片等静态资源通过 Hooch 进行缓存,当用户再次访问时,直接从 Hooch 的缓存中加载,用户打开网页的速度会飞快,体验更好。

· 优化 API 调用性能:如果你的应用频繁调用同一个 API 来获取数据(比如商品列表、用户排行榜),Hooch 可以缓存这些 API 的响应,下次请求时直接返回缓存数据,大大缩短用户等待时间,尤其在移动网络环境下效果显著。

· 简化微服务管理:当你的应用由多个微服务构成时,Hooch 可以作为统一的入口,将不同请求路由到对应的微服务,并且可以对这些微服务进行负载均衡,即使某个服务出现问题,也不会影响整体服务的可用性。

· 实现动态内容缓存:对于一些不经常变动但又需要动态生成的页面内容(如新闻头条、热门话题),Hooch 也可以进行缓存,当内容变化不频繁时,就能显著减少后端生成页面的压力,提高响应速度。

· 安全加固与性能优化:利用 Hooch 进行 SSL 终止,可以让你不必在每个后端服务都配置 SSL 证书,集中管理更方便,同时 Hooch 还可以进行一些基础的安全防护,比如阻止恶意请求,并对响应进行压缩,进一步提升用户体验。

16

RGB贪吃蛇键盘游戏引擎

作者

lightofshadow

描述

这是一个基于Linux和OpenRazer驱动的Python脚本,它允许用户在Razer键盘上玩经典的贪吃蛇游戏。通过利用键盘上的RGB灯光,将每个按键变成游戏中的像素点,将键盘变成了一个巨大的游戏屏幕。这是一种极具创意地利用硬件特性的技术实验,将游戏体验从屏幕延伸到了物理键盘上。

人气

点赞 3

评论数 2

这个产品是什么?

这是一个利用Razer键盘RGB灯光实现贪吃蛇游戏的Python项目。它通过OpenRazer开源驱动,能够控制键盘上每一个按键的颜色。游戏逻辑在Python脚本中运行,并将蛇的移动、食物位置等信息转化为对应的按键灯光变化,最终在键盘上“绘制”出游戏画面。其创新之处在于将一个二维游戏巧妙地映射到键盘这一独特的输入/输出设备上,变废为宝,赋予了键盘全新的交互可能性。

如何使用它?

开发者可以在Linux系统上安装OpenRazer驱动,然后下载并运行这个Python脚本。脚本会读取用户的键盘输入来控制蛇的移动(上下左右),并将游戏状态同步到键盘的RGB灯光上。例如,蛇身会显示为一种颜色,食物为另一种颜色,背景则可能是默认色。对于有Razer键盘的开发者来说,这提供了一种无需额外显示设备,即可获得沉浸式游戏体验的独特方式,也可以作为学习键盘硬件交互和RGB控制的绝佳起点。

产品核心功能

· 键盘RGB动态渲染:通过OpenRazer驱动,能够实时改变键盘上每个按键的颜色,将键盘变成动态的游戏屏幕,这对于展示游戏状态和提供视觉反馈非常有价值。

· 游戏逻辑核心实现:内置经典的贪吃蛇游戏逻辑,包括蛇的移动、吃到食物增长、碰撞检测等,能够独立运行并提供完整的游戏体验,这是所有游戏类应用的基石。

· 键盘输入事件捕获:能够监听并响应用户键盘输入,将按键动作转化为游戏中的控制指令,确保了游戏的交互性和可玩性,这对于任何需要用户输入的程序都至关重要。

· 跨平台驱动集成:利用OpenRazer驱动,使得项目能在Linux环境下兼容多种Razer键盘,这展示了利用现有开源驱动拓展硬件应用的可能性,为类似项目提供了集成思路。

产品使用案例

· 在Linux环境下,一名Razer Ornata Chroma键盘用户想要一种新颖的娱乐方式。他安装了OpenRazer驱动,然后运行了这个Python脚本。他的键盘立刻变成了一个小型的游戏屏幕,他可以通过键盘按键操控蛇在键盘上“游动”吃食物,每一个灯光闪烁都对应着游戏中的一个动作,带来了前所未有的沉浸感。

· 一位开发者想要探索如何在键盘上实现更丰富的交互。他将此项目作为灵感来源,研究了其如何利用RGB灯光模拟像素显示,并尝试将其扩展到更复杂的图形展示,例如简易的动画播放器或状态指示器,将键盘的潜力发挥到极致。

· 另一个场景是,作为一种趣味性的技术演示,在技术聚会或Hackathon上,展示如何用代码将普通硬件变成一个游戏设备,吸引眼球并激发社区对键盘硬件功能挖掘的兴趣,展示黑客精神的创造力。

17

高薪IT人才对接平台

作者

IOZ

描述

这是一个专为年薪10万美元起步的IT职位设计的招聘平台。其技术创新在于利用了特定的数据筛选和匹配算法,旨在高效地将高技能的IT专业人才与提供优厚薪资的企业连接起来,解决传统招聘平台在高端人才匹配效率上的痛点。它不仅仅是发布招聘信息,更是一种精准的供需双方的价值对焦。

人气

点赞 2

评论数 3

这个产品是什么?

这是一个专注于高端IT人才招聘的平台。其技术核心在于一套智能的职位和人才匹配系统。平台会分析职位描述中的关键技术栈、经验要求、以及薪资范围(明确设定10万美金起),同时也会对求职者的简历进行深度解析,识别其技能匹配度、过往项目经验以及职业发展期望。通过这种精细化的数据挖掘和算法比对,它能够更准确地找出最适合这些高薪职位的候选人,减少双方在海量信息中筛选的时间和精力。所以这对我有什么用?对于企业,这意味着能更快地找到符合要求的高级人才;对于求职者,意味着能看到更多真正符合自己身价的职位,避免在不匹配的岗位上浪费时间。

如何使用它?

开发者可以通过两种主要方式使用这个平台。第一,作为招聘方,你可以发布年薪10万美金起的高端IT职位。平台会引导你详细描述职位需求,包括所需的技术栈(如Python, Go, Kubernetes, AWS, AI/ML等)、项目经验、领导力要求等。一旦发布,平台就会开始利用其算法为你寻找潜在的匹配候选人。第二,作为求职者,你可以创建或上传你的详细简历,标记你的技能、经验、项目成果以及期望的薪资范围。平台会主动向你推荐符合条件的职位。此外,你也可以主动浏览平台上发布的职位,与潜在雇主建立联系。所以这对我有什么用?无论你是想招聘顶尖人才还是寻找高薪机会,这个平台都能为你提供一个高度聚焦且高效的对接环境。

产品核心功能

· 智能职位与人才匹配引擎:利用自然语言处理(NLP)技术解析职位描述和简历,识别关键技术词汇、经验水平和薪资期望,实现高精度匹配,大大节省双方筛选时间。

· 高薪职位聚焦:平台专注于年薪10万美金起步的IT职位,确保用户接触到的都是市场上具有竞争力的机会或候选人。

· 数据驱动的招聘洞察:提供关于高端IT人才市场趋势、热门技术栈和薪资水平的分析,帮助企业制定更有效的招聘策略。

· 个性化职位推荐:为求职者提供基于其技能和经验的定制化职位推荐,确保推荐的准确性和相关性。

· 安全高效的沟通渠道:提供便捷的平台内沟通工具,促进招聘方和候选人之间的直接交流,简化招聘流程。

产品使用案例

· 一家快速发展的SaaS公司需要招聘一名经验丰富的云原生架构师,要求精通Kubernetes和微服务设计,年薪15万美金。公司在传统招聘网站上耗费大量时间,但收效甚微。使用From100k后,平台迅速推送了多名符合技术要求且薪资期望匹配的候选人,公司在两周内就完成招聘。

· 一名拥有8年经验的AI算法工程师,擅长深度学习模型开发和部署,期望年薪12万美金以上。他发现许多通用招聘平台上的AI岗位薪资不高或要求过于宽泛。在From100k上,他很快找到了几家提供他期望薪资且专注于前沿AI研究的科技公司,并成功获得面试机会。

· 一家初创企业正在寻求一名有创业经验的CTO,负责技术团队组建和产品路线规划,年薪设定为20万美金。通过From100k,他们能够定向搜索拥有相似背景和高层管理经验的候选人,快速找到了几位极具潜力的合适人选,为公司的快速发展奠定了技术基础。

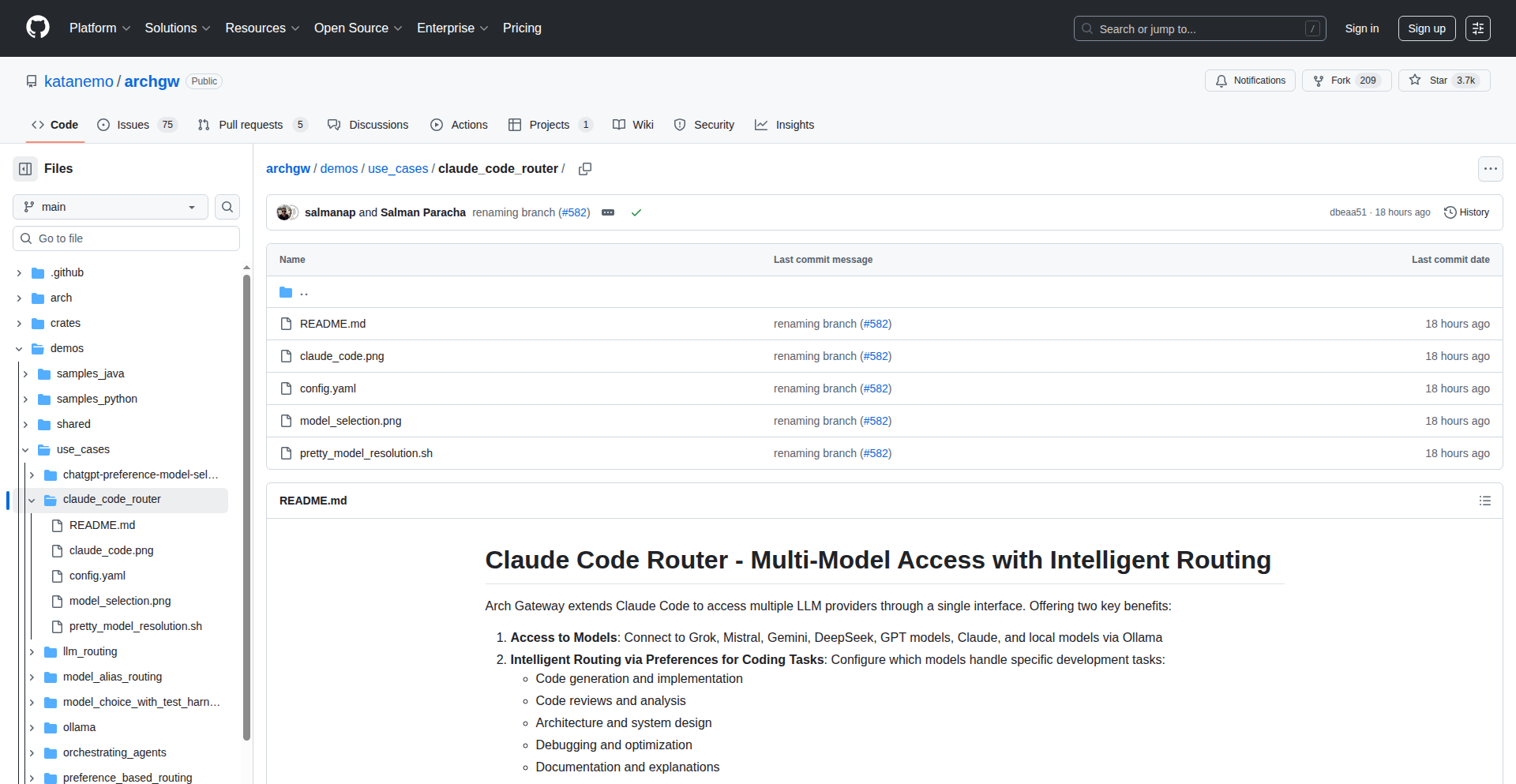

18

Arch Gateway: 智能代码助手路由

作者

adilhafeez

描述

Arch Gateway 是一个命令行工具,它能根据你的个人喜好和具体任务,自动选择最适合的AI模型来帮你写代码、检查代码、调试代码或设计系统。它不像其他工具那样只看模型跑分,而是让你自己说了算,选择最懂你的AI,所以它能更精准地解决你的编程难题。

人气

点赞 4

评论数 1

这个产品是什么?

Arch Gateway 是一个非常聪明的代码助手调度中心。想象一下,你有好几个不同特长的大语言模型(LLM),比如一个擅长写生成代码,另一个精通代码审查,还有一个特别能找出Bug。Arch Gateway 的核心技术在于它不是简单地把你的指令扔给某一个模型,而是有一个“智能中间层”来分析你的需求(比如你是想写一段新代码,还是想修复一个错误)。然后,这个中间层会根据你事先设定的偏好(比如你更喜欢某个模型生成的代码风格,或者某个模型响应更快),将任务精确地分配给最合适的那一个AI模型。它就像一个懂你的项目经理,能把任务交给最对口的员工,所以你的代码开发效率和质量都能提升。

如何使用它?

开发者可以将Arch Gateway作为一个命令行界面(CLI)集成到他们的日常开发流程中。你只需要在命令行中输入你的编程需求,例如‘生成一个Python函数来读取CSV文件’或者‘检查这段JavaScript代码是否存在潜在的安全问题’。Arch Gateway 会根据你配置的模型优先级和任务类型,自动调用内部的路由逻辑,选择一个或多个最适合的LLM来完成你的指令,并将结果返回给你。你可以将其看作是你在本地运行的一个AI编程助手,通过简单的命令就能享受到多个顶尖AI模型的服务,而无需手动切换不同的服务和平台。

产品核心功能

· 统一模型接入:让你能从一个地方使用Claude Code, Grok, Mistral, Gemini, DeepSeek, GPT,甚至你本地运行的Ollama模型。这意味着你不用记住多个API密钥和接口,就能享受到不同AI模型的优势。

· 任务导向智能路由:能够根据你执行的具体任务(如代码生成、代码审查、Bug调试、系统设计)来选择最擅长该任务的AI模型。这样可以确保你得到的建议和代码是最贴切、最高效的,解决你“用错AI导致效果不佳”的问题。

· 个性化模型偏好设置:不同于依赖通用的跑分数据,Arch Gateway允许你根据自己的主观感受和实际需求来设定模型优先级。例如,你可能觉得某个模型的代码更易读,或者某个模型的响应速度更符合你的工作习惯,你可以将其排在前面,从而获得更符合个人需求的AI助手。

· 跨模型能力协同:潜在地,Arch Gateway可以设计成能够将复杂任务分解,并分配给不同的模型处理,然后将结果整合。例如,一个模型生成初稿,另一个模型进行优化,再由第三个模型进行最终审查,最终交付一个高质量的成果,解决你“单个AI模型能力有限”的痛点。

产品使用案例

· 开发者在写一个新的后端API时,可以对Arch Gateway说:“帮我设计一个RESTful API接口,用于用户认证。” Arch Gateway可能会根据你设定的偏好,将“系统设计”任务交给一个更擅长架构的AI模型,并返回设计建议。

· 当你在项目中遇到一个棘手的Bug,你可以将相关代码片段和错误信息提供给Arch Gateway,并询问:“请帮我找出这段代码中的Bug,并给出修复建议。” Arch Gateway会选择一个在调试方面表现出色的模型来分析,并提供解决方案,帮你快速定位和解决问题。

· 如果你在为前端组件编写新的功能,你可以要求Arch Gateway:“生成一段React代码,实现一个带有搜索过滤功能的表格。” Arch Gateway会选择一个在前端框架代码生成方面更强的模型来完成,确保代码的质量和可维护性。

· 在进行代码重构时,你可以将一段需要优化的代码提交给Arch Gateway,并指示:“请审查这段代码,并提出优化建议,使其更具可读性和效率。” Arch Gateway会选择一个精通代码审查和优化的模型来处理,帮助你提升代码质量。

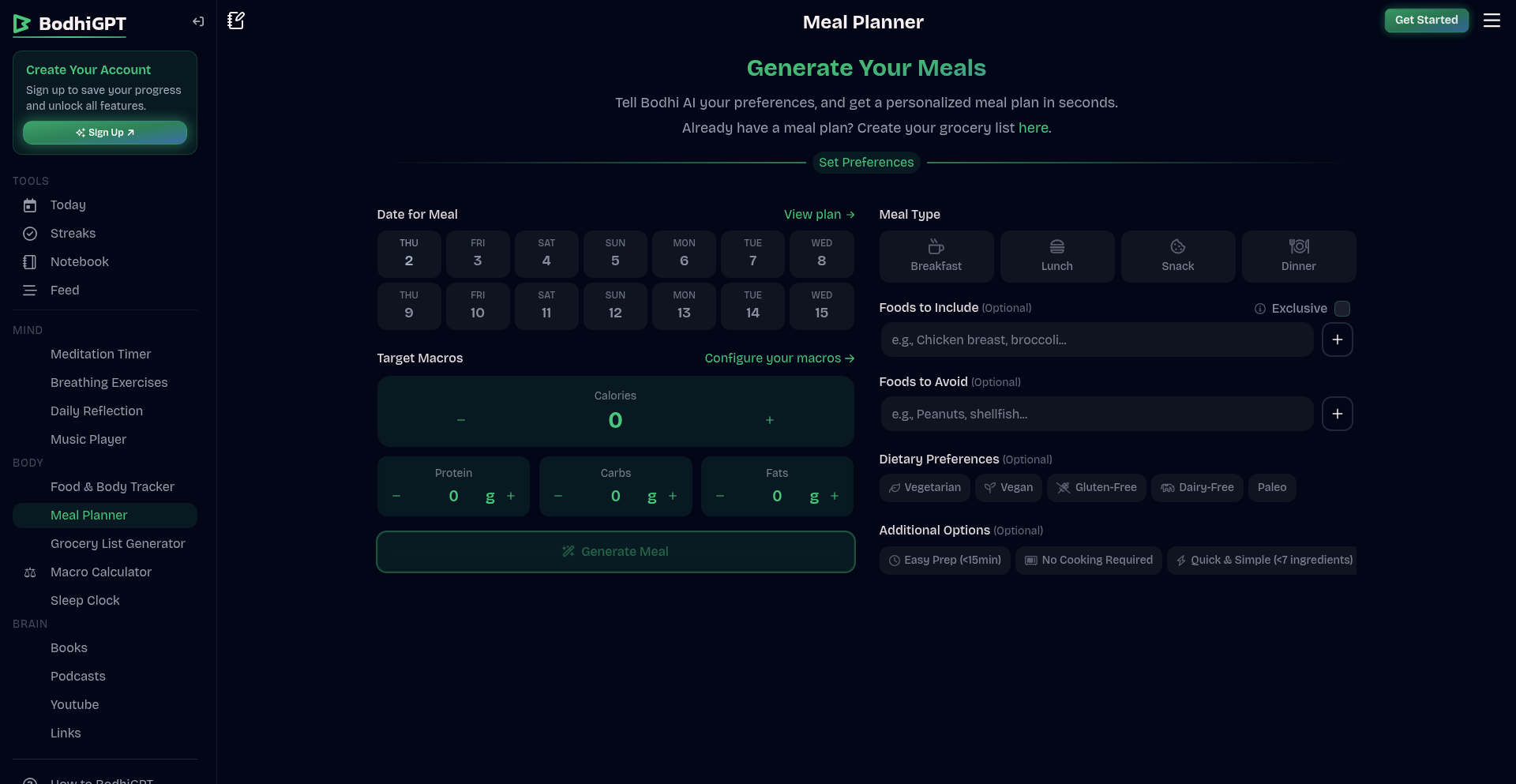

19

AI餐谱智造器

作者

whatcha

描述

一个基于人工智能的自动餐谱生成工具,它能够根据用户输入的偏好(如食材、饮食限制、口味等)生成个性化的膳食计划。项目的技术创新在于其对自然语言处理(NLP)和推荐算法的巧妙结合,能够理解用户的非结构化输入,并输出结构化、有创意的菜谱建议,从而解决人们在日常饮食规划中遇到的“吃什么”的难题。

人气

点赞 3

评论数 1

这个产品是什么?

这是一个利用AI(人工智能)技术,像大厨一样为你量身定制每日三餐的系统。它不是简单地查找菜谱,而是能理解你喜欢什么、不能吃什么(比如过敏或减肥需求),然后“创作”出符合你口味和需求的餐谱。它的核心技术是AI,特别是自然语言理解,能读懂你用大白话说出来的想法;还有一个聪明的推荐系统,就像一个经验丰富的营养师,知道如何搭配食材和营养。所以,它能让你的饮食计划既有创意又实用,省去你绞尽脑汁想菜谱的时间。

如何使用它?

开发者可以将这个AI餐谱智造器集成到自己的应用中,比如健身App、健康管理平台,或者智能厨房设备。你可以通过API(一种让不同软件之间互相沟通的接口)将用户输入的食材、饮食偏好、过敏信息等发送给AI餐谱智造器,然后它会返回一个包含菜谱名称、食材列表、烹饪步骤和营养信息的JSON格式数据。这样,你的应用就能为用户提供智能的用餐建议,提升用户体验。

产品核心功能

· 个性化餐谱生成:根据用户输入(如食材、饮食习惯、过敏原、烹饪时间偏好)自动生成每日或每周的餐谱。技术上,它利用NLP理解用户需求,并结合推荐算法匹配最合适的菜谱,解决用户“今天吃什么”的烦恼。

· 智能食材推荐:根据已有的食材,推荐可以制作的菜谱。这能帮助用户充分利用现有食材,减少浪费,体现了AI在资源优化上的价值。

· 营养均衡分析(潜在扩展):未来可以加入营养成分分析,确保餐谱的营养搭配合理。这为健康饮食提供了科学依据。

· 多样化菜谱库:AI能够学习和生成大量不同风格的菜谱,提供丰富的选择。这为用户带来新鲜感,避免饮食单调。

产品使用案例

· 一个健身App可以通过集成AI餐谱智造器,为用户提供符合其健身目标的个性化饮食计划。例如,对于需要增肌的用户,AI可以生成高蛋白、低脂肪的餐谱,直接解决了用户在获取专业饮食建议方面的障碍。

· 一个健康管理平台可以利用此工具,为有特殊饮食需求(如糖尿病、素食主义)的用户生成安全、健康的餐谱。这使得平台能够为更广泛的用户群体提供服务,并有效解决他们对饮食安全的顾虑。

· 智能冰箱设备可以通过连接AI餐谱智造器,根据冰箱内现有食材推荐菜谱,并自动生成购物清单。这大大提升了厨房的智能化程度,解决了用户因不清楚冰箱内有什么而产生的用餐规划难题。

20

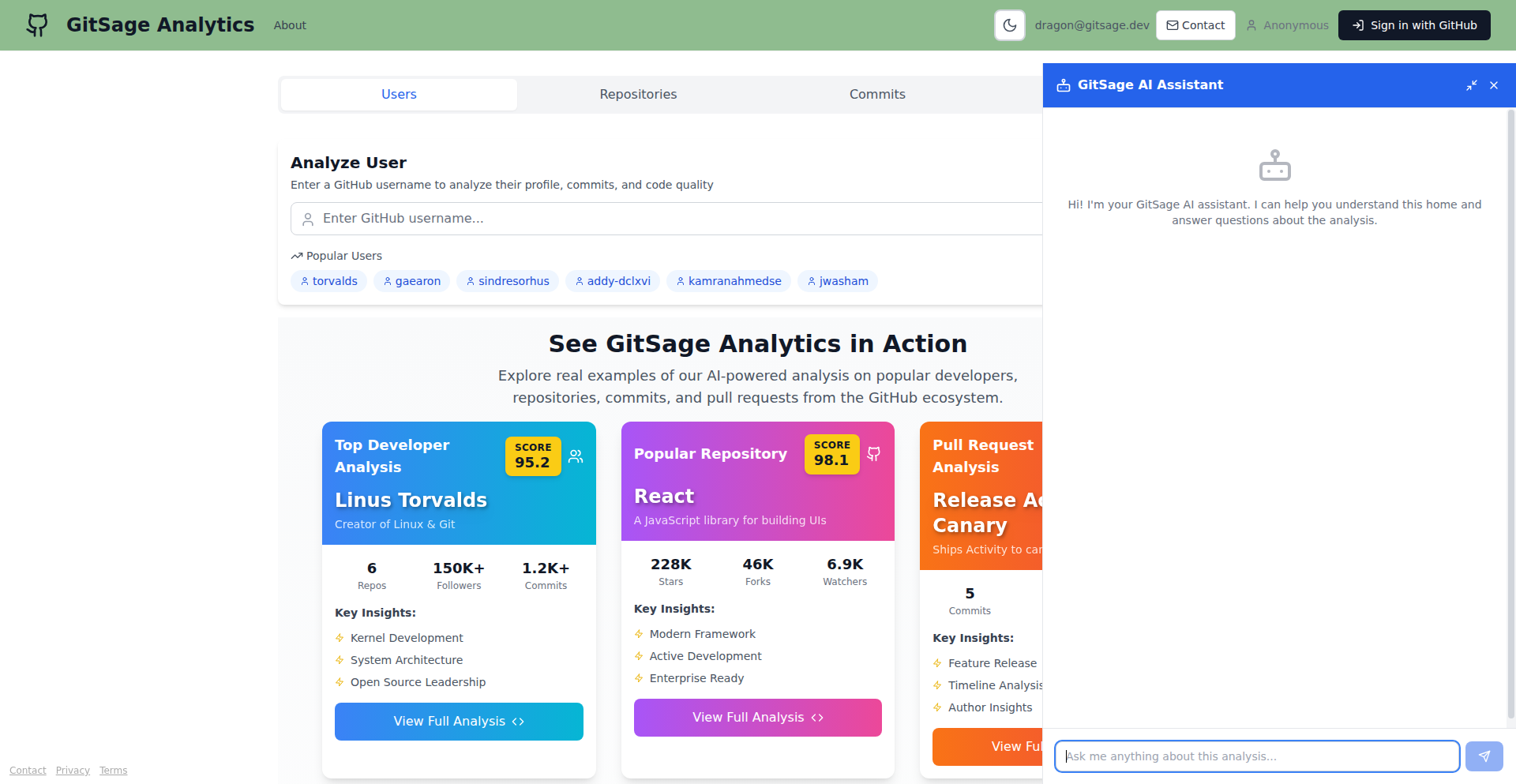

AI代码洞察引擎 GitSage

作者

adamthehorse

描述

GitSage 是一个利用人工智能(AI)来帮助开发者理解和探索不熟悉的代码库和项目。它通过AI代理,能够让你像与经验丰富的开发者交流一样,提问关于某个开源项目(比如React)的技术细节、当前开发活跃度等问题,并从中获得清晰的解释。它解决了开发者在面对庞大复杂代码时不知从何入手,或不知道向谁请教的难题,让你能快速抓住核心。

人气

点赞 4

评论数 0

这个产品是什么?

GitSage 是一个基于AI的代码探索和分析工具。它的核心技术是将大型、复杂的开源项目(比如一个前端框架或一个后端服务)的代码内容,通过AI进行“消化”和“理解”。当你想了解一个不熟悉的库时,你可以直接用自然语言向GitSage提问,例如“React最新开发在关注哪些技术点?”或者“这个库的XXX功能是如何实现的?” GitSage会利用AI分析项目代码和开发动态,给出相对直接和有针对性的回答。这就像是拥有一个24/7在线的、对代码库非常了解的AI助手,帮你快速导航和理解技术细节,而不需要你深入阅读成千上万行的代码。它的创新之处在于将AI的强大语言理解和信息提取能力,直接应用到代码库的深层解析上,让代码的可访问性和可理解性大大增强。

如何使用它?

开发者可以使用GitSage来加速学习新库、理解现有项目、查找特定问题的解决方案。你可以直接访问GitSage的平台(目前是免费的),输入你感兴趣的项目名称(如GitHub仓库地址)或直接提出关于项目的问题。例如,如果你在工作中需要使用一个你从未使用过的第三方库,你可以问GitSage:“这个库的核心API是什么,有什么需要注意的坑吗?” GitSage会分析该库的代码,并给你一个简洁明了的回答,让你快速上手,节省了大量查阅文档和猜测的时间。未来,它还将集成GitHub MCP(可能是指GitHub的某种代码分析或管理服务),进一步提升代码理解的深度和广度,方便开发者在更复杂的开发流程中集成使用。

产品核心功能

· AI驱动的代码库理解:利用AI技术解析代码结构、功能模块和技术实现,让开发者即使不熟悉该代码也能快速理解其核心逻辑,解决“看不懂代码”的痛点。

· 自然语言交互式查询:开发者可以用日常语言提问关于项目的问题,AI会从代码中提取相关信息并给出解答,大大降低了信息获取的门槛,就像在和一个领域专家对话。

· 项目开发动态分析:AI能够分析项目的提交历史、活跃度和开发趋势,帮助开发者了解项目的健康状况和未来发展方向,从而做出更明智的技术选型决策。

· 开发者画像与协作指引(未来功能):通过分析代码贡献和开发者行为,GitSage有望帮助识别项目中关键的开发者和技术贡献者,为协作和寻求帮助提供指引。

· 集成GitHub MCP(未来功能):通过集成GitHub的先进服务,进一步提升代码的解析深度和范围,可能实现更精细化的代码审计、安全分析或性能洞察。

产品使用案例

· 场景:新入职的开发者需要快速理解一个庞大的遗留项目。 问题:不知从何处入手,文档缺失或过时。 解决方案:使用GitSage,向AI提问“项目的主要模块有哪些?它们之间的关系是什么?”,GitSage会提炼出项目架构概要,帮助开发者迅速建立全局观。

· 场景:开发者在项目中遇到一个棘手的bug,需要查找是哪个第三方库出了问题。 问题:不确定是哪个库,且不熟悉该库的代码。 解决方案:将怀疑的库代码提交给GitSage,询问“这个库在处理XXX场景时,是否存在已知问题或性能瓶颈?”,AI会分析相关代码片段,给出可能的线索,加速问题定位。

· 场景:团队正在考虑引入一个新的前端框架,需要评估其技术可行性和社区活跃度。 问题:文档繁杂,人工分析耗时。 解决方案:让GitSage分析该框架的GitHub仓库,询问“该框架最近的开发重点是什么?哪些功能最常被修改?”,AI能提供关于开发活跃度和技术方向的洞察,辅助团队决策。

21

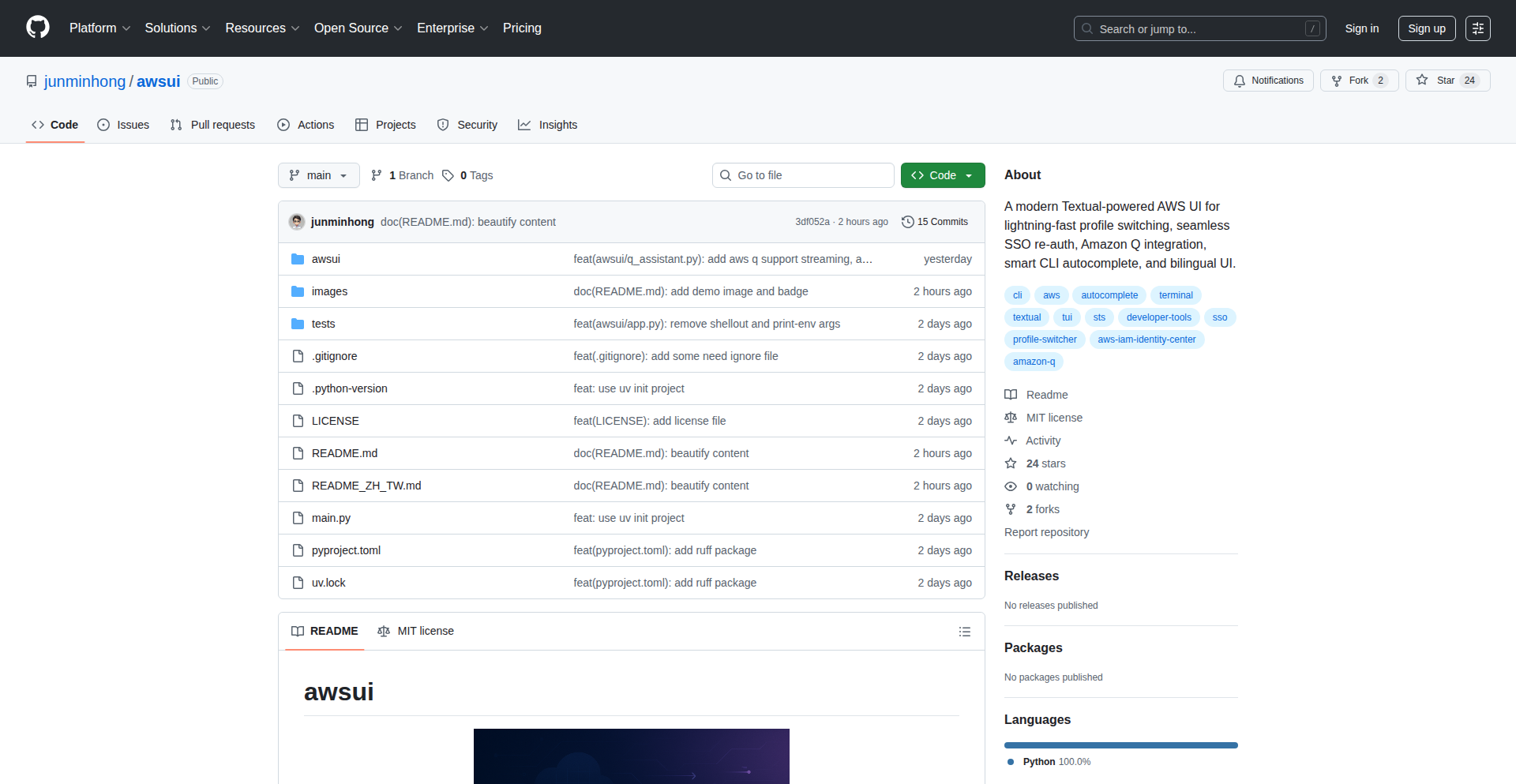

Awsui - 智能AWS CLI终端助手

作者

jasper_go

描述

Awsui 是一个为AWS(亚马逊云服务)用户打造的现代终端用户界面(TUI)工具。它解决了开发者在使用AWS CLI时频繁切换配置(profile)的痛点,并允许直接在图形界面中执行AWS命令,甚至与AWS Q(一个AI助手)进行交互。它的创新在于将复杂的AWS CLI操作可视化、便捷化,同时融入了AI能力,让云服务管理更高效、更直观。这对于需要管理多个AWS账户或项目、或者希望简化AWS操作流程的开发者来说,能极大地提升工作效率。

人气

点赞 4

评论数 0

这个产品是什么?

Awsui 是一个基于文本的用户界面(TUI)工具,它彻底改变了你与AWS CLI(命令行工具)的交互方式。想象一下,不再需要记住一长串复杂的命令和配置文件名,取而代之的是一个直观、交互式的命令行环境。它的核心创新是将AWS配置文件的管理和切换集成在一个易于浏览的界面中,并且你可以在这个界面里直接输入AWS命令,实时看到结果。更酷的是,它还能让你直接调用AWS Q,也就是说,你可以直接在终端里用自然语言向AWS提问或寻求帮助,比如‘帮我列出所有在us-east-1区域运行的EC2实例’,Awsui 就能帮你转化为AWS命令并执行。所以,它就像一个集成了AWS管理、命令执行和AI助手的超级终端,让复杂的云操作变得前所未有的简单。它能帮你省去记忆命令和配置的烦恼,快速准确地完成云服务管理任务。

如何使用它?

开发者可以在安装Awsui 后,通过简单的命令启动它。一旦启动,你就会看到一个清晰的界面,列出了你配置的所有AWS profile。你可以通过键盘导航快速选择和切换不同的profile,无需再手动编辑配置文件或输入繁琐的切换命令。选定profile后,你可以在底部的命令输入区域直接输入AWS CLI命令,比如 `aws ec2 describe-instances`,Awsui 会帮你执行并显示结果。对于与AWS Q的交互,你只需在特定模式下输入你的问题,Awsui 会将其发送给AWS Q并返回答案。这种方式特别适合在本地开发环境,需要频繁与AWS服务交互,或者进行日常的云资源管理和监控的开发者。它提供了比直接使用AWS CLI更友好的可视化体验和更高效的操作流程。

产品核心功能

· 多AWS Profile智能管理与快速切换:通过直观的列表和快捷键,开发者可以轻松选择和切换不同的AWS配置文件,无需记忆复杂的profile名称,节省了大量查找和输入的时间,特别适合管理多个项目或客户的AWS环境。

· 集成AWS CLI命令执行与结果展示:允许开发者在可视化的终端界面中直接输入和执行AWS CLI命令,并实时查看命令的输出结果,提高了命令输入的准确性和操作的流畅性,使云资源的管理和调试更加直观。

· 原生集成AWS Q AI助手:能够直接调用AWS Q进行自然语言交互,用户可以用简单易懂的语言提出问题或任务指令,Awsui将其转化为AWS操作,并返回结果,极大地降低了使用AWS服务的门槛,提升了问题解决的效率。

· 交互式命令补全与历史记录:提供了智能的命令补全功能,减少输入错误,加速命令的编写;同时保留命令历史记录,方便开发者回顾和重复执行常用命令,提升了日常操作的效率。

产品使用案例

· 开发者在切换不同客户的AWS账户时,只需在Awsui中选择对应的profile,即可快速安全地执行相关AWS命令,避免了因profile切换错误而导致的权限问题或操作失误,确保了工作的连续性和安全性。

· 一名SRE工程师需要在生产环境中快速查看某个EC2实例的详细信息,他可以直接在Awsui中输入 `aws ec2 describe-instances --instance-ids i-xxxxxxxxxxxxxxxxx`,并在终端中清晰地看到实例的状态、IP地址等关键信息,无需在多个终端窗口间切换。

· 一位AI/ML工程师需要快速查询在某个特定区域可用的GPU实例类型,他可以直接对Awsui中的AWS Q功能提问:“请列出在ap-southeast-1区域可用的GPU实例型号”,Awsui会将其转换为AWS CLI命令并返回答案,省去了查阅官方文档或手动执行命令的繁琐过程。

· 项目团队成员需要定期检查S3存储桶的使用情况,他们可以在Awsui中设置一个常用命令,并利用历史记录功能快速执行,确保所有团队成员都能方便、一致地管理云存储资源。

22

上下文式中文学习助手

作者

wayy

描述

这是一个智能工具,能让你通过阅读自己感兴趣的文章(比如Hacker News文章)来学习中文。它能根据你的中文水平(HSK等级)对文章进行选择性翻译,让你在熟悉的内容中学习新词汇。遇到不认识的字词,轻轻一点就能看到解释,帮助你更自然、高效地掌握中文,摆脱枯燥的死记硬背。所以这对我有什么用?让你告别死记硬背,通过阅读真正喜欢的内容来轻松学会中文。

人气

点赞 4

评论数 0

这个产品是什么?

这是一个创新的中文学习工具,它巧妙地将语言学习融入了你的日常阅读习惯。其核心技术在于一个能够智能识别你中文水平(通过HSK等级来衡量)的算法。当你输入或选择一篇英文文章后,它不会全部翻译,而是根据你的水平,只翻译那些你可能不认识的单词和短语,同时保留大部分你已经认识的内容。这样,你在阅读过程中就处于一个“恰到好处”的学习区,既能理解大意,又能主动接触和学习新知识。当你遇到遗忘的字词,只需双击或选中,即时弹出的定义会立刻帮你解决困惑。更棒的是,它还会记录你查阅过的词汇,为你构建个性化的学习词库,并根据你的进步情况,逐步引入更高级的词汇,实现更智能的学习路径。所以这对我有什么用?它提供了一种沉浸式的学习体验,让你在不知不觉中提升中文能力,让学习过程充满乐趣而非负担。

如何使用它?

开发者可以通过两种主要方式使用这个项目。第一种是直接访问其在线试用版(trylinden.com/chinese),粘贴你想要阅读的英文文章链接或文本,选择你的HSK等级,然后就可以开始阅读,并利用即时翻译和词汇记录功能。第二种是(虽然目前还处于早期阶段,但有计划)将其作为Chrome扩展集成,这样在你浏览网页时,就能自动检测并部分翻译你正在阅读的内容,实现无缝的学习体验。对于开发者而言,这意味着可以轻松地将这种“上下文学习”的能力应用到任何需要阅读大量英文材料以学习中文的场景,例如技术文档、新闻报道、博客文章等。所以这对我有什么用?你可以随时随地,将任何你感兴趣的英文内容变成你的中文学习教材,让碎片时间也变得高效有意义。

产品核心功能

· 选择性部分翻译:根据用户设定的HSK等级,智能地部分翻译文章内容,保留大部分已知词汇,实现“学以致用”,而不是“从零开始”。这能帮助用户在阅读过程中巩固已有知识,同时有效地引入新词。应用场景:阅读英文技术文章、新闻、博客等,同时进行中文学习。

· 即时词汇查询:用户只需双击或选中文章中的不认识的字词,即可立刻获得定义,无需离开当前阅读界面,保证了阅读的流畅性,降低了学习的干扰。应用场景:提高阅读效率,快速解决生词问题,从而更深入地理解文章内容。

· 个性化词汇追踪:工具会记录用户查阅过的词汇,形成个性化的学习词汇库,并跟踪用户的掌握情况,为后续的学习提供数据支持。应用场景:帮助用户回顾和复习,强化记忆,并为未来的智能词汇推荐打下基础。

· 智能词汇难度递进(计划中):根据用户对低级别HSK词汇的掌握程度,智能地引入更高一级的HSK词汇,确保学习的难度循序渐进,始终保持在用户的“最近发展区”。应用场景:实现更科学、更有效的语言学习路径规划,避免挫败感,持续保持学习动力。

产品使用案例

· 开发者需要阅读英文技术文档来了解某个新技术,但其中文水平刚达到HSK 3。使用该工具,可以将技术文档输入,工具会根据HSK 3的水平提供部分翻译,让开发者在理解核心技术概念的同时,学习到相关的专业中文词汇,而不是被大量生词阻碍。解决方案:通过上下文学习,开发者能够同时提升技术理解力和中文水平。

· 一位中文学习者喜欢阅读Hacker News上的创业和技术文章,但其HSK等级为4。他可以直接将喜欢的Hacker News文章链接提供给工具,工具会智能翻译掉其中HSK 4及以上级别的生词,让他能顺利读懂文章,并在这过程中学习到地道的中文表达和行业术语。解决方案:将兴趣爱好与语言学习结合,提升学习动力和效果。

· 某公司正在招聘一位有国际视野的工程师,需要阅读大量英文技术报告。工程师可以使用这个工具,将报告进行部分翻译,提高阅读效率,同时学习到行业内通用的英文技术术语的中文对应说法,为将来的跨国沟通打下基础。解决方案:提高专业领域的外语阅读能力,加速信息获取速度。

23

AI发牌官 Blackjack

作者

blcksearcher

描述

这是一个利用AI技术驱动的在线 Blackjack 游戏,它创新性地将流畅的用户体验与可交互的AI发牌官结合,解决了传统真人发牌直播模式下速度慢、UI体验差的问题。通过AI模拟真人发牌官,并能对玩家的互动做出反应,为玩家提供更快速、更具沉浸感的游戏体验,同时保留了与“人”互动的乐趣。

人气

点赞 3

评论数 1

这个产品是什么?

这是一个基于区块链(Solana)的在线 Blackjack 游戏,最核心的创新在于它使用了AI来扮演发牌官。与传统的真人荷官视频直播不同,AI发牌官能够全天候、更快速地响应玩家的动作,并且可以通过聊天与玩家互动。这种技术方案使得游戏界面更加流畅,用户体验媲美单机游戏,同时保留了真人游戏的趣味性。游戏资金采用非托管模式,玩家可以直接连接钱包进行充值和提现,资金安全有保障。

如何使用它?

开发者可以将此项目作为一个参考,学习如何将AI与游戏结合,尤其是在需要实时交互和模拟人机对话的场景。对于普通玩家,如果项目部署上线,只需连接Solana钱包,充值SOL币即可开始游戏。这个项目可以启发开发者思考如何构建更智能、更互动的游戏或应用。

产品核心功能

· AI发牌官模拟:利用AI技术模拟真人发牌官的发牌、洗牌等动作,实现更快速、更流畅的游戏流程。这解决了真人发牌官受限于人力和物理流程导致的游戏速度慢的问题。

· AI实时交互:AI发牌官能够根据玩家的游戏动作和聊天信息做出响应,增加游戏的趣味性和互动性。这弥补了纯粹的AI游戏缺乏人情味,以及真人直播效率低下的不足。

· 区块链集成:基于Solana链进行游戏,实现非托管的资金管理,玩家可以直接控制自己的资产,大大提升了资金的安全性。这意味着玩家的资金不会被平台方控制。

· 流畅的用户界面:设计了媲美手机应用的UI,让玩家无论在何种设备上都能获得极佳的游戏体验。这让游戏不再受限于笨重的网页端或视频流。

· 钱包连接与资产管理:支持直接连接Solana钱包进行充值和提现,简化了交易流程,并保证了资产的自主可控。这意味着玩家可以随时随地、安全地管理自己的游戏资产。

产品使用案例

· 在开发需要快速响应和实时反馈的在线棋牌类游戏时,可以借鉴AI发牌官的技术思路,用AI来处理游戏逻辑和事件,提高游戏效率。

· 对于希望在游戏中增加社交互动和个性化体验的开发者,可以学习AI发牌官如何与玩家进行自然语言交互,从而设计出更吸引人的NPC或游戏助手。

· 在构建去中心化金融(DeFi)应用时,可以参考其非托管的资金管理模式,为用户提供更安全、透明的资产操作方式。

· 如果你正在研究如何用AI来提升用户体验,这个项目展示了AI如何在一个原本严肃的交互场景中,提供娱乐性和趣味性,这对于用户粘性的提升非常有价值。

24

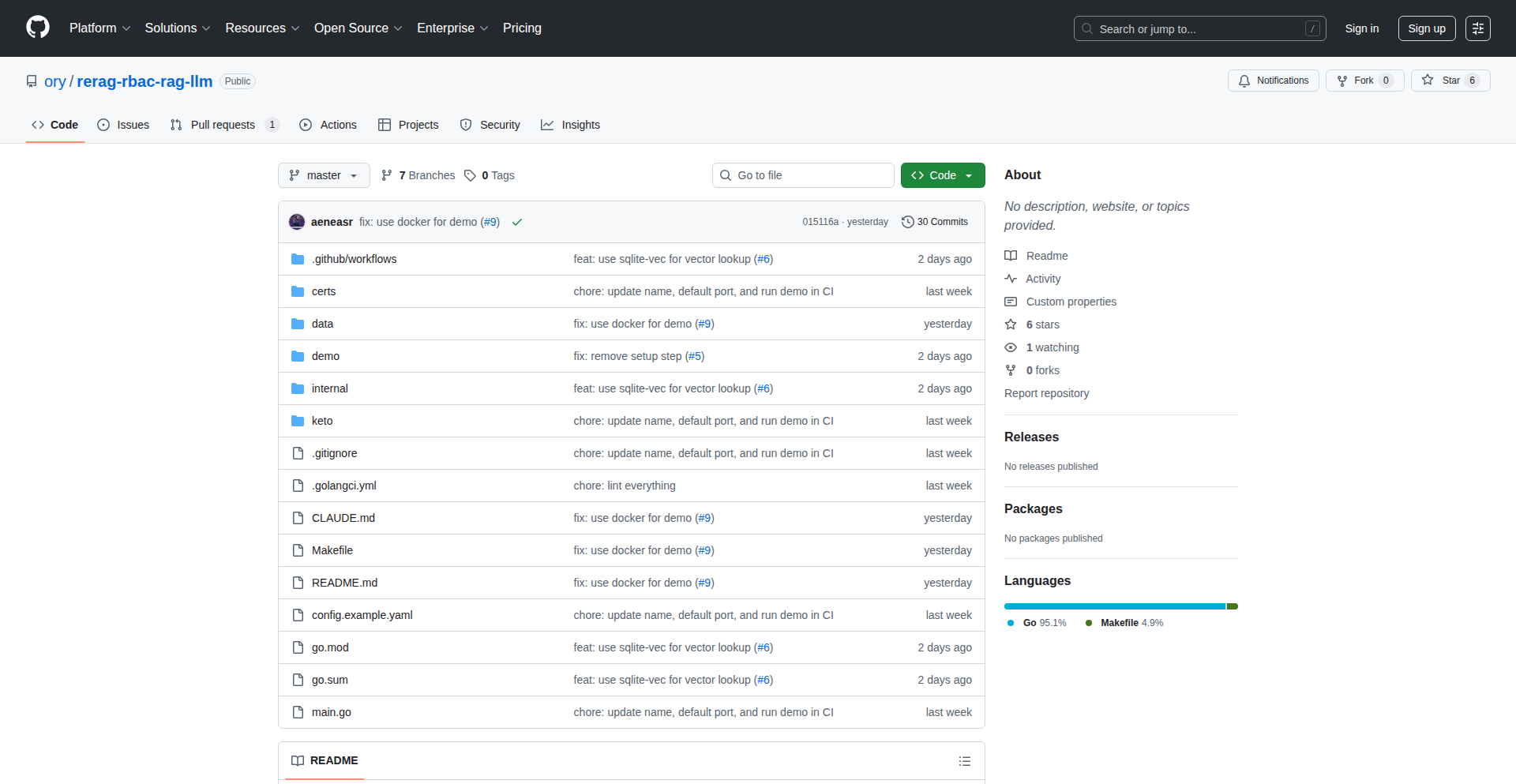

Rag:智能文档检索助手

作者

eigenqwertz

描述

Rag 是一个利用大型语言模型(LLM)进行文档检索的项目。它解决了在海量非结构化文档中快速找到相关信息难题。通过将文档内容转化为向量(一种数字表示),Rag 能够理解文档的语义,从而实现比传统关键词搜索更智能、更精准的检索。

人气

点赞 3

评论数 0

这个产品是什么?

Rag 是一个基于大型语言模型(LLM)的文档检索系统。它的核心技术是将文档内容通过一种叫做“嵌入(embedding)”的技术,转化为一串串数字(向量)。这些向量能够捕捉文档的意义,而不是仅仅是文字的表面。当用户输入一个问题时,Rag 也会将这个问题转化为一个向量,然后去寻找与问题向量最相似的文档向量。这样,即使文档中没有完全相同的词语,Rag 也能找到意思上相关的文档。所以这对我有什么用?它让你能在大堆文档里,通过问问题的方式,找到真正想要的信息,比大海捞针还高效。

如何使用它?

开发者可以将 Rag 集成到现有的应用程序中,为用户提供智能文档搜索功能。例如,可以将其用于客服系统,让客服人员能快速找到知识库中的解决方案;也可以用于内部文档管理,帮助团队成员迅速定位技术文档或项目报告。集成方式通常是调用 Rag 提供的 API(应用程序接口),将用户的问题发送给 Rag,然后接收返回的搜索结果。所以这对我有什么用?你可以为你的产品增加一个“懂你”的搜索框,让你的用户或团队成员更轻松地获取信息。

产品核心功能

· 文档语义理解:通过将文档转化为向量,Rag 能够理解文档的内容含义,而不仅仅是匹配关键词。这使得搜索结果更加精准。所以这对我有什么用?你能找到的答案,比你直接搜索关键词时更贴切,更可能解决你的问题。

· 向量相似性搜索:Rag 使用向量数据库来存储和检索文档向量,能够快速找到与用户问题最相似的文档。所以这对我有什么用?即使你不知道确切的搜索词,Rag 也能帮你找到相似意思的内容,大大降低了搜索难度。

· API驱动的集成:Rag 提供易于集成的API接口,方便开发者将其快速接入到不同的应用场景中。所以这对我有什么用?你可以轻松地把这个强大的搜索功能,添加到你自己的软件或服务里,让它们更智能。

· LLM赋能:Rag 充分利用了大型语言模型的强大能力,实现了更高级的文本理解和生成。所以这对我有什么用?它能够理解更复杂、更自然的语言查询,并可能在未来提供更具深度的答案。

· 知识库问答:Rag 可以作为一个智能问答系统,直接针对用户的问题,从文档库中提取并组织答案。所以这对我有什么用?不用再一篇篇翻阅文档,直接得到问题答案,大大节省了时间。

产品使用案例

· 一个在线教育平台,利用 Rag 为学生提供一个智能的课程资料搜索功能。学生可以通过自然语言提问,Rag 会从大量的教材、讲义、笔记中找出最相关的知识点。所以这对我有什么用?学生学习时,遇到不懂的问题,可以直接问,立刻得到答案,学习效率更高。

· 一个软件开发团队,将 Rag 集成到内部的 Git Wiki 中,帮助开发者快速查找 API 文档、解决方案和最佳实践。开发者只需要用自然语言描述他们遇到的问题,Rag 就能精准定位到相关的文档片段。所以这对我有什么用?开发者可以更快地找到解决问题的方法,减少开发中的卡顿,提升工作效率。

· 一个法律咨询公司,使用 Rag 来管理和检索大量的法律条文、判例和案例分析。律师可以通过 Rag 快速找到与特定案件相关的法律依据。所以这对我有什么用?律师可以更快速、更全面地掌握案件信息,做出更准确的判断,为客户提供更好的服务。

· 一个公司内部的HR知识库,Rag可以帮助员工快速找到关于公司政策、福利、入职流程等信息。员工不再需要咨询HR,而是通过提问就能获得解答。所以这对我有什么用?员工可以随时随地自助查询所需信息,节约了HR的时间,也提升了员工获取信息的便利性。

25

Kexa.io云安全智能管家

作者

patrick4urcloud

描述

Kexa.io是一个用于检查云环境安全配置错误的开源工具,其高级版本集成了AI,能够智能协助修复这些错误。它提供了一个统一的Web界面,让开发者和安全团队能够轻松可视化多云安全状况,通过可视化界面管理安全规则,并获得基于行业标准(如CIS benchmarks)的AI驱动的修复建议,解决在多云环境下管理安全配置和合规性难题。

人气

点赞 3

评论数 0

这个产品是什么?

Kexa.io是一个开源的IT安全合规工具,旨在帮助开发者和安全团队自动检查AWS、GCP、Azure等云服务中的安全配置错误。它创新之处在于,其高级版本增加了一个直观的Web界面,让你无需深入研究复杂的配置文件,就能:

1. 从一个地方清晰地看到你所有云环境(如AWS、Azure、GCP)的安全状态。

2. 通过图形界面轻松管理安全规则,甚至可以无代码地创建和修改规则。

3. 利用AI提供智能修复建议,帮助你快速解决发现的安全漏洞,这些建议基于权威的安全标准。

所以,如果你管理着多个云服务,Kexa.io能让你更省力地确保云环境的安全和合规,而且AI助手还会告诉你怎么修复,这对我意味着什么?意味着我不用成为一个云安全专家也能保护好我的云资产。

如何使用它?

开发者可以使用Kexa.io的开源版本,通过命令行接口(CLI)或API来扫描和报告云环境中的配置错误。集成通常涉及将Kexa.io作为CI/CD流程的一部分,以便在代码部署前就发现潜在的安全问题。

对于Kexa.io的高级版本,开发者可以通过其Web界面进行操作:

1. 注册并连接你的云账户(AWS、GCP、Azure等)。

2. 在Web界面上直观地浏览和理解你的云资产安全报告。

3. 使用内置的规则编辑器创建或调整安全检查规则,无需编写代码。

4. 当发现安全问题时,AI会根据情况提供详细的修复指导,你可以直接参考并执行。

技术使用场景:

- 作为DevOps工程师,将Kexa.io集成到CI/CD流水线中,自动化安全检查,确保代码上线前符合安全标准。

- 作为安全审计员,利用Kexa.io的统一视图,快速评估多个云账户的安全态势,并生成合规性报告。

- 作为开发团队负责人,让团队成员也能轻松理解和管理项目的云安全配置,通过AI提示进行自助修复。

集成方式:

- 开源版:通过Docker容器部署,或直接安装CLI工具,通过配置文件定义扫描范围。

- 高级版:通过Web注册,连接API密钥或服务账户,即可开始使用,无需复杂的本地部署。

产品核心功能

· 多云安全态势可视化:通过单一Web界面集中展示AWS、Azure、GCP等多个云环境的安全配置状态,让你一眼掌握整体风险。这对我意味着什么?我可以避免登录到每个云服务商的控制台去查看,大大节省了时间,让我能快速了解潜在的安全风险。

· 无代码规则管理与构建:提供图形化界面来管理现有的安全规则,并支持用户通过可视化编辑器创建新的安全检查规则,无需编写复杂的脚本或代码。这对我意味着什么?即使我对安全规则的编写不熟悉,也能根据业务需求定制安全检查,让安全策略更贴合我的实际情况。

· AI驱动的自动化修复建议:利用人工智能技术,根据行业标准(如CIS benchmarks)和用户自定义规则,分析发现的安全配置错误,并提供清晰、可操作的修复指导。这对我意味着什么?当我发现安全问题时,AI会告诉我具体的解决方案,大大降低了解决问题的门槛,提高修复效率,减少了因操作失误带来的风险。

· 基础设施即代码(IaC)原生支持:Kexa.io的设计理念是与IaC工具(如Terraform, CloudFormation)协同工作,能够理解和扫描IaC文件中定义的云资源配置,从源头上发现潜在的安全问题。这对我意味着什么?我可以在编写和部署代码的同时,就考虑到安全性,将安全检查前置,避免在部署后才发现问题,从而节省大量的修复成本和时间。

产品使用案例

· 场景:一家拥有AWS和Azure两个云账户的初创公司,其开发团队希望在发布新功能前确保所有部署都符合基本的安全合规要求,但公司内部缺乏专门的安全专家。

使用:开发团队使用Kexa.io的开源版集成到CI/CD流程中。每次代码提交并准备部署时,Kexa.io会自动扫描CloudFormation和Terraform代码中的配置,识别出如开放的S3存储桶、不安全的网络规则等问题。

解决:Kexa.io的报告会立即通知开发团队,并指出具体问题所在,开发团队根据报告中的信息修改IaC代码,确保部署的安全。Kexa.io的AI修复建议甚至能指导他们如何安全地修改规则。

对我意味着什么?这个工具让我这种非安全专家也能在产品上线前进行基础的安全检查,避免了因配置不当导致的数据泄露等严重后果。

· 场景:一个大型企业需要管理跨越AWS、GCP和Azure的数百个云账户,并需要定期向合规部门提交安全审计报告。

使用:企业使用Kexa.io的高级版,通过其Web界面集中管理所有云环境的安全策略。安全团队可以在UI中设定并审查CIS benchmarks相关的规则,并根据AI生成的报告来跟踪和管理修复进度。

解决:Kexa.io的统一可视化界面让安全团队能够快速全面地了解整体安全态势,AI提供的修复建议帮助他们高效地指导不同团队进行修复,并能生成符合要求的合规性报告。

对我意味着什么?即使有成百上千个云资源,我也不用手忙脚乱,Kexa.io能帮我梳理清楚,并给出修复方案,让合规性检查变得更高效。

· 场景:一位独立开发者正在构建一个面向公众的Web应用,希望确保用户数据的安全,并满足GDPR等隐私法规的要求。

使用:开发者使用Kexa.io的高级版,连接到部署应用所用的AWS账户。他利用无代码规则构建器创建了检查是否所有S3存储桶都已加密、是否启用了访问日志等规则。

解决:Kexa.io在后台持续监控,当发现任何配置不符合这些规则时,会通过AI提示告诉他如何立即修正,例如如何为存储桶启用静态加密。

对我意味着什么?这个工具让我一个人的团队也能享受到专业的安全守护,确保我的应用和用户数据是安全的,让我更专注于核心业务开发。

26

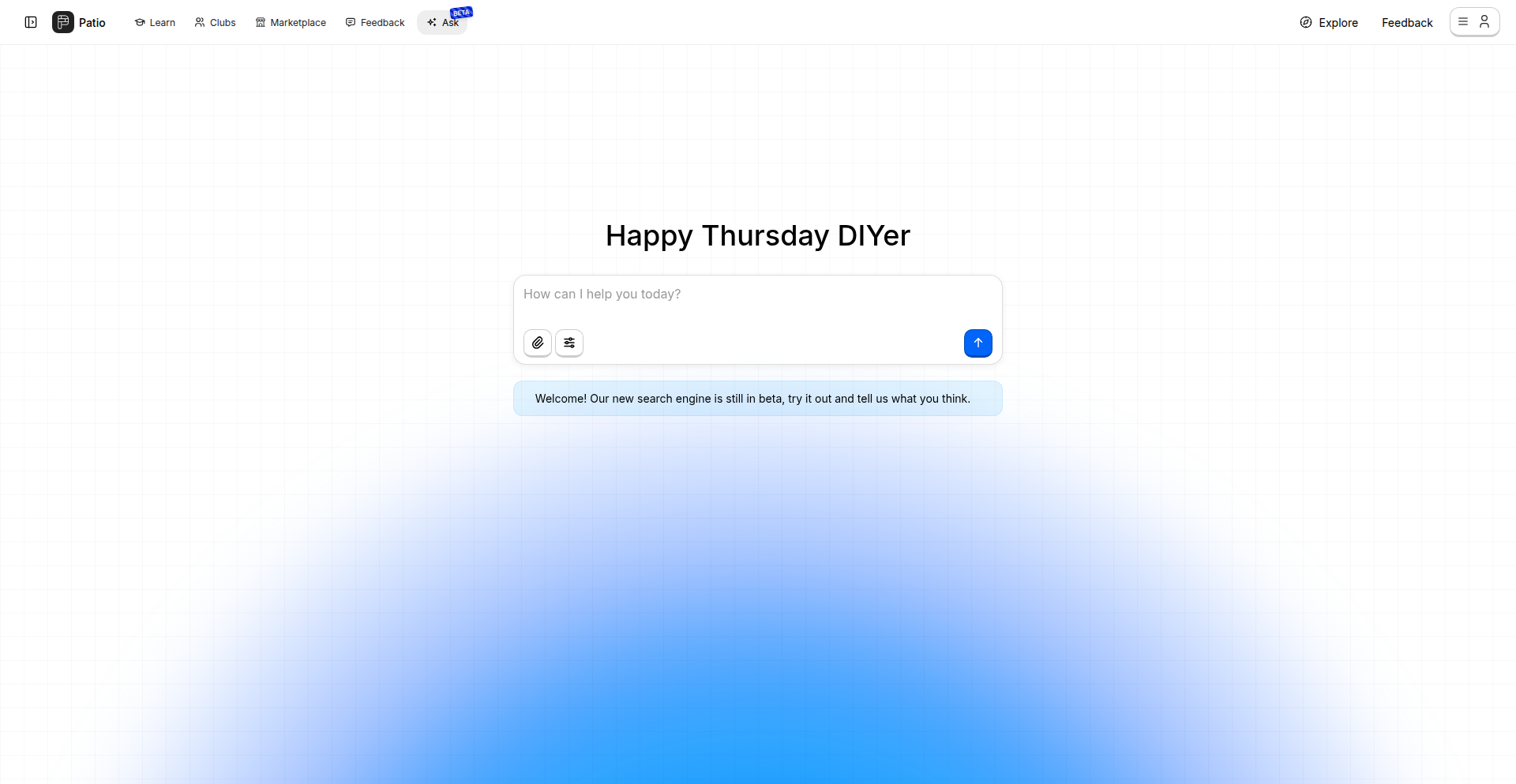

DIY匠心搜索

作者

rocknrollisdev

描述

这是一个由AI驱动的DIY和家居装修领域的智能搜索引擎,就像为特定人群定制的Perplexity(一个AI知识引擎),专注于解决建造、修复和制作过程中的问题。它能更精准地理解DIY相关的提问,并提供恰当的教程和指南,让用户轻松找到所需信息。

人气

点赞 3

评论数 0

这个产品是什么?

DIY匠心搜索是一个专门为喜欢自己动手做(DIY)和家居装修的人们打造的AI搜索工具。它不只是简单地搜集信息,而是理解你在进行某项手工制作、维修或者改造时遇到的具体问题。比如,你问“如何给木地板打蜡?”,它能理解你可能关心的是工具、材料、步骤以及注意事项,并给出更贴合实际操作的教程和指导。它的创新之处在于,它通过AI技术深度学习了大量的DIY项目、教程和经验分享,能够比通用搜索引擎更懂你的需求,直接给出解决方案,而不是让你在海量链接中大海捞针。所以,这对我来说很有用,它能在我遇到DIY难题时,快速准确地给我答案,省去我大量查找和筛选信息的时间。

如何使用它?

开发者和DIY爱好者可以通过访问patio.so/ask网站来使用这个工具,无需注册。只需在搜索框中输入你遇到的DIY问题,例如“如何更换水龙头?”、“如何用粘土制作花盆?”或者“如何给旧家具上漆?”,DIY匠心搜索就会利用其AI能力,为你梳理出最相关的步骤、所需材料、工具建议以及注意事项,甚至可能会直接链接到相关的视频教程或详细指南。这就像有一个经验丰富的“DIY向导”在旁边随时为你解答。所以,这对我来说很有用,当我需要进行一项不熟悉的DIY项目时,可以直接向它提问,它就能提供操作指南,让我能够信心满满地开始动手。

产品核心功能

· AI驱动的DIY问题理解:能准确识别并理解用户在DIY、维修、装修等场景下提出的具体技术或操作性问题,提供定制化答案,大大提高信息检索的效率和相关性。

· 精准教程与指南推荐:通过AI分析,直接匹配最适合用户需求的手工教程、操作步骤和解决方案,避免用户在海量信息中迷失,直接找到可执行的操作方法。

· 跨平台信息整合:能够整合来自不同平台的DIY相关资源,如博客文章、视频教程、论坛讨论等,并进行提炼和组织,为用户提供更全面的信息视图,一次性满足所有需求。

· 持续优化的AI模型:通过用户反馈和数据迭代,AI模型不断学习和改进,能够更好地理解复杂或模糊的DIY问题,提供更准确、更实用的建议,让工具越来越好用。

产品使用案例

· 场景:用户想在家中尝试制作一个简单的木制书架,但不知道从何开始。提问:“新手如何用木板制作一个简单的书架?”。DIY匠心搜索会直接给出所需工具列表(锯子、螺丝刀、砂纸等)、推荐的木板类型、详细的切割尺寸和组装步骤,甚至可能推荐一些基础的加固技巧。这样,用户就能清晰地知道需要准备什么,以及如何一步一步完成。

· 场景:用户的水龙头漏水了,想自己修理而不是请维修工。提问:“厨房水龙头漏水怎么修?”。DIY匠心搜索会分析漏水原因(可能是阀芯老化、密封圈磨损等),并提供针对性的维修教程,包括如何拆卸水龙头、更换密封圈或阀芯的步骤,以及需要准备的工具和可能的注意事项,如关闭水源等。这样,用户就能在短时间内自行解决问题。

· 场景:用户想为户外阳台制作一个小型种植箱,但缺乏经验。提问:“如何用回收材料制作一个简易阳台种植箱?”。DIY匠心搜索可能会提供利用旧木板、塑料桶等回收材料的设计方案,包括如何处理材料、尺寸建议、排水孔的设置方法以及如何进行简单的表面处理,使其既实用又美观。这样,用户就能以环保且低成本的方式完成项目。

27

本地文档AI问答机 (Offline RAG for Mac)

作者

irqlevel

描述

这是一个为macOS设计的、注重隐私的AI文档问答应用。它能在你的Mac上离线搜索、索引和与本地文档(目前仅支持PDF)进行对话。用户可以上传PDF文件,AI会学习这些内容,然后你就可以用自然语言提问,AI会根据你上传的文档内容给出答案。整个过程完全在本地运行,不上传任何数据到云端,保护用户隐私。

人气

点赞 3

评论数 0

这个产品是什么?

这是一个AI驱动的本地文档问答工具,核心技术是“检索增强生成”(Retrieval-Augmented Generation,简称RAG)。简单来说,它不是一个通用的AI,而是通过让你上传自己的文档,然后AI就变成了你文档的“专家”。它的创新之处在于,整个AI的处理过程全部在你自己的Mac电脑上完成,不依赖任何外部服务器,这意味着你的文档内容绝对不会被发送到网上,非常安全。唯一的网络使用就是在你第一次安装时下载AI模型。

如何使用它?

开发者可以将这个应用集成到需要本地化文档信息处理的场景中。例如,你可以用它来快速查找项目文档、技术手册、合同条款等。使用时,你只需将PDF文件拖拽到应用中进行索引,然后就可以开始向AI提问了。你可以问“这个项目的开发时间线是什么?”或者“合同中的付款条款有哪些?”AI会根据你上传的PDF文件内容来回答,无需联网。

产品核心功能

· 本地文档索引:将你的PDF文档内容转换成AI可以理解的格式,就像给文档建立了一个智能目录,这样做是为了让AI能快速找到相关信息,提高回答速度和准确性。

· 离线AI问答:直接与索引好的文档内容进行自然语言对话,AI会根据文档内容生成答案,这让你无需搜索就能快速获取信息,节省大量查找时间。

· 隐私保护:所有数据处理都在本地Mac完成,不上传云端,确保你的文档内容不会泄露,特别适合处理敏感或私密信息。

· PDF文件支持:目前支持PDF格式的文档,这是一个方便的起点,可以让你快速开始体验AI文档问答的便利性。

· LLM模型本地化:AI的“大脑”(语言模型)也安装在本地,这意味着AI的智能能力不依赖于互联网连接,让离线使用成为可能。

产品使用案例

· 在阅读一份长篇技术报告时,你想快速了解某个特定功能的实现细节。你可以上传报告PDF,然后问AI“请解释一下xxx功能的具体实现步骤”,AI会直接从报告中提取信息给出答案。

· 作为一名律师,你需要快速查找合同中关于违约责任的具体条款。你可以上传合同PDF,然后问AI“合同中关于违约责任的规定有哪些”,AI会直接找出相关内容。

· 作为一名开发者,你在处理一个旧项目时,需要回忆某个模块的设计思路。你可以上传相关的设计文档PDF,然后问AI“xxx模块的设计思路是什么”,AI会帮你快速回忆起来,避免重新钻研。

· 作为学生,在准备考试时,你需要快速梳理课本上的某个概念。你可以上传课本PDF,然后问AI“请解释一下xxx概念,并给出书中的相关例子”,AI会帮你梳理知识点。

28

AI对话式数据应用引擎

作者

mfdupuis

描述

这是一个能让你像聊天一样与你的数据互动,并直接将聊天结果转化为可重复使用的数据应用或工作流的AI系统。它解决了传统数据分析中“问AI-写代码-看结果-修改”的循环痛点,让你能在一个流畅的对话界面中完成所有操作。其核心创新在于AI与数据报告之间精妙的变量管理,确保AI生成的新数据不会轻易干扰到现有报告,直到你确认接受。

人气

点赞 3

评论数 0

这个产品是什么?

这是一个AI驱动的系统,让你能够通过自然语言(聊天)来与任何数据源进行交互。它的创新之处在于,它不仅能理解你的问题并直接在聊天界面展示结果,还能将这些聊天交互“固化”成一个可重复执行的数据应用或自动化工作流。更绝的是,它能巧妙地管理AI与你现有数据报告之间的“变量”:比如,AI可以访问你报告里的一个叫做'df1'的数据表,并基于此创建新的数据表'df2',但这个'df2'只有在你明确同意后才会真正出现在你的报告里,这样就避免了AI随意生成大量数据而导致报告混乱的问题。所以,这就像拥有一个能和你一起思考、一起工作的智能数据助手,而且它还能把你们的讨论成果变成你随时可用的工具。

如何使用它?

开发者可以将任意数据源(如数据库、CSV文件、API接口等)连接到这个AI引擎。在开发过程中,你可以直接在聊天框里输入指令,比如“找出过去一个月销量排名前十的产品”,AI会立即计算并展示结果。如果你满意,可以直接将这个查询转化为一个数据应用或自动化脚本,方便日后复用。你也可以随时在“聊天模式”和“构建模式”(即转化为实际应用)之间无缝切换,无需中断工作流程。这种方式特别适合那些需要频繁进行数据探索、报表制作或自动化处理的场景。它能够被集成到现有的开发环境中,作为一种更智能、更高效的数据处理和分析工具。

产品核心功能

· 数据源连接:支持连接多种数据源,让AI能够访问你的真实数据,解决了数据孤岛的问题,所以你可以让AI分析你拥有的所有数据。

· 纯对话式交互:用户可以通过自然语言与AI交流,提出数据问题,AI实时给出反馈,解决了复杂查询语句的学习门槛,所以你可以用最简单的方式获取数据洞察。

· 对话转数据应用:将一次性的聊天对话转化为可重复使用的报表、仪表盘或自动化工作流,提高了工作效率,解决了重复劳动的问题,所以你可以把每次的分析成果变成一个永久可用的工具。

· 安全变量管理:AI生成的新数据(变量)不会立即影响现有报告,直到用户确认,避免了AI误操作导致的混乱,解决了数据稳定性风险,所以你可以放心地让AI帮你探索数据,不用担心会搞乱你的现有工作。

产品使用案例

· 在制作月度销售报告时,你可以直接问AI:“帮我生成上个月各地区销售额和利润率的柱状图”,AI完成分析后,你只需点击“保存为报表”,这个图表就立刻呈现在你的报告里,解决了需要手动绘制图表和编写代码的麻烦。

· 当你需要对用户反馈进行情感分析时,可以提供用户评论数据给AI,并指令:“分析这些评论的情感倾向,并找出负面评论中提及最多的关键词”,AI完成分析后,你可以将这个过程保存为一个“用户反馈情感分析”的应用,今后只需导入新评论,就能自动生成分析报告,解决了手动处理大量文本数据的低效问题。

· 对于需要定期更新的市场数据,你可以让AI自动连接API获取最新数据,然后执行预设的分析流程,并将结果汇总成一个每日更新的仪表盘,解决了数据获取和分析的手动刷新问题,所以可以实现全自动化的市场趋势监控。

29

API响应调色板

作者

vrathee

描述

一个专为API响应调试设计的JSON格式化工具。它通过语法高亮、缩进和折叠等可视化手段,让复杂的JSON数据变得清晰易读,极大地提高了开发者在排查API问题时的效率。其技术创新在于将原本杂乱无章的API输出转化为一眼就能抓住重点的信息。

人气

点赞 2

评论数 0

这个产品是什么?

这是一个在Hacker News上由开发者分享的、旨在解决API响应调试痛点的JSON格式化工具。市面上很多API工具也能格式化JSON,但这个项目可能在细节上做了更符合开发者直觉的优化,比如针对API响应的常见模式进行预设高亮,或者提供更快捷的折叠/展开方式,让开发者能快速定位到错误信息或关键数据。它的核心技术思路是将原始的文本JSON数据,通过解析和渲染,以更友好的视觉方式呈现,就像给API响应数据穿上了一件“调色板”外衣,让开发者一眼就能看清结构和内容。

如何使用它?

开发者可以在集成开发环境(IDE)中使用这个工具的插件,或者在浏览器开发者工具中直接应用。当你的应用程序调用某个API,收到的返回数据是JSON格式时,你可以将这些原始的JSON文本粘贴到该工具中(或者通过IDE插件自动格式化),它就能立刻将其变成整洁、易读的格式。这对于诊断API集成中的错误、理解API返回的数据结构非常有帮助,直接提升了开发和调试的效率。

产品核心功能

· JSON语法高亮:将JSON数据中的关键字、字符串、数字、布尔值等用不同颜色区分显示,一眼就能辨认数据类型,相当于给数据做了“分类标记”,让你快速找到你需要的数据部分,所以这对我来说,能更快地理解API返回的数据。

· 自动缩进和结构化:将原本可能挤在一起的JSON数据,按照层级关系自动排版,让嵌套结构一目了然,相当于给数据做了一次“美化排版”,让你清晰地看到数据的层级关系,所以这对我来说,更容易理解复杂的API返回结构。

· 数据折叠与展开:允许开发者折叠不关心的部分,只展开需要查看的层级,大大减少了视觉干扰,就像拥有一个“信息放大镜”,只聚焦你关心的部分,所以这对我来说,可以屏蔽掉不必要的信息,只关注核心数据。

· 错误识别辅助(推测):可能内置了一些常见的API错误JSON模式的识别,通过特殊高亮或提示,帮助开发者快速定位问题,相当于给API响应加了一个“错误检测器”,所以这对我来说,能更快地发现API可能存在的错误。

产品使用案例

· 在集成第三方支付API时,发现请求总是失败,但收到的JSON错误信息难以理解。使用API响应调色板后,错误代码和描述被清晰高亮,开发者能迅速找到错误原因并进行修复,解决了API集成中的疑难杂症,所以这对我来说,能帮助我快速解决第三方API集成遇到的各种难题。

· 开发一个需要调用多个内部微服务的应用,每个服务返回的JSON结构都不同。使用该格式化工具后,开发者可以方便地比对和理解不同服务的响应,确保数据流转的正确性,相当于拥有了一套“数据对比模板”,所以这对我来说,能更轻松地管理和协调多个服务间的数据交互。

· 前端开发者需要调试前端页面调用的后端API。在浏览器开发者工具中接入此格式化工具(可能通过浏览器插件),可以将原始JSON响应转化为易于阅读的格式,极大缩短了前端与后端接口联调的时间,相当于一个“接口调试加速器”,所以这对我来说,能大幅提升前端和后端联调的效率。

30

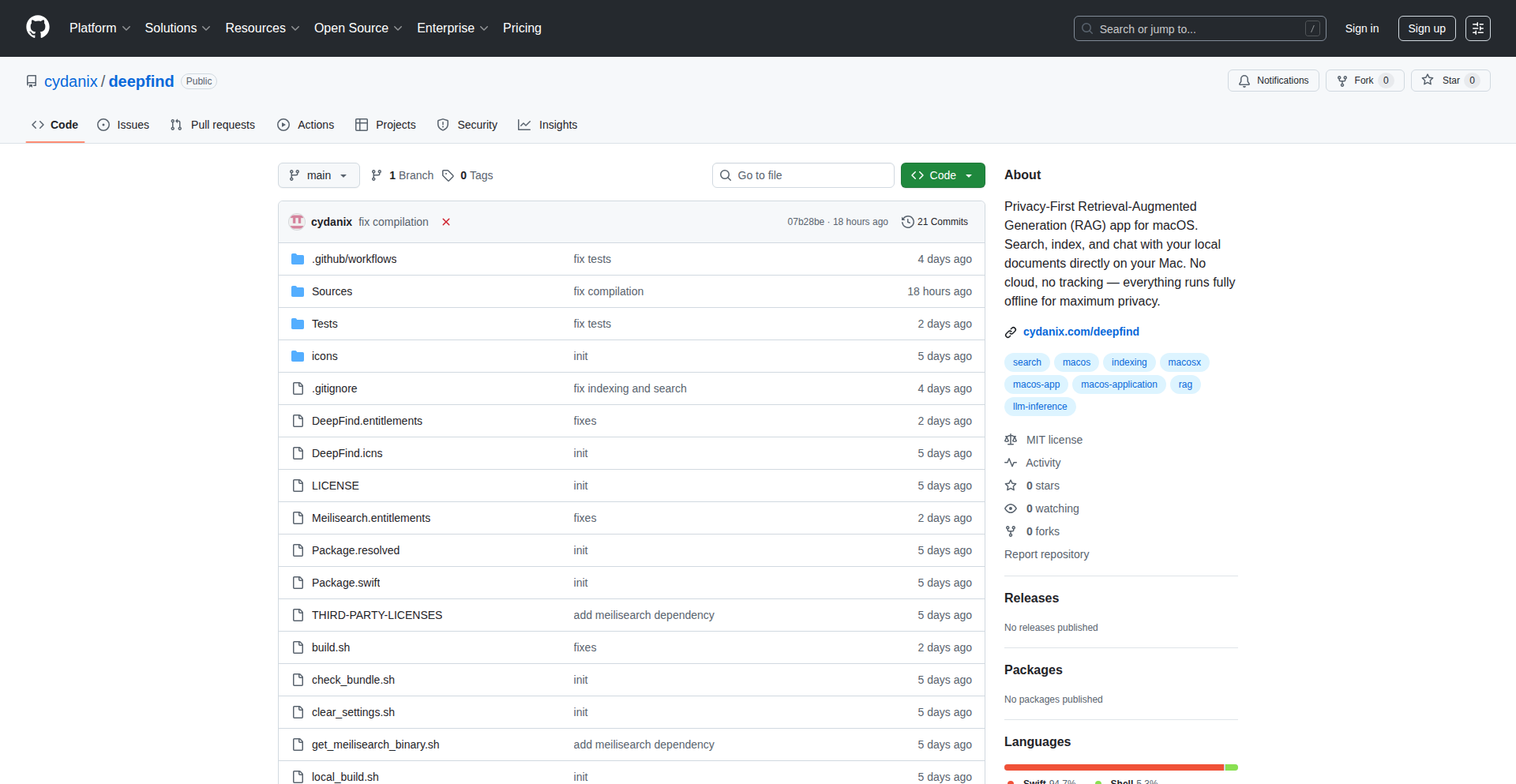

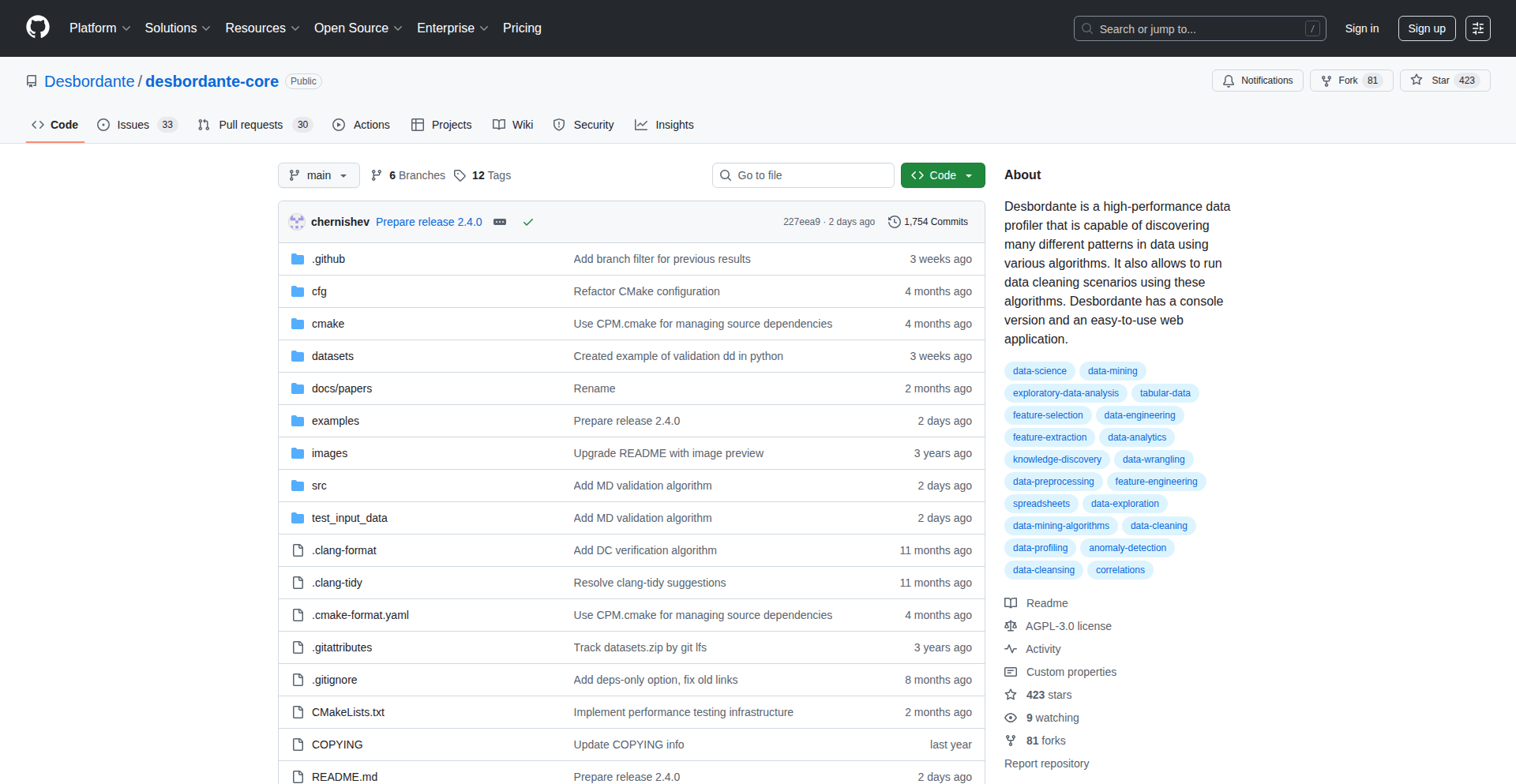

Desbordante: 智能数据模式洞察引擎

作者

chernishev

描述

Desbordante v2.4.0 是一个强大的开源工具,能够自动发现并验证数据中隐藏的复杂模式。它就像一个数据侦探,能找到数据中不寻常的规律,并告诉你这些规律是否可靠,还能帮你验证数据的质量。新版本增加了对四种不同模式的验证支持,以及发现数据中函数依赖关系的功能,并可以将发现的模式保存下来,方便以后使用。附带的Colab教程让你快速上手,找到最适合你的数据模式分析方法。所以,它能帮助你更深入地理解你的数据,发现潜在问题,提高数据质量,做出更明智的决策。

人气

点赞 2

评论数 0

这个产品是什么?

Desbordante是一个高性能的数据分析工具,它的核心技术在于能够自动扫描你的数据,像扫描仪一样找出其中可能存在的、不那么明显的规律和关联。比如,你的一份客户购买记录,它能发现“购买了A商品的用户,有70%的几率会在一个月内购买B商品”这样的模式。它不仅仅是找出模式,还能帮你“验证”这些模式是否真实有效,而不是偶然出现的。新版本v2.4.0厉害之处在于,它支持对四种不同类型的模式进行严格的“打分”和“审批”,确保你发现的模式靠谱。而且,它还能帮你发现数据中“函数依赖”——简单来说,就是当某个数据的值确定时,另一个数据的值也必然确定的情况,就像“出生年月日”确定了“星座”一样。所以,这对于想深入了解数据、发现数据问题、甚至预测数据趋势的开发者来说,是一个非常有力的工具。

如何使用它?

开发者可以使用Desbordante来分析各种类型的数据集,例如用户行为日志、交易记录、传感器数据等。你可以将Desbordante集成到你的数据处理流程中,作为数据预处理或数据质量检查的一部分。例如,在部署一个机器学习模型之前,先用Desbordante分析数据,发现潜在的数据偏差或异常模式,从而优化模型训练。它提供了Colab Notebooks,让你可以在Jupyter Notebook环境中直接运行代码示例,快速了解如何使用它来发现和验证数据模式。你可以直接通过Python库来调用Desbordante的核心功能,输入你的数据,然后它会返回发现的模式列表以及验证结果。所以,这能让你在开发过程中,更早、更准确地发现数据中的问题,减少后期返工,让你的应用更加健壮。

产品核心功能

· 自动发现数据中的复杂模式: 这个功能就像一个智能搜索引擎,能从海量数据中挖掘出隐藏的、有价值的规律,帮助你了解数据的内在关联。这对于理解用户行为、优化产品设计非常有价值。

· 模式验证: 发现模式后,它还能帮你判断这些模式是否真实可靠,而不是巧合。这能确保你基于的数据洞察是准确的,避免做出错误的决策。所以,它能让你对发现的规律更加放心。

· 支持多种模式验证类型: 新版本增加了对四种不同类型模式的验证支持,意味着它可以更全面、更深入地审查数据的规律,确保分析结果的多样性和准确性。这让你可以从更多角度审视你的数据。

· 发现图函数依赖: 这是一个非常专业的功能,能够帮你找到数据中“一个值决定另一个值”的强关联关系,比如“用户的注册时间”可能决定了“用户是否会成为活跃用户”。这对于数据建模和特征工程非常有价值。

· 模式序列化: 发现的模式可以被保存下来,方便以后重复使用或与其他工具共享。这意味着你一次的分析成果,可以被持续利用,提高效率。

· 提供Colab Notebooks示例: 附带的教程让你无需复杂的环境配置,就能快速上手和测试Desbordante的功能,让你能更快地掌握这个工具的使用技巧,并找到最适合你需求的分析方法。

产品使用案例

· 在电商平台开发中,使用Desbordante分析用户购买数据,发现“购买了A商品的用户,有较高的概率会在之后购买B商品”的模式,从而优化商品推荐算法,提高交叉销售率。这直接提升了销售额。

· 在金融风控领域,利用Desbordante检测交易数据中的异常模式,例如“某个时间段内,同一IP地址发生大量小额交易”,以识别潜在的欺诈行为。这帮助降低了金融风险。

· 对于社交媒体平台,使用Desbordante分析用户互动数据,发现“分享特定类型内容的用户,更容易产生评论”,从而调整内容分发策略,增加用户互动。这提升了平台的活跃度。

· 在IoT设备数据分析中,通过Desbordante发现传感器读数之间的函数依赖关系,例如“温度升高到一定值时,风扇转速会自动提高”,从而优化设备性能和能耗。这让设备运行更高效。

· 在数据清洗阶段,利用Desbordante验证数据中的一致性模式,例如“如果用户的收货地址是北京,那么其邮政编码的第一个数字必须是10”。当发现不符合模式的数据时,及时标记或修正,提高数据质量。这确保了数据的准确性,为后续分析打下良好基础。

31

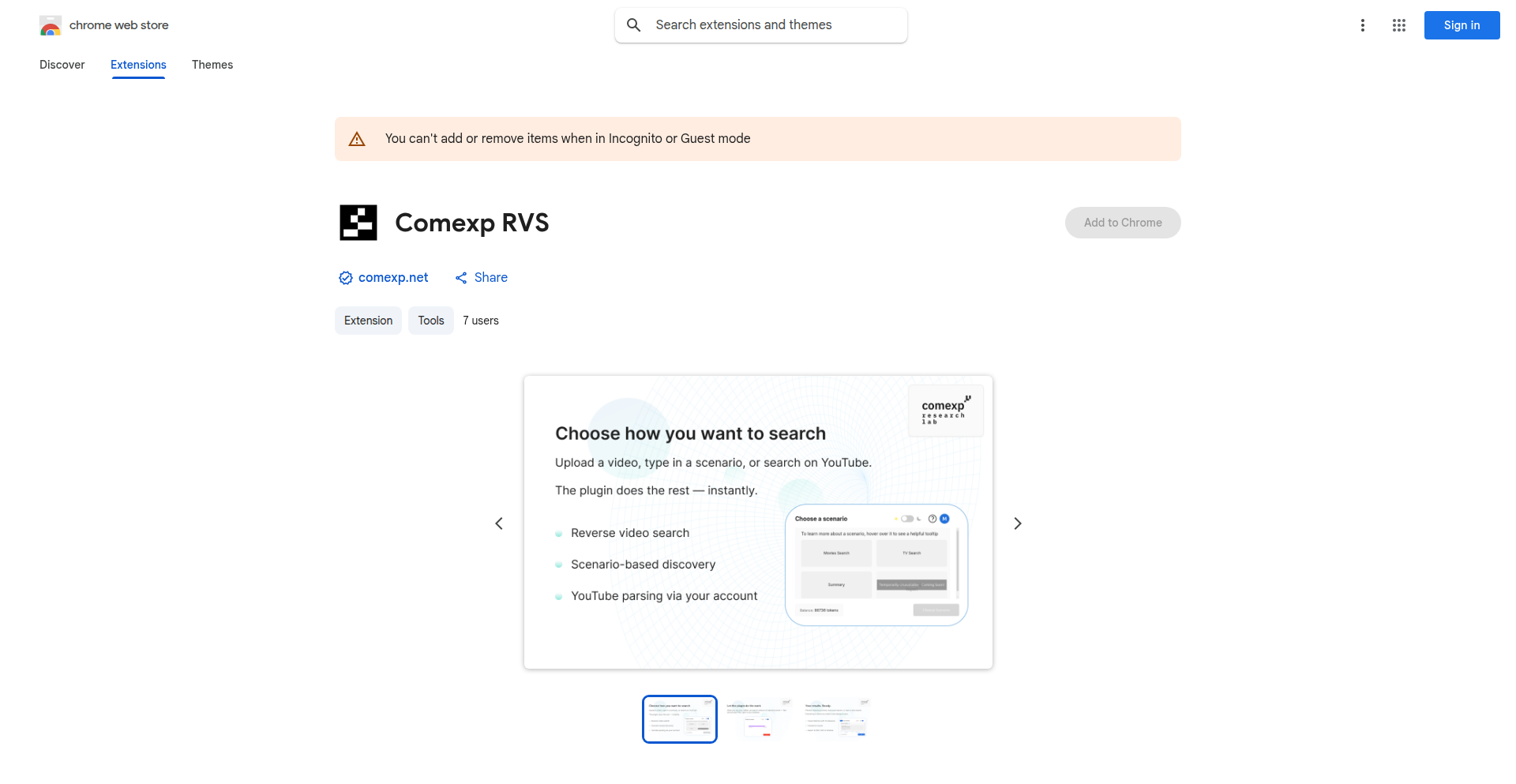

Comexp RVS: 视频DNA匹配引擎

作者

comexp_rvs

描述

Comexp RVS 是一个创新的浏览器扩展和平台,它能实现真正的实时视频到视频搜索、视频内容分析和追踪。它解决了用户在查找视频片段来源、监控直播电视内容、过滤重复视频以及智能总结长视频等方面的痛点。其核心创新在于利用专有的TAPe技术,无需训练大量数据或依赖复杂的机器学习模型,就能进行高精度的动态视频匹配,即使视频质量不高也能奏效。

人气

点赞 2

评论数 0

这个产品是什么?

Comexp RVS 是一个非常酷的工具,它就像给视频加上了“DNA”,能够识别视频的独特性并进行匹配。它的技术原理非常巧妙,不是像我们常听到的“AI”那样依赖大量数据训练神经网络,而是采用了一种叫做TAPe(Time-stamped Audio-Visual Pattern Matching)的技术。你可以把它想象成,它能捕捉视频中独特的“声音和画面指纹”,即使是短暂的视频片段,只要指纹匹配,它就能找到完整的原始视频。这意味着,它能解决“这是什么电影/电视剧?”这样的问题,并且能做到实时匹配,效果非常惊艳。最厉害的是,它不需要庞大的计算资源,一个普通的服务器就能运行,而且还能监控成百上千个直播电视频道,找出某个片段在何时何地播出过,还能智能去除视频列表里的重复内容,甚至自动生成长视频的精华摘要。所以,它能让你更高效地找到想要的视频内容,或者更聪明地观看视频。

如何使用它?

对于开发者来说,Comexp RVS 提供了多种使用方式。最直接的是安装其Chrome浏览器扩展,当你在线观看视频时,可以截取一小段片段,然后通过扩展进行搜索,找到完整的视频来源。这在查找某个片段的出处、研究视频资料时非常有用。另外,Comexp RVS 还提供了一个Widget/API接口(tape.comexp.net/tools),这意味着开发者可以将这项强大的视频搜索和分析能力集成到自己的应用程序或服务中。例如,你可以为自己的内容平台开发一个“片段溯源”功能,或者为媒体监测服务添加直播视频内容的追踪能力。集成方式通常是通过API调用,发送视频片段给Comexp RVS的服务器进行分析,然后返回匹配结果。所以,这能让你利用最前沿的视频识别技术,增强你的产品功能,解决更复杂的视频相关问题。

产品核心功能

· 视频片段搜索与溯源:通过上传或粘贴视频片段,找到原始完整视频或剧集。这使得用户能够轻松找出电影、电视剧、短视频等内容的来源,大大节省了搜索时间。对于内容创作者或研究者来说,可以快速定位素材的原始出处,用于版权验证或学术引用。

· 实时直播电视监控:追踪特定内容(如广告、新闻片段)在数百个直播电视频道和档案中的播出时间和地点。这对于市场营销人员、新闻媒体机构或内容研究者来说,可以实现精准的媒体监测,了解内容覆盖范围和传播情况。

· 智能去重过滤:自动识别并过滤掉视频合集或播放列表中的重复内容,确保观看体验流畅不重复。这能让用户在观看长篇内容集锦时,避免不必要的重复观看,提高效率。开发者可以将此功能集成到视频播放器或内容管理系统中。

· 视频内容智能摘要:自动生成长视频中最核心、最重要的部分,让用户快速了解视频主旨。这对于需要快速掌握大量视频信息的用户(如学生、研究者)来说,极大地提高了信息获取效率,避免了浪费时间在无关紧要的部分。

· 跨平台视频匹配:利用TAPe技术,实现高效且低成本的视频动态匹配,即使视频质量不高也能准确识别。这意味着该技术在各种复杂场景下都具有很高的实用性,无需依赖昂贵的GPU和大量训练数据,降低了使用门槛。

产品使用案例

· 场景:用户在社交媒体上看到一个有趣的短视频片段,但不知道它来自哪部电影或电视剧。使用Comexp RVS浏览器扩展,用户可以轻松截取这段视频,通过搜索找到完整的影片信息。解决了“这是什么?”的根本性问题,提升了娱乐体验。

· 场景:一家市场研究公司需要监测竞争对手的广告在各大电视台的播出情况。通过Comexp RVS的API,他们可以构建一个系统,实时追踪所有目标频道的广告播放,并记录播出时间、频道和广告内容。这比人工监测效率高出数千倍,并能提供精确的数据。

· 场景:一个内容聚合平台拥有大量用户上传的视频剪辑,其中可能包含重复内容。在向用户展示列表前,集成Comexp RVS的去重功能,可以自动移除重复视频,保证用户看到的内容是最新鲜、最有价值的,提升了用户满意度。

· 场景:一位学生需要快速了解一部时长两小时纪录片的关键信息,但时间有限。使用Comexp RVS的视频摘要功能,他可以快速获取纪录片的核心观点和重要情节,在短时间内完成初步的信息获取,为后续深入研究打下基础。

· 场景:一家视频内容审核公司需要快速识别并标记视频中的潜在侵权内容。Comexp RVS的视频DNA匹配技术,即使在视频被轻微编辑或经过转码后,也能进行高精度的识别,大大提高了内容审核的效率和准确性。

32

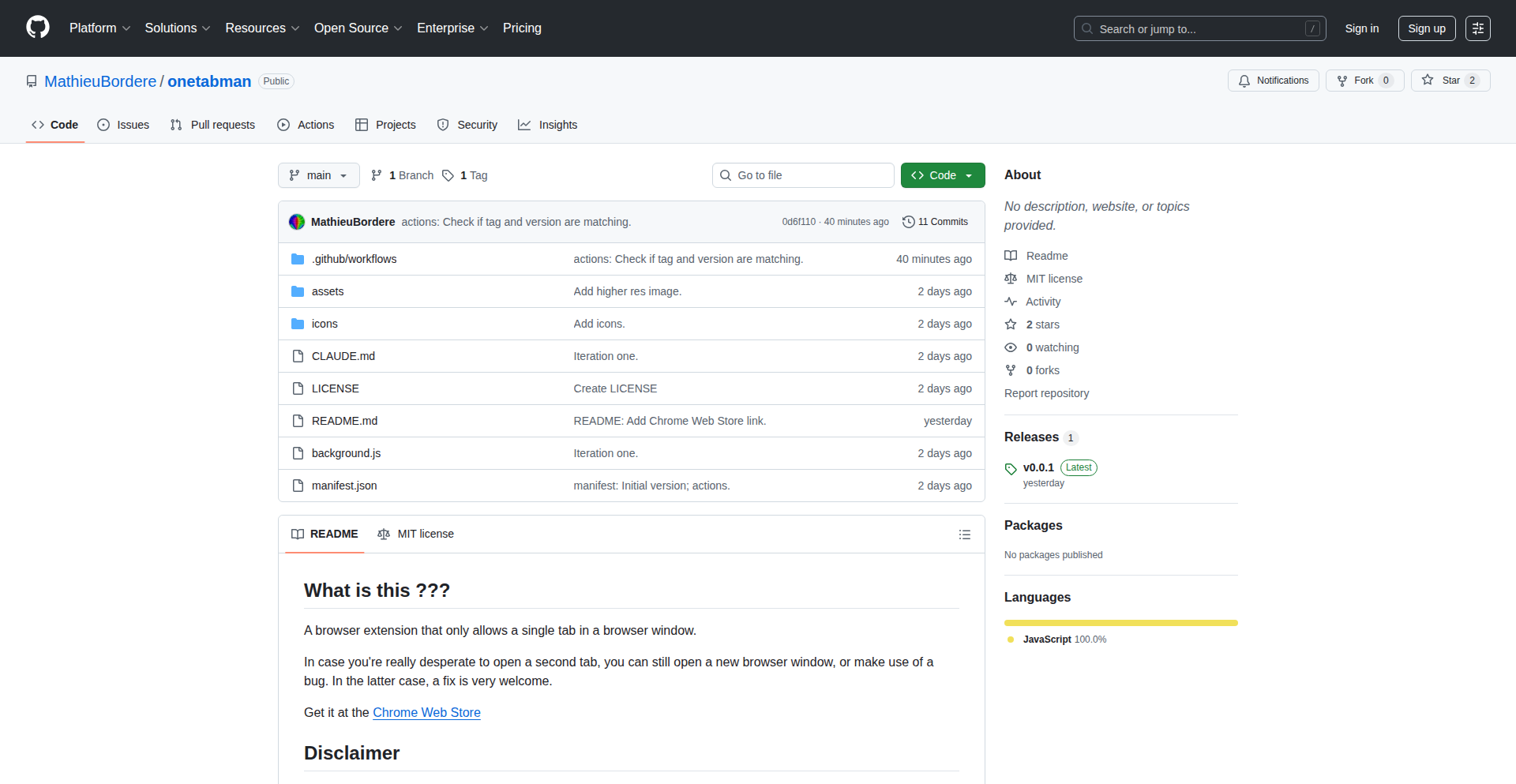

专注标签守护者

作者

letmetweakit

描述

这是一个Chrome浏览器扩展程序,它强制你的浏览器窗口在任何时候都只能保持一个标签页,帮助你摆脱多标签页的干扰,重新找回工作和学习的专注力。它通过拦截新建标签页的操作来实现这一点,让你更有效地管理在线信息,而不是陷入无休止的网页切换。

人气

点赞 2

评论数 0

这个产品是什么?

专注标签守护者是一个非常有创意的Chrome扩展,它的核心技术在于拦截浏览器中常见的“新建标签页”操作。当你尝试点击“+”号按钮或者使用快捷键(比如Ctrl+T)想打开一个新的标签页时,这个扩展就会阻止这个动作发生。同时,当你点击一个链接,正常情况下它会在新标签页打开,但这个扩展会把链接强行在你当前的标签页里打开。它的技术实现思路很简单但有效:通过监听浏览器内部的事件,识别出用户想要创建新标签页的行为,然后直接阻止该事件的默认处理方式。这就像给你的浏览器加了一个“只准有一个座位”的规则,迫使你一次只能处理一件事情,从而帮助你集中注意力。它的价值在于,通过限制最容易分散注意力的元素(多标签页),为你创造一个更纯粹、更聚焦的数字工作环境。所以这对我有什么用?它能帮你减少无意义的网页切换,让你在处理任务时更不容易分心,提升工作效率。

如何使用它?

开发者和普通用户都可以轻松使用专注标签守护者。只需在Chrome网上应用商店搜索并安装“专注标签守护者”(或者它在GitHub上的名字OneTabMan)这个扩展程序。安装完成后,它会自动在你的Chrome浏览器(以及兼容的Brave浏览器)上生效。你不需要进行任何复杂的配置。每次你想打开新的网页时,它都会阻止你新建标签页,或者直接在你当前的标签页打开链接。这是一种即插即用的专注力提升工具。所以这对我有什么用?你只需安装一次,它就会默默地为你工作,在你不经意间就帮你保持专注,无需学习复杂的设置,即可享受更高效的浏览体验。

产品核心功能

· 阻止新建标签页操作:当用户尝试通过点击“+”按钮或使用键盘快捷键打开新标签页时,扩展程序会拦截这个请求,确保当前标签页不会被关闭或替换。这能防止因好奇心驱使而打开过多不相关页面的冲动,让你专注于当前任务。所以这对我有什么用?减少了你随意浏览和被无关信息吸引的机会。

· 在新标签页打开链接时强制当前标签页打开:当你点击一个链接,它本应在新标签页打开时,此功能会将该链接的内容直接加载到当前已有的标签页中。这迫使你在浏览新内容时,必须先退出当前正在处理的任务,从而让你在切换内容时更加深思熟虑,避免不必要的页面跳转。所以这对我有什么用?它能让你在获取新信息时,更明确地知道自己是在“切换”还是在“继续”任务,从而更好地管理信息流。

· 支持Chrome和Brave浏览器:该扩展经过测试,可在主流的Chrome浏览器以及以隐私为导向的Brave浏览器上正常运行。这意味着你可以将其应用于你常用的浏览器环境中,而不必担心兼容性问题。所以这对我有什么用?无论你使用Chrome还是Brave,都可以无缝接入这个专注工具,享受统一的专注体验。

产品使用案例

· 用于深度工作场景:当需要进行需要高度集中的写作、编程、研究或学习时,开发者可以安装此扩展。它能有效防止在查阅资料过程中,因为不小心点击链接而分散注意力,导致打断思维流程。开发者可以在此场景下,将所有参考资料或代码片段都在同一个标签页内进行切换查看,保持对主任务的持续关注。所以这对我有什么用?在需要深度思考的时候,它为你打造一个“无干扰区”,让你潜心于核心工作。

· 用于减少社交媒体和新闻网站的沉迷:对于经常浏览社交媒体或新闻网站的用户,这个扩展可以成为一道“数字防火墙”。当用户习惯性地点击链接想要探索更多内容时,扩展会将其引导回当前已打开的页面,从而打断了“无限滚动”和“信息过载”的循环,帮助用户更克制地获取信息。所以这对我有什么用?它能帮你减少在容易让你分心的地方花费过多时间,让你更有意识地控制自己的上网行为。

· 用于学习新技能或完成课程:在学习过程中,通常需要参考大量文档或观看在线课程。此扩展能确保你在跳转到学习材料时,不会因为打开太多辅助页面而迷失方向,保持学习路径的清晰。用户可以在一个标签页内浏览教程,然后在同一个标签页内进行实践操作,避免学习过程中的信息碎片化。所以这对我有什么用?它能帮助你保持学习的连贯性,让你更容易跟上学习节奏,高效掌握新知识。

33

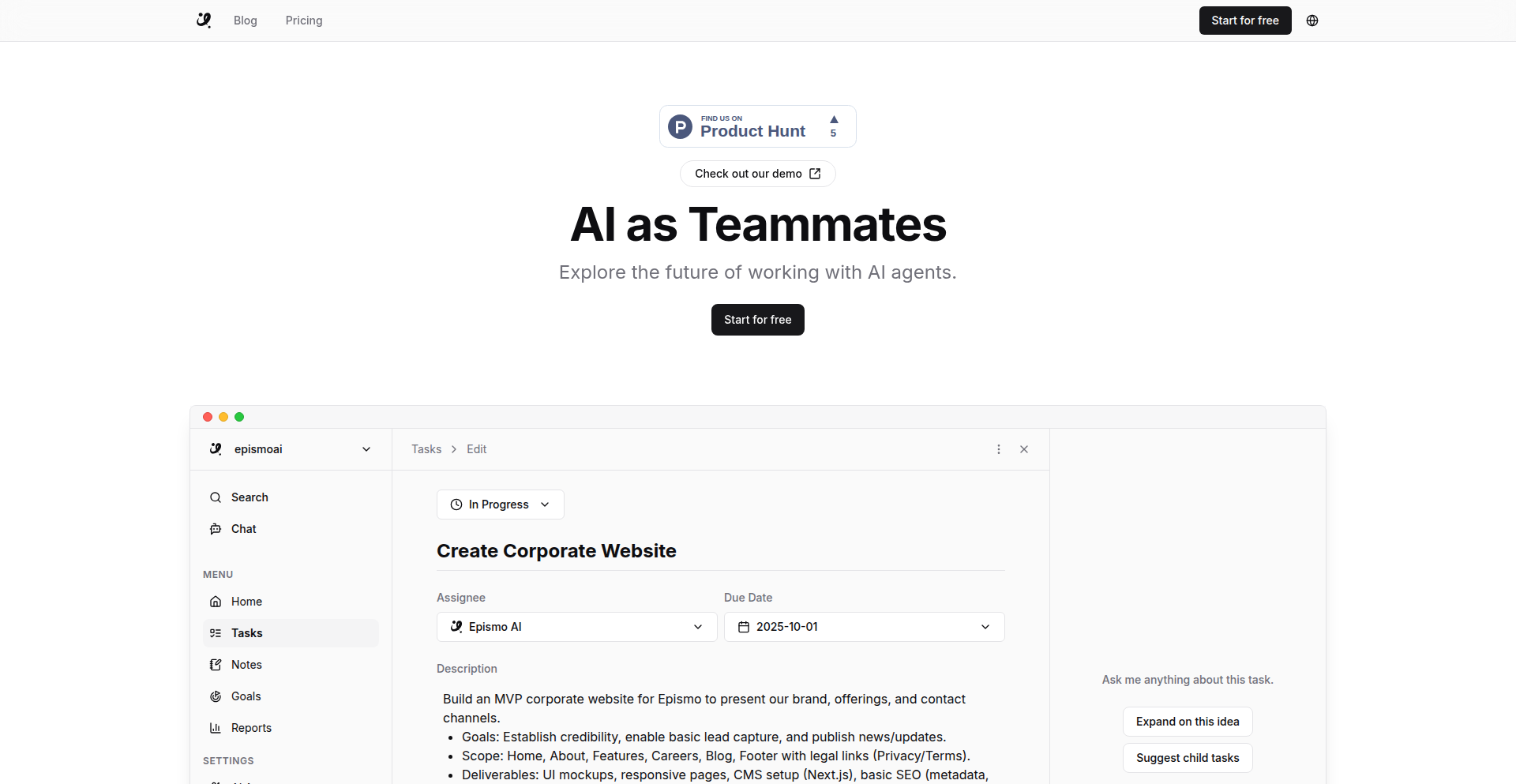

Epismo: AI驱动的任务追踪与责任明确器

作者

hirokiyn

描述

Epismo是一个AI驱动的项目管理工具,旨在解决会议后任务责任不清、目标分散的问题。它利用AI技术分析会议记录和项目讨论,自动提炼出关键任务、分配责任人,并追踪任务进展,确保项目不偏离轨道。所以,它能让你清楚知道谁在做什么,项目目标是否在按计划推进,减少沟通成本和项目延误。

人气

点赞 2

评论数 0

这个产品是什么?

Epismo是一个智能的项目管理助手,它就像一个聪明的秘书,能帮你消化会议内容。它的技术核心是自然语言处理(NLP)和机器学习(ML)。当你把会议记录或项目讨论的文本丢给它时,它会像读懂你一样,识别出里面提到的具体任务、负责人以及截止日期(如果存在)。最棒的是,它能主动关联这些信息,生成一个清晰的任务列表,并标记出每个任务由谁负责,以及这个任务对整个项目目标的重要性。这种自动化的信息提取和组织,避免了人工梳理的繁琐和遗漏,大大提高了项目管理的效率。所以,它的创新在于用AI帮你“听懂”项目,并把“听懂”的结果转化为可执行、可追踪的行动项,让你告别模糊和遗忘。

如何使用它?

开发者可以通过以下方式使用Epismo:

1. **集成到现有工作流**:将Epismo与你常用的沟通工具(如Slack、Microsoft Teams)或文档协作平台(如Google Docs、Notion)集成。一旦会议结束,可以将会议记录直接发送给Epismo进行分析,或者让它实时监控特定频道或文档的变化。

2. **手动导入与配置**:如果你有大量的历史会议记录或零散的项目笔记,可以直接复制粘贴文本到Epismo的界面,或者上传文档文件。然后,Epismo会进行智能分析,生成项目任务和负责人列表。

3. **API调用**:对于更高级的用户,Epismo可能提供API接口,允许你通过编程方式将Epismo的功能集成到自定义的工具或自动化脚本中,例如,当某个项目相关的代码提交被检测到时,自动触发Epismo分析相关讨论并更新任务状态。

所以,开发者可以将Epismo作为项目初期规划、中期进展监控的强大助手,快速将讨论转化为行动,确保项目按部就班推进,而无需费力手动整理。

产品核心功能

· AI驱动的任务提取:利用自然语言处理技术,自动从会议记录、聊天记录或文档中识别出具体的任务描述,让开发者不再错过任何一个重要的行动项,从而保证了项目执行的完整性。

· 责任人自动分配:通过分析讨论内容,智能识别并建议每个任务的负责人,减少了项目中的责任模糊,确保了任务有人负责,提高了执行效率。

· 目标与任务关联:能够将识别出的任务与项目的整体目标进行关联,帮助开发者理解每个任务的价值和优先级,优化了开发资源分配,让工作更有方向感。

· 任务进度追踪:提供一个集中的仪表板,可视化地展示任务状态、负责人和预期完成时间,让团队成员清晰了解项目进展,及时发现并解决潜在的瓶颈。

· 遗漏预警机制:如果发现任务分配不明确或存在遗漏,Epismo能够发出预警,提示开发者及时修正,避免因信息不对称导致的延误。

产品使用案例

· 在一个远程团队的周会结束后,项目经理将会议录音转写的文本导入Epismo,Epismo迅速识别出15个关键任务,并准确分配给对应的工程师和设计师,同时生成了可视化任务板。这让团队成员在会议结束后立即清楚自己的工作内容和优先级,避免了信息在多位成员间传递的损耗。

· 在一个敏捷开发团队中,开发者在Slack频道进行技术讨论,讨论中涉及到了一个bug修复和一个新功能的初步构想。Epismo通过集成,实时抓取了这些信息,并将其转化为Epismo中的待办任务,并分配给了最可能负责的开发者。这使得技术讨论能够快速落地为可执行的任务,加速了开发迭代。

· 一个创业公司在项目启动阶段,通过Epismo梳理了复杂的项目需求和各部门的职责。Epismo能够将原始的需求文档转化为结构化的任务列表,并明确了每个阶段的交付物和负责人,为项目顺利启动奠定了坚实的基础,避免了项目初期因目标不清而产生的混乱。

34

持久化计时器 TimeTracker

作者

DRYTRIX

描述

TimeTracker 是一个开源的、可自托管的时间追踪应用,专为需要完全数据控制的自由职业者和小型团队设计。它解决了传统时间追踪器在浏览器关闭时会丢失计时数据或被迫依赖云服务的痛点。通过服务器端持久化计时、团队协作功能以及灵活的部署选项,TimeTracker 提供了可靠且数据自主的时间管理解决方案。

人气

点赞 2

评论数 0

这个产品是什么?

TimeTracker 是一个用 Flask、HTMX 和 WebSockets 构建的自托管时间追踪应用程序。它的核心创新在于其“持久化计时器”功能,这意味着你的计时记录不会因为关闭浏览器或电脑而丢失,因为计时数据是存储在服务器端的。这意味着即使用户的电脑重启,正在进行的计时也能被恢复。它还支持多人协作,可以为不同客户和项目分配时间,并生成详细的报告和账单导出。这种自托管的模式让你拥有对自己数据的完全控制权,避免了对第三方云服务的依赖。

如何使用它?

开发者可以通过克隆 GitHub 仓库,然后使用 Docker Compose 命令来快速启动 TimeTracker。启动后,可以通过访问 `http://localhost:8080` 来使用。对于自由职业者,可以将它用于精确追踪为客户工作的时长,并方便地生成账单。对于小型团队,可以将它部署在内部服务器或 Raspberry Pi 上,方便团队成员协作追踪项目时间,管理项目进度和资源分配。它也可以作为一种简单可靠的方式来记录个人工作时间,帮助提高效率和管理时间。

产品核心功能

· 持久化计时器:利用服务器端存储,即使浏览器关闭或电脑重启,计时也不会丢失,确保了数据记录的完整性,解决了用户担心数据丢失的痛点。

· 团队支持:允许多个用户同时使用,并支持角色分配、项目和客户管理,方便小型团队协作管理时间,并能清晰了解每个成员在不同项目上的投入。

· 报告与导出:能够按项目或用户细分,生成详细的时间消耗报告,并支持导出为 CSV 文件,便于进行项目成本核算、客户账单生成和工作效率分析。

· 自托管部署:支持 Docker 和 Raspberry Pi 等多种部署方式,让用户可以选择最适合自己的方式将应用部署在本地或私有服务器上,从而完全掌控自己的数据,无需担心隐私泄露或服务中断。

· 响应式界面与实时更新:使用 Flask、HTMX 和 WebSockets 技术,提供流畅的用户体验,界面可以在不同设备上良好显示,并且计时器的状态能够实时更新,无需手动刷新页面。

产品使用案例

· 一位自由网页开发者使用 TimeTracker 来精确记录为不同客户开发项目所花费的时间。通过生成详细的 CSV 报告,他能准确地向客户收取费用,并且不必担心因意外关闭浏览器而丢失计费时间。

· 一个小型软件开发团队使用 TimeTracker 部署在内部的 Raspberry Pi 上,用于追踪不同功能模块的开发进度。团队成员可以互相协作,项目经理可以查看每个成员在每个任务上的时间投入,从而更好地进行项目排期和资源调配。

· 一位独立内容创作者使用 TimeTracker 来记录自己撰写文章、制作视频等工作的时间。通过分析报告,他能了解自己在不同类型内容创作上的时间花费,从而优化自己的工作流程和时间管理策略。

· 一家初创公司希望避免使用第三方云端时间追踪服务,担心数据安全和长期成本。他们选择将 TimeTracker 部署在自己的服务器上,既能满足团队成员的时间追踪需求,又能确保数据的隐私和安全,同时控制成本。

35

LeetCode遗忘曲线助手

作者

anjandutta

描述

这是一个基于间隔重复(Spaced Repetition)算法的LeetCode刷题复习系统。它解决了开发者在解决大量LeetCode题目后,却无法有效记忆和迁移知识点的问题。通过智能调度复习计划,它能帮助开发者巩固对算法和数据结构模式的掌握,显著提升面试中的问题解决能力。

人气

点赞 2

评论数 0

这个产品是什么?

这是一个帮助开发者在LeetCode刷题过程中,对抗遗忘的智能复习工具。核心技术是“间隔重复”算法,这种算法基于人类记忆曲线,让你在最容易忘记的时间点进行复习。简单来说,就是把你做过的LeetCode题目,按照一定的规律(比如做完一天后复习,然后三天,再一周,再两周……)安排复习计划。它还会根据题目的难度调整复习间隔,容易的题目复习频率低,难的题目复习频率高。它还能让你记录复习时的笔记或制作“闪卡”,追踪你对题目的实际掌握程度。所以,它的技术创新在于将科学的记忆方法应用到算法学习中,有效解决了“刷题看似很多,实则记不住”的痛点。这对于任何想要提升算法能力的开发者来说,都是一种更高效的学习方式。

如何使用它?

开发者可以通过访问项目的演示网站(dsaprep.dev/tracker)来使用它。你可以将你做过的LeetCode题目添加到系统中,然后系统会自动为你生成一个复习计划。当需要复习某个题目时,它会提醒你。你可以在复习时查看笔记,或者添加新的笔记,记录你的思考过程和解题技巧。这个系统可以集成到你的日常学习流程中,成为你LeetCode备战不可或缺的一部分。你可以把它想象成一个智能的“错题本”,但比传统的错题本更主动、更科学。

产品核心功能

· 自动调度题目复习计划:系统会根据间隔重复算法,为你安排不同时间点的复习,确保你不会忘记已解决的题目。这能让你持续巩固知识,避免“死记硬背”,真正理解解题模式。

· 基于难度的复习间隔调整:针对不同难度的题目,系统会自动调整复习的频率。简单题目复习次数少,难题复习次数多,让你把精力集中在最需要巩固的部分,提高学习效率。

· 高亮显示待复习题目:系统会清晰地标记出哪些题目已经到期需要复习,让你一目了然,不会错过任何重要的复习机会。这让你能够有条不紊地进行复习,避免遗漏。

· 记录实际掌握程度和笔记:你可以为每个题目添加复习笔记和闪卡,记录你的理解和反思。这有助于你追踪自己对题目的真实掌握情况,并且在复习时能够快速回忆起关键信息。

· 跟踪实际记忆效果:系统通过你的复习行为和笔记,间接衡量你对题目的记忆情况。这让你能够更客观地评估自己的学习进度,及时调整复习策略。

· 提供问题解决模式识别:通过反复复习,你能够更深刻地理解不同问题的模式和适用的解题方法。这能在实际面试中让你更快地识别问题类型,并选择正确的解决方案。

· 提升面试中的反应速度:熟练掌握和快速回忆起解题模式,能够显著缩短你在面试中的思考时间,让你表现得更自信、更专业。

· 减少无效刷题量:通过高效的复习,你可能只需要解决数量相对较少的题目,就能达到比大量重复刷题更好的学习效果。这能节省你的宝贵时间,避免在无效的劳动中消耗精力。

产品使用案例

· 在一个大型科技公司的软件工程师面试场景下,开发者面对一道复杂的图论问题。他之前做过类似问题,但因为没有系统复习,一时想不起具体算法。通过使用LeetCode遗忘曲线助手,他能够根据系统提示,快速回忆起所学的Dijkstra算法和相关优化技巧,成功解决了问题,并给出了高效的解决方案。

· 另一位开发者在准备ACM竞赛时,发现自己总是会忘记一些特殊的动态规划状态转移技巧。他将这些题目加入遗忘曲线助手,并记录了详细的状态定义和转移方程。在周期性复习中,他能够牢固掌握这些技巧,并在模拟赛中迅速应用,取得了更好的成绩。

· 一位初级开发者在学习二叉树的遍历方法时,经常混淆前序、中序和后序遍历的逻辑。他将这些题目添加到系统中,并在每次复习时,尝试不看答案,仅凭印象写出递归和迭代的代码。通过这种方式,他能够区分不同遍历方法的精髓,并将其熟练运用到实际的树结构操作中。

· 一位在校大学生在准备秋季招聘时,发现自己虽然解决过很多LeetCode题目,但在模拟面试中,面对新题时,常常无法快速联想到合适的解题思路。他开始使用遗忘曲线助手,并注重记录做题时的思考过程。一段时间后,他发现自己看到题目时,能更快地识别出是哪种类型的题目,并能回忆起相似问题的解决方法,显著提升了面试通过率。

· 一位开发者在学习操作系统中的进程调度算法时,觉得概念抽象难以理解。他将相关的算法题型加入系统中,并在复习时,将理论知识与代码实现结合起来,记录下自己的理解。通过间隔复习,他能够更深入地理解不同调度算法的优缺点,以及它们在实际场景中的应用。

36

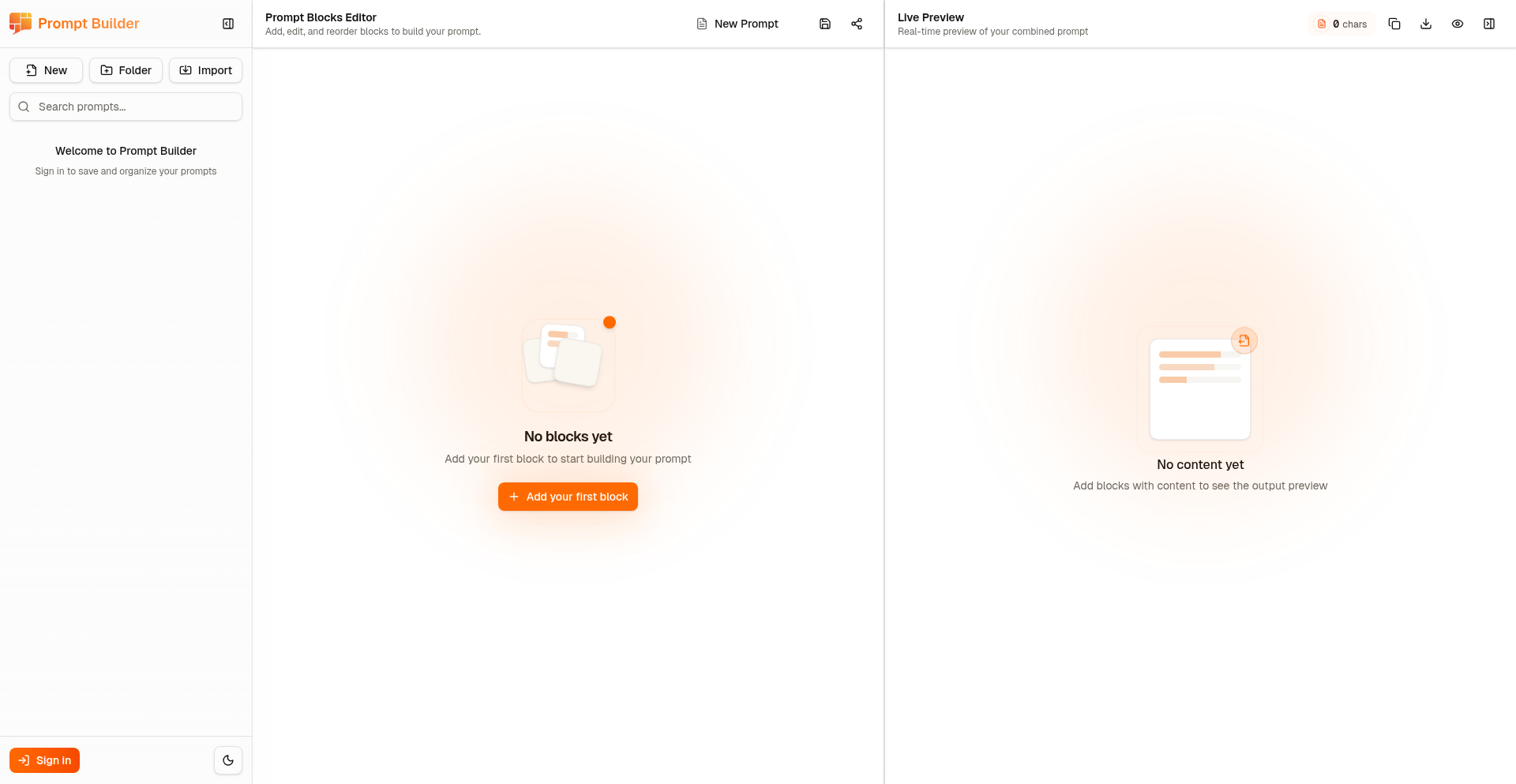

PromptCraft BlockBuilder

作者

Jaber_Said

描述

PromptCraft BlockBuilder 是一个创新的AI提示词构建工具,它通过可视化的拖拽积木块方式,极大地提升了AI提示词的创建效率。它解决了传统文本式提示词构建过程中,结构混乱、难以复用、迭代缓慢等痛点,让用户能像搭积木一样轻松构建复杂的AI指令。

人气

点赞 1

评论数 1

这个产品是什么?

PromptCraft BlockBuilder 是一个基于图形化界面的AI提示词生成器。它将AI提示词拆解成一个个可复用的“积木块”,例如“指令主体”、“语气设定”、“输出格式”、“负面约束”等。用户只需将这些积木块拖拽到画布上,并进行组合和参数配置,就能快速生成高质量的AI提示词。这种方式避免了用户需要记住和手动输入大量参数和指令,降低了AI提示词创作的门槛,同时提高了提示词的结构化和可维护性。

如何使用它?

开发者可以通过其Web界面直接使用,也可以将其集成到现有的AI应用或开发流程中。它提供了一个直观的拖拽编辑器,用户可以轻松添加、移除和连接不同的提示词模块。生成的提示词可以直接复制使用,或通过API调用,为开发者的AI应用提供更灵活、更强大的提示词管理能力。这对于需要批量生成或动态调整AI提示词的场景尤为有用。

产品核心功能

· 可视化拖拽式提示词构建:通过将AI提示词的各个部分(如指令、约束、示例等)抽象成可拖拽的积木块,用户可以直观地组合它们,大大简化了提示词的创建过程,让你构建AI指令不再是枯燥的文本输入,而是像玩游戏一样有趣高效。

· 模块化提示词库:内置了丰富的预设提示词模块,涵盖了各种常用AI任务,如文本生成、代码编写、图像生成等,用户可以即插即用,并根据需要进行修改和扩展,解决了重复构建相似提示词的麻烦,节省了大量时间。

· 提示词版本控制与复用:支持保存和管理不同版本的提示词,并允许用户将自定义的模块分享和复用,确保了提示词的迭代和一致性,让团队协作和项目管理更加顺畅。

· 参数化与动态提示词生成:每个积木块都可以配置参数,并支持变量注入,使得生成的提示词可以根据实际需求动态变化,这对于需要处理大量个性化需求的AI应用来说,提供了强大的灵活性。

· 导出与集成能力:生成的提示词可以导出为多种格式(如JSON、文本),并支持通过API集成到其他应用程序中,这意味着你可以将这个强大的提示词构建能力无缝地应用到你自己的项目里,提升AI应用的开发效率。

产品使用案例

· 内容创作者需要批量生成不同风格的营销文案:使用PromptCraft BlockBuilder,内容创作者可以预先设计好营销文案的基本结构和风格模块,然后通过调整关键词和参数,快速生成大量个性化的文案,无需每次从头开始编写,极大地提高了生产力。

· AI应用开发者需要为用户提供高度定制化的AI聊天机器人:开发者可以利用PromptCraft BlockBuilder构建模块化的对话逻辑和回复模板,用户可以通过图形界面选择对话偏好和内容主题,系统则能实时生成针对性的AI回复,为用户带来更个性化的交互体验。

· 研究人员在实验不同AI模型参数对输出结果的影响:研究人员可以利用PromptCraft BlockBuilder快速构建和调整包含不同指令和约束的提示词,并通过可视化界面清晰地了解每个提示词的结构,高效地进行AI模型行为的探索和对比实验。

· 初学者希望学习如何编写有效的AI提示词:PromptCraft BlockBuilder直观的操作方式,让初学者能够通过实际操作理解提示词的构成要素,并快速上手创建有效的AI提示词,降低了AI技能的学习门槛。

37

PageLM:你的文档智能学习助手

作者

Boblaw1

描述

PageLM 是一个开源的、面向文档的AI学习伙伴,它能将你的大量文档转化为互动式学习材料,如测验、带间隔重复的闪卡、结构化笔记、播客式音频课程、模拟考试,甚至AI驱动的作业规划。核心创新在于利用LangChain和LangGraph技术,让AI能够理解和处理你的文档内容,并以多种形式进行知识输出,极大地提升了信息吸收和复习的效率。所以这对我有什么用?它能帮你把堆积如山的学习资料变成高效的学习工具,让你事半功倍。

人气

点赞 2

评论数 0

这个产品是什么?

PageLM 是一个免费的、社区驱动的开源项目,它的技术原理是将你上传的文档(比如PDF、文本文件等)输入给一个由LangChain和LangGraph驱动的大型语言模型。这个AI会精读你的文档,理解其中的关键信息、概念和逻辑关系。然后,它就能基于这些理解,为你生成多种形式的学习内容。创新的地方在于,它不仅能回答关于文档的问题,还能主动帮你创造出各种学习辅助工具,比如可以让你练习的测验,帮助记忆的闪卡,或者让你像听播客一样学习的音频。所以这对我有什么用?它能自动化你学习过程中整理和复习资料的繁琐工作,让你更专注于理解和掌握知识。

如何使用它?

开发者可以通过访问PageLM的GitHub仓库(https://github.com/CaviraOSS/pagelm)来获取和部署这个项目。你可以将其作为一个独立的应用程序使用,也可以将其集成到你现有的工作流程或学习平台中。集成方式可能包括通过API调用 PageLM 的功能,或者根据项目的开源特性进行二次开发,定制更符合自己需求的学习体验。使用场景非常广泛,例如学生可以用它来整理课程笔记,研究人员可以用它来提炼文献要点,任何需要从大量文档中提取信息并高效学习的人都能从中受益。所以这对我有什么用?你可以根据自己的技术能力和需求,灵活地使用或扩展这个工具,让它成为你个性化的学习助手。

产品核心功能

· 文档内容智能解析:利用大型语言模型理解上传文档的语义和结构,价值在于准确提取关键信息,应用场景是作为一切后续学习功能的基础。

· 互动式测验生成:根据文档内容自动生成选择题、填空题等,价值在于提供即时练习机会,应用场景是检验对知识点的掌握程度。

· 间隔重复闪卡:将文档中的概念和定义转化为闪卡,并结合间隔重复算法,价值在于帮助用户长期记忆,应用场景是高效背诵和复习。

· 结构化笔记整理:自动为文档内容梳理出逻辑清晰的笔记结构,价值在于提高信息的可读性和易理解性,应用场景是整理复杂主题的学习笔记。

· 播客式音频课程:将文档内容转化为类似播客的音频讲解,价值在于提供非视觉的学习方式,增加学习的灵活性,应用场景是通勤、运动等碎片化时间学习。

· 模拟考试功能(ExamLab):根据文档内容创建模拟考试,价值在于帮助用户在真实考试前进行压力测试和知识盲点发现,应用场景是考前冲刺复习。

· AI作业规划:根据文档内容和用户目标,生成个性化的作业和学习计划,价值在于提供清晰的学习路径和时间管理,应用场景是应对复杂的学习任务和项目。

产品使用案例

· 一名大学生使用PageLM导入他关于“人工智能伦理”的课程讲义和相关论文。PageLM能够将这些材料转化为一套练习题和结构化笔记,并生成一个模拟考试,帮助他系统地复习,发现自己对某些概念的理解不够深入。在这个场景下,PageLM通过将零散的文档转化为结构化的学习体系,极大地提高了复习效率,解决了学生面对大量阅读材料时的迷茫感。

· 一位软件工程师正在研究一个新框架的API文档。他将API文档上传到PageLM,并利用其生成了关于关键函数和参数的闪卡,同时创建了可以查询具体用法的互动式问答。这帮助他快速掌握了框架的核心功能,并能在实际开发中快速查找和应用。在这个场景下,PageLM通过将枯燥的技术文档转化为易于记忆和检索的资源,加速了新技术的学习过程,解决了开发者需要快速上手新工具的问题。

· 一位历史系学生需要准备关于“二战关键战役”的期末论文。他将相关的书籍章节和史料导入PageLM,PageLM不仅为他生成了关于各个战役的结构化笔记,还能够根据这些笔记生成一些讨论性问题,激发他思考不同战役之间的联系和影响。此外,PageLM还能生成一份初步的研究计划,指导他如何开展后续的写作。在这个场景下,PageLM通过提供多角度的学习辅助,激发了用户的深度思考,解决了学生在研究性学习中如何系统性梳理信息和构思论文的难题。

38

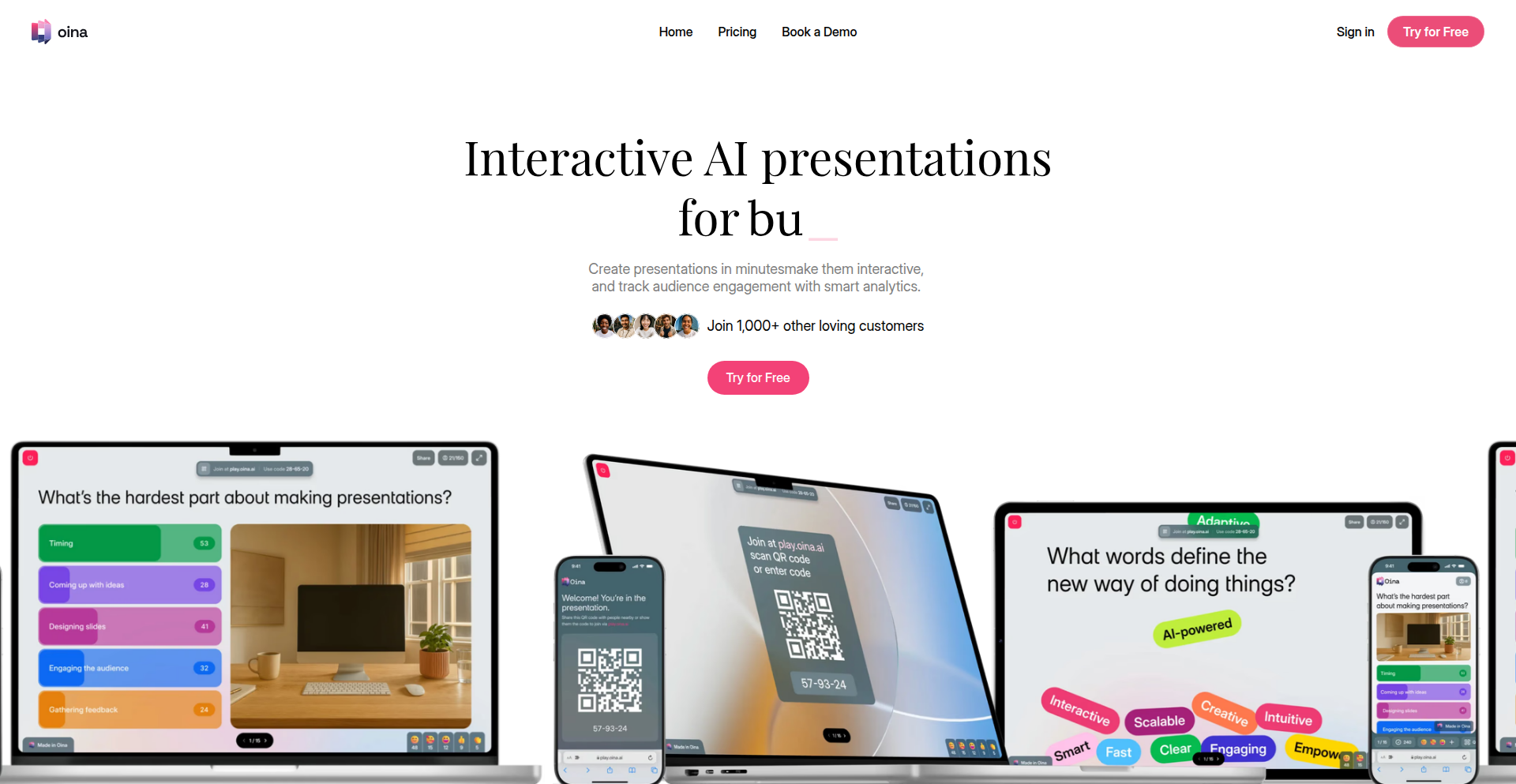

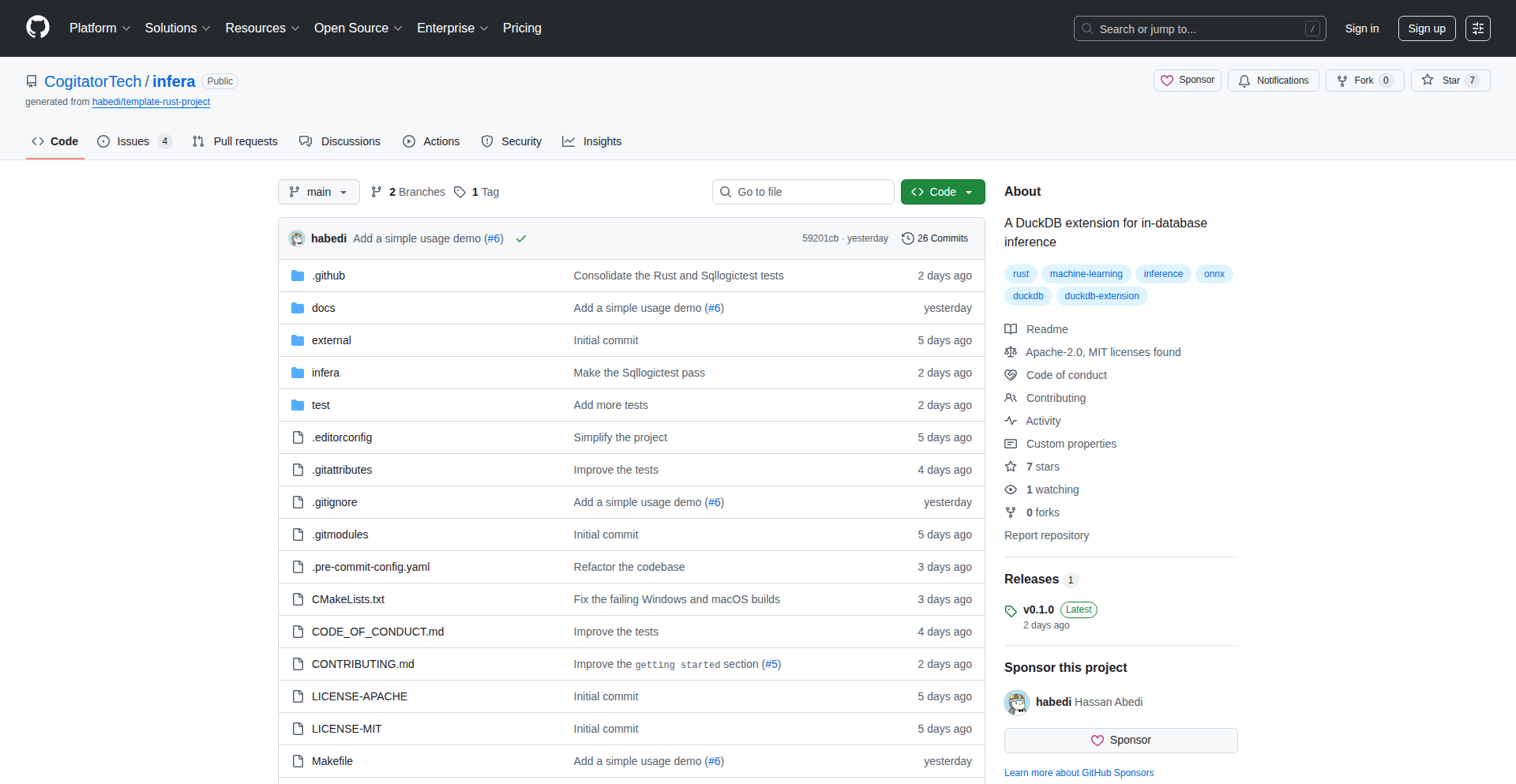

Oina: AI驱动的交互式演示引擎

url

作者

tygynbayev1

描述

Oina 是一个AI驱动的演示文稿生成和实时互动平台。它不仅能根据用户输入的课题、文档或要求,在65种语言中快速生成演示文稿大纲,还能智能嵌入测验、投票、开放式提问和评分等交互式幻灯片。最关键的是,它支持观众通过二维码(无需下载App)实时参与演示互动,并在会后提供详尽的观众参与度和反馈分析。新集成Web搜索功能,确保AI能引入最新信息。

人气

点赞 2

评论数 0

这个产品是什么?

Oina 是一个创新的AI工具,它能帮你快速创建不仅内容充实,而且极具互动性的演示文稿。传统演示工具只能生成静态幻灯片,Oina 的独特之处在于它将AI的内容生成能力与实时观众互动机制相结合。你可以告诉AI你想要演示的主题,它就能帮你构建整个演示框架,还可以帮你插入测验、投票等环节。演示时,观众无需任何准备,扫描一下二维码就能立刻参与,就像玩游戏一样。演示结束后,你还能看到大家对每个问题的回答和参与的热情度,这对于需要即时反馈的教师、培训师和团队来说非常有价值。

如何使用它?

开发者可以轻松地将Oina集成到现有的教学或会议流程中。首先,在Oina平台上输入你的演示主题,选择AI的生成风格和语言,Oina会在几秒钟内生成一份完整的演示大纲,并支持添加各种互动元素。在实际演示时,只需将Oina生成的演示链接分享给观众,他们就能通过扫描二维码加入。开发者也可以利用Oina生成的分析报告,来评估观众的理解程度和对内容的反馈,以便后续改进。对于需要高度参与感和即时反馈的在线课程、培训会、产品发布会或团队会议,Oina都能提供强大的支持。

产品核心功能

· AI内容生成:能快速根据用户输入生成演示文稿大纲,大幅节省内容创作时间,解决“从零开始”的难题。

· 多语言支持:支持65种语言,让内容可以触达全球受众,打破语言障碍。

· 交互式幻灯片:支持嵌入测验、投票、问答、评分等互动模块,增强观众参与度,解决演示枯燥、观众注意力不集中的痛点。

· 实时观众互动:观众通过二维码即可加入,无需下载App,降低参与门槛,实现即时反馈。

· 演示后分析:提供详细的观众参与数据和反馈分析,帮助演讲者了解观众的理解和接受程度,优化内容和演讲技巧。

· Web搜索集成:AI能抓取最新的网络信息,确保演示内容的时效性和权威性,解决演示内容过时的问题。

产品使用案例

· 某大学教授使用Oina为一门新课程创建了互动式教学大纲。学生们在课堂上通过Oina进行即时小测验,教授能够快速了解学生对概念的掌握情况,并根据反馈调整教学节奏,大大提高了课堂效率和学生的学习兴趣。

· 一家科技公司在发布新产品时,使用Oina进行线上演示。通过Oina的投票功能,观众可以实时表达对产品特性的偏好,通过问答环节快速获得用户疑问的解答。演示结束后,公司获得了关于产品接受度的宝贵数据,为产品迭代提供了方向。

· 一个企业培训师需要为一个跨国团队进行线上培训。Oina的65种语言支持和易于参与的交互式问答,确保了不同语言背景的学员都能积极参与,培训师也能通过即时反馈了解学员的困惑点,从而更精准地进行指导,提升了培训效果。

39

LLMSwap: 智能工作区记忆大师

作者

sreenathmenon

描述

LLMSwap 是一个创新的AI助手工具,它解决了大型语言模型(LLM)在处理多项目时容易丢失上下文的问题。通过为每个项目创建独立的“工作区”,LLMSwap 能够让AI记住你在不同项目中的学习、决策和技术栈,就像拥有一个永不健忘的AI导师。它支持市面上几乎所有主流的AI模型,并提供简洁易用的命令行和Python SDK。

人气

点赞 2

评论数 0

这个产品是什么?

LLMSwap 是一个智能工作区管理系统,专门为开发者和需要管理复杂信息的用户设计。它的核心创新在于引入了“工作区”(workspace)的概念,为AI助手提供了独立且持久化的记忆。想象一下,你写代码、学习新知识、构思个人项目,每个场景下AI都需要不同的背景信息。LLMSwap 允许你为每个场景创建一个独立的工作区,每个工作区都保存着与该场景相关的对话历史、学习笔记、技术决策等信息(例如,`context.md`, `learnings.md`, `decisions.md`)。这样,当你切换工作时,AI能够自动加载对应工作区的记忆,不会出现“AI又把我忘了”的情况。它还能自动提取你的学习重点,并支持多种AI模型,让你在不同的AI之间自由切换,不被任何一家厂商绑定。这就像是AI界的“cURL”,功能强大,使用简单。

如何使用它?

开发者可以通过简单的命令行指令 `pip install llmswap==5.1.0` 来安装。安装完成后,你可以通过 `cd` 命令切换到不同的项目目录,LLMSwap 会自动识别当前的工作区。例如,当你进入一个企业项目目录 (`cd ~/work/api-platform`),AI就会加载与该企业项目相关的技术规范和团队约定;当你进入学习目录 (`cd ~/learning/rust`),AI会回忆你学习Rust时遇到的困难和进步。你可以直接在终端与其交互,或者通过其Python SDK将其集成到你自己的应用程序中。它支持多种AI提供商,包括Claude, IBM Watsonx, GPT-4, Gemini, Groq, Ollama等,你可以根据自己的需求和喜好选择。

产品核心功能

· 工作区内存持久化:为每个项目创建独立的AI记忆,每次切换项目AI都能准确回忆起之前的对话和上下文,无需重复解释,显著提高效率。

· 自动学习日记:AI能从与你的每一次交互中提取关键学习点,并生成学习日记,帮助你巩固知识,构建个人知识体系。

· 多AI模型支持:兼容市面上几乎所有主流的AI模型和提供商,避免了对单一AI厂商的依赖,你可以自由选择最适合的AI。

· 多视角教学模式:提供Guru、Socrates、Coach等6种不同的AI教学人格,满足你在不同场景下对指导、启发或提问的不同需求。

· 统一的Python SDK和CLI:既可以直接通过命令行使用,也可以通过Python代码将其集成到你的自动化脚本或应用中,灵活性极高。

· 零供应商锁定:不与任何特定的AI服务商绑定,你可以随时更换AI模型或服务提供商,保护你的投资。

产品使用案例

· 大型软件项目开发:在开发一个复杂的企业级API平台时,开发者可以为每个模块或功能创建一个独立的工作区。AI能够记住每个模块的技术栈、设计思路和遇到的bug,并在你询问时提供精准的帮助,避免了在不同模块间切换时AI“失忆”的问题。

· 多语言学习:一个开发者正在同时学习Rust和Go。他可以为Rust创建一个工作区,记录学习过程中的难点和解决方案;再为Go创建一个独立工作区。当他在学习Rust时,AI会提供Rust相关的指导;切换到Go时,AI则会聚焦于Go语言的知识,确保学习的连贯性和效率。

· 个人兴趣项目管理:开发者有一个正在开发的个人游戏项目,同时还在研究机器学习的某个新算法。他可以为游戏项目创建一个工作区,记录游戏的设计理念、代码片段和TODO列表;为机器学习算法创建一个工作区,保存研究笔记和实验结果。AI能够根据当前的工作区提供定制化的建议和信息。

· 跨团队协作辅助:在一个需要与多个团队沟通协调的项目中,开发者可以使用LLMSwap为每个合作团队创建一个工作区。AI可以根据不同团队的技术背景和沟通风格,提供更贴切的沟通建议和信息摘要,帮助开发者更顺畅地与各方协作。

40

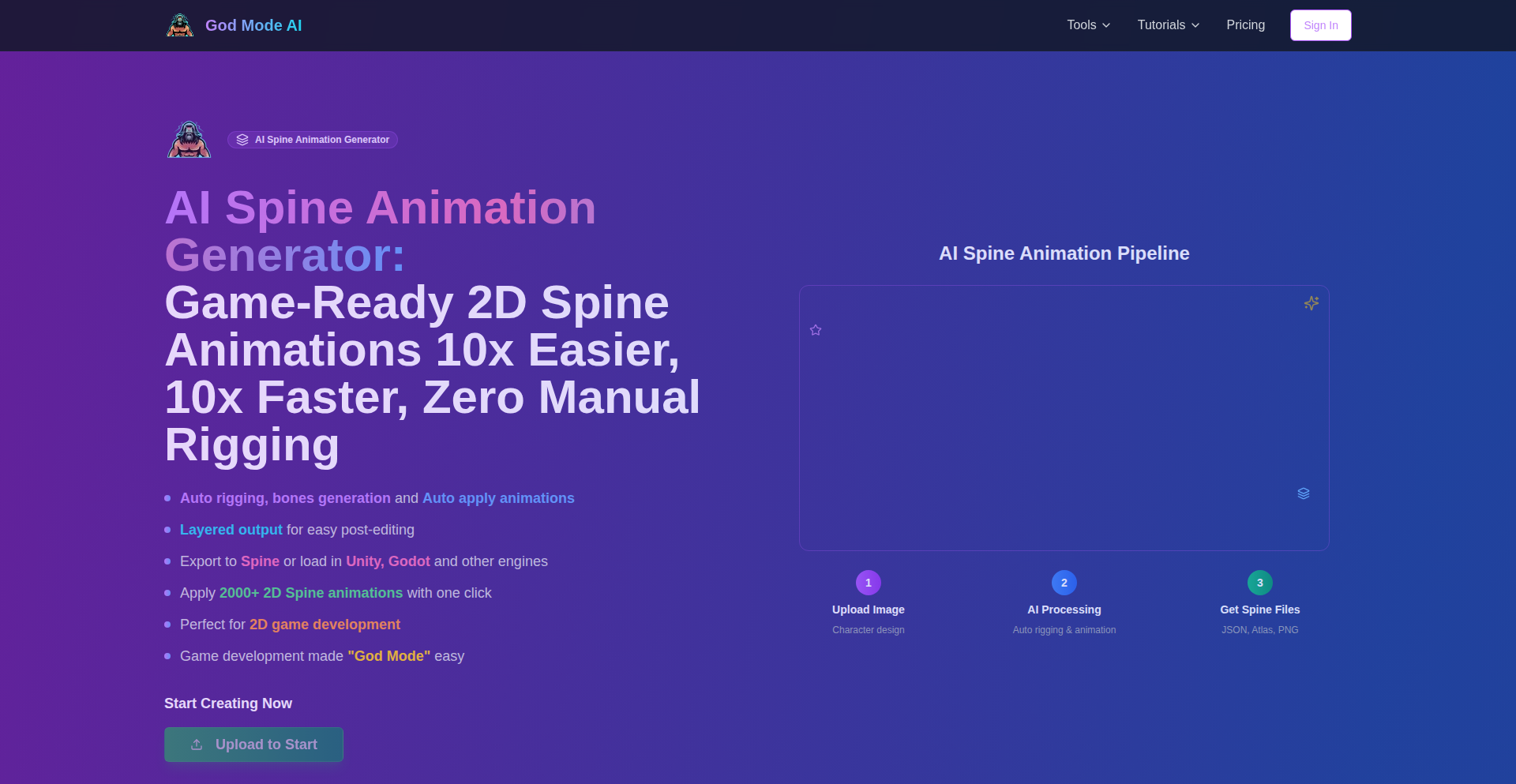

AI驱动的2D游戏角色骨骼动画生成器

作者

lyogavin

描述

这个项目利用人工智能技术,能够自动为上传的2D游戏角色图像生成骨骼动画。它解决了游戏开发中角色动画制作耗时耗力的问题,通过AI自动进行骨骼绑定和动画应用,让开发者能以更快的速度、更低的成本获得大量动画资源,直接导出到Spine软件或各大游戏引擎,极大提升了2D游戏开发的效率。

人气

点赞 2

评论数 0

这个产品是什么?

这是一个AI工具,专门用来制作2D游戏角色骨骼动画。你只需要上传一张游戏角色的图片,它就能自动分析图片的结构,像给角色安上骨架一样,生成一套骨骼系统(这个过程叫做“自动骨骼绑定”)。更厉害的是,它还能一键应用2000多种预设的动画模板,比如走路、跑步、攻击、跳跃等等,让你的角色瞬间“活”起来。它还会把角色图拆分成不同的图层,方便后续编辑,并可以直接导出到常用的动画制作软件Spine,或者直接集成到Unity、Godot等游戏引擎中。简单来说,就是用AI帮你省去了大量繁琐的手工动画制作时间,让2D游戏角色动起来变得前所未有的简单高效。

如何使用它?

开发者在使用时,只需将游戏角色的一张静态图片上传到这个AI工具中。AI会首先自动识别角色的身体部位,并生成一套智能的骨骼结构(Auto rigging)。接着,你可以选择一个或多个预设的动画模板(2k+ animations),AI会自动将这些动画应用到角色骨骼上,生成相应的动画序列。最后,你可以选择将结果导出为Spine文件,以便在Spine软件中进行更精细的手动调整和编辑,或者直接导出到Unity、Godot等游戏引擎的兼容格式,用于游戏开发。这大大缩短了从角色原画到可用动画的过程,让开发者能更专注于游戏的核心玩法和设计。

产品核心功能

· 自动骨骼绑定: AI能够智能地识别2D角色图像中的关键点,并生成一套可驱动的骨骼结构,无需开发者手动绘制和连接骨骼,极大地减少了前期准备工作,实现技术价值在于自动化和效率提升。

· 一键应用2000+动画: 工具预置了大量常用的2D角色动画模板,用户只需点击一下,AI就能将这些动画应用到角色的骨骼上,快速生成多种动画效果,为开发者提供丰富的动画素材,应用场景是快速填充角色动画库,解决重复性劳动问题。

· 分层图像输出: 输出时会将角色图像根据骨骼结构拆分成不同的图层,方便在Spine等软件中进行精细的后期编辑和优化,技术价值在于保持动画的可编辑性和灵活性,方便二次创作。

· 直接导出Spine文件: 支持将生成的骨骼和动画直接导出为Spine格式,这是2D游戏动画领域广泛使用的专业格式,意味着开发者可以直接在Spine软件中进行更深入的细致调整,技术价值在于与专业工具的无缝对接,保证工作流的顺畅。

· 导出至主流游戏引擎: 支持导出为Unity、Godot等主流游戏引擎可以直接使用的格式,开发者拿到文件后即可快速集成到游戏项目中,显著缩短了动画资源从制作到上线的周期,技术价值在于跨平台兼容性和快速集成能力。

产品使用案例

· 一个独立游戏开发者正在制作一款像素风的RPG游戏,需要为几十个不同的NPC角色制作行走、攻击等基础动画。使用该AI工具,他只需要上传NPC的原画,AI就能快速生成骨骼并应用预设动画,大大节省了原本需要数天甚至数周的手动制作时间,让他能在有限的预算内完成更具吸引力的角色表现。

· 一家小型游戏工作室面临项目延期风险,急需为一款新推出的2D平台跳跃游戏添加大量角色动作。通过使用这个AI动画生成器,他们将原本需要外包大量动画制作的工作量内部化,并且在短时间内就为主角和敌人生成了跑步、跳跃、受击、死亡等多种动画,成功按时交付了项目,解决了开发周期紧张的技术难题。

· 一位游戏美术师希望尝试新的2D动画风格,但对繁琐的骨骼绑定流程感到头疼。他利用这个工具,通过AI生成骨骼,然后尝试不同的动画模板,探索各种可能性,并在此基础上进行微调。这种方式让他能够更专注于创意和风格的探索,而不是被技术细节所困扰,体现了AI作为创意辅助工具的强大能力。

41

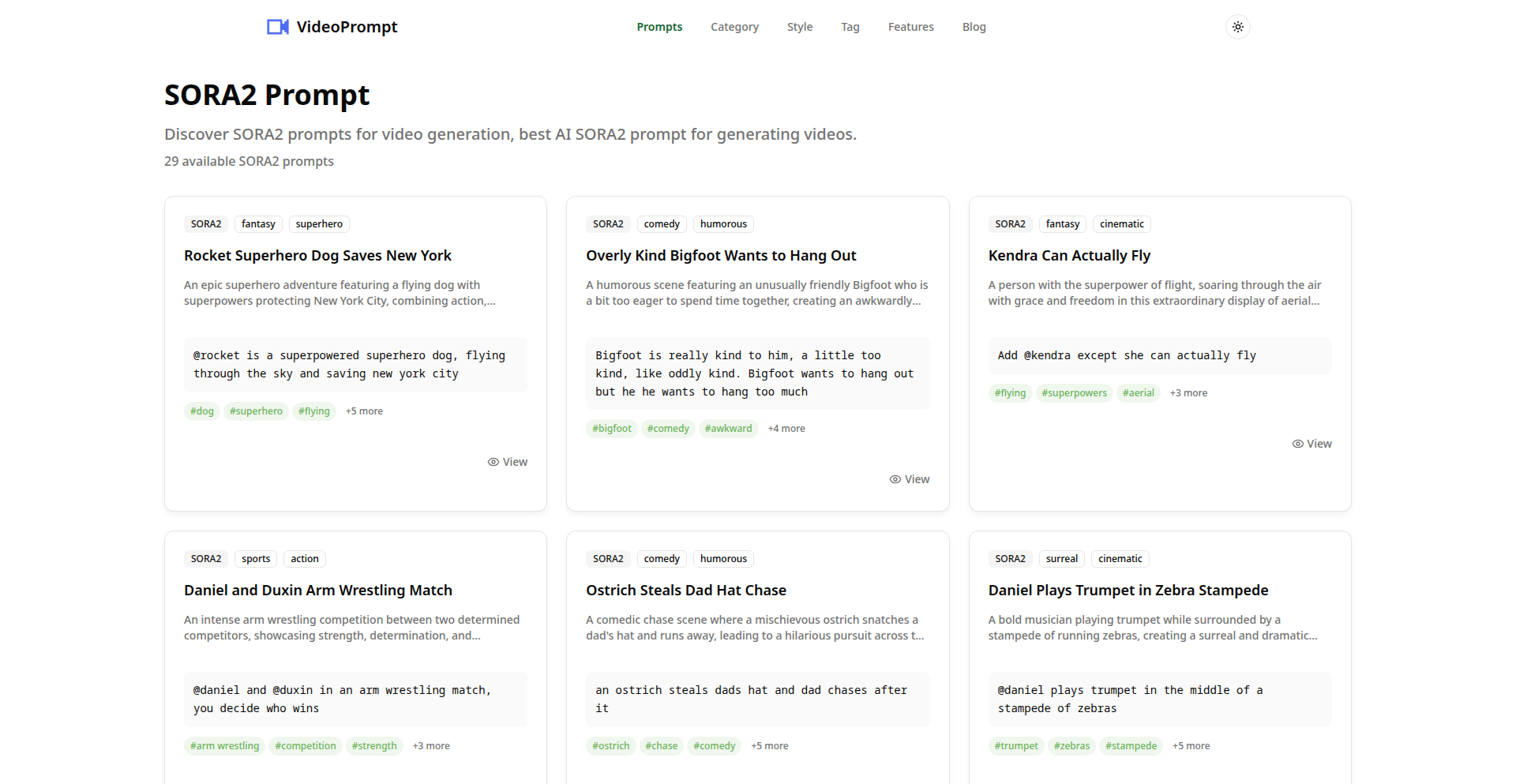

AI视频生成提示词宝库 (Sora2适配版)

作者

hr98w

描述

这是一个由开发者hr98w构建的AI视频生成提示词库,特别针对Sora2等先进AI视频生成模型。项目收集并组织了大量高质量的提示词,旨在帮助用户更高效地生成想要的视频内容,解决AI视频生成中“不知道如何精确描述”的技术痛点。

人气

点赞 1

评论数 1

这个产品是什么?

这是一个AI视频生成模型(比如Sora2)的“使用说明书”集合。AI视频生成模型需要用户输入文字描述(提示词)来指导它生成视频,但如何写出能让AI准确理解并生成理想效果的提示词,是很多开发者和创意工作者面临的难题。这个项目就是通过收集、整理和分类大量的提示词,让用户可以快速找到适合自己需求的描述,从而降低AI视频生成的门槛,提升生成效率和质量。它通过对已有成功提示词的分析,提炼出能够触发AI特定效果的关键词和结构,这本身就是一种对AI模型行为的深入洞察和利用。

如何使用它?

开发者可以将这个提示词库作为AI视频生成时的参考和灵感来源。当你想要生成一段特定场景、风格或动作的视频时,可以从库中查找相关的提示词,或者从中学习提示词的构成方式,然后根据自己的具体需求进行修改和组合。例如,你可以直接复制一个“奇幻森林漫步”的提示词,或者借鉴“电影级镜头语言”的提示词结构来描述你自己的创意。这种使用方式就像是为AI视频生成工具提供了一套“高级指令集”,让原本需要反复尝试才能摸索出的有效描述变得触手可及。

产品核心功能

· 海量精选提示词库:提供大量经过验证的、能够生成高质量AI视频的提示词,让用户无需从零开始摸索,直接获得优秀结果,大大节省了时间和精力。

· 多维度分类和搜索:提示词按场景、风格、镜头语言等维度进行分类,方便用户快速定位目标提示词,提高查找效率,无论你是想生成科幻大片还是温馨小品,都能快速找到对应的“魔法咒语”。

· Sora2模型适配优化:提示词经过优化,能够更好地与Sora2等前沿AI视频生成模型配合,充分发挥模型的潜力,生成更符合预期、更具艺术感的视频。

· 提示词结构分析与学习:通过学习库中的提示词,开发者可以理解不同元素(如主体、动作、场景、光影、风格等)如何组合才能获得最佳的AI生成效果,从而提升自己撰写提示词的能力,成为AI视频生成的“语言大师”。

产品使用案例

· 一个独立游戏开发者想为游戏CG制作一段“魔法箭矢飞射”的动画,他可以从提示词库中找到类似“魔法元素汇聚,凝结成闪耀的箭矢,以惊人的速度射向目标,留下炫目的轨迹,电影级特效”的提示词,然后稍作修改,就能快速生成符合游戏风格的动画片段。

· 一个短视频创作者想制作一段“未来城市漫步”的创意短片,他可以在库中找到关于“赛博朋克城市”、“霓虹灯光”、“未来交通工具”等相关的提示词,并将它们组合成一个能够生成沉浸式未来体验的提示词,快速产出吸引眼球的内容。

· 一个AI研究者正在探索Sora2模型的极限,他可以使用提示词库中的各种复杂、新颖的提示词作为实验素材,研究模型对不同描述的响应行为,从而推动AI视频生成技术的发展。

· 一个初学者想要尝试AI视频生成,他对如何写提示词一无所知。通过浏览这个提示词库,他可以直观地看到“优秀”的提示词是什么样的,并学习其背后的逻辑,从而快速入门,并开始创作自己的第一个AI视频。

42

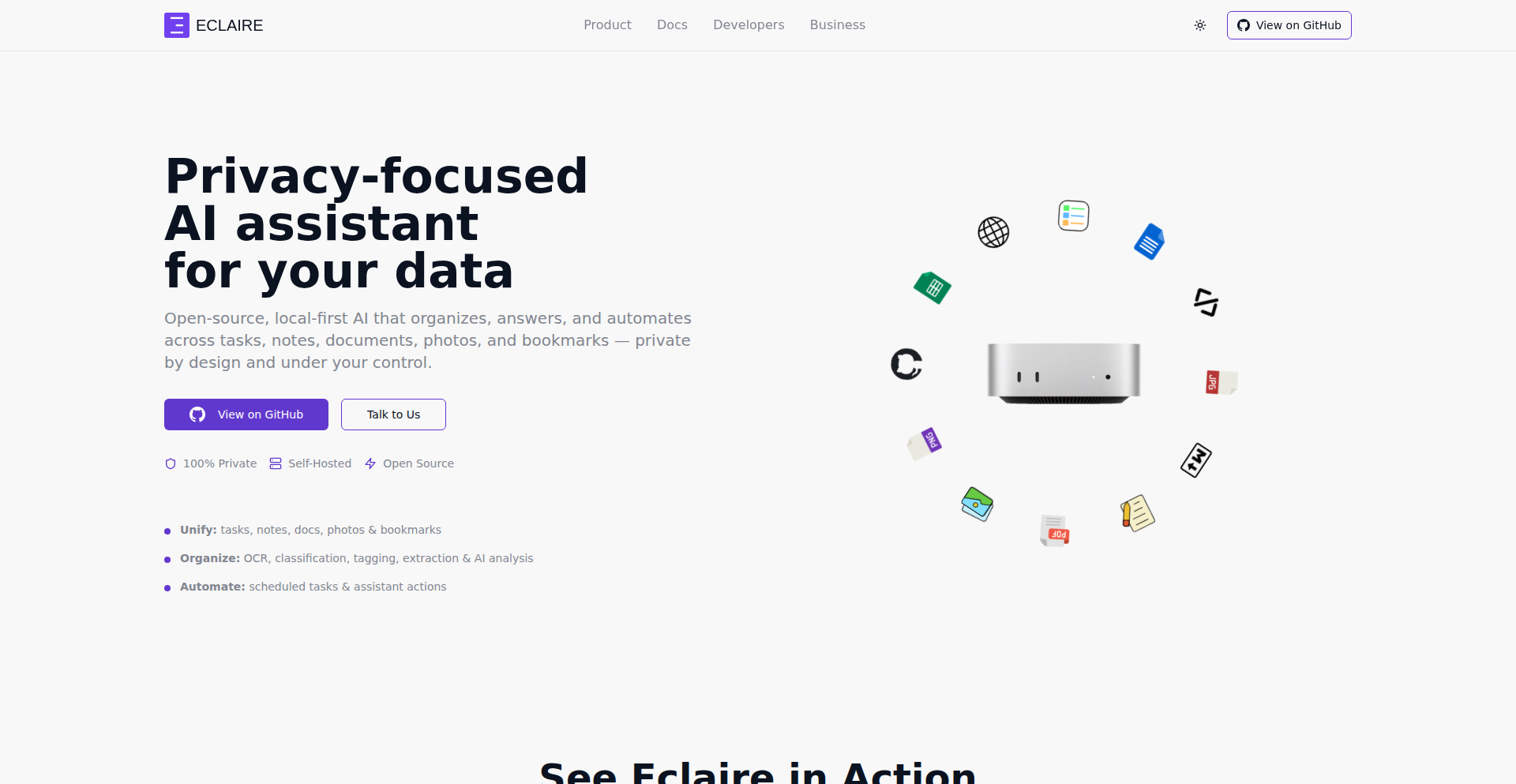

Eclaire: 数据大脑

作者

korale

描述

Eclaire 是一个开源的、注重隐私的 AI 助手,它可以帮你管理和理解你个人的海量数据(如书签、照片、文档、笔记等)。它最大的创新点在于,你可以在自己的电脑上搭建一个“数据大脑”,将所有数据集中起来,并在本地运行 AI 模型进行分析,完全保护你的数据隐私。通过简单的集成,AI 能够搜索、回答问题、生成新内容,甚至可以执行你设定的定时任务。所以这对我有什么用?它让你能够安全地掌控自己的数字信息,让 AI 真正成为你个人数据的智能管家。

人气

点赞 2

评论数 0

这个产品是什么?

Eclaire 是一个自托管的、强调数据隐私的 AI 助手。它的核心技术在于能够将你分散在各种地方(特别是苹果生态系统)的数据集中起来,然后在你自己的设备上运行人工智能模型来处理这些数据。数据处理包括获取网页书签、自动打标签、分类、分析图片、提取文字(OCR)等等。处理完的数据就可以被 AI 用来执行智能搜索、回答关于你数据的问题、创建新的内容,甚至可以设置 AI 定期执行某些任务。它之所以有技术创新价值,是因为它解决了当前许多 AI 工具依赖云服务、数据隐私难以保障的问题,将 AI 的能力带回用户手中,实现真正的个性化和私密化数据管理。所以这对我有什么用?这意味着你可以拥有一个只属于你的、永远不会泄露你个人信息的智能助手,它能帮你从杂乱的数据中提取有价值的信息。

如何使用它?

开发者可以通过 GitHub 克隆 Eclaire 的开源代码,并在自己的电脑上搭建运行环境。利用 Apple Shortcuts(苹果快捷指令)功能,可以非常方便地将数据分享给 Eclaire,比如通过 Mac 的全局键盘快捷键或者手机的分享菜单。一旦数据被 Eclaire 接收并处理,开发者就可以通过 Eclaire 提供的接口与其 AI 互动,例如向它提问、搜索信息,或者配置 AI 执行自动化任务。它还可以与其他应用集成,实现更广泛的数据处理和自动化流程。所以这对我有什么用?你可以轻松地将 Eclaire 集成到你现有的工作流程中,让你的 Mac 和 iPhone 成为数据智能化的入口,享受更高效、更私密的个人数据管理体验。

产品核心功能

· 本地数据集成和处理: Eclaire 能连接并处理来自不同来源的数据,如网页书签、本地文件、笔记等,将它们统一管理。这使得你的所有数字资产都处于一个可控的环境中,极大地提高了数据利用效率,避免信息孤岛,所以这对我有什么用?我可以一次性管理我所有的重要信息,不再需要到处查找。

· AI驱动的数据分析和理解: 集成了图像识别、文本提取(OCR)等 AI 模型,能够自动分析和理解数据内容,例如识别图片中的物体、从文档中提取文字。这能够为数据提供更深层次的洞察,所以这对我有什么用?AI 能帮我理解我存储的各种数据,让信息更有价值。

· 智能搜索与问答: 基于处理过的数据,Eclaire 能够进行智能搜索,并能回答关于你个人数据的问题,就像一个了解你所有信息的私人助理。这提供了前所未有的信息检索能力,所以这对我有什么用?我可以快速找到我需要的信息,甚至让 AI 帮我总结和分析。

· 自动化任务执行: 支持创建定时或周期性的任务,让 AI 自动执行,例如定期整理文件、生成报告等。这极大地解放了用户的双手,提高了生产力,所以这对我有什么用?我可以让 AI 帮我处理重复性的工作,节省宝贵的时间。

· 隐私优先的自托管架构: 所有 AI 模型和数据处理都在本地进行,用户数据完全掌握在自己手中,无需担心数据泄露。这是 Eclaire 最核心的价值所在,所以这对我有什么用?我可以使用强大的 AI 功能,同时保证我个人数据的绝对安全和隐私。

产品使用案例

· 开发者将 Eclaire 集成到自己的笔记应用中,当开发者在笔记中粘贴网页链接时,Eclaire 会自动抓取网页内容、提取关键信息并生成摘要,然后将这些信息与笔记关联,方便日后查阅。解决的技术问题是:手动整理网页信息效率低下且易遗漏。所以这对我有什么用?我粘贴网页信息后,AI 会自动帮我处理好,让我专注于思考而不是整理。

· 一个摄影爱好者使用 Eclaire,将他拍摄的照片导入系统。Eclaire 的图片分析功能自动为照片打上标签(如人脸、地点、场景),并识别出照片中的物体,这使得他能够通过关键词快速搜索到特定照片,甚至可以根据照片内容让 Eclaire 创作相关的文本描述。解决的技术问题是:海量照片管理困难,搜索效率低。所以这对我有什么用?我可以轻松找到我想要的照片,AI 还能帮我给照片起名字,让它们更有故事。

· 一位作家利用 Eclaire 收集研究资料。他可以将收集到的文献、网页、笔记等所有信息都喂给 Eclaire,然后让 Eclaire 根据这些信息生成一份研究报告的草稿,或者回答关于研究主题的复杂问题。解决的技术问题是:信息分散,整合和分析耗时耗力。所以这对我有什么用?我可以把零散的资料交给 AI,让它帮我生成报告或回答问题,大大加快我的写作进度。

43

灵感录音笔记

作者

mcadenhe

描述

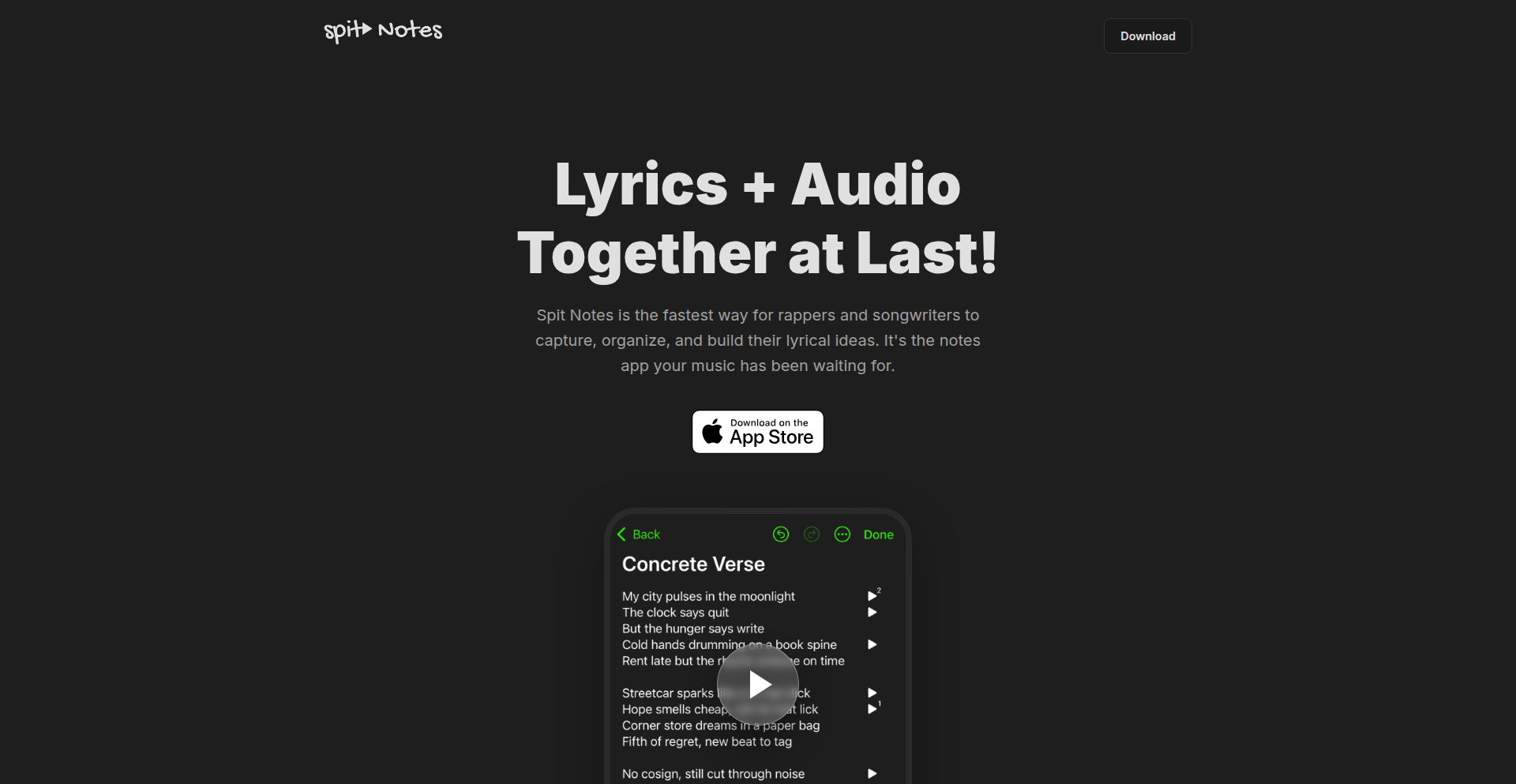

Spit Notes 是一款专门为创作者设计的笔记应用,它将歌词和录音无缝结合。它解决了用户在创作过程中,特别是写歌词时,常常需要同时记录灵感(语音备忘录)和文本(歌词)的痛点。传统方式下,歌词和录音容易分散,查找和管理不便。Spit Notes 将录音直接嵌入到笔记的同一行,用户可以在写歌词时随时录制语音,确保灵感不丢失,极大地提升了创作效率和流畅度。

人气

点赞 2

评论数 0

这个产品是什么?

Spit Notes 是一个集成了录音功能的笔记应用,主要面向音乐创作者。它的核心技术创新在于将音频录制功能深度整合到文本笔记中,使得用户可以在记录歌词的同时,即时录制旋律、歌词片段或创作想法,并且这些录音会直接以音频文件的形式,紧密地与对应的文字行关联起来。与市面上其他应用不同的是,Spit Notes 的音频元素布局非常简洁,不会打断文字的阅读和书写流畅性。这就像一个专为创作者设计的“所见即所得”的创作环境,让灵感捕捉和整理变得前所未有的高效。

如何使用它?

开发者和创作者可以通过 iOS 设备下载并使用 Spit Notes。在应用内,您可以像使用普通笔记应用一样创建和编辑文本。当您需要记录灵感、旋律片段或某个歌词的即时想法时,只需在文本行旁边点击录音按钮,即可开始录制。录制完成后,音频会自动附加到当前行,并以简洁的图标显示。您可以随时点击该图标播放录音。这种设计非常适合在开车、醒来或任何突发灵感时,快速捕捉创作素材,而无需切换应用或担心文件丢失。

产品核心功能

· 歌词与录音同步记录:在同一个笔记条目中,用户可以边写歌词边录制对应的语音灵感,音频会直接附加在文本行旁边,方便回顾和管理。解决了创作时灵感分散和难以关联的问题。

· 无缝音频嵌入:录制的音频文件以轻巧的图标形式嵌入到笔记文本中,不影响文字的阅读和编辑流畅性。解决了传统笔记应用中音频元素可能带来的界面拥挤和干扰。